目录

[1. 什么叫模型](#1. 什么叫模型)

[2. 什么是大语言模型](#2. 什么是大语言模型)

[2.1 神经网络](#2.1 神经网络)

[2.2 自监督学习](#2.2 自监督学习)

[2.3 半监督学习](#2.3 半监督学习)

[2.4 语言模型](#2.4 语言模型)

[3. 大语言模型的能力](#3. 大语言模型的能力)

1. 什么叫模型

今天我们来聊一聊什么叫做模型。

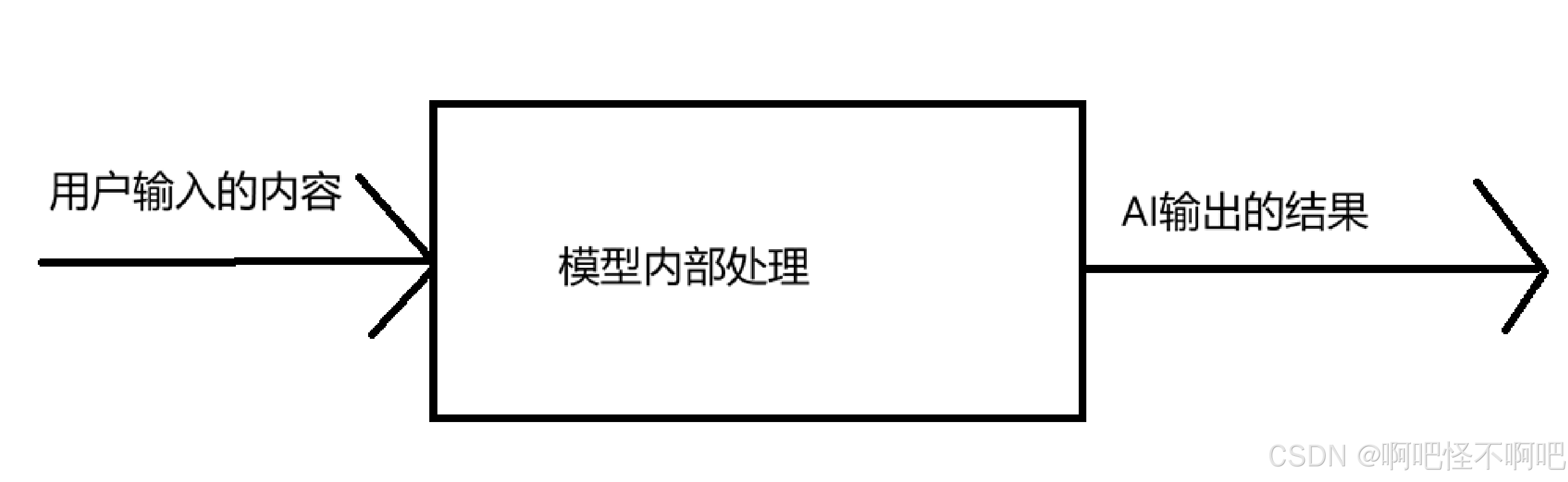

模型是⼀个从数据中学习规律的"数学函数"或"程序"。旨在处理和⽣成信息的算法,通常模仿⼈类的认知功能。通过从⼤型数据集中学习模式和洞察,这些模型可以进⾏预测、⽣成⽂本、图像或其他输出,从⽽增强各个⾏业的各种应⽤。

简单来说就是一个模型只会处理一件事,我们也可以把它理解为单个工作流,然后多个模型组合在一起就是语言大模型了。

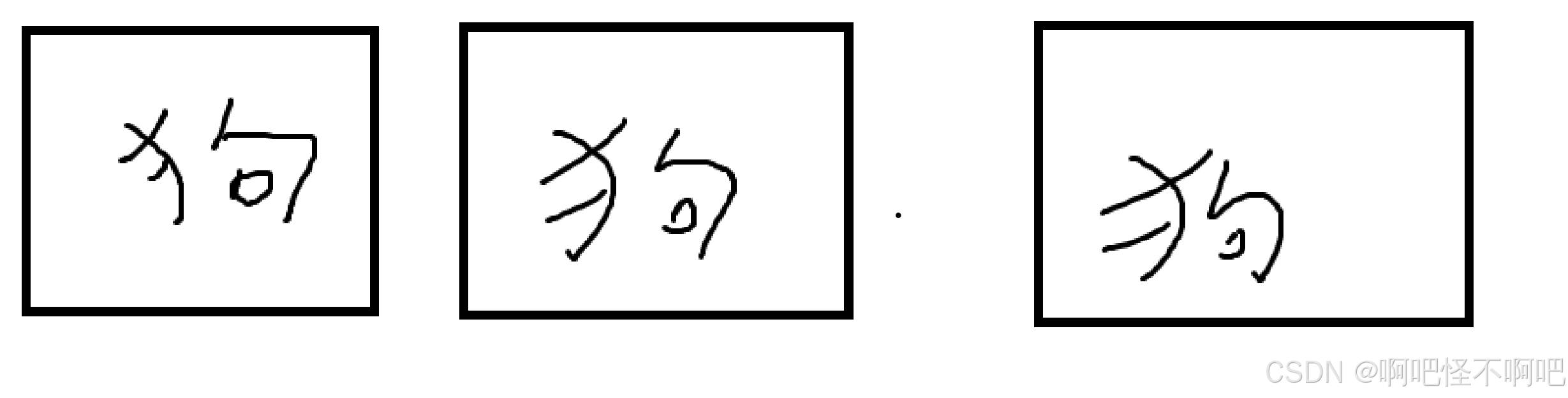

它和工作流的区别在我看来就是它这个处理是需要提前训练。我们看下面这个图片,我们就像这样把下面这些狗狗的图片全部都喂给模型,并且我们需要给每一张图片都标注好这个是狗,这样再经过很多张这样图片让AI看,然后AI就学会分辨什么是狗了。

但是这个模型的话就只可以分辨什么是狗,如果我们问这个模型什么是猫的话,那么这个模式是无法做出回答的。

2. 什么是大语言模型

2.1 神经网络

神经网络我们可以理解为很多个无数个组合在一起的工作流,每一块工作流只处理一小部分的问题,通过各自之间的配合,从而达成有效处理用户信息的能力。

2.2 自监督学习

自监督学习 是一种无监督学习的进阶范式 ,核心是让模型自己从原始数据中构造监督信号(标签),无需人工标注数据,就能完成特征学习和模型训练。

这个的话我的理解就相当于是自学,同时自己给自己修正方向。

2.3 半监督学习

半监督就是"少量指导+⼤量自学"的结合模式。

通过给部分的照片备注,接着再放一些不相关的照片来给模型进行识别,这种学习过程叫做半监督学习。

2.4 语言模型

语⾔模型的核⼼任务就是预测下⼀个词。⼀个强⼤的语⾔模型,能够根据⼀段话,预测出最合理、最通顺的下⼀个词是什么,这样⼀个个词接下去,就能⽣成⼀整段话、⼀篇⽂章。

比如我们平常打字时的自动补全,那就是一种语言模型。

3. 大语言模型的能力

大语言模型和语言模型并不完全是一种东西。简单来说,所有大语言模型都是语言模型,但并非所有语言模型都是大语言模型。

核心定义与关键特征

-

核心定位:以 "预测下一个词" 为基础任务,通过海量数据学习语言规律、知识与逻辑,涌现对话、推理、创作等通用能力,而非仅针对单一任务。

-

三大关键特征

-

架构:统一采用 Transformer(多为纯 Decoder),自注意力机制高效捕捉长距离语义依赖,并行计算能力远超 RNN/LSTM。

-

规模:参数量达数十亿至万亿级(如 GPT-3 1750 亿、GPT-4 万亿级),训练数据为 TB 级通用文本(书籍、网页、代码等)。

-

能力:支持零样本 / 少样本学习,可跨任务泛化,具备上下文理解、复杂推理与多模态(文本 + 图像 / 音频)处理能力。

-

主要挑战与局限

-

幻觉:生成看似合理但不符合事实的内容,需外部知识库或检索增强(RAG)修正。

-

算力与成本:训练与推理依赖大规模 GPU 集群,成本高、能耗大。

-

安全与伦理:存在偏见、隐私泄露、内容滥用风险,需强化对齐与合规管控。

-

上下文窗口限制:虽持续扩大(如 GPT-4 128k、Gemini 1.5 Pro 10M),但超长文本处理仍有瓶颈。