1、介绍

有时为了信息安全的需要,可能需要在本地运行一些LLM,而运行和管理这些LLM就需要一些工具的支持才行。本篇文章就是介绍几款用过的LLM管理工具,主要包括:ollama、LM Studio、AnythingLLM和open-webui。

2、ollama

2.1 简介

Ollama 是一个 开源框架和工具集,专门用于在本地计算机(从个人笔记本电脑到服务器)上 快速部署和运行各种开源 LLM。可以从https://ollama.com/下载,支持主要的操作系统,包括MAC、Windows和Linux,它的主要作用:

-

简化部署 :只需一行命令(如

ollama run llama3)就能自动下载、配置并启动一个模型,无需手动处理复杂的依赖和环境。 -

统一管理:可以轻松地拉取、运行、切换、删除不同的模型,并用统一的方式与它们交互。

-

性能优化:内置了优化,特别是对 macOS 和 Linux 的支持非常好。它利用量化技术,将庞大的模型"瘦身",使其能在消费级硬件(甚至没有独立显卡的电脑)上相对流畅地运行。

-

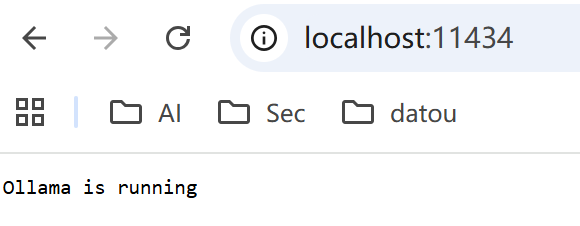

提供API :运行后,它会提供一个类似 OpenAI 格式的本地 API 端点(通常位于

http://localhost:11434),允许其他应用(如聊天界面、代码编辑器插件、自动化脚本)来调用这个本地模型。

2.2、常用命令

|------------------------------------------|---------------------------------------|-------------------------------------------|

| 命令 | 作用 | 示例 |

| ollama run <模型名> | 拉取(如果本地没有)并运行指定模型,进入交互式对话。 | ollama run llama3 |

| ollama pull <模型名> | 拉取模型到本地,但不运行。 | ollama pull qwen2:7b |

| ollama list | 列出本地已下载的所有模型。 | ollama list |

| ollama ps | 显示当前正在运行的模型及其资源占用。 | ollama ps |

| ollama stop <模型名> | 停止一个正在运行的模型。 | ollama stop llama3 |

| ollama rm <模型名> | 删除本地的一个模型(需要先停止)。 | ollama rm qwen2:7b |

| ollama cp <源模型名> <目标模型名> | 复制一个模型,创建一个新的副本(可用于创建自定义模型的基础)。 | ollama cp llama3 myllama3 |

| ollama show <模型名> --license等 | 显示模型的详细信息,如许可证、模版、参数等。 | ollama show myllama3 |

| ollama create <模型名> -f <Modelfile路径> | 使用Modelfile创建一个自定义模型。 | ollama create my-assistant -f ./Modelfile |

| ollama serve | 启动Ollama服务(通常Ollama以后台服务运行,此命令可手动启动)。 | ollama serve |

运行之后,可以通过访问 URL:http://localhost:11434/查看ollama是否真正运行起来:

2.3、使用ollama的示例代码

可以参考 https://blog.csdn.net/jimmyleeee/article/details/155503056。

3、LM Studio

3.1、简介

LM Studio 是一款面向开发者和AI爱好者的本地大语言模型桌面应用程序 ,提供图形化界面让你在个人电脑上轻松运行各种开源大模型。它是把复杂的技术细节包装成"开箱即用"体验的本地AI桌面工具,特别适合不想折腾命令行的用户快速上手和实验各种开源大模型。可以从https://lmstudio.ai/ 下载安装。

3.2、用法

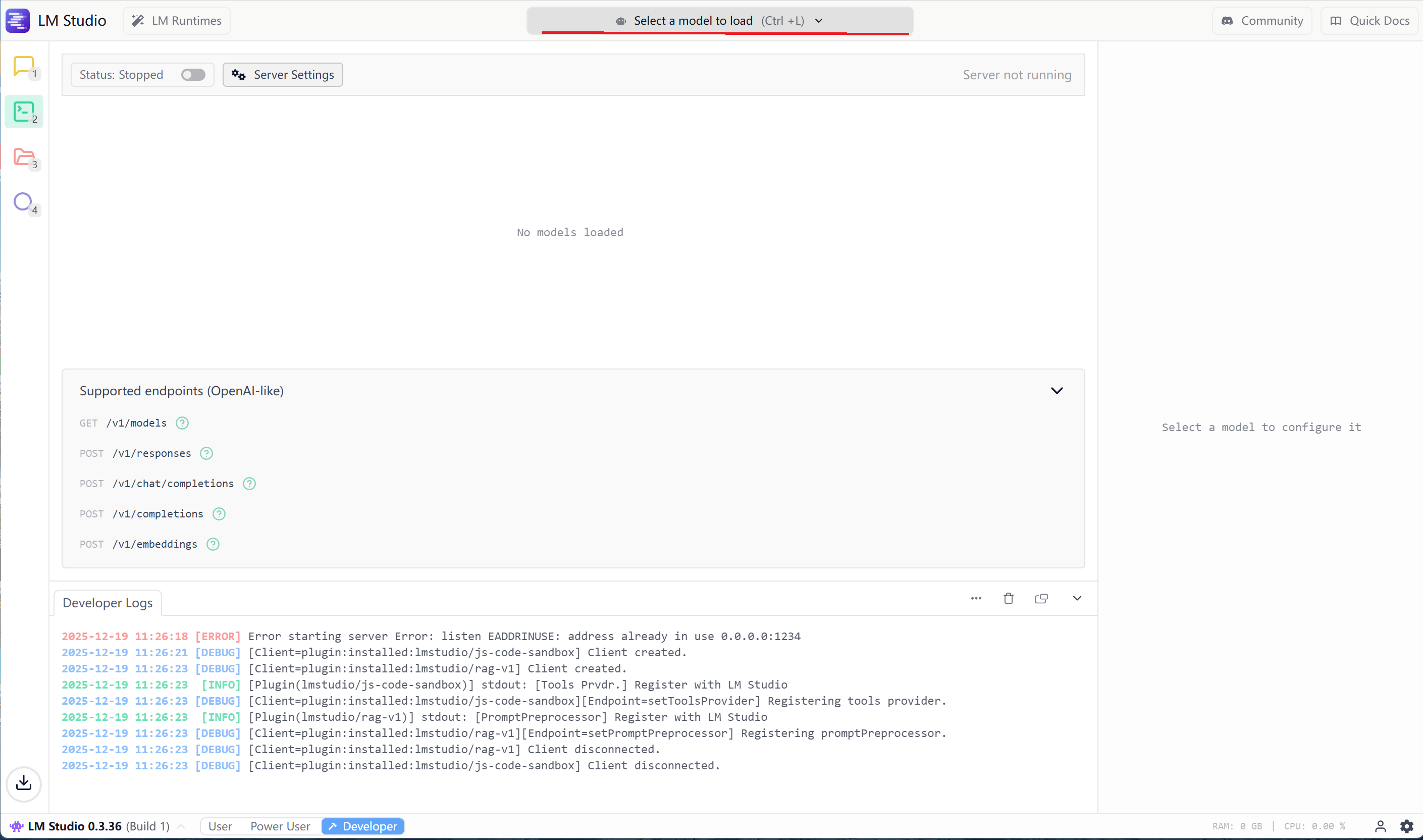

直接在Windows系统运行程序,如下:

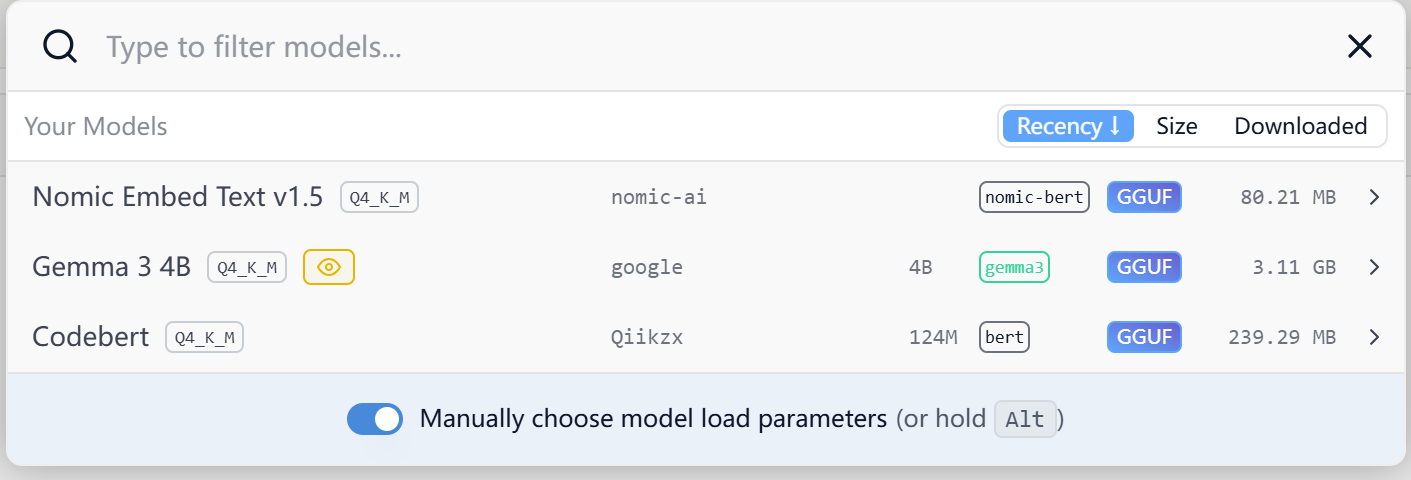

在顶部中央位置【Select a model to load】,可以选择需要加载的模型,和ollama的ollama pull <模型名>一样,把模型加载到本地。

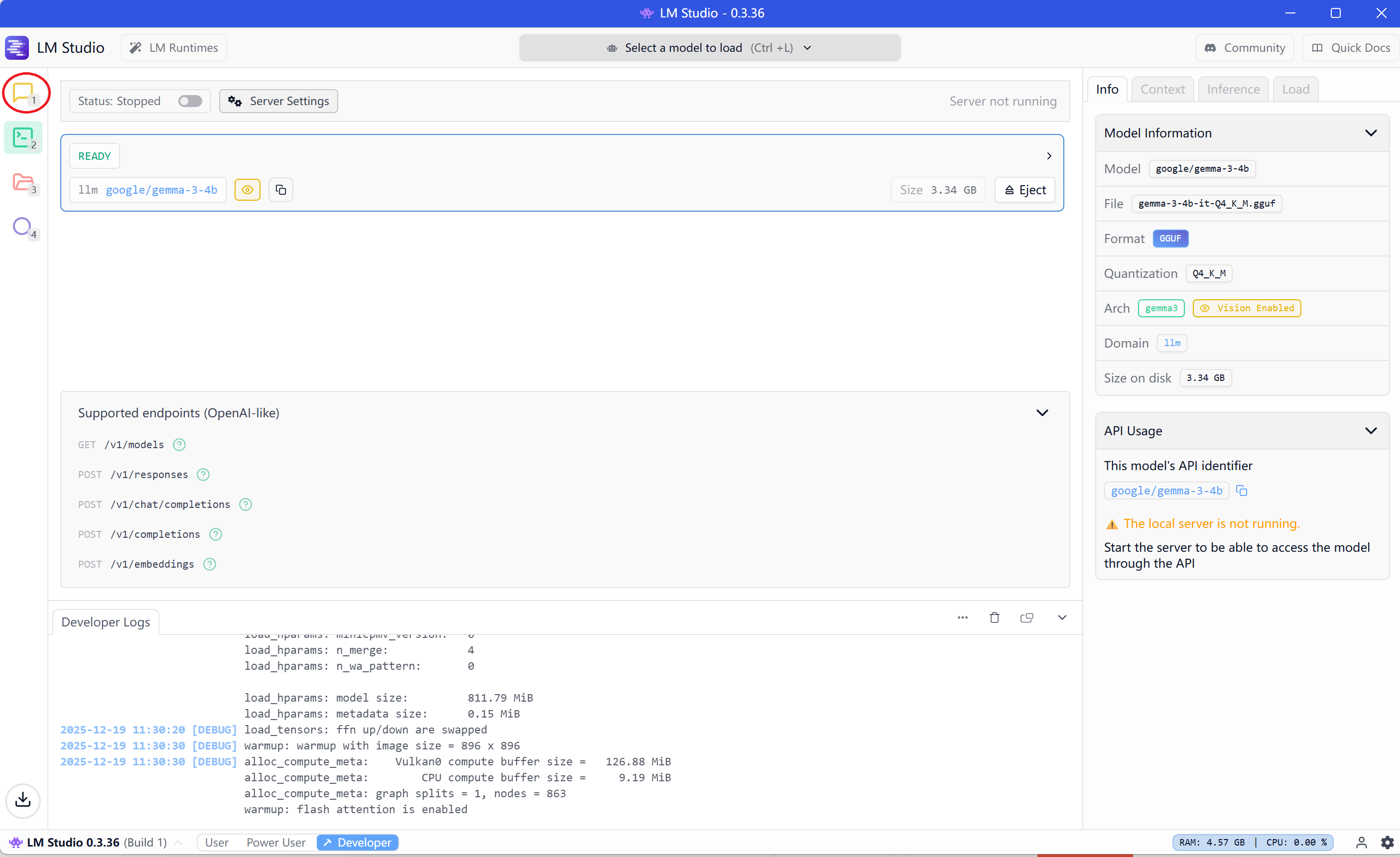

模型加载成功之后,会在右侧显示模型的具体信息,然后就可以开始通过红色圆圈里的Chat和大模型进行Chat了。

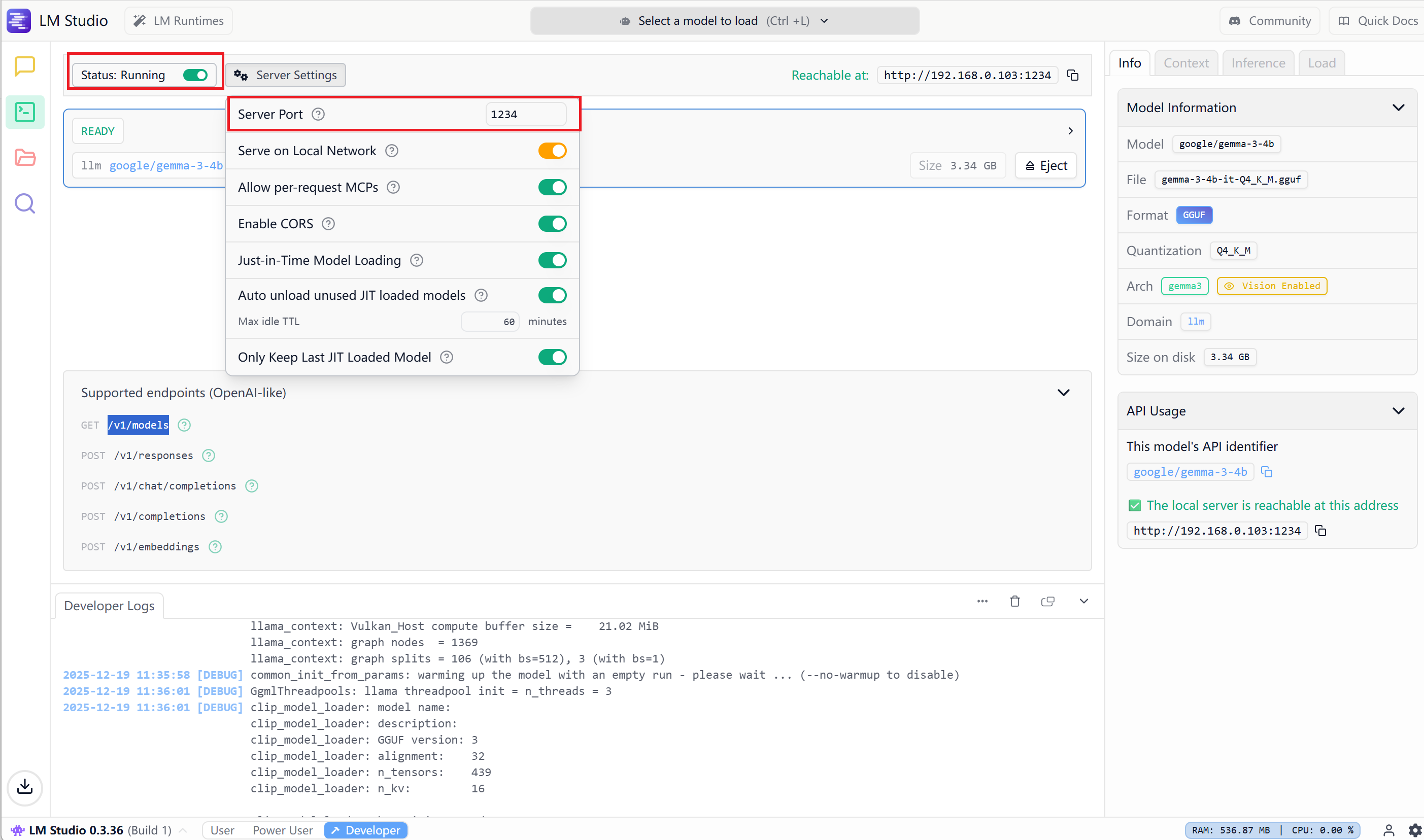

服务器的信息可以通过Server Settings查看:默认 Status Running是disable,需要手工Enable一下:

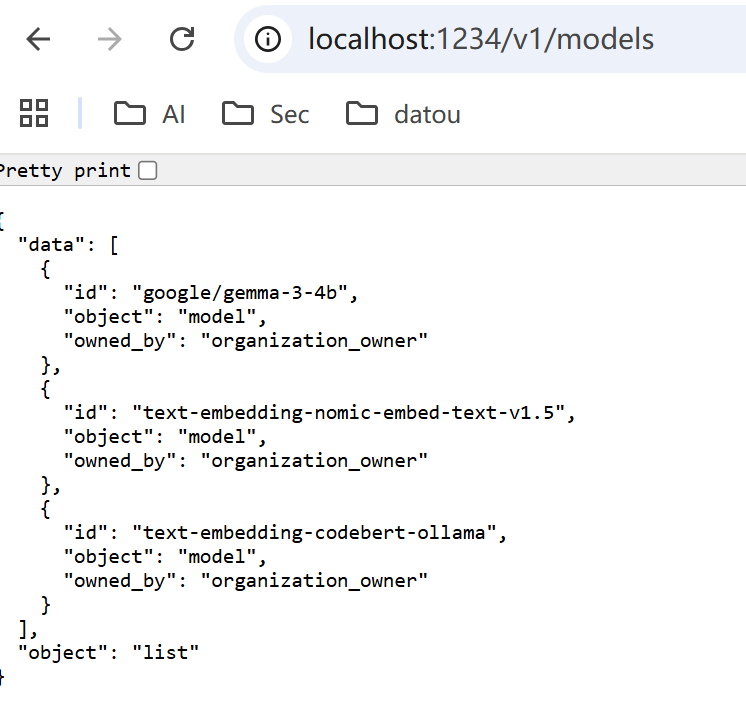

然后,就可以通过URL http://localhost:1234/v1/models 查看是否可以通过API访问:

3.3、使用LM Studio的示例代码

python

import requests

# LM Studio 服务器的 OpenAI 兼容 API 地址

url = "http://localhost:1234/v1/chat/completions"

# 构建请求数据

data = {

"model": "gemma-3-4b", # 这个名称不重要,LM Studio 会使用当前加载的模型

"messages": [

{"role": "user", "content": "如何学习AI?给初学者三条建议"}

],

"temperature": 0.7,

"max_tokens": 500

}

# 发送请求

response = requests.post(url, json=data)

# 检查响应

if response.status_code == 200:

result = response.json()

answer = result["choices"][0]["message"]["content"]

print("回答:", answer)

else:

print(f"请求失败: {response.status_code}")

print(response.text)在使用的过程中,虽然LM Studio的UI工具使用起来很方便,同样的机器,感觉性能比较差一些。

4、其他工具

Ollama提供命令行工具访问,LM Studio提供UI工具,这两款工具基本上可以满足绝大部分的需求了。在本章再简单介绍几个比较流行的工具,有兴趣的可以下载工具去试试。

4.1、 AnythingLLM

AnythingLLM 是一款企业级、全栈式的私有化 ChatGPT 替代方案,核心功能是让您用自己的文档构建专属知识库,并通过对话进行智能查询。 下载网站地址:https://anythingllm.com/desktop。

核心定位:

"基于自有文档的私有化 ChatGPT + 企业级知识库管理系统"

主要特征:

| 特性 | 说明 |

|---|---|

| 📚 多格式文档支持 | 直接上传 PDF、Word、Excel、PPT、TXT、Markdown、图片(OCR)、网页链接、音频(转录)等 |

| 🔍 智能检索增强(RAG) | 自动分割、向量化文档内容,精准检索相关片段生成回答 |

| 🏢 多工作区管理 | 为不同团队/项目创建独立的知识库和工作空间 |

| 👥 多用户与权限控制 | 完整的用户系统,支持管理员、成员等角色权限管理 |

| 🔄 多模型后端支持 | 可连接 Ollama、LM Studio、OpenAI API、Azure OpenAI、Anthropic、本地 HuggingFace 模型等 |

| 💬 多样化对话模式 | 支持普通对话、基于文档的问答、混合模式 |

| 🚀 一键部署 | 提供 Docker 容器和桌面版,部署简单 |

| 🔒 完全私有化 | 所有数据(文档、向量、对话)均存储在本地/自有服务器 |

4.2、 OpenWebUI

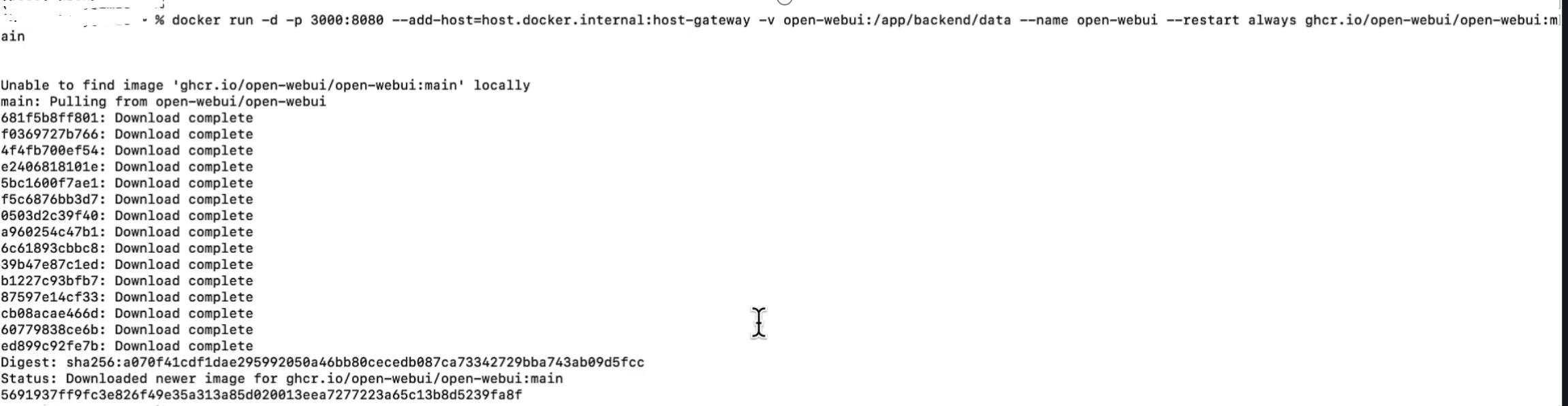

Open WebUI (原名 Ollama WebUI)是一款开源、现代化的 Web 界面,专为本地大语言模型设计,提供类似 ChatGPT 的聊天体验。关于OPENWebUI可以参考:https://docs.openwebui.com/getting-started/quick-start/,可以通过docker直接加载,。

加载之后注意访问方式:

核心定位:

"ChatGPT 式的本地 AI 聊天界面,功能丰富且易于部署"

主要特征:

| 特性 | 说明 |

|---|---|

| 🌐 现代 Web 界面 | 类似 ChatGPT 的直观聊天界面,支持 Markdown、代码高亮、数学公式渲染 |

| 🤖 多后端支持 | 原生支持 Ollama(默认),也支持 OpenAI API、OpenRouter、LM Studio 等后端 |

| 📁 多模型切换 | 轻松在多个本地模型间切换,无需重启应用 |

| 💬 对话管理 | 完整的对话历史记录、重命名、搜索、导出/导入功能 |

| 🖼️ 多模态支持 | 支持图像上传和视觉模型(如 LLaVA)的图片分析 |

| 📝 提示词模板 | 内置常用提示词模板库,支持自定义模板 |

| 🔌 插件系统 | 支持扩展插件(如联网搜索、知识库集成等) |

| 🔧 高级功能 | 模型参数调节、RAG(检索增强生成)功能、角色预设 |

| 🚀 一键部署 | 提供 Docker、Kubernetes 部署,也支持直接安装 |

5、 总结

5.1、 工具比较

| 维度 | Ollama | LM Studio | Open WebUI | AnythingLLM |

|---|---|---|---|---|

| 核心定位 | 本地LLM命令行管理器 | 本地LLM桌面GUI应用 | 本地LLMWeb聊天界面 | 企业级文档知识库系统 |

| 核心功能 | 模型下载、运行、管理 | 图形化模型管理、运行、参数调节 | 现代化Web聊天界面、对话管理 | 文档上传、向量化、RAG问答、多工作区 |

| 界面类型 | 命令行终端 | 桌面应用程序 | Web浏览器界面 | Web浏览器界面 |

| 部署方式 | 命令行安装/Docker | 桌面安装包 | Docker/直接安装 | Docker/桌面版/专业版 |

| 模型支持 | 专为Ollama优化的模型 | 大部分GGUF格式模型 | 多后端:Ollama、OpenAI API等 | 多后端:Ollama、OpenAI等 |

| 数据管理 | 模型文件管理 | 模型文件管理 | 对话历史管理 | 文档知识库、向量数据库、用户数据 |

| 多用户支持 | ❌ | ❌ | ✅(需配置) | ✅(完整权限系统) |

| 文档处理 | ❌ | ❌ | 有限(需插件) | ✅核心功能(多格式支持、OCR、转录) |

| 聊天体验 | 基础命令行交互 | 基础聊天界面 | ChatGPT式体验(Markdown、代码高亮) | 文档问答专用界面 |

| 优势 | 轻量、快速、脚本友好 | 图形化、零配置、适合初学者 | 功能丰富、现代界面、易部署 | 专业文档处理、企业级功能 |

| 局限性 | 无图形界面 | 功能相对简单 | 需要额外部署后端 | 相对复杂、资源需求较高 |

| 开源状态 | 开源免费 | 免费使用 | MIT开源 | 开源版 + 商业版 |

| 典型用户 | 开发者、终端爱好者 | 个人用户、快速实验者 | 团队共享、Web界面爱好者 | 企业、团队、知识密集型用户 |

| 一句话总结 | "模型管理专家" | "开箱即用体验者" | "Web版ChatGPT皮肤" | "私有化知识库专家" |

5.2、 我应该选择哪个工具?

| 你的需求 | 推荐工具 | 原因 |

|---|---|---|

| 只想快速在本地运行模型 | LM Studio | 下载即用,无需配置,图形界面直观 |

| 需要在脚本/自动化中使用模型 | Ollama | 命令行友好,易于集成到工作流 |

| 想要类似ChatGPT的Web界面 | Open WebUI | 功能丰富,界面现代,支持多用户 |

| 需要基于文档进行问答 | AnythingLLM | 专门为文档知识库设计,RAG功能完整 |

| 团队协作使用 | Open WebUI 或 AnythingLLM | 支持多用户,易于共享访问 |

| 企业级知识管理 | AnythingLLM | 完整权限系统、工作区管理 |

| 测试比较多个模型 | LM Studio 或 Open WebUI | 图形化界面方便切换比较 |

5.3、技术架构对比

| 组件 | Ollama | LM Studio | Open WebUI | AnythingLLM |

|---|---|---|---|---|

| 前端技术 | 无(CLI) | 桌面应用(Electron) | Vue.js(Web) | React(Web) |

| 后端技术 | Go语言服务 | 本地服务 | Python FastAPI | 多种技术栈 |

| 数据存储 | 模型缓存 | 模型缓存 | SQLite/PostgreSQL | SQLite/向量数据库 |

| 通信协议 | REST API | 本地进程通信 | HTTP/WebSocket | HTTP/WebSocket |

5.4、组合使用建议

实际上,这些工具可以组合使用发挥更大威力:

-

最佳实践组合:

text

Ollama(模型运行) + OpenWebUI(界面交互) ↓ 强大的本地ChatGPT替代方案 -

专业工作流:

text

LM Studio(模型测试选型) → Ollama(生产环境部署) → AnythingLLM(文档知识库应用) -

个人学习路线:

text

LM Studio(入门体验) → OpenWebUI(日常使用) → Ollama(深入了解)

5.5、总结

| 工具 | 本质 | 最适合 | 核心价值 |

|---|---|---|---|

| Ollama | 模型运行时引擎 | 开发者、自动化脚本 | 轻量高效的模型管理 |

| LM Studio | 桌面应用 | 个人用户、快速实验 | 零配置的图形化体验 |

| Open WebUI | Web界面框架 | 团队共享、Web爱好者 | 现代化的聊天交互界面 |

| AnythingLLM | 知识库应用平台 | 企业、文档密集型用户 | 私有化文档智能问答系统 |