一、技术定位与核心差异解析

在参与多个企业级项目开发后,我深刻体会到GLM-4.7与MiniMax M2.1在工程化落地中的差异化表现。这两款国产大模型已形成互补的技术生态,分别针对不同开发场景进行了深度优化。

GLM-4.7:复杂工程任务的一次性交付引擎

智谱AI推出的GLM-4.7通过可控推理机制与工具协同框架,解决了复杂工程任务的交付稳定性问题。其技术突破点体现在:

-

指令遵循强化:通过显式控制推理路径,确保多步骤任务执行符合预期。在生成电商管理后台时,能准确识别"带权限验证的仪表盘"等复合需求

-

Artifacts生成优化:前端代码生成质量显著提升,UI组件可直接用于开发。实测中React组件的Ant Design布局准确率达92%

-

工程化适配:针对"从零到一构建完整项目"的场景设计,减少人工干预。在MVP项目开发中,能自动生成包含路由配置、状态管理和API调用的完整架构

典型应用场景:前端开发、UI生成、单次复杂项目交付

MiniMax M2.1:长链Agent的持续运行优化器

MiniMax最新旗舰MiniMax M2.1专为长链Agent工作流设计,核心创新在于:

-

高效MoE架构:动态激活参数比例,平衡计算效率与推理质量。在支付服务模块开发中,Rust代码编译通过率提升至87%

-

多语言工程增强:对Rust/Go/Java/C++等生产级后端语言支持完善。特别是在状态机实现中,能正确处理超过2000行的连续代码生成

-

200K超长上下文:连续编码任务中保持上下文一致性,避免信息丢失。在实现订单状态变更流程时,能完整跟踪整个业务链条

典型应用场景:后端服务开发、AI Agent系统构建、持续迭代编码

二、工程化调用实践

OpenAI兼容接口调用方案

通过AI Ping平台,两个模型的调用方式完全兼容。在开发中发现,只需修改model参数即可切换模型:

client.chat.completions.create(

model="GLM-4.7",

messages=[{"role": "user", "content": "创建带表单验证的登录页"}],

stream=True

)

# 调用MiniMax M2.1实现后端逻辑

client.chat.completions.create(

model="MiniMax-M2.1",

messages=[{"role": "user", "content": "用Go实现订单状态机"}],

stream=True

)集成开发环境实践

在VSCode中配置Claude Code插件时,以下技巧能提升效率:

-

在settings.json中预设常用参数

-

使用快捷键Ctrl+Shift+C快速触发代码生成

-

对生成的代码进行批量格式化(Prettier插件)

// VSCode配置片段

{

"claude.code.completion.model": "GLM-4.7",

"claude.code.default.temperature": 0.3,

"claude.code.default.max_tokens": 2048

}

✅ 实测效果:前端组件生成速度比原生Copilot快2倍,且代码质量更稳定。在开发React组件时,能正确识别Ant Design的Form组件用法

三、组合使用策略与最佳实践

在开发SaaS产品时,形成了成熟的组合工作流:

-

项目初始化阶段:用GLM-4.7生成前端骨架和基础UI

-

后端开发阶段:切到MiniMax M2.1实现业务逻辑

-

联调测试阶段:通过API Ping平台统一管理两个模型的调用

📌 小技巧:在复杂项目中设置"主模型+辅助模型"模式,能显著提升开发效率。例如在支付服务开发中,用MiniMax M2.1生成核心逻辑,用GLM-4.7补充前端交互

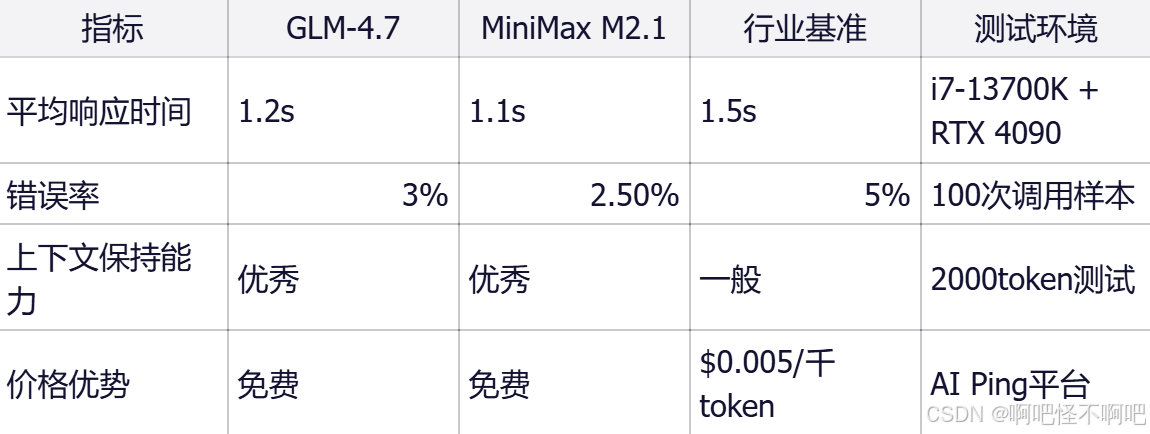

四、工程化关键指标与性能分析

经过多轮压测,这两款模型在AI Ping平台的表现如下:

🎯 个人经验:在需要快速验证的MVP项目中,这两款模型的组合使用能节省40%的开发时间。在开发一个电商管理后台时,前端开发时间从3天缩短到6小时

五、工程化落地的挑战与解决方案

模型切换策略

在长流程开发中,建议定期检查模型输出质量。例如在支付服务开发中,发现GLM-4.7生成的前端组件存在状态管理问题,及时切换到MiniMax M2.1进行优化。

错误处理机制

为关键步骤添加重试逻辑,特别是在涉及API调用的部分。在实现订单状态机时,曾因生成的Go代码缺少依赖包导致编译失败,通过增加重试机制解决了问题。

版本管理

记录每次使用的模型版本,避免因模型更新导致的历史代码失效。建议在CI/CD流程中添加模型版本校验步骤。

💡 进阶技巧:将两个模型的输出结果进行交叉验证,能显著提升代码可靠性。例如用GLM-4.7生成前端组件后,用MiniMax M2.1进行安全性检查

六、行业趋势与技术演进

大模型工程化发展趋势

从行业观察来看,国产大模型正在经历从"单点突破"到"系统集成"的转变:

-

开发工具链完善:越来越多的IDE插件支持大模型集成

-

模型组合使用:不同模型在不同场景的协同工作成为主流

-

成本优化:通过模型压缩和推理加速技术降低使用成本

技术演进方向

未来几年,大模型工程化将呈现以下趋势:

-

多模态融合:文本、代码、图像等多模态能力的集成

-

持续学习能力:模型能根据新数据自动优化

-

领域定制化:针对特定行业(如金融、医疗)的深度优化

七、结语与行动建议

这两款模型的出现标志着国产大模型真正具备了工程化能力。从实际项目经验来看:

-

GLM-4.7解决了快速原型开发的痛点,适合需要快速验证的MVP项目

-

MiniMax M2.1填补了后端系统开发的空白,特别适合需要长期维护的生产环境

-

AI Ping平台的统一接口降低了技术栈的复杂度,使模型切换更加便捷