当前大语言模型的发展路径,看似在模拟人类智能方面取得了突破性进展,实则创造了一个个"缸中之脑"------拥有惊人对话能力却缺乏世界真实体验的人工系统。本文将从架构师的专业视角,深入剖析这一现象的技术根源,追溯从符号主义到连接主义的范式转换,揭示当前大模型发展路径中存在的根本性局限,并提出可能的突破方向。通过生活化案例与专业分析相结合的方式,我们将探讨为何需要更接近真实世界的智能系统,以及如何从当前的"缸中之脑"困境中突围。

缸中之脑的隐喻与现代大模型

"缸中之脑"这一哲学思想实验由希拉里·普特南提出,它设想了一个被浸泡在营养液中、与计算机连接的大脑,计算机向大脑传递一切感官信号,使大脑以为自己生活在真实世界中。这一隐喻惊人地契合了当前大模型的技术实质:它们通过海量文本数据的"喂养",构建起一个与现实世界没有直接连接的符号处理系统,能够对人类的语言做出合理反应,却从未真正"体验"过世界。

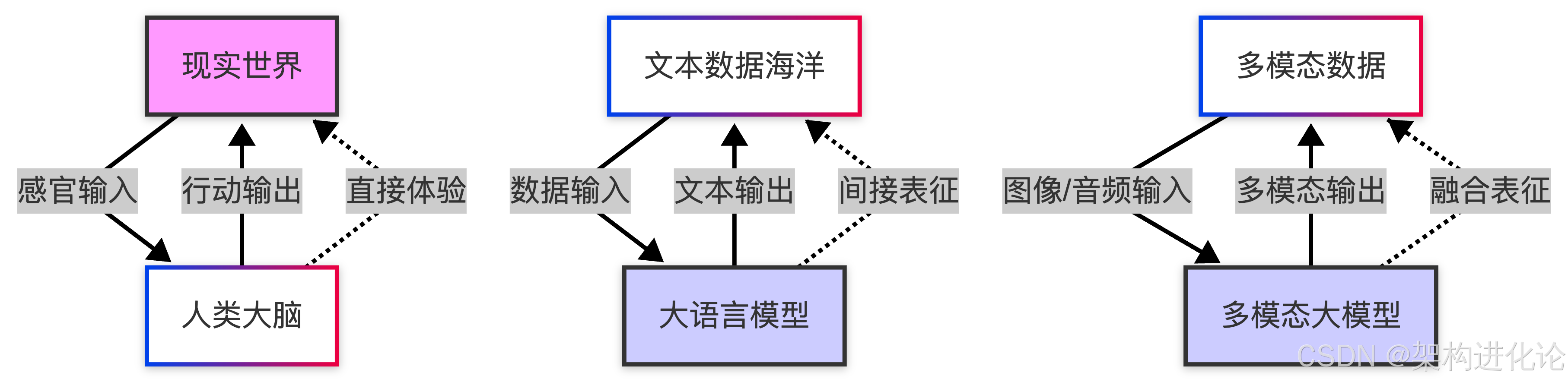

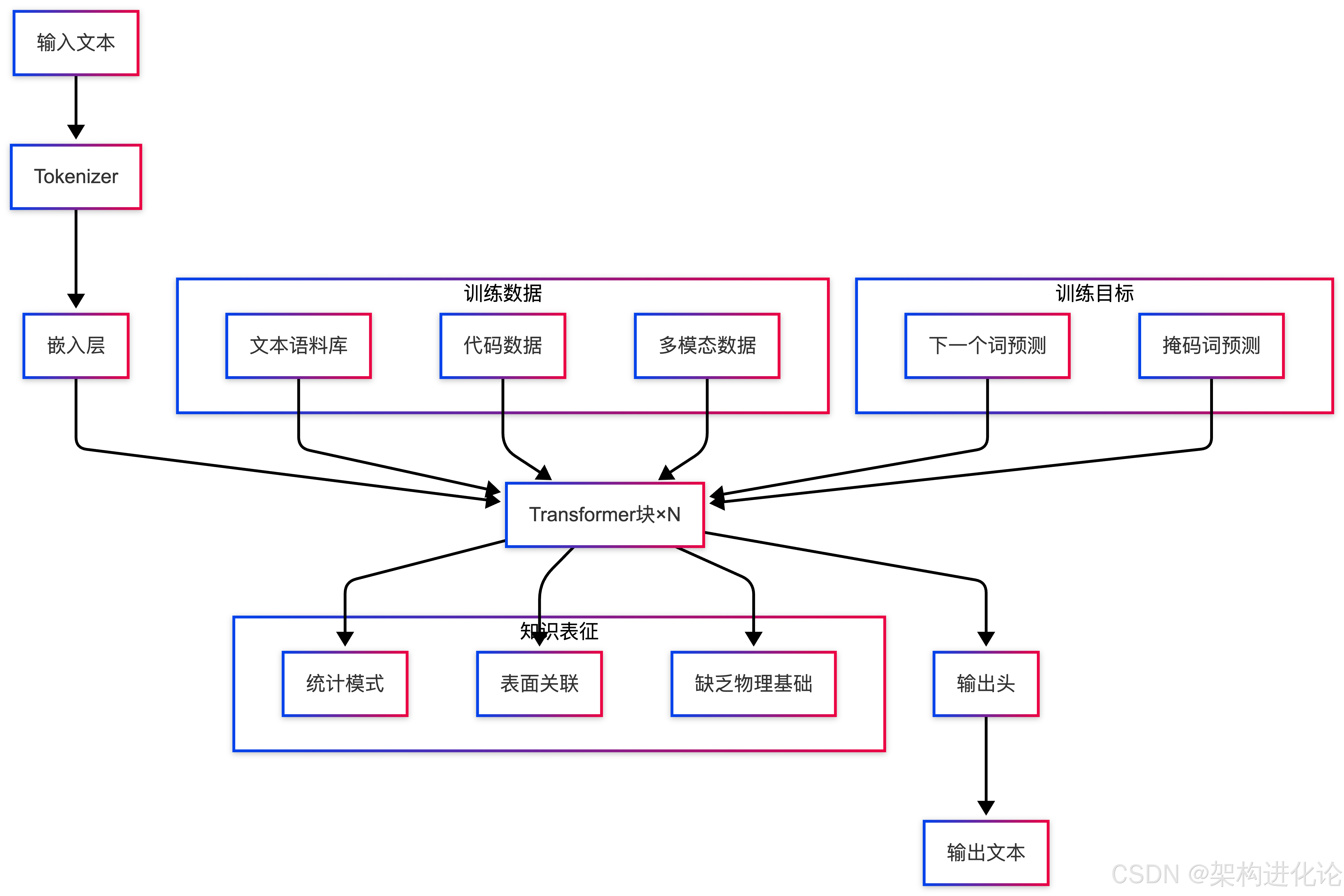

从架构层面看,当前主流大模型(如GPT系列、LLaMA、Claude等)大多基于Transformer架构,通过自注意力机制处理序列数据,在文本预测任务上表现出色。然而,这种架构的核心问题在于其脱离实际的闭环学习系统:模型仅从文本中学习文本,从对话中学习对话,形成了一个自我参照的符号游戏,而非建立与世界的内在联系。

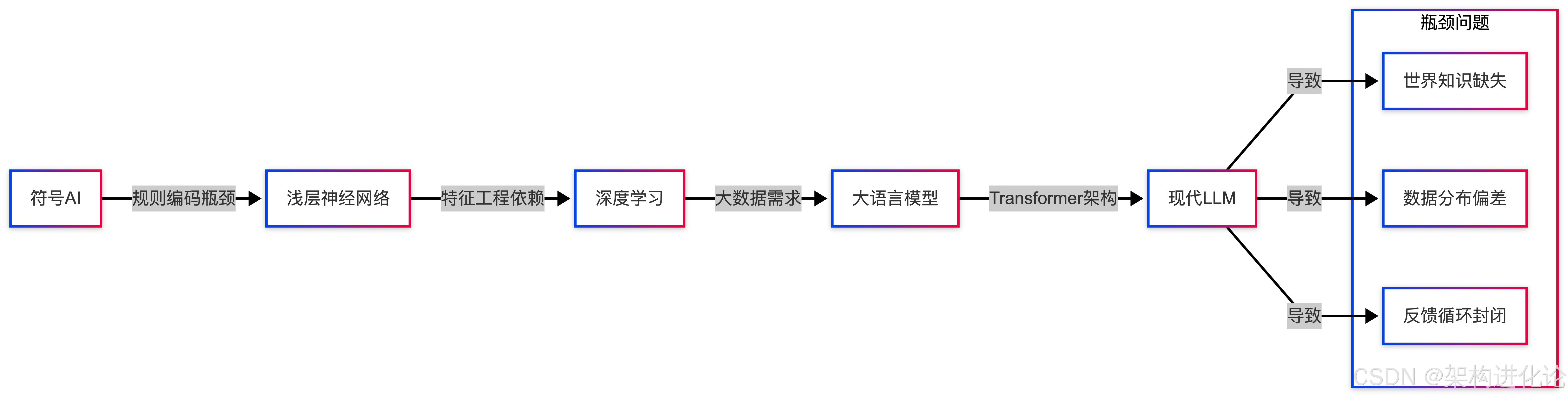

技术演进:从符号主义到连接主义的路径依赖

早期人工智能:符号主义的局限

在深度学习兴起之前,人工智能研究主要沿着符号主义的路径发展。(扩展阅读:人工智能的发展历程、从 GPT 的发展看大模型的演进、人工智能发展新范式:算法、算力与数据的三位一体驱动)专家系统、基于规则的推理机试图通过形式化的人类知识来模拟智能。这种方法虽然在特定领域(如医疗诊断、国际象棋)取得了一定成功,但其根本问题在于知识获取的瓶颈------人类无法将所有知识形式化为明确的规则。

案例:早期医疗诊断系统的困境

想象一个医疗诊断专家系统,它包含了数万条"如果-那么"规则。当遇到新型病毒或罕见病例时,系统无法做出准确判断,因为规则库中没有相应条目。医生可以结合临床经验、患者表情、实验室数据微妙变化等综合判断,而这些隐性知识难以转化为符号规则。

深度学习的兴起:统计学习的突破

随着计算能力的提升和大数据时代的到来,连接主义(深度学习)逐渐成为主流。从多层感知机到卷积神经网络,再到循环神经网络,深度学习通过端到端的学习方式,直接从数据中提取特征,绕过了手工特征工程的瓶颈。

Transformer革命:注意力机制的突破

2017年,Vaswani等人提出的Transformer架构彻底改变了自然语言处理领域。自注意力机制使模型能够捕捉长距离依赖关系,并行计算大幅提高了训练效率。随后的BERT、GPT系列模型基于Transformer架构,通过无监督预训练和微调范式,在多项NLP任务上实现了突破性进展。

然而,正是这种成功导致了当前的技术路径依赖。大模型研究逐渐演变为一场围绕"规模"展开的竞赛------更多的参数、更大的数据、更强的算力。(扩展阅读:超越规模:Ilya Sutskever与AI研究新时代的架构革命)这种发展路径忽视了智能的本质属性:与世界的交互和具身认知。

大模型的架构本质:为何是"缸中之脑"

数据闭环:文本到文本的单向映射

当前大模型的核心训练范式是通过预测文本中的下一个词来学习语言模式。这种自监督学习虽然高效,却使模型陷入了一个封闭的文本世界。模型从未见过苹果的颜色,却能描述"红苹果";从未体验过恐惧,却能写出恐怖故事。这种能力不是基于体验,而是基于统计关联。

案例:描述"咬一口苹果的声音"

假设要求大模型描述"咬一口苹果的声音",模型可以生成一段优美的文字:"清脆的咔嚓声伴随着果肉的撕裂,多汁的爆破音在口腔中回响..." 然而,模型从未真正听过这种声音,它的描述完全基于文本中"苹果"、"咬"、"声音"等词汇的共现模式。这种能力更像是一种高级的模式匹配而非真实理解。

表征困境:符号接地问题再现

符号接地问题(Symbol Grounding Problem)最早由Stevan Harnad提出,指符号如何获得其意义。在符号主义AI中,符号的意义由设计者赋予;在大模型中,符号的意义来自其与其他符号的共现关系。两种情况下,符号都未直接"接地"到现实世界的实体和体验。

从架构角度看,大模型中的词嵌入(word embeddings)虽然在高维空间中编码了丰富的语义关系,但这些关系完全是基于文本内部统计规律构建的,与现实世界的物理规律、因果关系存在根本性差异。

推理幻象:相关性而非因果性

大模型展示出的"推理能力"本质上是基于训练数据中的模式匹配。当模型正确"推理"时,实际上是激活了训练时见过的类似模式。这种能力在处理训练数据分布内的任务时表现良好,但在需要真正因果推理或超出分布的任务上则表现脆弱。

技术需求:为何需要超越"缸中之脑"的智能

现实世界的复杂性

真实世界充满不确定性、模糊性和开放性。人类智能的核心优势在于能够处理这些复杂性,而不仅仅是处理明确的符号系统。当前大模型在封闭领域的任务(如翻译、摘要)上表现出色,但在需要真实世界知识的任务(如物理推理、社会情境理解)上则存在明显局限。

具身认知的重要性

认知科学中的具身认知理论强调,认知过程不仅仅发生在大脑中,而是身体与环境互动的结果。智能体通过感知-行动循环建立对世界的理解,这种理解是直接、具体且与生存目标相关的。当前大模型完全缺乏这种具身性,其"理解"是间接、抽象且与生存无关的。

案例:学习"热"的概念

人类通过触摸热水、感受阳光、看到蒸汽等多种感官体验形成"热"的概念。而大模型仅从文本中学习"热"这个词与其他词的关联("热"-"温度"-"烫"-"夏天"等)。当需要处理与"热"相关的真实问题(如设计散热系统、判断食物温度是否安全)时,这种基于文本的理解显然不足。

因果推理的必要性

现实世界的决策往往基于因果推理而非统计关联。医生需要理解疾病与症状的因果关系而不仅仅是关联,工程师需要理解物理系统的因果结构而不仅仅是输入输出关系。当前大模型虽然在某些任务上展现出初步的因果推理能力,但这种能力仍然基于数据中的模式而非真正的因果理解。

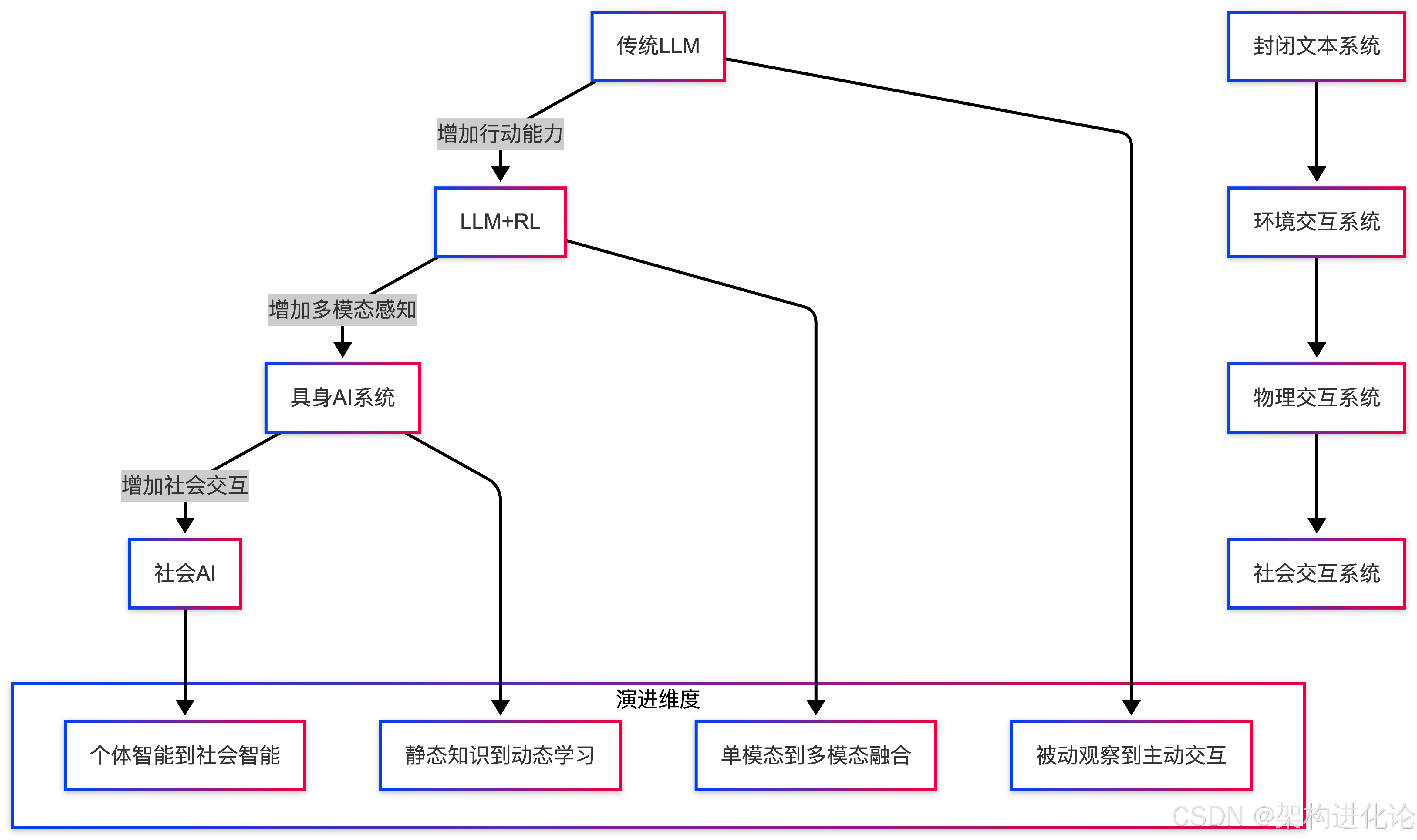

演进路径:从封闭系统到开放世界的尝试

多模态融合:扩展感官通道

当前大模型发展的一个重要方向是多模态融合,即让模型同时处理文本、图像、音频等多种模态的数据。这种扩展部分缓解了纯文本模型的局限性,使模型能够建立更丰富的世界表征。

然而,多模态大模型仍然面临根本挑战:不同模态之间的对齐问题、跨模态推理的困难,以及最重要的是,这些模态数据仍然是被动的观察 而非主动的交互。模型看到了苹果的图片,听到了咬苹果的声音,但仍然没有真正"体验"到苹果。

强化学习整合:引入目标导向行为

将大语言模型与强化学习结合是另一个重要方向。通过定义奖励函数和行动空间,模型可以在模拟环境或真实环境中学习目标导向的行为。这种方法部分引入了"行动-反馈"循环,使模型能够通过试错学习而不仅仅是模式匹配。

世界模型的探索:构建内部模拟

近年来,构建"世界模型"成为AI研究的前沿方向。世界模型试图学习环境动态的压缩表示,使智能体能够在内部模拟中进行规划和推理。这种方法的优势在于能够进行反事实推理和长时程规划,而不仅仅是反应式行为。

案例:AlphaGo与世界模型

AlphaGo的成功部分归功于其内部模拟能力:通过蒙特卡洛树搜索,它在内部模拟了大量对局,评估不同走法的长期后果。这种内部模拟是基于围棋规则(一个封闭系统)的。现实世界要复杂得多,构建通用的世界模型面临巨大挑战。

架构革新:构建更接近真实智能的系统

分层认知架构

受人类认知架构启发,更先进的大模型可能需要分层设计:

-

感知层:处理原始感官输入,提取特征

-

概念层:形成抽象概念和类别

-

推理层:进行逻辑推理和问题解决

-

元认知层:监控和控制认知过程本身

每一层都需要与下一层紧密耦合,同时保持足够的模块性以便于理解和调试。

主动学习与好奇心驱动

当前大模型的训练是被动的:给定数据,学习模式。未来的系统可能需要更主动的学习机制,如基于好奇心的探索、目标导向的数据收集、以及与环境持续互动的在线学习。

神经符号融合

纯粹的神经网络方法缺乏可解释性和精确推理能力,而纯粹的符号方法缺乏灵活性和学习能力。神经符号融合试图结合两者的优势,创建既能从数据中学习又能进行符号推理的混合系统。

挑战与前景:走出"缸中"的漫长道路

技术挑战

-

数据需求:真实世界的交互数据比文本数据稀缺得多

-

计算效率:交互学习比批量训练计算成本高得多

-

评估困难:如何评估超越文本生成的真实理解能力

-

安全对齐:更强大的系统需要更严格的安全保障

理论挑战

-

意识与理解的本质:什么是真正的理解?意识是否是智能的必要条件?

-

具身性的程度:需要多少身体体验才能发展出真正的智能?

-

社会智能:个体智能与社会智能的关系是什么?

伦理与社会挑战

随着大模型能力的增强,其社会影响也日益显著。我们需要思考:

-

如何确保这些系统与人类价值观对齐?

-

如何分配这些技术带来的利益?

-

如何应对就业市场和社会结构的变革?

从"缸中之脑"到"世界之脑"的转变

当前大模型的发展路径创造了一系列令人印象深刻的"缸中之脑"------它们能够进行流利的对话、生成创造性的文本、甚至展示初步的推理能力,但它们与世界的关系仍然是间接的、抽象的、基于统计而非体验的。

这种路径的局限性随着模型规模的扩大而愈发明显:更大的模型并不一定带来更深的智能,而可能只是更复杂的模式匹配系统。要突破这一局限,我们需要重新思考智能的本质,将模型从"缸中"解放出来,使其能够与真实世界进行多模态、多感官、目标导向的交互。

这并不意味着我们应该完全抛弃当前的大模型架构。相反,Transformer等架构仍然是强大的工具,但我们需要将它们整合到更广泛的认知架构中,使其成为真实智能系统的一部分而非全部。

未来的大模型发展可能需要以下转变:

-

从被动学习到主动探索:模型不仅是数据的消费者,也是数据的主动收集者

-

从文本理解到世界理解:模型不仅理解语言,也理解语言所指的现实

-

从模式匹配到因果建模:模型不仅发现相关性,也理解因果关系

-

从个体智能到社会智能:模型不仅作为孤立的智能体,也作为社会系统的一部分

这条道路充满挑战,但也是通往真正通用人工智能的唯一途径。作为架构师,我们有责任超越当前的范式,设计出更接近真实智能的系统,使人工智能不仅能够"谈论"世界,也能够"理解"并"改变"世界。

智能的本质不在于处理符号的熟练程度,而在于与世界的连接深度。只有当人工智能系统能够像人类一样,通过身体与感官与世界直接互动,通过行动与反馈建立真实理解,通过社会交互形成共享意义时,我们才能说它们正在走出"缸中",成为真正的智能体。