NLP 实战笔记:基于 Scikit-learn 本地数据集的垂直领域词云生成

文章目录

- [NLP 实战笔记:基于 Scikit-learn 本地数据集的垂直领域词云生成](#NLP 实战笔记:基于 Scikit-learn 本地数据集的垂直领域词云生成)

-

-

- [1. 数据源策略:为何放弃在线 Fetch?](#1. 数据源策略:为何放弃在线 Fetch?)

- [2. 数据加载与预处理 Pipeline](#2. 数据加载与预处理 Pipeline)

- [3. 词云生成与超参数解析](#3. 词云生成与超参数解析)

- [4. 解决 NumPy 2.0 兼容性问题 (High Priority)](#4. 解决 NumPy 2.0 兼容性问题 (High Priority))

- [5. 总结](#5. 总结)

-

在自然语言处理(NLP)的探索性数据分析(EDA)阶段,词云(Word Cloud) 依然是快速直观地展示语料库特征分布、捕捉高频关键词的有效手段。

本文将演示如何利用 Python 构建一个轻量级的可视化 Pipeline:从 Scikit-learn 的 20 Newsgroups 本地数据集中提取特定领域的文本,经过预处理清洗后,生成高质量的词云图。同时,本文将解决近期 numpy 版本更新导致的主流词云库兼容性报错问题。

1. 数据源策略:为何放弃在线 Fetch?

在 Scikit-learn 的官方示例中,通常推荐使用 fetch_20newsgroups 接口在线获取数据。然而在实际的工程环境或国内网络环境下,这种依赖外部 HTTP 请求的方式存在明显的不确定性:

- 网络延迟与超时:数据集较大(约 14MB),无进度条的等待极易导致脚本假死。

- 不可复现性:网络波动可能导致数据流中断。

因此,本地化加载(Local Ingestion) 是更稳健的选择。我们预先将数据集下载并解压至本地,利用 sklearn.datasets.load_files 接口进行目录级扫描。这不仅解耦了网络依赖,也符合气隙(Air-gapped)环境下的开发规范。

下载地址:https://ndownloader.figshare.com/files/5975967

点击之后即可下载

- 下载成功之后进行解压,数据集包含训练集与测试集,全部当作文本数据即可,因为本次为词云统计,而不是机器学习。

2. 数据加载与预处理 Pipeline

我们将通过 load_files 加载本地数据,并指定 categories 参数对语料进行初步筛选。本例选取 sci.space(太空科学)板块,旨在生成具有鲜明主题特征的词云。

此外,Newsgroup 数据集包含大量邮件元数据(Header、Footer)。为了避免 Subject, Organization, From 等无意义词汇占据主导权重,我们需要实现一个基于规则的清洗函数。

python

from sklearn.datasets import load_files

from wordcloud import WordCloud

import matplotlib.pyplot as plt

import os

# 本地数据集路径配置

# 数据集结构需满足:root/category/file.txt

LOCAL_DIR = r"D:\Code\NLP\Scikit-learn-NLP词云\20newsbydate\20news-bydate-train"

if not os.path.exists(LOCAL_DIR):

raise FileNotFoundError(f"Dataset not found at {LOCAL_DIR}")

print(f"Loading data from local repository: {LOCAL_DIR} ...")

# 1. 结构化加载

# 仅提取 'sci.space' 类别,实现垂直领域的语料聚焦

dataset = load_files(

LOCAL_DIR,

categories=['sci.space'],

encoding='utf-8',

decode_error='ignore',

shuffle=True,

random_state=42

)

print(f"Data Loaded. Corpus size: {len(dataset.data)} documents.")

# 2. 启发式预处理 (Heuristic Preprocessing)

def strip_newsgroup_header(text):

"""

清洗邮件头:基于双换行符(\n\n)分割元数据与正文

"""

_pos = text.find('\n\n')

if _pos != -1:

return text[_pos+2:]

return text

# 应用清洗逻辑并合并语料

# 将离散的文档列表合并为单个长字符串,供 WordCloud 统计 TF (Term Frequency)

clean_corpus = [strip_newsgroup_header(doc) for doc in dataset.data]

text_payload = " ".join(clean_corpus)3. 词云生成与超参数解析

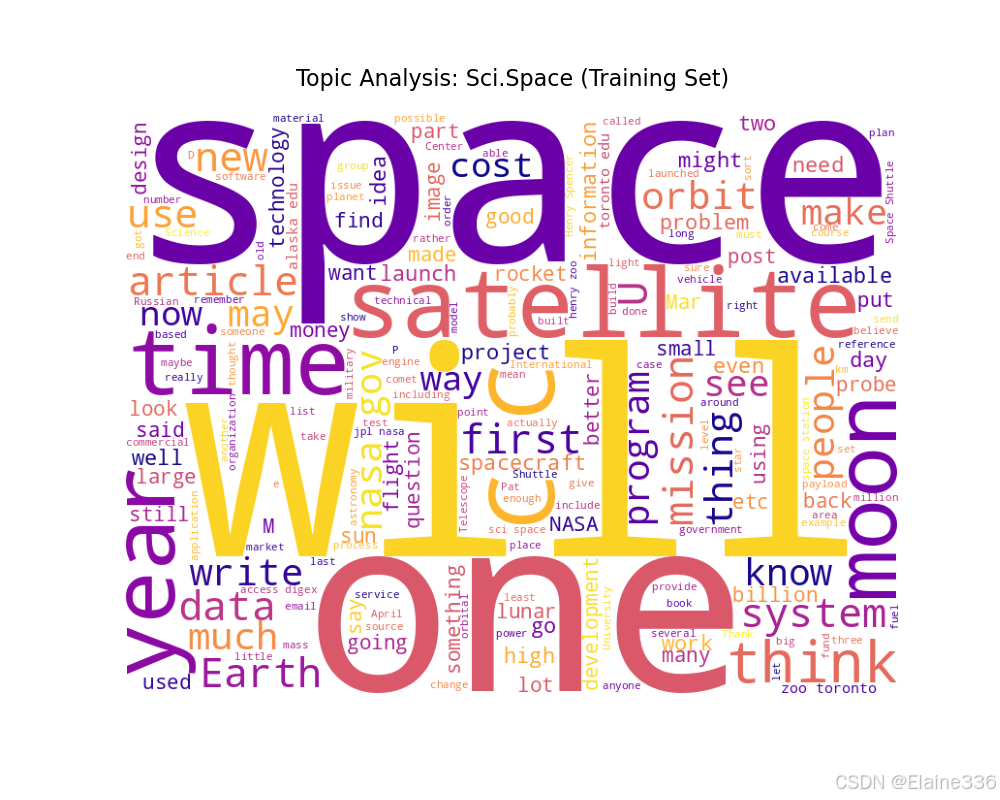

WordCloud 对象的实例化过程涉及多个关键超参数,这些参数决定了最终的可视化效果和信息密度。

python

print("Generating Word Cloud representation...")

wc = WordCloud(

width=800, # 画布水平分辨率

height=600, # 画布垂直分辨率

background_color='white', # 适用于文档/论文的白底风格

max_words=200, # [核心参数] 频率截断阈值。最大词数:只显示频率最高的前200个词

colormap='plasma' # 颜色映射表,'plasma' 提供了高对比度的视觉体验

).generate(text_payload)关于 max_words 的技术考量:

很多开发者误以为 max_words 是库的渲染上限。实际上,这是一个频率截断(Frequency Cutoff) 参数。

- 词云库内部会计算所有 Token 的权重。

max_words=200意味着仅选取 Top-200 权重的词汇进行布局。- 设置过大(如 2000)会导致长尾词汇堆积,增加视觉熵(Visual Entropy),使得核心信息被淹没;设置过小则无法体现语料的丰富度。200 通常是一个平衡点。

4. 解决 NumPy 2.0 兼容性问题 (High Priority)

在最新的 Python 环境中(尤其是 NumPy >= 2.0 版本),直接将 WordCloud 对象传入 Matplotlib (plt.imshow(wc)) 会触发 TypeError: asarray() got an unexpected keyword argument 'copy'。

这是由于 NumPy 2.0 移除了部分旧 API,而 wordcloud 库底层对 np.array 的调用尚未完全适配。

最佳实践解决方案:

不要依赖隐式的类型转换,而是显式调用 .to_image() 方法将词云对象转换为标准的 PIL Image 对象或 NumPy 数组。

python

# 可视化渲染

plt.figure(figsize=(10, 8))

# -------------------------------------------------------

# [Critical Fix] 显式转换图像对象

# 规避 Matplotlib 内部调用 np.array(obj, copy=True) 导致的兼容性崩溃

# -------------------------------------------------------

plt.imshow(wc.to_image())

plt.axis('off')

plt.title("Topic Analysis: Sci.Space (Training Set)", fontsize=16, pad=20)

plt.show()

5. 总结

通过上述流程,我们完成了一个完全本地化、鲁棒性强的 NLP 可视化 Demo。

- 工程解耦 :利用

load_files替代fetch,保证了数据流的稳定性。 - 信噪比优化 :通过 Header 清洗和

max_words调优,确保了生成结果聚焦于实际内容(如NASA,Orbit,Launch)。 - 环境适配:通过代码层面的微调,解决了新版 NumPy 的 Breaking Change。

这种基于本地结构化数据的处理模式,可以非常方便地迁移到其他垂直领域(如金融文本、医疗报告)的关键词分析任务中。