【AI学习-comfyUI学习-第二十四节-open(contorlnet多重处理)+图生图openpose-各个部分学习】

- 1,前言

- 2,说明

- 3,流程

- 4,模块部分说明

-

- [四、为什么每个 ControlNet 应用节点参数几乎一样?](#四、为什么每个 ControlNet 应用节点参数几乎一样?)

- [五、核心 ①:DW OpenPose 预处理(最重要的节点)](#五、核心 ①:DW OpenPose 预处理(最重要的节点))

-

- [📌 节点:DW姿态检测器(comfyui_controlnet_aux)](#📌 节点:DW姿态检测器(comfyui_controlnet_aux))

- 它在干嘛(大白话)

- 5,细节部分

- 6,工作流链接

- 7,总结

1,前言

最近,学习comfyUI,这也是AI的一部分,想将相关学习到的东西尽可能记录下来。

2,说明

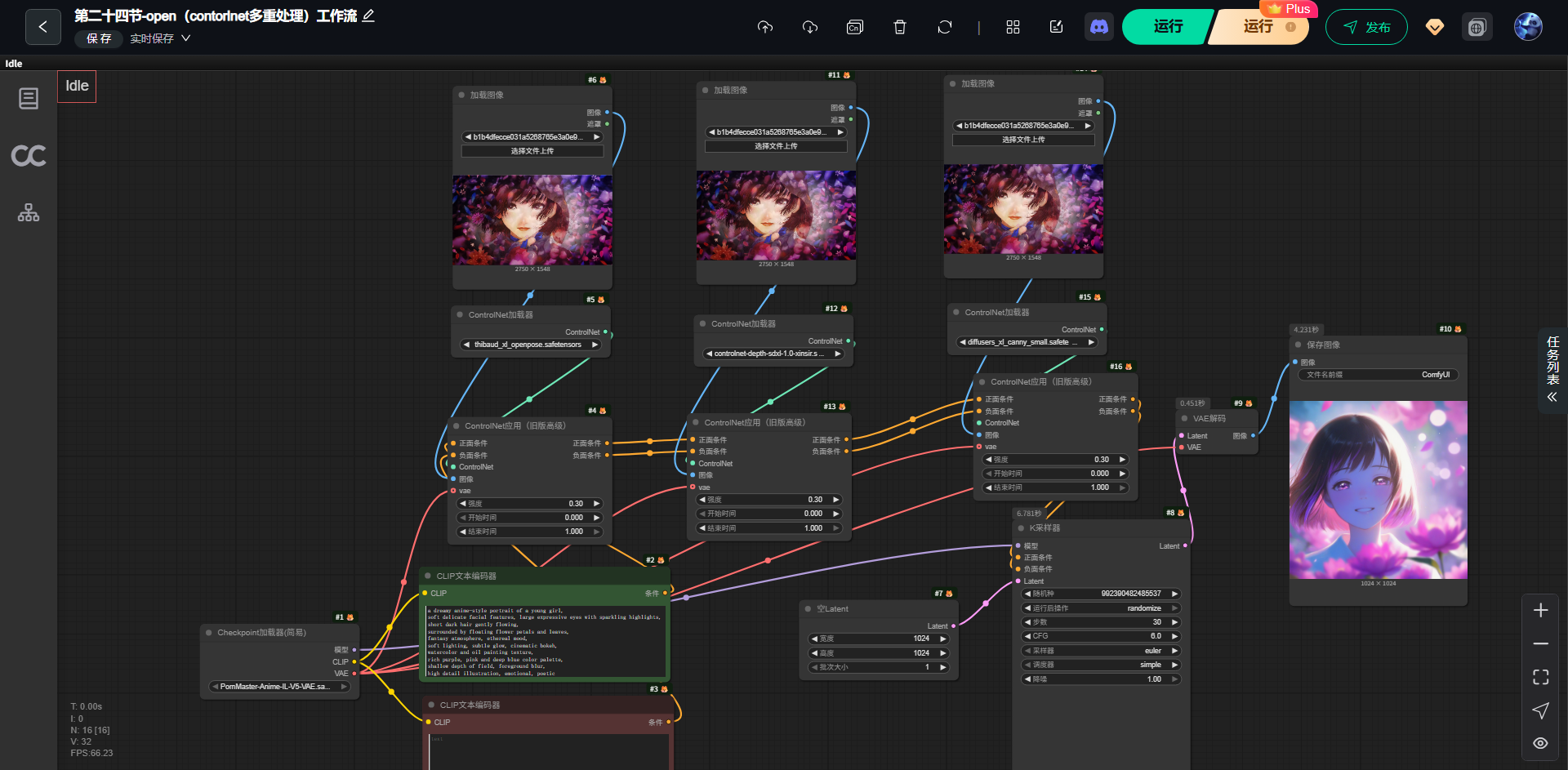

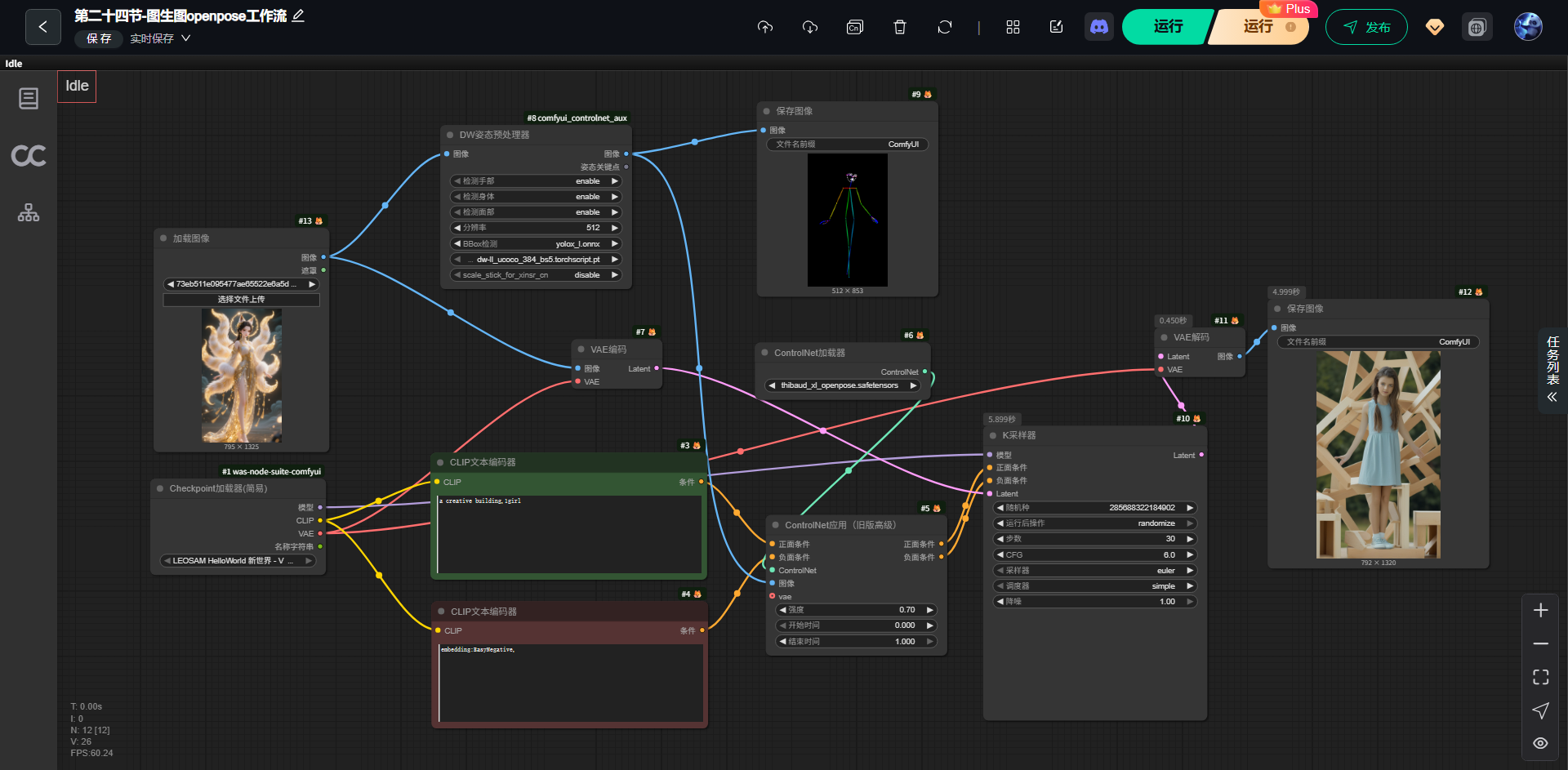

1,第二十四节-open(contorlnet多重处理)工作流

这是一个「多模态结构约束 + 文本语义驱动」的 SDXL 稳定重绘工作流,

通过 OpenPose、Depth、Canny 三种 ControlNet,从姿态、空间、轮廓三个层面约束生成过程,在保证结构一致性的前提下,由 Prompt 决定风格与细节。

用同一张参考图,分别抽取「人物姿态」「空间深度」「轮廓结构」,

再把这三种约束一起喂给 Stable Diffusion,让生成结果:

-

人物姿势不跑

-

结构不塌

-

构图稳定

-

风格由 Prompt 决定

bash

参考图 → 三种 ControlNet 条件 → 文本语义 → 采样生成 → 解码保存2,第二十四节2-图生图openpose工作流

用一张参考图 → 自动抽人体骨架(OpenPose) →

在"图生图"的基础上,让新生成的人物严格沿用原图姿势,但外观、风格由 Prompt 决定。

bash

原始图片

↓

OpenPose 骨架提取(可视化)

↓

ControlNet(OpenPose)

↓

图生图采样(KSampler)

↓

生成结果保存3,流程

1-第二十四节-open(contorlnet多重处理)工作流

| 图像 | 用来干什么 |

|---|---|

| 图 1 | 提取 OpenPose(人物骨架) |

| 图 2 | 提取 Depth(深度关系) |

| 图 3 | 提取 Canny(边缘轮廓) |

(1)调用模块

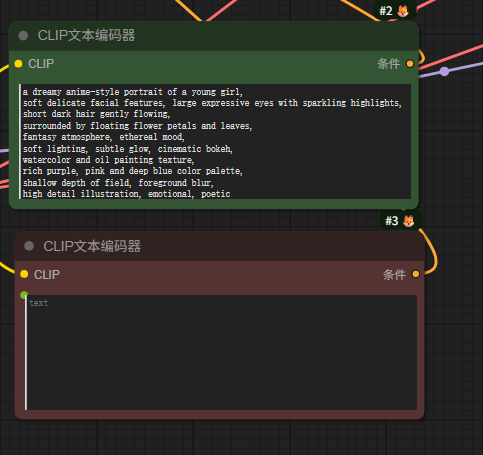

(2)输出 提示词

bash

a dreamy anime-style portrait of a young girl,

soft delicate facial features, large expressive eyes with sparkling highlights,

short dark hair gently flowing,

surrounded by floating flower petals and leaves,

fantasy atmosphere, ethereal mood,

soft lighting, subtle glow, cinematic bokeh,

watercolor and oil painting texture,

rich purple, pink and deep blue color palette,

shallow depth of field, foreground blur,

high detail illustration, emotional, poetic

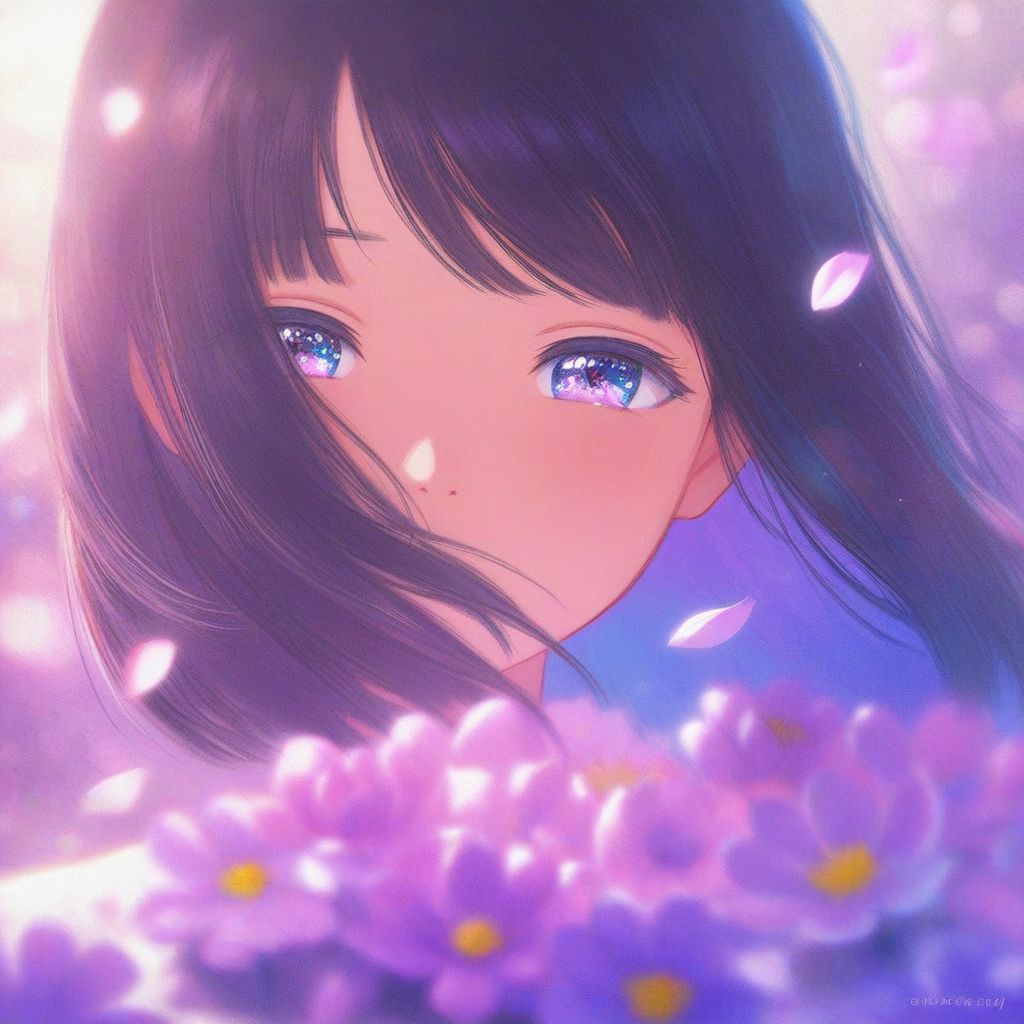

(3)生成图片

(1)原图片-参考图片

(2)生成图片

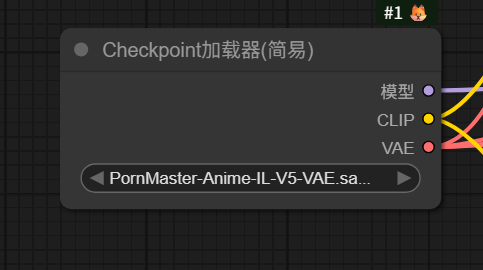

(4)模型选择

2-第二十四节2-图生图openpose工作流

(1)调用模块

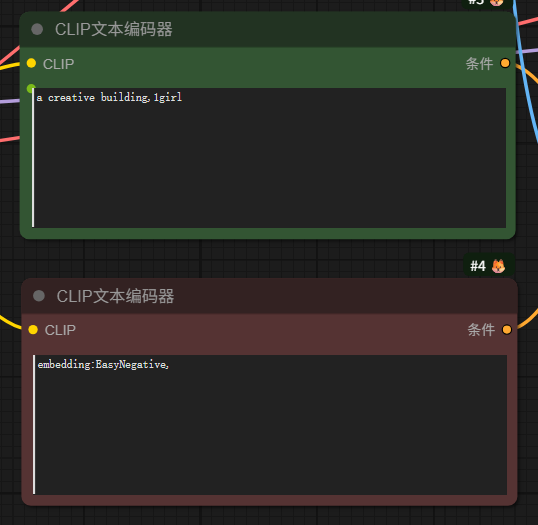

(2)输出 提示词

bash

a creative building,1girl

embedding:EasyNegative,

(3)生成图片

(1)原图片

(2)生成图片

(4)使用模型

4,模块部分说明

① OpenPose 分支(控制"人怎么站")

用到的节点

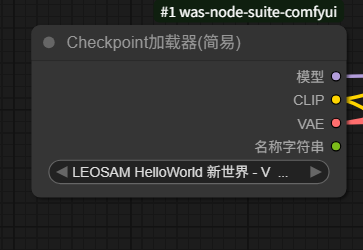

- ControlNet 加载器:

thibaud_xl_openpose - ControlNet 应用(旧版高级)

它控制什么?

- 人体姿势

- 四肢角度

- 身体比例

- 脸部朝向(一定程度)

📌 作用一句话:

"人物别乱动,姿势就按参考图来。"

② Depth 分支(控制"远近空间")

用到的节点

- ControlNet:

controlnet-depth-sdxl - ControlNet 应用(旧版高级)

它控制什么?

- 前景 / 中景 / 背景关系

- 脸不会突然塌

- 背景不会贴脸

📌 作用一句话:

"谁近谁远,按原图的空间关系来。"

③ Canny 分支(控制"轮廓结构")

用到的节点

- ControlNet:

diffusers_xl_canny - ControlNet 应用(旧版高级)

它控制什么?

- 发型外轮廓

- 脸型边界

- 大的结构线条

📌 作用一句话:

"形状别跑,轮廓要稳。"

四、为什么每个 ControlNet 应用节点参数几乎一样?

你这里用的是:

- 强度(weight):0.30

- 开始时间:0.0

- 结束时间:1.0

这代表什么?

三种约束 都不"抢戏"

只是轻轻扶住模型

如果你想微调(很重要):

| 想要效果 | 调哪一个 |

|---|---|

| 姿势必须完全一致 | 提高 OpenPose 到 0.5~0.7 |

| 结构老是崩 | 提高 Canny |

| 脸部透视怪 | 提高 Depth |

| 画面太死 | 降低所有 ControlNet 权重 |

好,这一张是**「第二十四节 · 图生图 OpenPose 工作流」,

我还是按你最熟悉的方式来:大白话 + 输入 / 输出 + 每一块在干嘛,而且和你刚才那个多 ControlNet 的流程做对比**,你一眼就能记住。

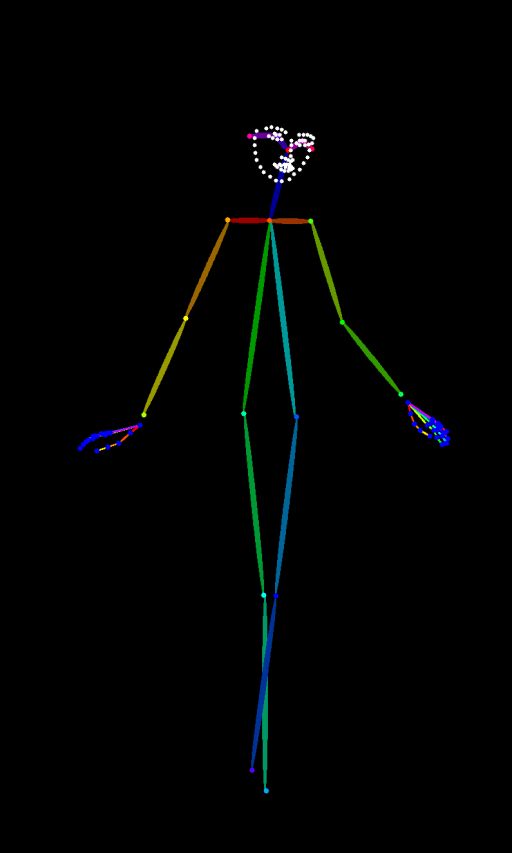

五、核心 ①:DW OpenPose 预处理(最重要的节点)

📌 节点:DW姿态检测器(comfyui_controlnet_aux)

你这个节点里打开的选项非常关键:

- ✅ 检测身体:enable

- ✅ 检测手部:enable

- ✅ 检测面部:enable

- 模型:

dw-ll_ucoco_384_bs5_torchscript.pt

它在干嘛(大白话)

把一张真人图 → 变成一根"彩色火柴人骨架图"

右上角保存的那张黑底 + 彩色线条的图,就是:

- 头

- 脊柱

- 手臂

- 腿

- 关节位置

📌 这是 OpenPose ControlNet 真正吃进去的东西

5,细节部分

1,多次尝试,画面细节有崩的地方,描述词相关

6,工作流链接

(1)第二十四节-open(contorlnet多重处理)工作流

https://download.csdn.net/download/qq_22146161/92500339

(2)第二十四节2-图生图openpose工作流

https://download.csdn.net/download/qq_22146161/92500336

7,总结

不断学习摸索中。