关键词:人工智能大模型 人工智能培训 大模型培训 具身智能培训 智能体 VLA

有效整合文本、图像等不同模态信息,以提升模型的跨模态理解与生成能力,是当前多模态人工智能(Multimodal AI)研究的核心问题。以下从架构设计、对齐策略、训练方法、应用场景等多个维度系统阐述关键技术和实践路径:

一、核心挑战

异构性(Heterogeneity):文本是离散符号序列,图像是连续像素空间,二者语义表示差异大。

对齐困难(Alignment):如何在语义层面建立跨模态对应关系(如"狗" ↔ 狗的图像)。

信息冗余与互补:不同模态可能包含重复或互补信息,需有效融合而非简单拼接。

生成一致性:跨模态生成(如图文生成)需保持语义一致性和细节真实性。

二、主流技术路径

- 统一表示学习(Unified Representation)

目标:将不同模态映射到共享语义空间。

代表方法:

CLIP(Contrastive Language--Image Pretraining):通过对比学习对齐图像和文本嵌入。

ALIGN、FLAVA、BLIP:扩展至更大规模数据或多任务联合训练。

优势:支持零样本迁移、跨模态检索。 - 跨模态注意力机制(Cross-Modal Attention)

在Transformer架构中引入跨模态注意力层,使一个模态能"关注"另一个模态的关键区域。

例如:ViLT(Vision-and-Language Transformer)直接将图像块与文本token一起输入Transformer。

LXMERT、Oscar 等模型使用双流编码+交叉注意力融合。

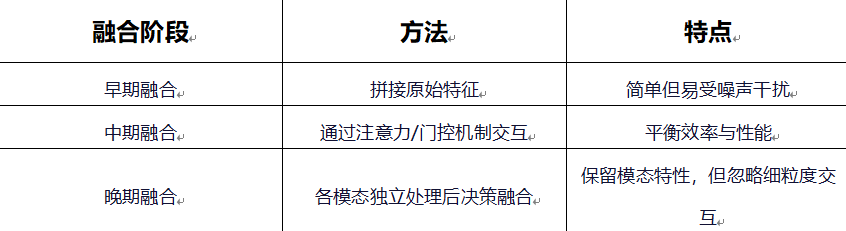

3.多模态融合策略

- 预训练 + 微调范式

大规模多模态预训练:利用海量图文对(如LAION、COCO、Conceptual Captions)进行自监督学习。

下游任务微调:针对VQA、图像描述、跨模态检索等任务微调。

关键预训练目标:

图文匹配(ITM)

掩码语言建模(MLM)+ 视觉词预测

对比学习(InfoNCE loss) - 生成式多模态模型

文本→图像生成:DALL·E 系列、Stable Diffusion(结合CLIP文本编码器)

图像→文本生成:BLIP、GIT(Generative Image-to-text Transformer)

统一生成框架:Flamingo、KOSMOS-1 支持任意顺序的多模态输入输出。

三、提升性能的关键实践

高质量对齐数据:噪声标签会严重损害跨模态对齐效果,需清洗或使用弱监督对齐。

模态平衡采样:避免某一模态主导训练(如文本信息量远大于图像时)。

引入外部知识:结合知识图谱或常识库增强语义理解(如VisualCOMET)。

评估指标多元化:

理解任务:Recall@K、VQA Accuracy

生成任务:BLEU、CIDEr、CLIPScore、人工评估

四、前沿方向

通用多模态基础模型:如GPT-4V、Gemini,支持文本、图像、音频、视频等任意组合。

具身多模态学习:结合机器人交互数据,实现"感知-理解-行动"闭环。

可解释性与可控生成:通过提示工程(prompting)或控制向量引导生成内容。

低资源多模态学习:小样本、无监督或跨语言多模态迁移。

点击下方名片,获取更多资源!