-

个人首页: VON

-

鸿蒙系列专栏: 鸿蒙开发小型案例总结

-

综合案例 :鸿蒙综合案例开发

-

鸿蒙6.0:从0开始的开源鸿蒙6.0.0

-

鸿蒙5.0:鸿蒙5.0零基础入门到项目实战

-

Electron适配开源鸿蒙专栏:Electron for OpenHarmony

-

Flutter 适配开源鸿蒙专栏:Flutter for OpenHarmony

目录

- [DeepSeek-V3.2 模型在 OpenJiuWen 中的部署实践](#DeepSeek-V3.2 模型在 OpenJiuWen 中的部署实践)

DeepSeek-V3.2 模型在 OpenJiuWen 中的部署实践

引言:OpenJiuWen 简介

OpenJiuWen 是一个开源的大模型管理与推理平台,支持多种主流大语言模型(LLM)的快速接入、部署与调用。其核心目标是为开发者提供统一、高效、可扩展的模型服务接口,降低大模型落地门槛。通过 OpenJiuWen,用户可以轻松将如 DeepSeek、Qwen、Llama 等模型集成到自己的应用中,并实现可视化管理、API 调用、性能监控等功能。

本文将详细介绍如何在 OpenJiuWen 平台中部署 DeepSeek-V3.2 模型,借助华为云 ModelArts 提供的 API 服务完成配置与测试。

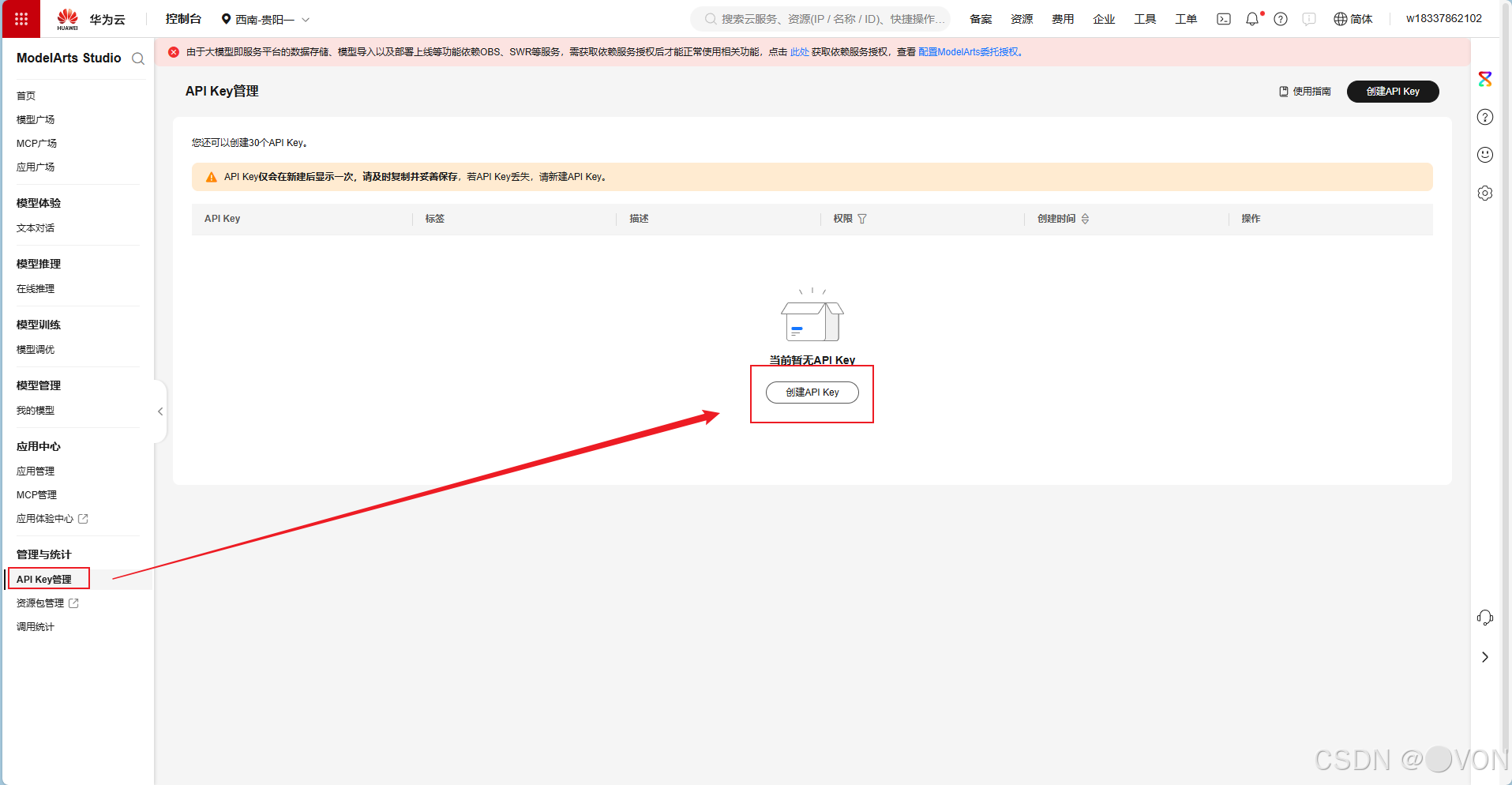

一、获取 API Key

首先,我们需要在华为云 ModelArts 控制台中申请用于调用 DeepSeek-V3.2 模型的 API 密钥。

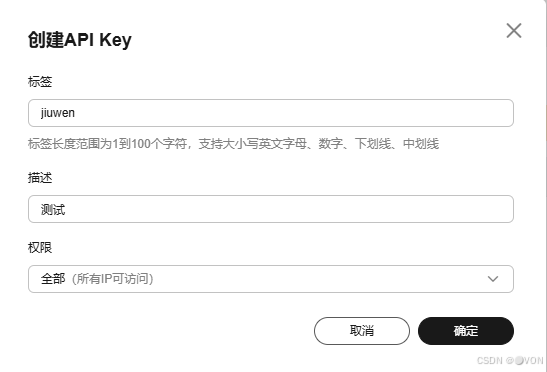

1.访问 ModelArts 控制台 - 授权管理页面。

2.在"新增授权"界面中,填写任意合法的授权名称和描述(仅用于标识,不影响功能)。

3.创建成功后,系统会生成一组 API Key 和 Secret,请妥善保存。后续在 OpenJiuWen 中配置模型时将用到该密钥。

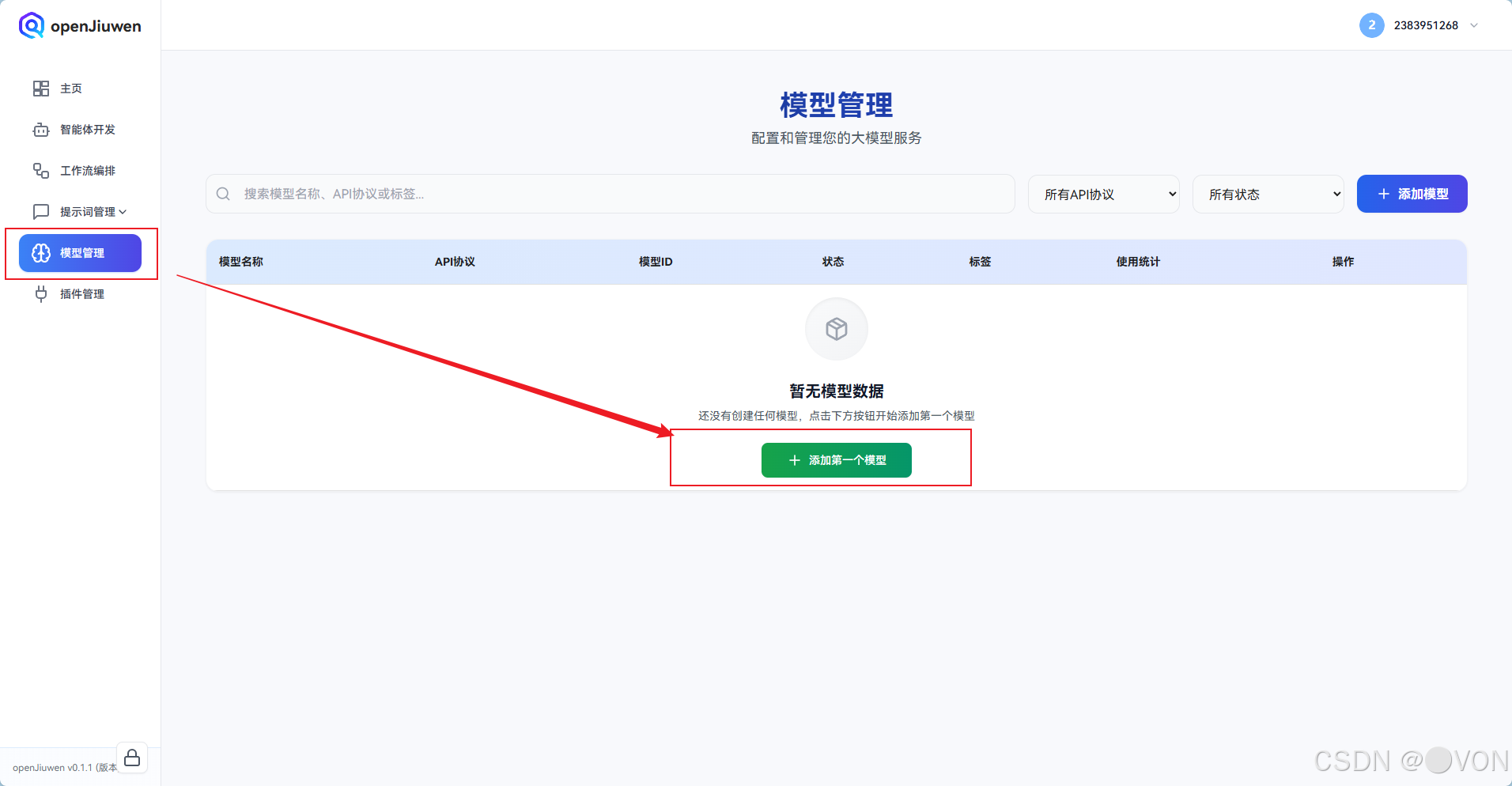

二、在 OpenJiuWen 中创建模型

进入 OpenJiuWen 的模型管理界面,点击"新建模型"以添加 DeepSeek-V3.2。

参数说明

| 参数名 | 说明 |

|---|---|

| 模型名称 | 用于界面显示的友好名称,例如 DeepSeek-V3.2 |

| API 协议 | 选择 OpenAI 或 Custom(根据 DeepSeek 是否兼容 OpenAI 协议;若使用华为云标准 API,则选 Custom) |

| 模型 ID | 华为云提供的模型唯一标识符(如 deepseek-v3-2) |

| API 密钥 | 上一步获取的 API Key |

| 基础服务地址 | 华为云 ModelArts 提供的 API 根路径 |

| 标签 | 可选,用于分类,如 deepseek, llm |

| 描述 | 补充说明,如"基于华为云部署的 DeepSeek-V3.2 模型" |

| 超时时间 | 建议设为 60 秒或更高,确保长文本生成不被中断 |

获取模型参数

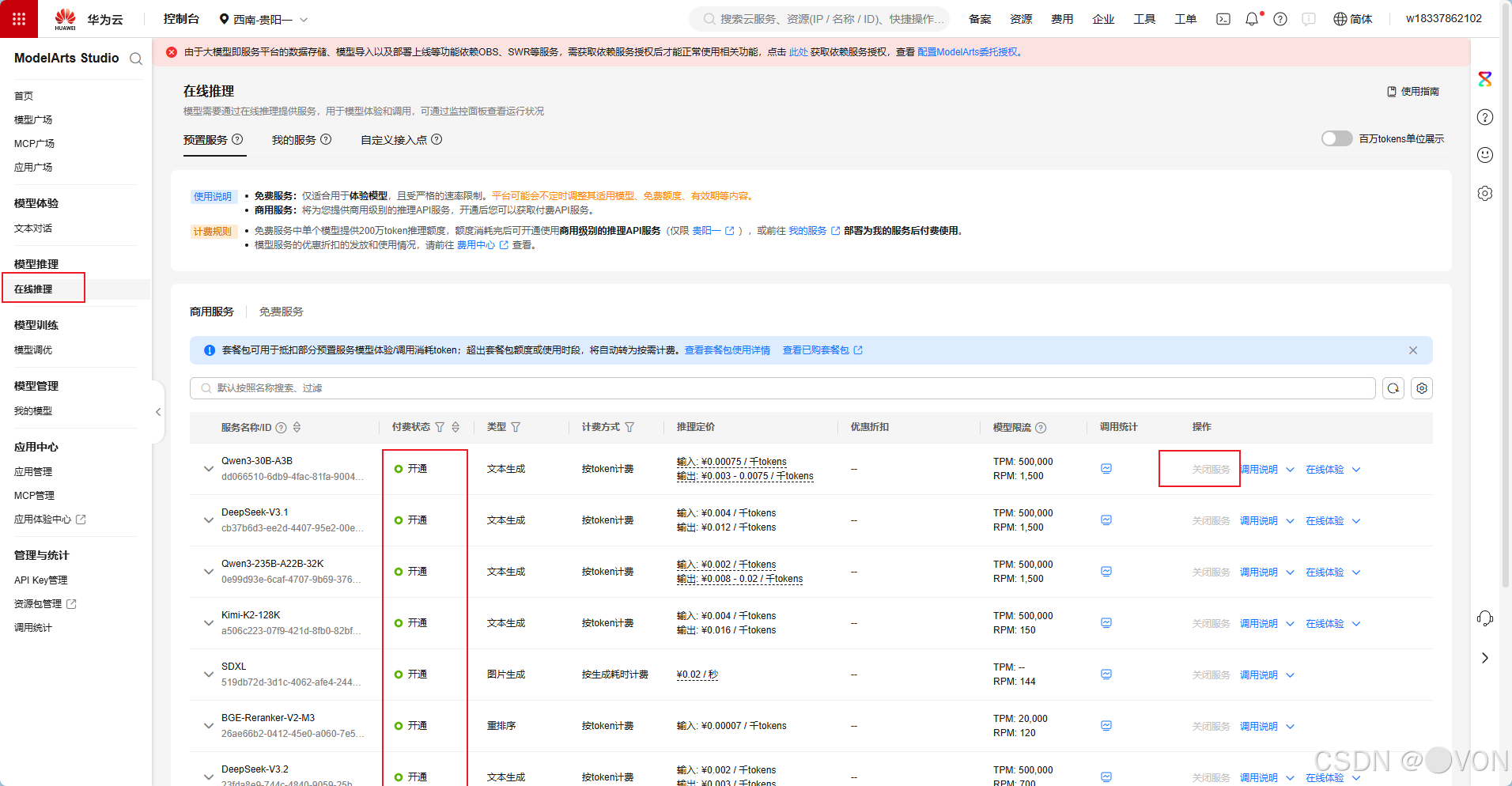

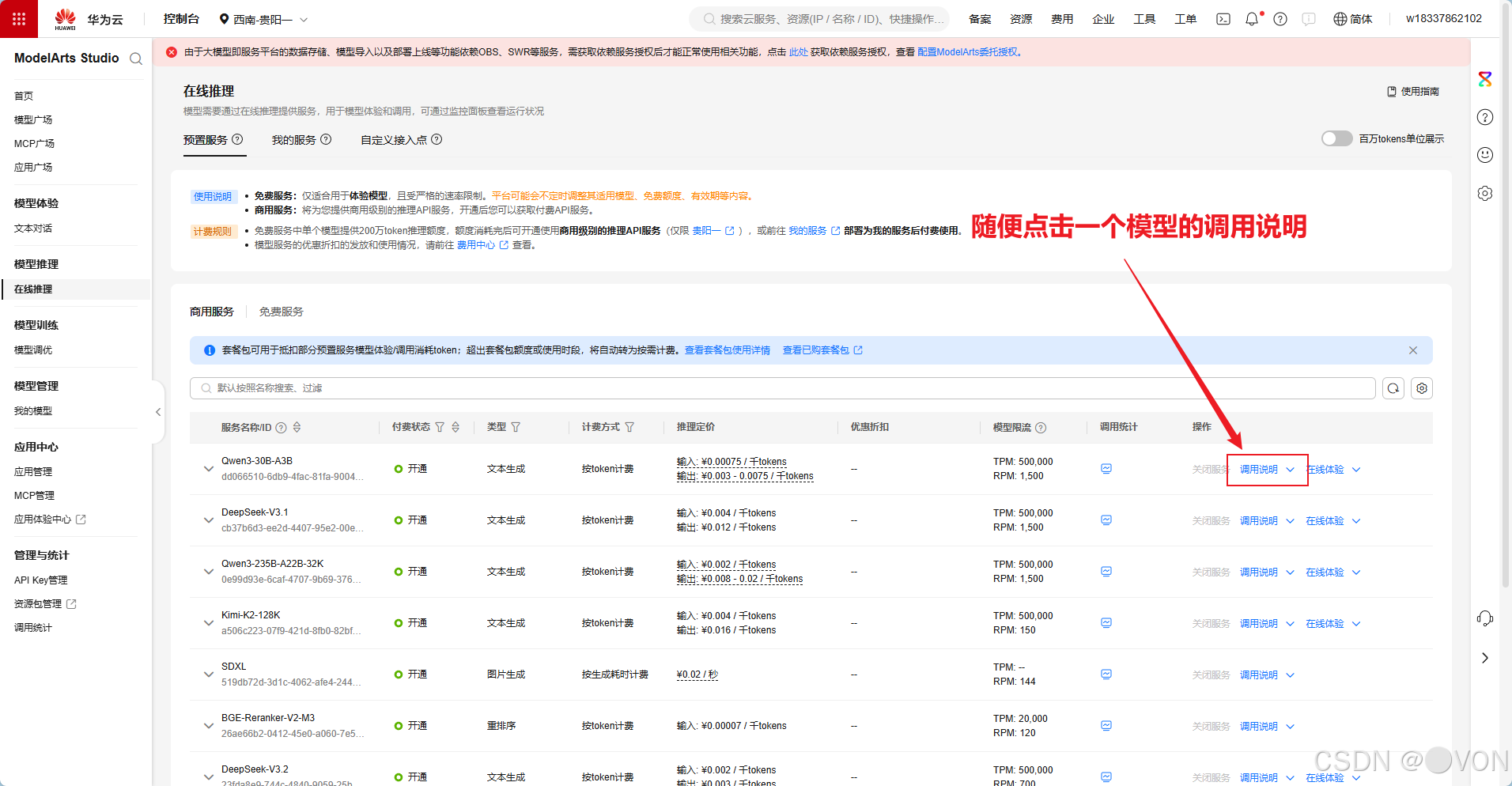

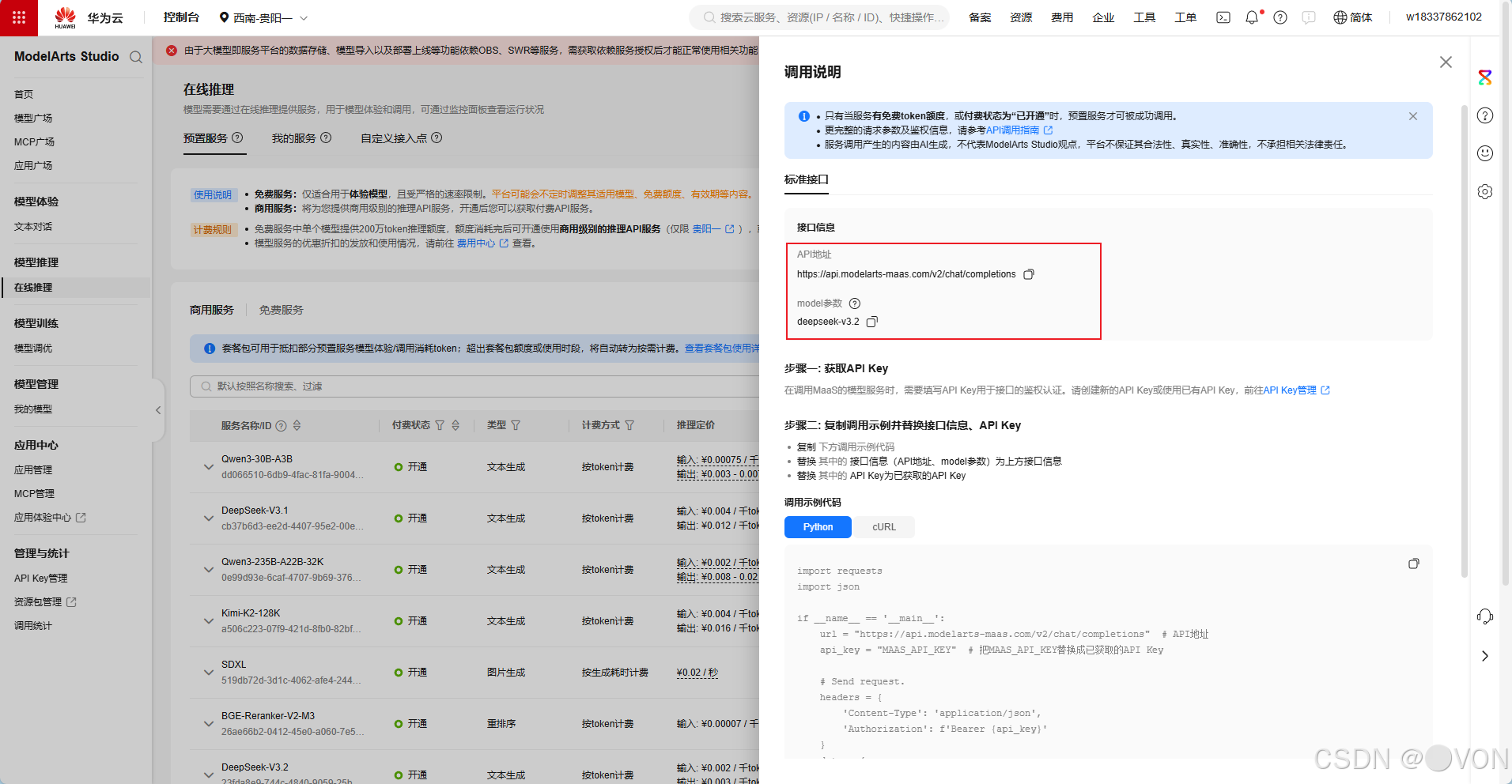

1.在华为云 ModelArts 的"模型部署"或"在线服务"中,找到已部署的 DeepSeek-V3.2 服务。

2.进入服务详情页,查看"调用说明"。

3.从中提取两个关键信息:

-

Endpoint URL**(基础服务地址)**

-

Model ID(模型标识)

4.将上述参数填入 OpenJiuWen 的模型创建表单中:

三、测试模型

模型配置完成后,可在 OpenJiuWen 的模型详情页直接发起测试请求。

1.点击"测试"按钮,输入示例提示词(Prompt),如:"请介绍一下人工智能的发展历程。"

2.若配置正确,系统将返回模型生成的响应内容,表明部署成功。

总结

通过以上步骤,我们成功将 DeepSeek-V3.2 模型接入 OpenJiuWen 平台,并完成了端到端的调用验证。该方案充分利用了华为云 ModelArts 的托管推理能力与 OpenJiuWen 的统一调度优势,为多模型管理提供了标准化、低代码的解决方案。

提示:若后续需更换模型版本或调整超时策略,只需在 OpenJiuWen 中编辑对应模型配置,无需修改业务代码,极大提升了运维灵活性。

参考文档:

OpenJiuwen项目地址:https://atomgit.com/openJiuwen?utm_source=csdn

OpenJiuwen官网:https://www.openjiuwen.com?utm_source=csdn