目录

[01 把"位置感"塞进策略](#01 把“位置感”塞进策略)

[02 技术亮点](#02 技术亮点)

[Metric-aware visual geometry,把"真实尺度"学进来](#Metric-aware visual geometry,把“真实尺度”学进来)

[几何记忆 + 局部点云,让避障更像"看懂空间"](#几何记忆 + 局部点云,让避障更像“看懂空间”)

[03 实验与表现](#03 实验与表现)

[04 总结](#04 总结)

定位无需独立前置,与导航融为一体

------重审端到端导航

把端到端导航模型部署落地时最致命的问题是什么?

往往不在避障,而在定位的悄然失效。

当你把相机装高了几厘米、俯仰角改了一点,或者底盘换成另一种运动特性------机器人就会出现一种典型的"迷失"症状:

该直走的时候轻微蛇形、遇到转角时犹豫、离障碍的安全距离忽大忽小。

这并非因为它"看不见",而是因为它缺乏不依赖外部模块的 "稳定尺度感 + 空间位置感"。

- 传统模块化靠 SLAM / 视觉里程计定位,误差层层传递;

- 现有端到端看似简洁,却暗戳戳依赖显式定位或精确标定。

因此,能不能直接把"空间位置感"直接融进导航策略里,让机器人不用强依赖SLAM,也能走得稳、躲得开、跨平台更好用?

该思路来自于这篇由清华大学联合上海AI Lab 提出的LoGoPlanner(是该团队之前工作NavDP的一个独立精简版,意在摆脱定位依赖,aka NavDP--)。

不仅解决了端到端的漂移顽疾,更实现了真正的跨平台泛化 ------ 从轮式到人形到四足、从办公室到工业区,轻松换平台。

01 把"位置感"塞进策略

与其把定位当作一个独立模块,不如让导航策略自己学会"我现在在哪、该往哪走",而且要学到真实尺度上的几何理解,也就是知道距离、尺度是真的能对上现实世界的。

这便是本项研究的核心思路,据此提出了 LoGoPlanner,名字可以拆开理解:

- **LoGo:**Localization Grounded,意思是策略的决策建立在"定位相关的隐式状态"上;

- **Planner:**它最终输出的是一条可执行的轨迹/动作序列,用来完成点目标导航。

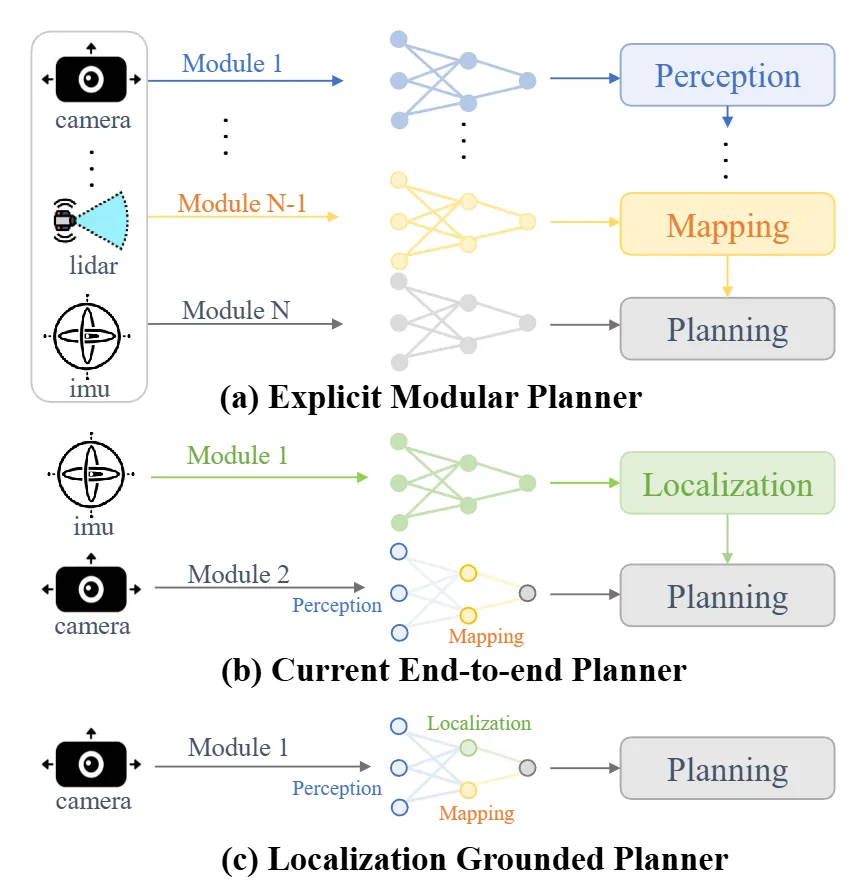

▲图1|LoGoPlanner 的整体定位。(a) 传统模块化导航通常会把任务拆成"定位、建图、规划、控制"等多个模块,优点是清晰,但缺点也明显:前面错一点,后面就层层放大。(b) 一些端到端方法虽然能从观测直接输出控制指令,但仍然需要显式定位模块(例如 SLAM/里程计)来兜底。(c) LoGoPlanner 的思路是把"定位相关的信息"变成策略内部的一部分:用隐式状态估计(不显式跑 SLAM,但学到位置相关表示)和尺度几何感知直接支撑端到端规划

整体框架里有三个关键:

- 长序列视觉状态估计:不只看一帧,而是"吃"进一段历史观测,从中提取"像定位一样"的状态表征,并把它锚定到真实尺度。

- **空间几何记忆:**利用历史信息重建周围的局部几何(比如点云/几何结构),让策略对障碍分布更敏感,避障更稳。

- **规划导向(Planning-oriented):**采用基于查询(query-based)的设计,把上述隐式状态和几何记忆作为条件输入,去生成轨迹或控制指令,从而减少"上游定位错一点,下游规划全崩"的连锁反应。

02 技术亮点

Metric-aware visual geometry,把"真实尺度"学进来

很多视觉导航sim-to-real之间的差距,常见原因之一就是"尺度感不靠谱":到底离障碍还有多少米、拐弯半径能不能过,策略心里没数,只能从视觉上"看个大概"。

**LoGoPlanner 强调 metric-aware(真实尺度感知):**它不仅提取视觉特征,还把视觉几何表征和真实尺度对齐,让后续规划更像在空间中"量尺子"而不是视觉上"凭感觉绕"。

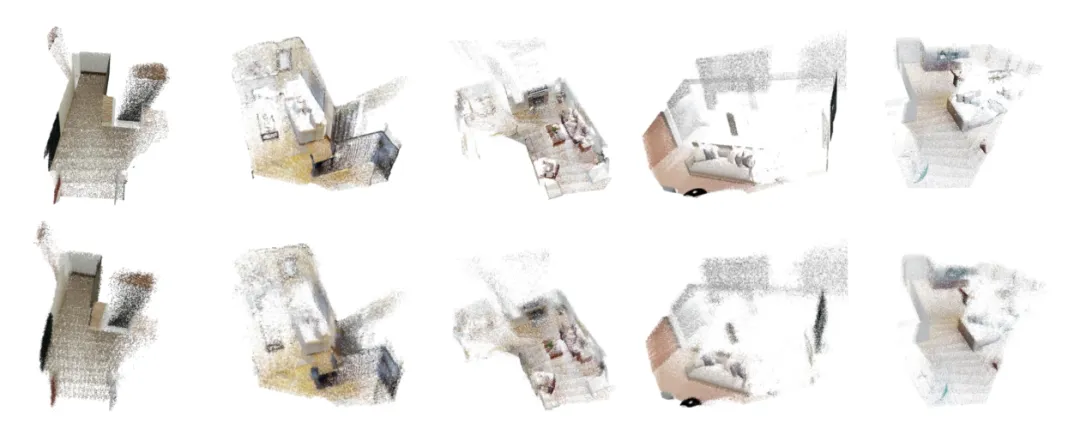

▲图2|Metric-aware visual geometry可视化:图中第一行是真值(ground truth)的场景点云,第二行是 LoGoPlanner 预测得到的场景点云。这里的点云是在真实尺度下预测的,并且以最后一帧的底盘位置作为坐标系原点,从图中可以看到机器人的感知能力非常强大,基本上能够高度还原真实场景的点云布局

用长时序观测做隐式状态估计,缓解漂移

只看单帧或短片段,容易让机器人"记不住自己刚刚怎么走过来的",尤其是走廊、重复纹理、转角这些地方,状态会漂。

LoGoPlanner 的做法是让骨干网络处理更长的观测序列,从历史里汇总出更稳定的状态表征。

**这里的关键词是 implicit state estimation(隐式状态估计):**不显式跑SLAM,但学到一种能支持决策的"位置相关表示",有了这种隐式的状态估计,机器人就可以更好的建模长程任务,减少误差的累积。

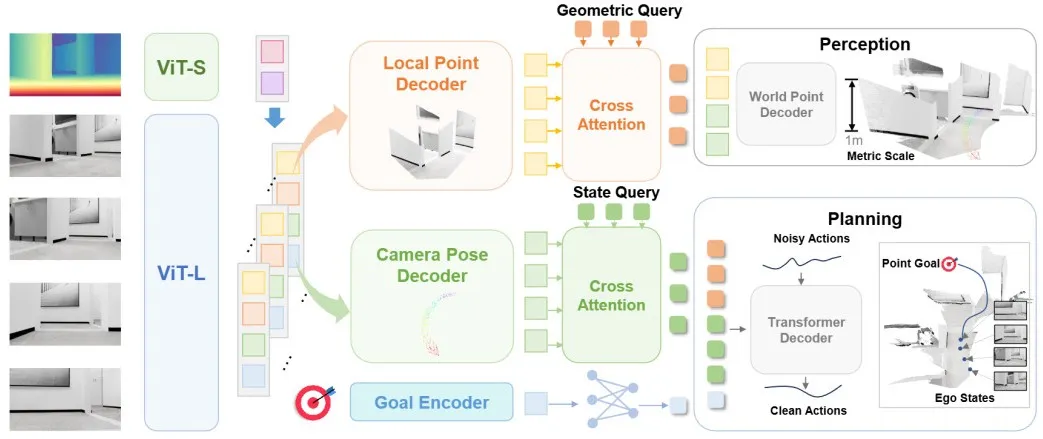

▲图3|方法结构总览。

LoGoPlanner 的骨架可以理解为三步:

- Step1:尺度先验注入:

在把图像切成小块(patch)并送入 ViT(Vision Transformer,视觉编码网络)之前,先把深度图编码后的"尺度相关先验信息"注入到这些图像块里;

同时微调一个视频几何模型,使其能够预测真实尺度下的几何信息。

- Step2:Query 方式做信息汇总:

把机器人自身状态(比如位姿、速度等)和环境几何(障碍分布等)在网络内部隐式聚合,而不是显式拼一堆手工模块。

- Step3:扩散策略输出轨迹:

最后接一个扩散策略头(逐步生成动作/轨迹的模型),生成可执行、尽量不撞的导航轨迹。

几何记忆 + 局部点云,让避障更像"看懂空间"

策略不是只看一张图去猜路在哪,而是持续累积对周围障碍的几何认识。

这种 geometry memory(几何记忆) 在非结构化环境里尤其关键:

因为障碍物的形状、分布、可通行间隙,决定了轨迹能不能走得安全、走得顺。

本文研究方法摆脱了雷达等多传感器的依赖,仅仅依赖相机的视频输入,对非结构化环境进行细粒度重建,提供了丰富的空间几何感知信息。

这种显式几何感知+隐式策略建模的布局可以取长补短,让机器人在复杂空间中更加穿梭自如。

03 实验与表现

实验围绕两条主线进行:

- 一条是在大规模仿真数据上训练与评测;

- 另一条是在真实机器人上跑三种平台(轮式移动机器人、四足机器人、人形机器人)、三类环境(办公室、家庭、工业)。

而且,研究在训练时做了多种随机化(比如机器人高度和相机俯仰角),目的就是逼着策略"别记死一种安装姿态"。

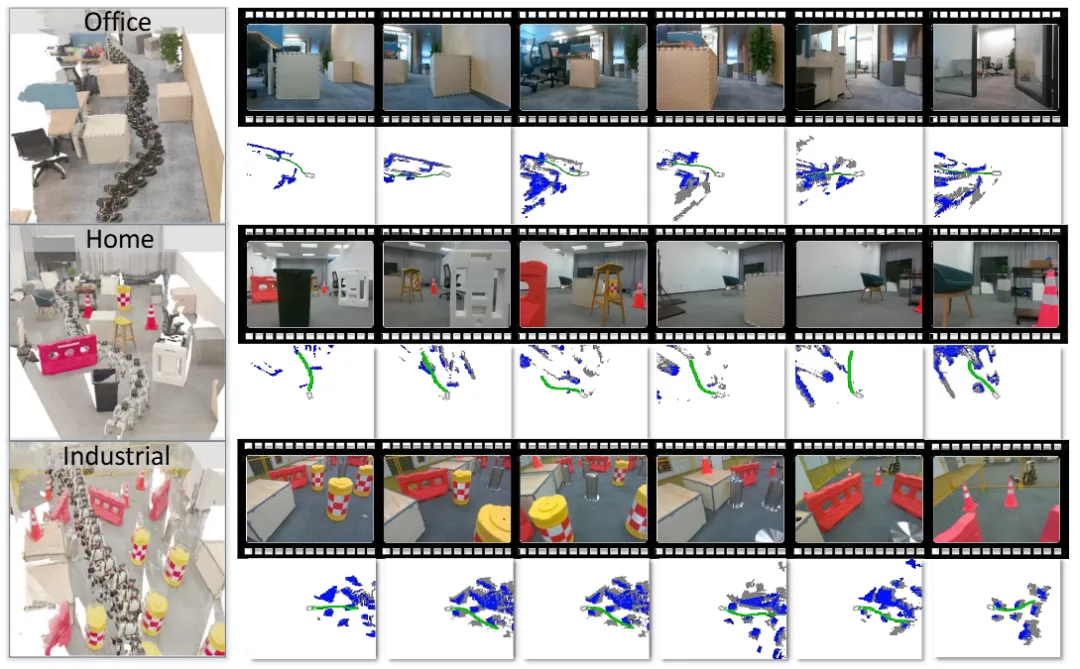

▲图4|真实机器人效果可视化:不同平台上规划轨迹长什么样?图中绿色曲线是 LoGoPlanner 规划出来的轨迹。蓝色点云表示当前帧观测到的障碍物,灰色点云表示上一帧的障碍物(可以理解为"历史几何信息")。可见在真实环境里、不同机器人平台上,LoGoPlanner 依然能输出连贯的可行轨迹

从结果趋势看,LoGoPlanner 的优势主要体现在两点:

- **跨平台更稳:**换平台、换安装角度时,性能下降没那么剧烈。

- **避障更可靠:**在室内家居与商业场景里,更能保持连续的轨迹质量,不容易出现犹豫或贴障走的情况。

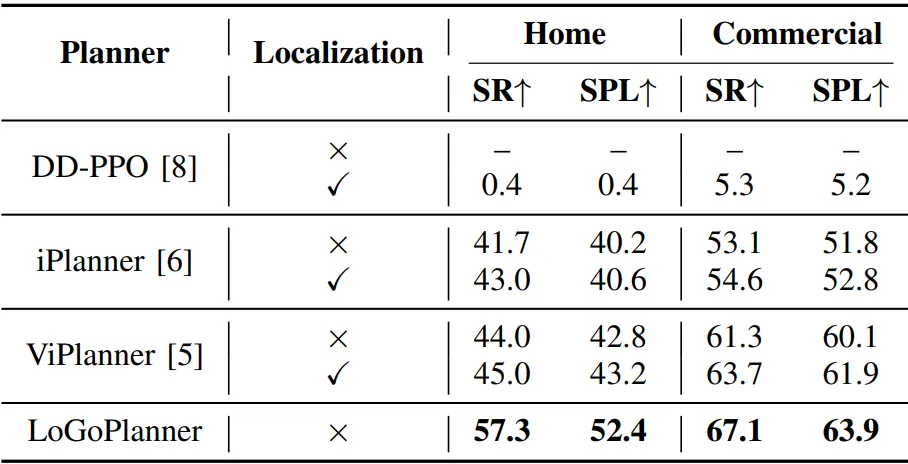

▲图5|多平台多场景真实环境试验结果。可以看到LOGOPlanner在不同的机器人平台都大幅度领先对比方法,并且这种领先能够跨越多场景,由此可见LoGoPlanner跨平台及跨场景部署的稳健性

与带有"真值定位"信息的先进对比方法,LoGoPlanner依旧实现了整体性能提升超过 27.3%。

这也证明了:定位信息不一定要以SLAM的形式出现,策略也可以自己学出可用的空间位置感,并把它用到规划里。

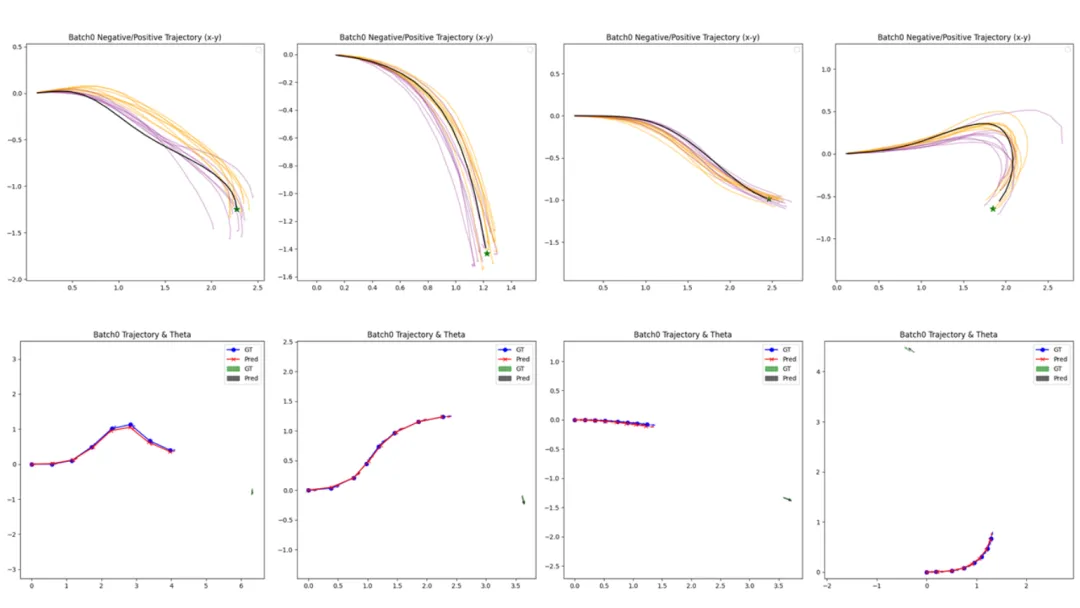

▲图6|真实环境结果可视化。上排:规划轨迹黑色轨迹是真值(ground truth),黄色和紫色是预测轨迹,绿色星标是目标点。用这排图主要看:预测轨迹是否能贴近真值趋势,能否顺利指向目标。下排:定位结果。蓝点是真值定位,红点是预测定位;绿色箭头是真值目标方向,灰色箭头是预测目标方向。用这排图主要看:策略内部学到的"空间位置感"是否能跟上真实运动,并把目标方向估计得足够稳

04 总结

从"换相机就漂移" 到 "跨平台稳行",LoGoPlanner 做的事情可以用一句话概括:把"空间位置感"从一个独立模块,变成导航策略内部的一部分。

当定位从一套独立系统转变为策略内生的"常识",机器人便得以摆脱对精密标定与复杂模块链的依赖,获得了一种更接近生物直觉的导航能力------

不再需要时刻回答"我在哪",却能稳健地决定"往哪走"。

这标志着具身智能导航正从 "伪端到端" 迈向 "真闭环"。但它并非完美:极端动态场景、超远距离导航的鲁棒性,以及边缘设备部署优化,仍是待解难题。

LoGoPlanner 打通了路径,当定位不再是独立前置任务、不再那么强依赖精细标定与显式定位模块、换平台时更省心时,也更有机会把端到端方法推到复杂真实环境里

Ref:

论文题目:LoGoPlanner: Localization Grounded Navigation Policy with Metric-aware Visual Geometry

论文作者:Jiaqi Peng, Wenzhe Cai, Yuqiang Yang, Tai Wang, Yuan Shen, Jiangmiao Pang