【论文阅读】RoboReward: General-Purpose Vision-Language Reward Models for Robotics

- [1 团队与发表时间](#1 团队与发表时间)

- [2 问题背景与核心思路](#2 问题背景与核心思路)

- [3 具体做法](#3 具体做法)

-

- [3.1 reward model设计](#3.1 reward model设计)

- [3.2 Loss设计](#3.2 Loss设计)

- [3.3 数据设计](#3.3 数据设计)

- [4 实验效果](#4 实验效果)

- [5 结论](#5 结论)

1 团队与发表时间

-

团队:由来自斯坦福大学(Stanford University)和加州大学伯克利分校(UC Berkeley)的研究人员共同完成,核心作者包括 Tony Lee、Andrew Wagenmaker、Percy Liang、Sergey Levine、Karl Pertsch 和 Chelsea Finn 。

- 注意:这里面有多位Physical Intelligence的联合创始人:Sergey Levine,Chelsea Finn,Karl Pertsch。这可能是Physical Intelligence (π) 团队的核心技术方向。

-

发表时间:该论文的 arXiv 版本更新于 2026 年 1 月 2 日 。

2 问题背景与核心思路

-

问题背景:设计良好的奖励信号对机器人强化学习(RL)至关重要。

- 人工设计reward:目前获取这些信号通常依赖于高成本的人工标注或脆弱的手写设计 。

- VLM学习的reward:

- 数据集难获取:虽然视觉语言模型(VLM)在自动奖励建模方面表现出潜力,但现有 VLM 在真实机器人任务中的精确度和可靠性尚不明确,且现有的机器人数据集(如 OXE)大多只有成功示例,缺乏训练奖励模型所需的失败案例 。

- 真值难获取:之前的GR-RL和pi*0.6均采用连续的reward,但是难以标注。比如85%和86%到底如何界定?

-

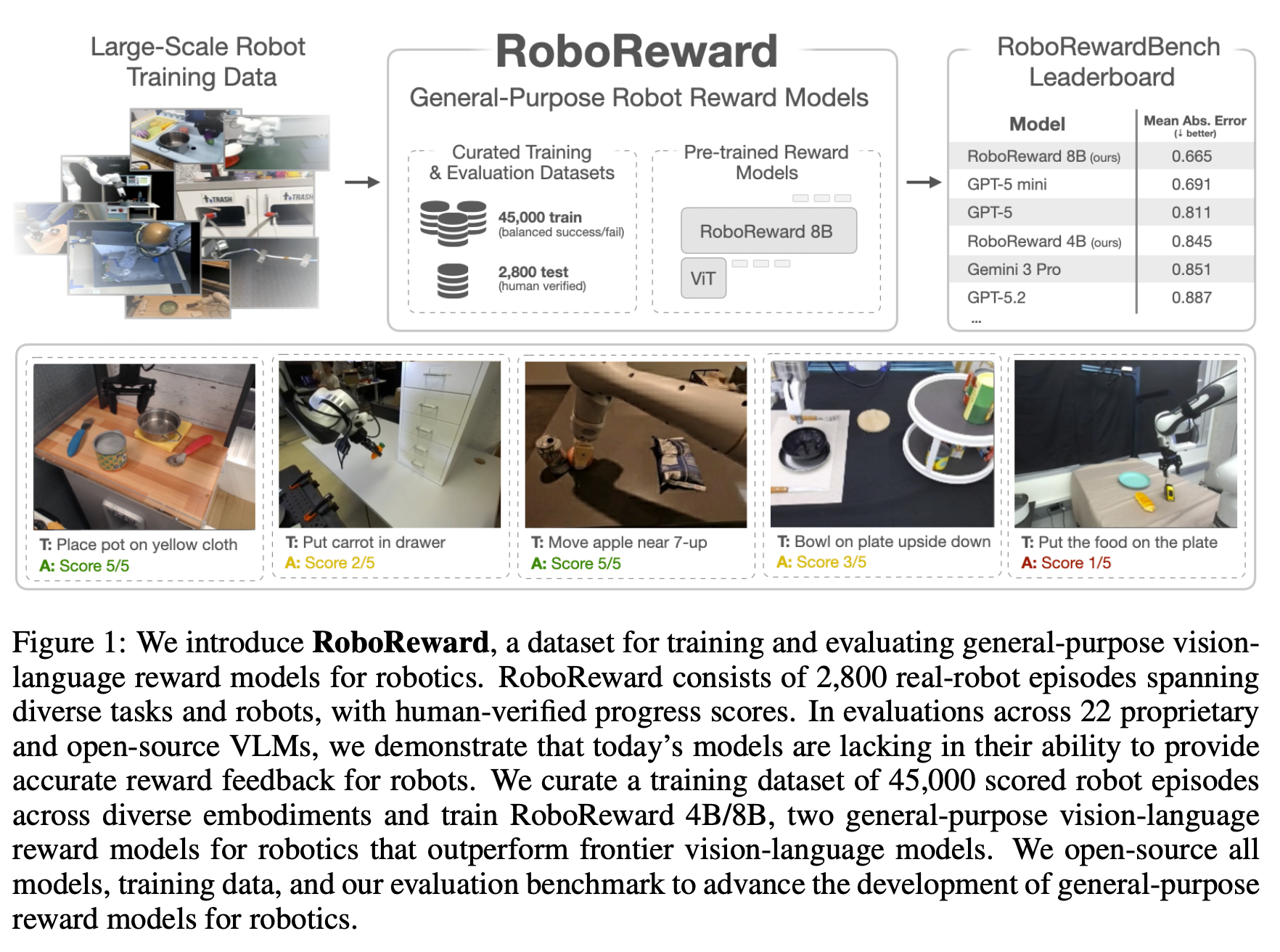

核心思路:引入 RoboReward,这是一个用于机器人奖励的大规模数据集和基准测试。其核心是通过一套负样本数据增强流水线(包括反事实重标记和时间裁剪),从现有的以成功案例为主的数据集中生成失败和"险些成功"的示例,从而训练出通用的 4B/8B 参数视觉语言奖励模型 。

3 具体做法

3.1 reward model设计

-

模型规模:训练了 40 亿(4B)和 80 亿(8B)参数的通用视觉语言奖励模型 。

-

输入输出:模型根据机器人执行任务的全集视频和自然语言指令,输出一个离散的进度评分(Progress Score),范围为 1 至 5 分 。

-

设计原则:选择离散进度评分而非二值成功信号,是因为实验证明进度评分能引导 RL 更快收敛,且人工标注的一致性更高 。

3.2 Loss设计

目标函数:模型通过微调(Fine-tuning)来预测 ground-truth 进度标签。

核心指标:主要使用**平均绝对误差(MAE)**作为评估标准,旨在最小化预测分值与真实进度标签(1-5 级)之间的距离 。

3.3 数据设计

- 数据来源:整合了 Open X-Embodiment (OXE) 的约 100 万个真实机器人演示视频和 RoboArena 的多样化策略评估数据 。

-

数据增强(生成负样本):

-

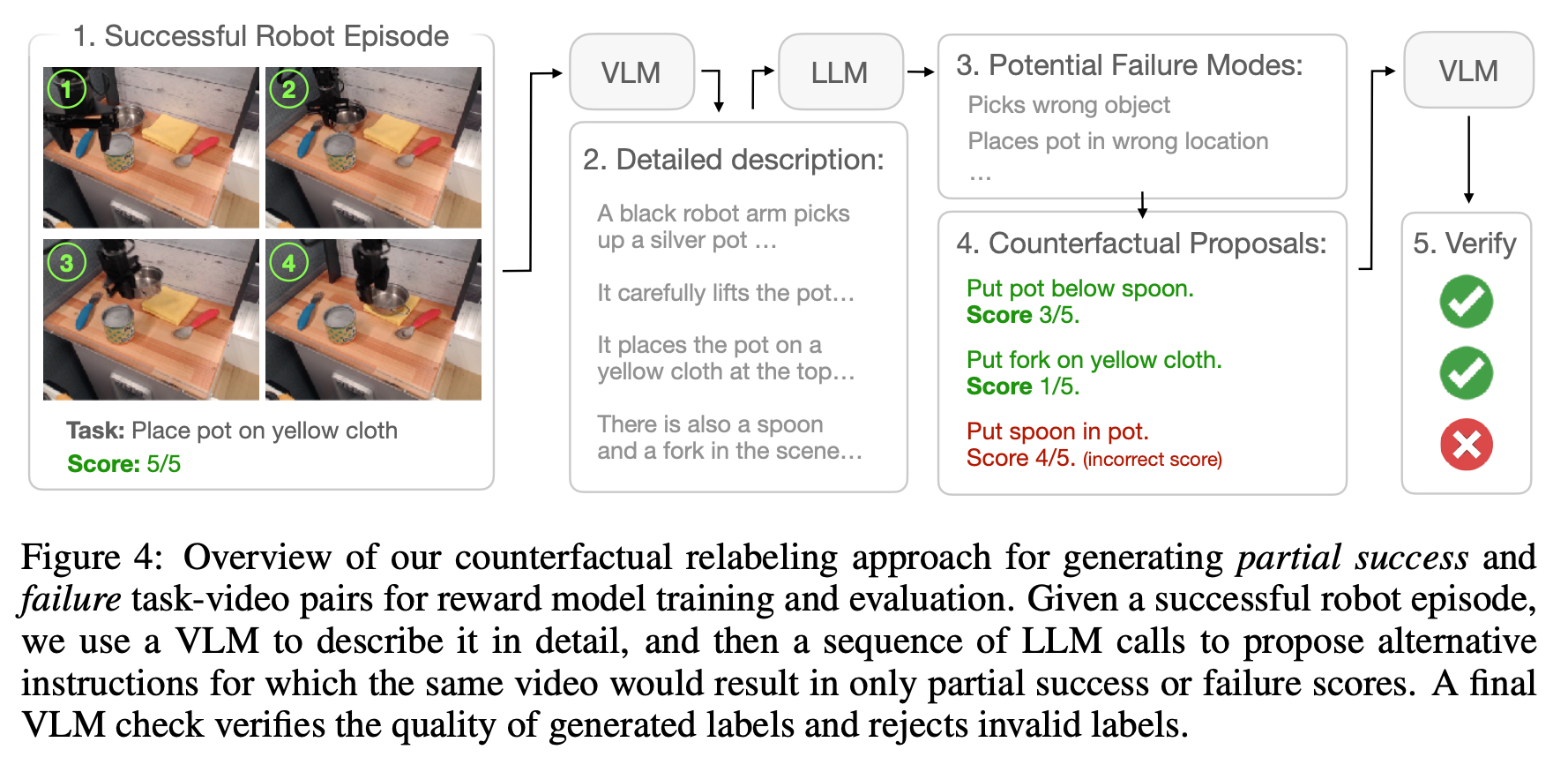

反事实重标记(Counterfactual Relabeling):保持视频内容不变,但通过 LLM 生成与视频动作不符或仅部分符合的错误指令,并分配低分(例如:视频是"捡起碗",指令被改为"捡起叉子") 。

-

时间裁剪(Temporal Clipping):将成功的视频在早期帧截断,以此模拟"部分完成"的状态 。

-

-

规模:训练集包含 45,000 个带评分的机器人轨迹;评估基准(RoboRewardBench)包含 2,800 多个涵盖 14 种机器身形和多样任务的剧集 。

4 实验效果

-

基准测试:在 RoboRewardBench 的评估中,RoboReward 4B 和 8B 模型的表现超过了许多规模更大的 VLM(包括某些专有模型如 GPT-5 变体) 。

-

真实机器人 RL:采用DSRL方法,在真实机器人强化学习任务中,使用 8B 模型作为奖励函数,其策略学习效果显著优于 Gemini Robotics-ER 1.5,并极大地缩小了与人类提供奖励之间的性能差距 。

-

消融实验:结果表明,反事实重标记和时间裁剪对于提高模型在多样场景下的鲁棒性和覆盖范围至关重要 。

5 结论

RoboReward 展示了利用 VLM 构建通用机器人奖励模型的可行性,并提供了目前最全面的数据集和评价基准 。

实验证明,离散进度奖励比二值成功奖励更适合引导强化学习训练 。

通过负样本增强技术,即便使用较小参数量的模型,也能在机器人奖励分配任务上达到甚至超过顶尖的大型专有 VLM 。