传统神经视频编解码 (NVC) 完全指南:从零读懂 AI 视频压缩的基石

📚 专为深度学习初学者打造的 NVC 深度教程

🎯 目标 :用最通俗的语言,讲清楚"传统神经视频编解码器"(Traditional Neural Video Codecs)------这个连接计算机视觉与经典信号处理的交叉领域。

🎧 核心问题:NVC 到底是什么?为什么它长得那么像 H.264?它里面的"光流"和"残差"到底在做什么?为什么虽然它压缩率极高,却被诟病"太慢"?

📋 目录

- 1. 为什么要学习 NVC?

- 2. NVC 是什么?

- 3. 一个生活中的类比:临摹画师

- 4. NVC 的核心架构(经典的 DVC 范式)

- 5. 关键技术拆解:光流与残差

- 6. 为什么叫"传统"NVC?(显式运动建模)

- 7. NVC 在 AI 领域的地位

- 8. 代码视角的 NVC 工作流

- 9. NVC vs 传统标准 (H.264/H.265)

- 10. 常见误区与问答

1. 为什么要学习 NVC?

你可能会问:"现有的 H.264、H.265 用得好好的,为什么要搞 AI 视频压缩?"

但事实是:

🚀 视频占据了互联网 80% 以上的流量,而传统算法已接近天花板。

几乎所有科技巨头都在押注 NVC:

| 领域 | NVC 扮演的角色 |

|---|---|

| 流媒体 (Netflix/YouTube) | 每一比特的节省 = 数亿美元的带宽成本降低 |

| 实时通信 (Zoom/Teams) | 在弱网环境下提供更清晰的画质 |

| 无人机/自动驾驶 | 在带宽受限的信道上传输高清语义信息 |

| 生成式 AI (Sora/Runway) | 视频生成的底层往往依赖 NVC 的压缩表示 (Latent Space) |

换句话说:

👉 如果你懂 NVC,你就掌握了未来视频传输与生成的"压缩密码"。

2. NVC 是什么?

一句话:

📌 NVC 就是用深度神经网络(CNN/Transformer)替换掉传统视频编码标准中手工设计的模块,并进行端到端优化的系统。

它的核心数学目标是最小化 率失真代价 (Rate-Distortion Cost):

- R (Rate):码率,即压缩后文件的大小(越小越好)。

- D (Distortion):失真,即压缩后画面变糊的程度(越小越好)。

- λ \lambda λ:平衡系数,决定你是想要更清晰(大 )还是更小文件(小 )。

传统编码器(如 H.265)是人类专家手工调参设计的;而 NVC 是通过大数据"训练"出来的。

3. 一个生活中的类比:临摹画师

为了理解 传统 NVC 的工作原理,我们可以把它想象成一个 "极简主义的连环画师"。

📌 场景:画师传输动画片

假设你要把一部动画片的每一帧通过电话描述给远方的朋友。

笨办法(MJPEG):

每一张画都从头开始描述:"这一帧,左上角是个太阳,中间是只猫......"

👉 太浪费了!

传统 NVC 的办法(残差 + 运动):

画师看着第二帧,发现猫只是向右走了一步,背景没变。他对朋友说:

- 运动(Motion): "把上一张画里的猫,向右平移 2 厘米。"

- 残差(Residual): "平移后,猫的尾巴形状有点不一样,请把尾巴这里涂黑一点(修补误差)。"

这就是 NVC 的精髓:

只传输 "怎么动" (光流) 和 "哪里不一样" (残差)。

4. NVC 的核心架构(经典的 DVC 范式)

"传统" NVC(以 2019 年经典的 DVC 模型为代表)几乎完美复刻了传统视频编码的流程。

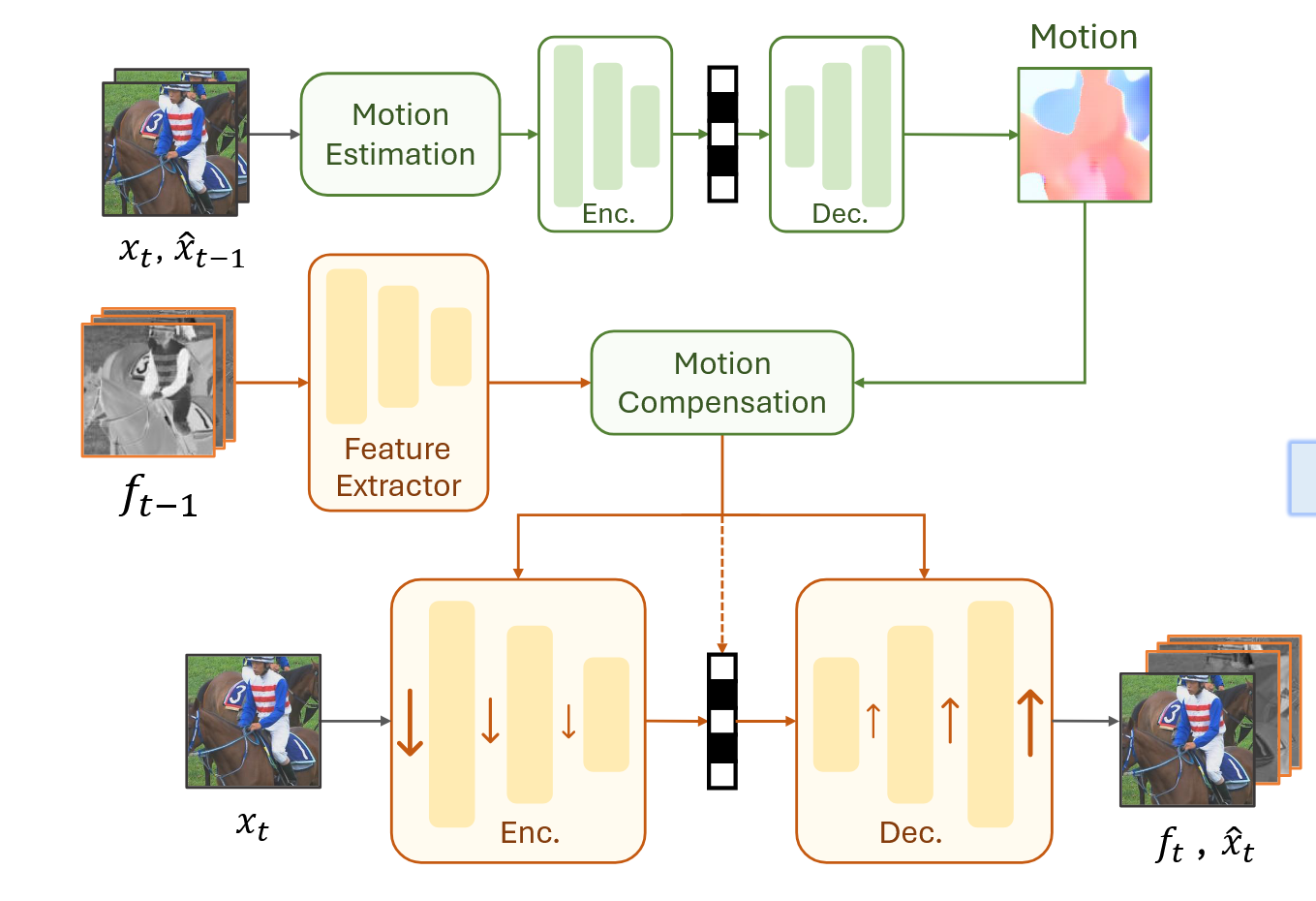

一个典型的 NVC 包含四个核心神经网络模块:

- 运动估计网络 (Motion Estimation Net):

- 👀 作用:看当前帧 和上一帧 ,算出一个光流图 (Optical Flow)。

- 🧠 本质:预测像素去哪了。

- 运动压缩网络 (Motion Encoder/Decoder):

- 📦 作用:光流图本身也很大,需要用一个类似 VAE 的网络把它压缩成二进制比特流。

- 运动补偿 (Motion Compensation):

- 🎨 作用:根据解压后的光流,把上一帧"扭曲 (Warp)"成当前帧的预测版 。

- 🔧 这是一个确定性的数学操作,通常不可学习,但可微分。

- 残差压缩网络 (Residual Encoder/Decoder):

- ✨ 作用:计算真实帧和预测帧的差值(),并用另一个 VAE 网络压缩这个差值。

5. 关键技术拆解:光流与残差

如果不理解这两个概念,就不可能理解传统 NVC。

🎯 概念 1:光流 (Optical Flow) ------ "显式运动"

光流是一个二维向量场。简单说,它是一张和图片一样大的图,但每个像素点存的不是颜色,而是 (dx, dy) ------ 即该像素下一帧会移动到哪里。

- 在 NVC 中: 神经网络(如 PWC-Net 或 SpyNet)负责"猜"出这个光流。

- 特点: 它是"显式"的,你可以把它可视化出来,看到物体的轮廓和运动方向。

🎯 概念 2:残差 (Residual) ------ "查漏补缺"

光流预测永远是不完美的:

- 物体被遮挡了怎么办?

- 光照突然变了怎么办?

- 出现了新物体怎么办?

这时候,光靠"扭曲"上一帧是不够的。残差就是:

NVC 的后半部分工作,就是把这个"残差图"当成一张普通图片,用图像压缩网络(如 VAE)把它压扁传过去。

6. 为什么叫"传统"NVC?(显式运动建模)

你可能注意到我们一直在强调 "显式运动"。

这就是 传统 NVC 与 新一代 NVC (如 DCVC-RT) 的最大区别:

-

传统 NVC (Paradigm of Motion-based NVCs):

-

坚信 "必须把光流算出来"。

-

结构:光流估计 -> 光流压缩 -> 运动补偿 -> 残差压缩 。

缺点: 模块极其臃肿!算光流的网络通常非常深(如 123 层),导致推理速度很慢,且中间产生的特征图很大 。

- 新一代 NVC (Implicit Modeling):

- 抛弃光流! 直接把上一帧特征拼到当前帧,让网络自己去"领悟"运动。

- 这就是为什么 DCVC-RT 能做到实时的原因 。

7. NVC 在 AI 领域的地位

NVC 是深度学习中非常特殊的"混合体":

- 计算机视觉 (CV):它需要极强的光流估计能力(类似自动驾驶)。

- 生成模型 (Generative AI):它的压缩模块本质上是 VAE(变分自编码器),现在也开始结合 Diffusion。

- 信息论:它必须处理熵编码(Entropy Coding),估算概率分布。

8. 代码视角的 NVC 工作流

用 PyTorch 伪代码来感受一下传统 NVC 的一次前向传播:

python

class TraditionalNVC(nn.Module):

def forward(self, x_curr, x_ref):

# 1. 运动估计 (算光流)

flow = self.optic_flow_net(x_curr, x_ref)

# 2. 压缩光流 (量化 + 编码)

flow_hat, bits_flow = self.motion_autoencoder(flow)

# 3. 运动补偿 (Warping)

# 根据光流,把参考帧 x_ref 扭曲成预测帧 x_pred

x_pred = flow_warp(x_ref, flow_hat)

# 4. 计算残差

residual = x_curr - x_pred

# 5. 压缩残差

res_hat, bits_res = self.residual_autoencoder(residual)

# 6. 重建当前帧 (用于下一帧参考)

x_recon = x_pred + res_hat

return x_recon, bits_flow + bits_res一句话:

👉 算运动 -> 压运动 -> 扭曲 -> 算残差 -> 压残差 -> 重建

9. NVC vs 传统标准 (H.264/H.265)

| 特性 | 传统标准 (H.264/HEVC/VVC) | 传统 NVC (DVC/DCVC-FM) |

|---|---|---|

| 设计理念 | 手工设计的模块堆叠(积木) | 端到端训练的神经网络(黑盒) |

| 运动建模 | 块匹配 (Block Matching) | 光流估计 (Optical Flow) |

| 压缩率 | 极高(几十年优化的结晶) | 已超越 H.265,甚至 VVC |

| 运行速度 | 快(有专用硬件编解码器) | 慢(依赖 GPU,计算量大) |

| 伪影类型 | 马赛克、块效应 (Blockiness) | 模糊、涂抹感 (Blurriness) |

🎉祝你天天开心,我将更新更多有意思的内容,欢迎关注!

最后更新:2026年1月

作者:Echo