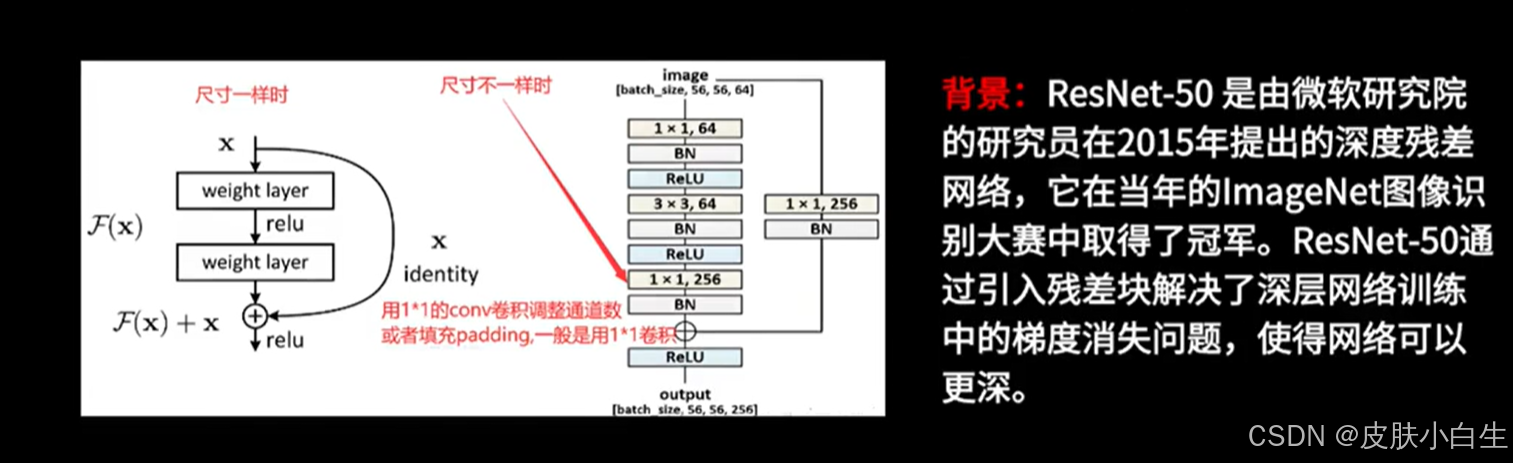

2015年,何凯明等人提出了一种新的神经网络结构Residual Networks(简称ResNet),在当年的ImageNet比赛中,在classification、detection、localization以及COCO的detection和segmentation任务上均获得第一名。同时,凯明大神发表的ResNet文章斩获了CVPR2016年的best paper,真tql。

论文链接:Deep Residual Learning for Image Recognition

代码链接:https://github.com/KaimingHe/deep-residual-networks

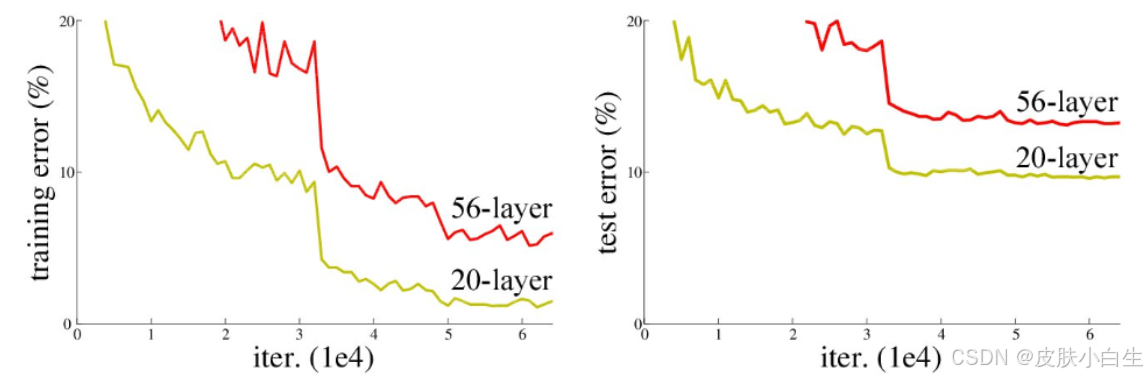

我们知道,网络的深度直接决定了网络的性能,往往更深的网络具有更强的表达能力。近年来随着GPU算力的大幅度提高,使得拥有大量参数的黑盒模型(深度学习)快速发展,从最初的LeNet->AlexNet->Vgg16...,似乎网络越来越深,精度也越来越好。但一些实验数据显示:当网络进一步加深,层数达到20层甚至100层时,更深的网络却表现出更高的误差,如下图所示: