目录

[01 从"专属模型"到"通用预测"](#01 从“专属模型”到“通用预测”)

[02 500小时数据+0.1秒推理](#02 500小时数据+0.1秒推理)

[03 核心设计](#03 核心设计)

[骨干网络:选对架构,才能 scaling](#骨干网络:选对架构,才能 scaling)

[04 实验结果](#04 实验结果)

[05 离"真"通用机器人还有多远?](#05 离“真”通用机器人还有多远?)

最大规模!机器人操作场景专用 3D 世界模型训练数据集

------短期炫技 vs 长期价值

当机器人面对杂乱的真实场景,仅靠一张RGB-D图像,能否预判物体运动、完成推、抓、工具使用等复杂操作?

复杂全场景点云中 95% 以上都是静态点,传统 L2 损失容易让模型 "学废",难以聚焦物体运动的关键信息;且多数模型依赖场景专属建模。

李飞飞团队2026开年首篇工作PointWorld给出了肯定答案------

一个预训练3D世界模型,将环境状态与机器人动作,在同一3D物理空间中,全部表征为"三维点流"(3D Point Flows)。

这意味着,模型不再学习抽象的"关节角度指令",而是直接学习机器人动作将如何导致三维场景中每一个几何点发生真实的物理位移。

01 从"专属模型"到"通用预测"

以往机器人要完成不同任务,要么依赖物理引擎(sim-to-real gap难跨越),要么靠像素级视频模型(物理一致性差)......

PointWorld跳出局限:

用3D点流(3D Point Flows)统一"环境状态"和"机器人动作"------

环境是静态点云转化的场景点流,机器人动作也不是关节角度这类专属指令,而是基于自身几何的3D点流。

这种设计直接让模型"看懂物理交互":

不管是单臂Franka、双手机器人还是移动平台

------只要能转化为3D点流,就能用同一个模型学习,完美解决"跨机器人形态"的迁移难题!

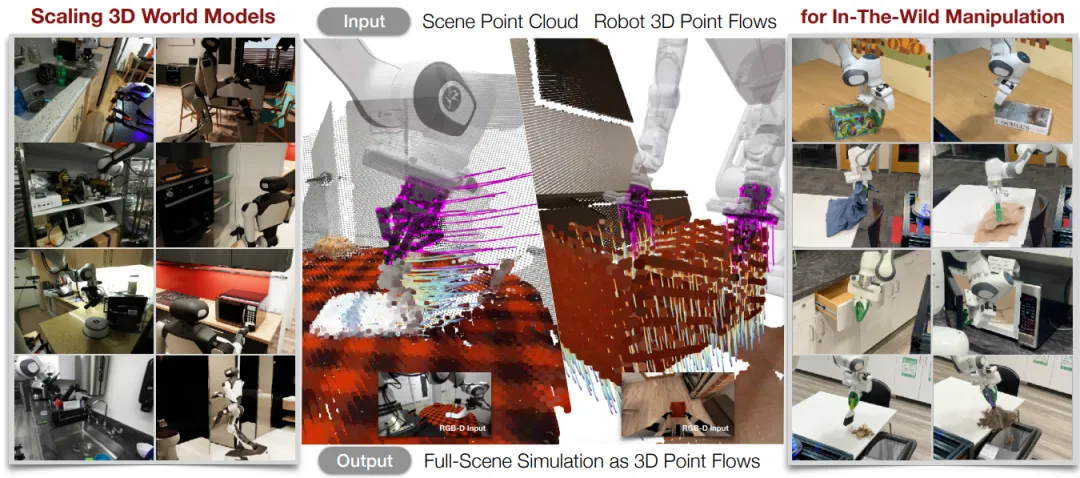

▲PointWorld:跨场景的 3D 世界模型:单模型实现野外机器人多任务操作。

02 500小时数据+0.1秒推理

要实现通用预测,数据和效率缺一不可:

-

超大规模数据集: 团队整合真实(DROID)+仿真(BEHAVIOR-1K)数据,涵盖单臂、双手、全身操作,总计200万条轨迹、500小时交互数据

------这是目前最大的3D动力学建模数据集,直接开源(具体开源信息详见项目主页)

-

**实时推理速度:**0.1秒就能完成一次全场景3D点流预测,能无缝接入模型预测控制(MPC)框架,让机器人边预测边规划,不耽误实操。

▲对3D世界建模进行监督,以实现对物理交互的精准控制,这一过程基于3D机器人点流和局部可观测RGB-D数据。

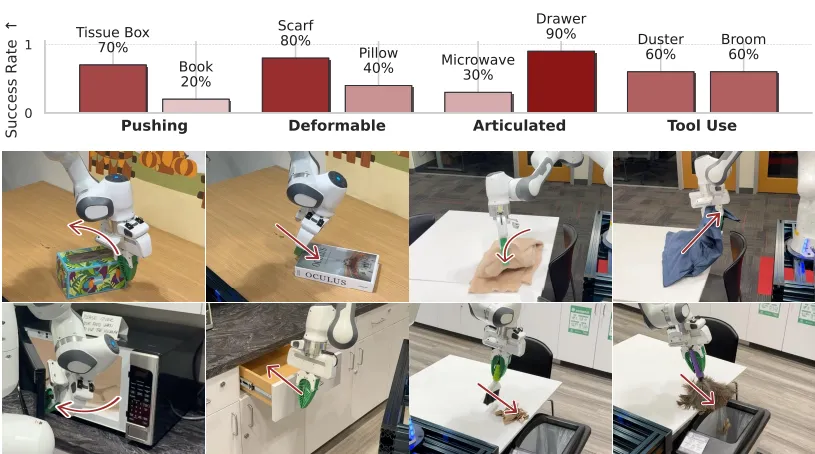

一个预训练模型,给它一张野外RGB-D图像,无需任何微调或演示,就能让Franka机器人完成------

- 刚体推(纸巾盒、书本)

- 变形物体操作(叠围巾、放枕头)

- 关节物体控制(开微波炉、关抽屉)

- 工具使用(用扫帚、抹布清扫)

成功率最高达90%(抽屉操作),直接刷新3D世界模型的实操上限!

03 核心设计

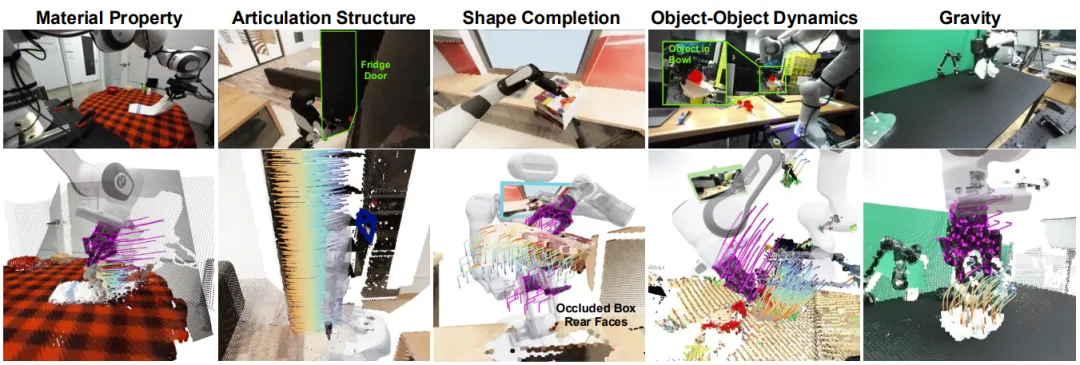

能实现这么强的泛化,关键在三个"反常识"设计:

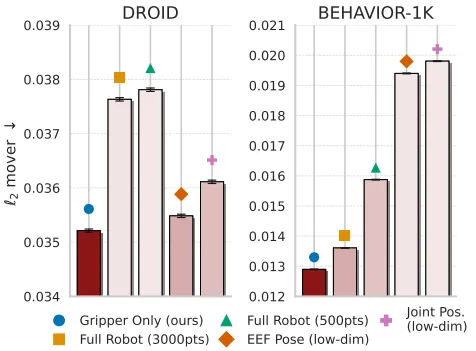

动作表示:不用关节,用几何

传统机器人动作靠关节角度或末端位姿,换个机器人就失效。PointWorld直接用机器人3D表面点流:根据URDF模型(机器人几何描述),通过正运动学生成 gripper(夹具)的点轨迹------不管是平行夹爪还是多指手,只要几何已知,动作就能统一表示,从根源解决"形态依赖"。

▲PointWorld 模型的架构流程图。

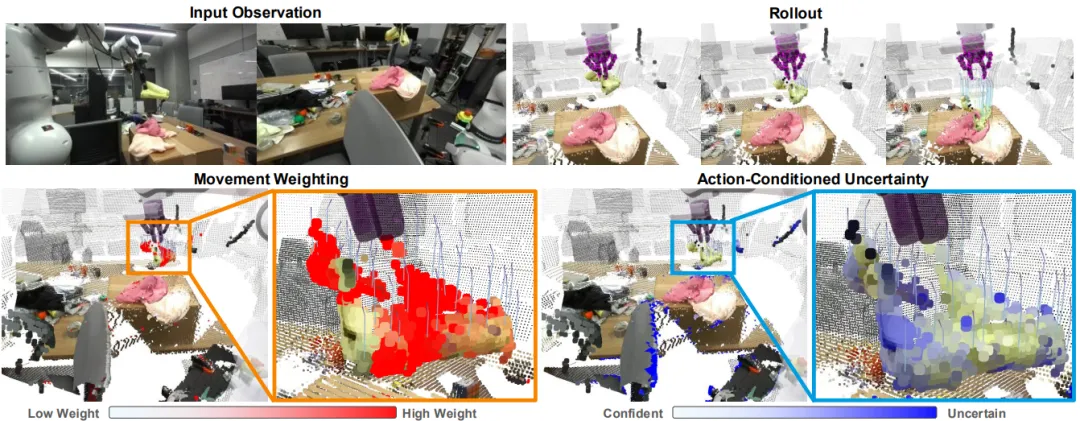

训练目标:不盯静态点,只抓"运动关键"

全场景点云中,95%以上是静态点,传统L2损失会让模型"学废"。

PointWorld加了运动加权损失:

用sigmoid函数给运动点(是真实位移)更高权重,再结合Huber损失和不确定性正则,让模型聚焦于"机器人接触引发的物体运动",训练效率直接拉满。

▲运动加权和不确定性正则化的作用。

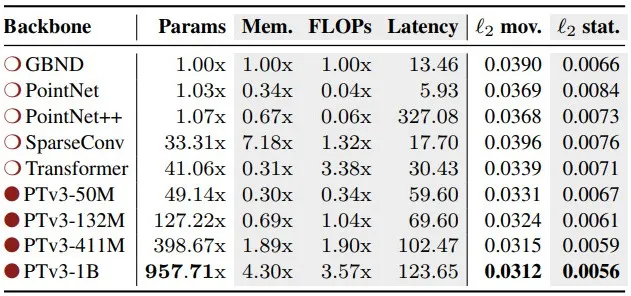

骨干网络:选对架构,才能 scaling

对比GraphNet、PointNet等架构后,研究敲定PointTransformerV3(PTv3)------

参数能从50M scale到1B,同时保持内存和速度优势。

1B参数模型的推理 latency仅0.12秒,比传统Graph模型精度高20%,还能处理部分遮挡场景(比如抓箱子时看不见的接触面)。

Backbone比较

04 实验结果

零样本迁移

单模型无需微调,就能让Franka机器人完成刚体推、变形物体操作(叠围巾)、关节物体控制(开微波炉)、工具使用(用扫帚清扫)等任务,成功率最高达90%。

▲PointWorld 在真实场景中的零样本操作------多任务成功率与实操演示。

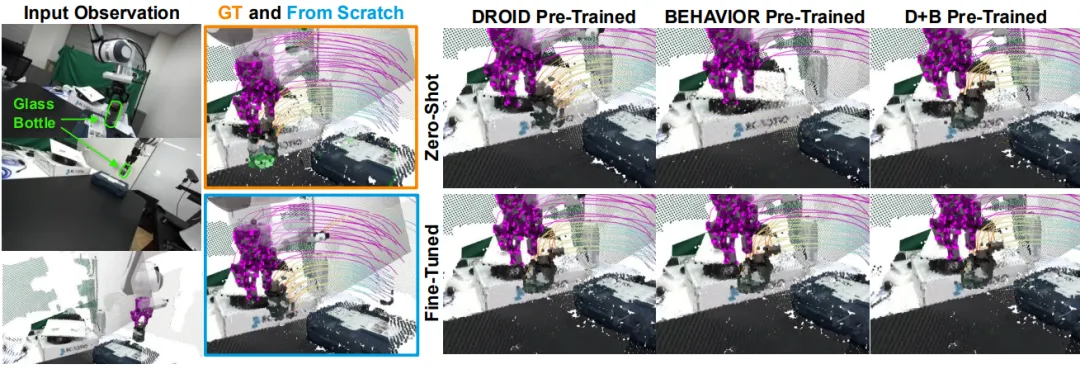

▲PointWorld 在真实场景的泛化能力------不同预训练数据下的零样本与微调表现。

跨域泛化

在真实数据(DROID)和仿真数据(BEHAVIOR-1K)间迁移时,仅需20倍 fewer 微调步骤,就能超越场景专属模型。

▲动作表示方式对比 ------ 不同表示下 DROID 与 BEHAVIOR-1K 的性能表现。

数据规模

构建了目前最大的3D动力学建模数据集:

包含200万 条轨迹、500小时交互数据,涵盖单臂、双手、全身操作,并且全面开源。

05 离"真"通用机器人还有多远?

PointWorld虽强,但仍有现实挑战:

- 目前假设初始场景静态,无法处理动态环境(比如突然闯入的物体);

- 精细物体(笔、电线)标注易出错,可能导致模型混淆机器人与场景点;

- 未融入显式物理先验(如牛顿力学),极端场景下预测可能偏离常识。

但不可否认,以往要针对每个场景训模型,现在一个预训练模型就能搞定多任务;以往依赖大量机器人数据,现在靠3D点流统一表示,跨形态迁移不再是难题。

++一句话总结++

PointWorld的价值,不止是"让机器人多会几项技能",更是提供了一套"3D世界模型 scaling 方法论":

用统一的3D点流表示打破形态壁垒,用大规模数据和高效架构撑起泛化能力。

Ref:

论文题目:PointWorld: Scaling 3D World Models for In-The-Wild Robotic Manipulation