大模型的训练与推理成本主要源于海量参数带来的算力消耗、存储开销和资源利用率低下等问题。要实现成本的大幅降低,需从模型本身、计算架构、训练流程、部署管理等多维度协同优化,在保证模型性能不显著下降的前提下,最大化资源利用效率。以下是经过产业实践验证的核心策略:

一、模型自身优化:从根源减少资源需求

模型是成本消耗的核心载体,通过轻量化设计和冗余压缩,可直接降低训练与推理过程中的算力、存储需求,是成本优化的基础环节。

1. 低比特量化技术:以精度换效率的高效路径

量化通过降低模型参数和激活值的数值精度,减少存储占用和计算开销,当前已实现"低精度无显著性能损失"的突破。传统模型多采用32位浮点数(FP32)存储参数,通过量化可将其转换为16位(FP16)、8位(INT8)甚至2位(INT2)的低精度格式,其中向量后训练量化(VPTQ)技术可在2比特精度下仍保持95%以上的准确率。实践表明,量化可实现2-8倍的存储压缩,减少75%的内存需求,同时降低推理时的内存带宽消耗,使LLaMA-2、Mistral-7B等模型的推理吞吐量提升1.6-1.8倍,部署硬件门槛从A100 80GB降至RTX4090 24GB,月均成本从万美元级降至2000美元以下。

2. 智能剪枝与稀疏化:移除冗余计算单元

大模型中存在大量冗余权重和神经元,剪枝技术通过移除这些无效组件,可显著减少计算量和存储需求。剪枝分为结构化剪枝(移除整个神经元或卷积核)和非结构化剪枝(移除单个冗余权重),其中MaskLLM等可学习的半结构化稀疏化技术,通过建立N:M模式的稀疏性,能精准减少推理时的计算开销,实现2-10倍的压缩比。此外,多头潜在注意力机制(MLA)通过将键值向量压缩至低秩空间,可将推理时KV缓存的显存需求降至传统机制的4%-13%,大幅提升长上下文处理的效率并降低成本。

3. 高效模型架构设计:提升计算性价比

通过架构创新减少无效计算,是降低成本的核心方向。混合专家模型(MoE)通过门控机制动态选择激活的专家网络,避免全参数参与计算,如DeepSeek-V3模型在推理过程中仅需激活5.5%的参数(37B/671B)即可达到SOTA效果,显著降低计算成本。同时,参数共享、低秩分解等技术也在不损失性能的前提下,将模型参数量压缩2-5倍,进一步减少训练和推理的资源消耗。

4. 知识蒸馏:小模型继承大模型能力

知识蒸馏通过将大模型(教师模型)的知识迁移到小模型(学生模型),让小模型在保持大模型核心能力的同时,大幅降低参数量和计算开销。这种方式可实现10-100倍的压缩比,例如DeepSeek R1通过蒸馏技术,性能与OpenAI o1持平,但成本仅为后者的三十分之一。蒸馏过程中,通过监督策略训练(SFT)、奖励模型训练(RM)和强化学习优化的三阶段流程,可在小规模高质量数据集上完成训练,进一步降低数据和算力成本。

二、计算架构优化:提升资源利用效率

合理的计算架构设计可解决资源争夺、负载不均等问题,最大化硬件利用率,从系统层面降低成本。

1. 分布式训练架构:突破单机资源限制

通过数据并行、模型并行和流水线并行的组合策略,将训练任务分布到多个计算节点,避免单机硬件瓶颈,同时缩短训练时间。数据并行将数据集分割为多个批次,由不同节点并行处理并同步参数;模型并行将超大模型的不同部分分配到不同节点,解决单卡显存不足问题;流水线并行则将训练流程拆分为多个阶段,实现节点间的高效协同。分布式训练可充分利用集群资源,将700亿参数模型的训练周期从数周缩短至数天,大幅降低算力租赁成本。

2. PD分离式推理架构:针对性匹配资源需求

大模型推理的预填充(Prefill)阶段为计算密集型,解码(Decode)阶段为存储密集型,传统架构中两阶段共享节点资源,导致资源争夺和利用率低下。预填充-解码(PD)分离架构将两阶段分开部署,根据各自特性匹配最优硬件:预填充阶段选用高算力GPU,解码阶段选用高显存硬件,可成倍优化系统性能与成本。例如,Mooncake开源项目通过PD分离架构构建调度集群,实现有效吞吐平均提升75%,特定场景提升5.25倍,并承接了kimi线上80%的流量;DeepSeek在PD分离基础上增加高负载专家分发策略,进一步优化资源利用。

3. 精细化调度策略:应对场景差异化需求

通过智能化资源调度和任务调度,提升系统在多样化场景下的适配性和利用率。分布式调度平台(如XXL-JOB、SchedulerX)通过实时任务监控、负载动态均衡、弹性扩缩容等技术,可应对低时延(智能客服)、高吞吐(视频生成)、长上下文(RAG)等不同场景的需求。例如,阿里云Llumnix全局调度器支持运行时请求重调度,在多个实例间动态分配请求,避免部分节点过载、部分节点闲置的情况,提升整体资源利用率达30%以上。

三、训练与推理策略调整:减少无效资源消耗

通过优化训练数据、推理流程和任务管理,减少不必要的算力和数据开销,进一步降低成本。

1. 数据高效利用:提升数据性价比

训练数据的质量而非数量,直接影响模型性能和训练效率。通过数据清洗、去重和筛选,保留高质量、高相关性的数据,可在减少训练数据量的同时,提升训练效果。此外,检索增强生成(RAG)架构通过向量检索技术,仅加载与当前任务最相关的上下文片段,而非整个数据集,可减少70%的token消耗和50%以上的推理延迟,大幅降低推理阶段的算力和内存成本。

2. 参数高效微调:避免全量训练开销

针对特定场景的适配需求,无需对大模型进行全量训练,通过LoRA、Adapter等参数高效微调技术,仅训练模型的少量适配器参数,即可实现场景适配。这种方式可将微调的参数量减少至原模型的1%-5%,算力消耗降低一个数量级,同时缩短微调周期,降低能源和硬件成本。

3. 任务批处理与请求合并:提升硬件吞吐量

推理阶段,将多个同类请求合并为一个批次处理,可充分利用GPU的并行计算能力,提升单位时间内的处理量(吞吐量)。对于视频生成、数据集生成等批量输出场景,批处理可将GPU利用率从30%提升至80%以上,显著降低单位请求的算力成本。同时,通过请求队列管理,避免峰值流量导致的资源过载,平稳利用算力资源。

四、工程化部署与管理:全生命周期成本管控

从部署工具选择、硬件选型到成本监控,通过全生命周期的工程化管理,实现成本的持续优化。

1. 选用高效推理引擎:降低部署门槛

主流推理引擎已从多点爆发逐渐收敛到性能卓越、适配性广的方案,选用成熟引擎可大幅降低优化成本。例如,vLLM支持多硬件、推理优化特性丰富,可提升推理吞吐量3-5倍;LMDeploy、SGLang对多模态、长文本场景友好,与DeepSeek等模型深度整合后,可进一步提升推理效率。针对MoE模型,KTransformers、DeepSpeed等框架强化了专家并行支持,DeepEP通信库则定向优化了MoE架构的通信开销,降低部署和运行成本。

2. 开源模型替代与硬件适配:降低许可与硬件成本

选用LLaMA、StableLM等开源模型,可避免专有API的高昂费用,同时利用社区资源进行持续优化,降低定制化成本。硬件选型上,根据任务需求匹配性价比更高的硬件,例如推理阶段选用RTX4090替代A100,可将月均成本从万美元级降至2000美元以下;同时,利用AMD、华为昇腾等非英伟达硬件的生态支持,进一步降低硬件采购和租赁成本。

3. 建立成本监控体系:实现精细化管控

通过实时监控算力使用、显存占用、任务进度等指标,及时发现资源闲置、过度消耗等问题。建立成本评估模型,定期分析性能与成本效益,采用渐进式优化策略,避免一次性大规模投入。例如,通过监控发现某场景下模型推理的GPU利用率仅为20%,通过调整批处理大小和调度策略,可将利用率提升至60%以上,成本降低60%。

三、总结:多维度协同优化是核心

大幅降低大模型训练和推理成本并非依赖单一技术,而是需要"模型优化-架构设计-策略调整-工程管理"的全链路协同。通过量化、剪枝、蒸馏等技术实现模型轻量化,通过分布式架构、PD分离、精细化调度提升资源利用率,通过高效数据利用、参数微调减少无效消耗,再结合开源生态和成本监控实现全生命周期管控,可将训练和推理成本降低70%-85%,同时保持95%以上的性能表现,为大模型的规模化落地提供可持续的成本支撑。

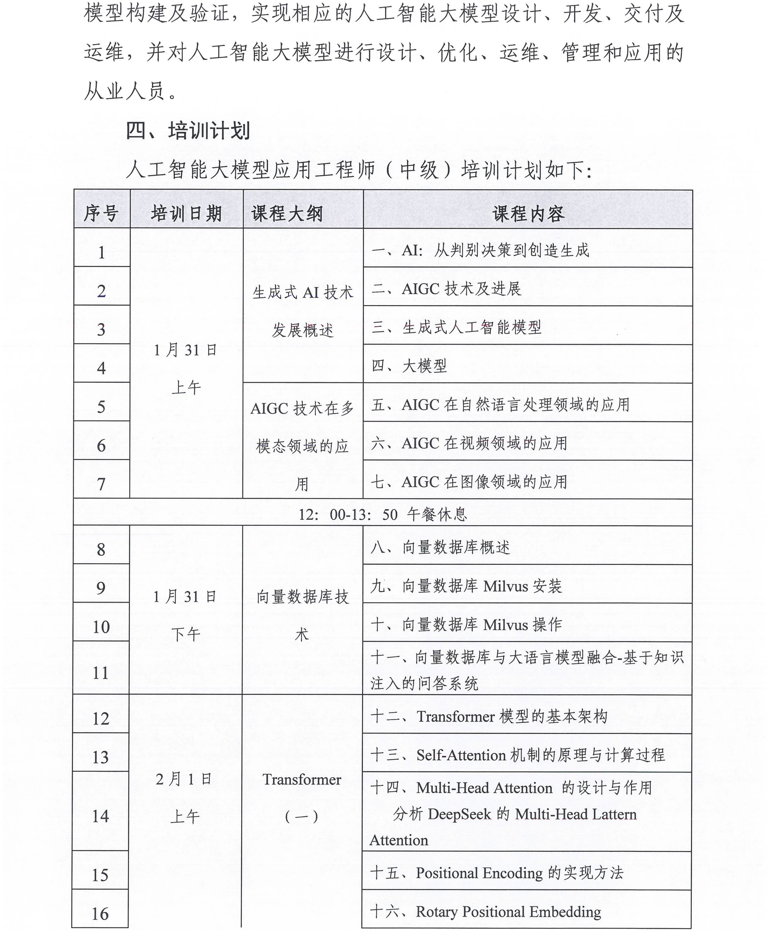

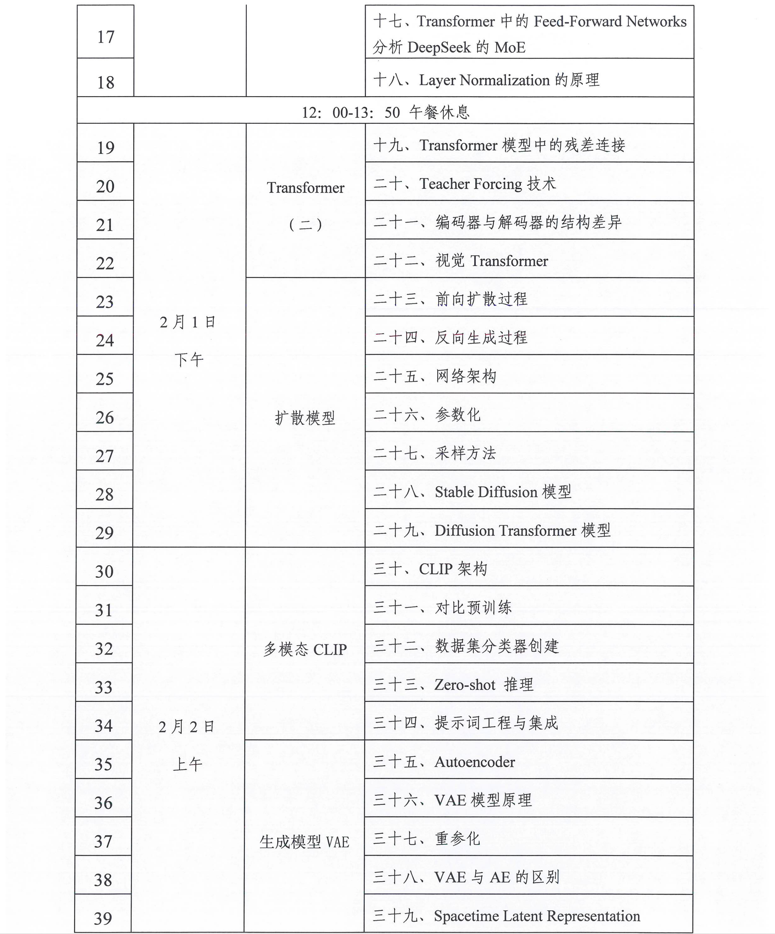

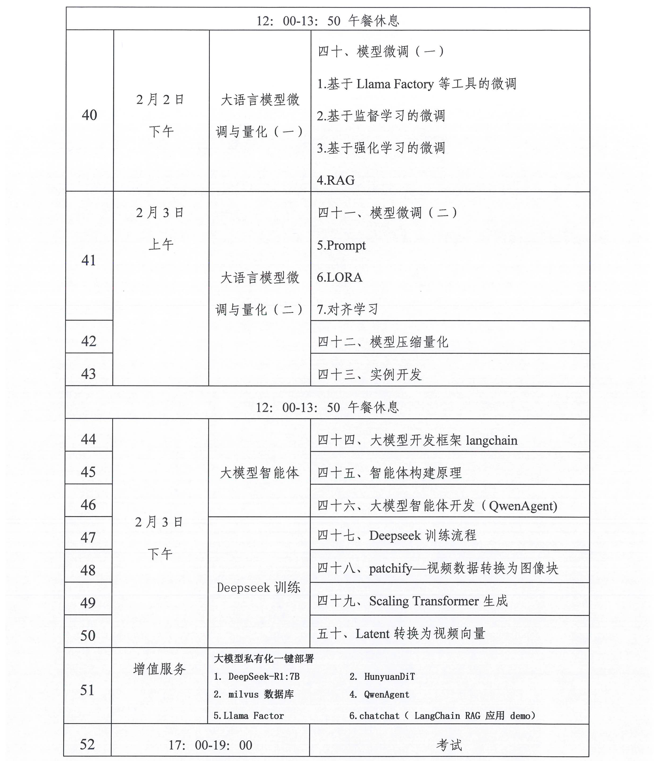

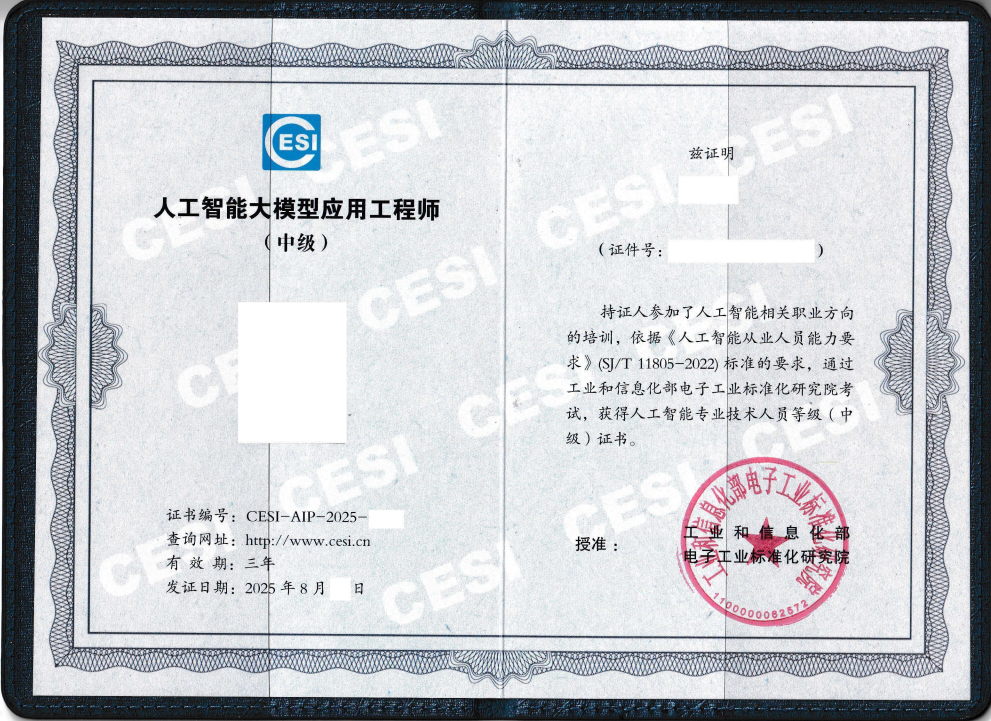

相关学习课纲推荐: 工业和信息化部电子工业标准化研究院关于开展人工智能从业人员 "人工智能大模型应用工程师"专项学习