目录

-

- 1.摘要

- [2.异构 pbest 引导的综合学习粒子群算法](#2.异构 pbest 引导的综合学习粒子群算法)

- 4.结果展示

- 5.参考文献

- 6.代码获取

- 7.算法辅导·应用定制·读者交流

1.摘要

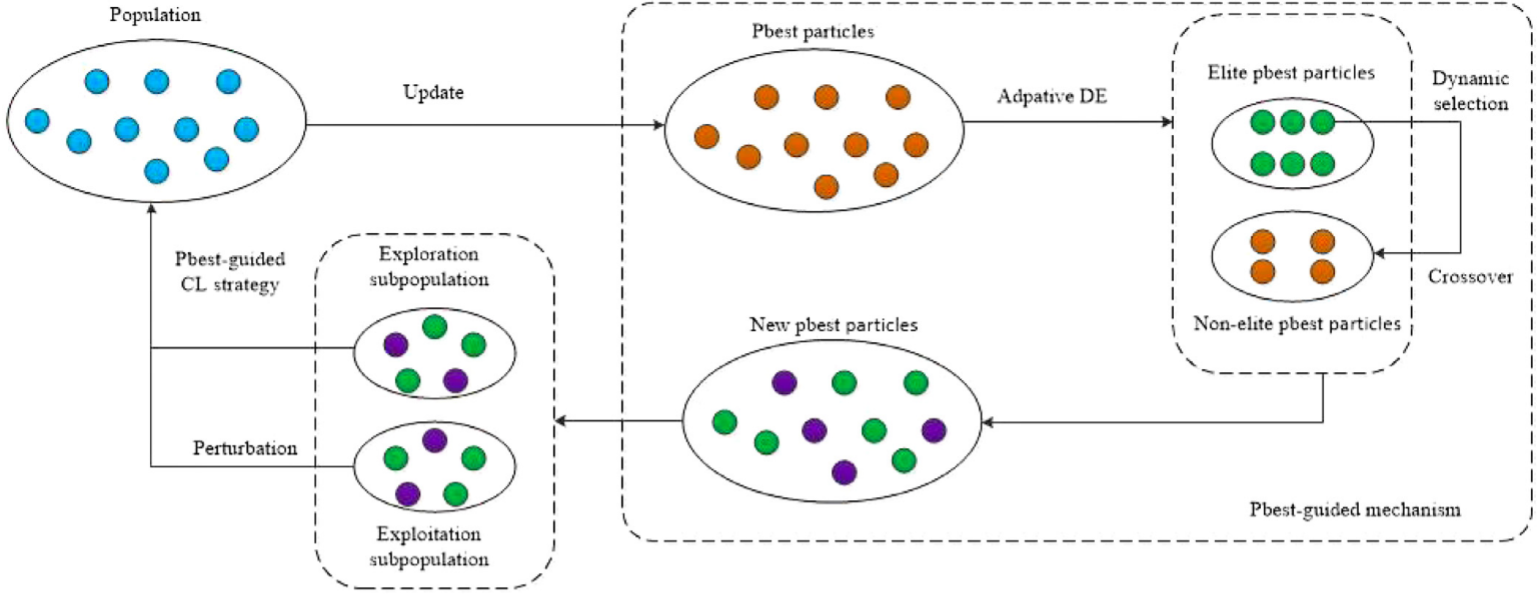

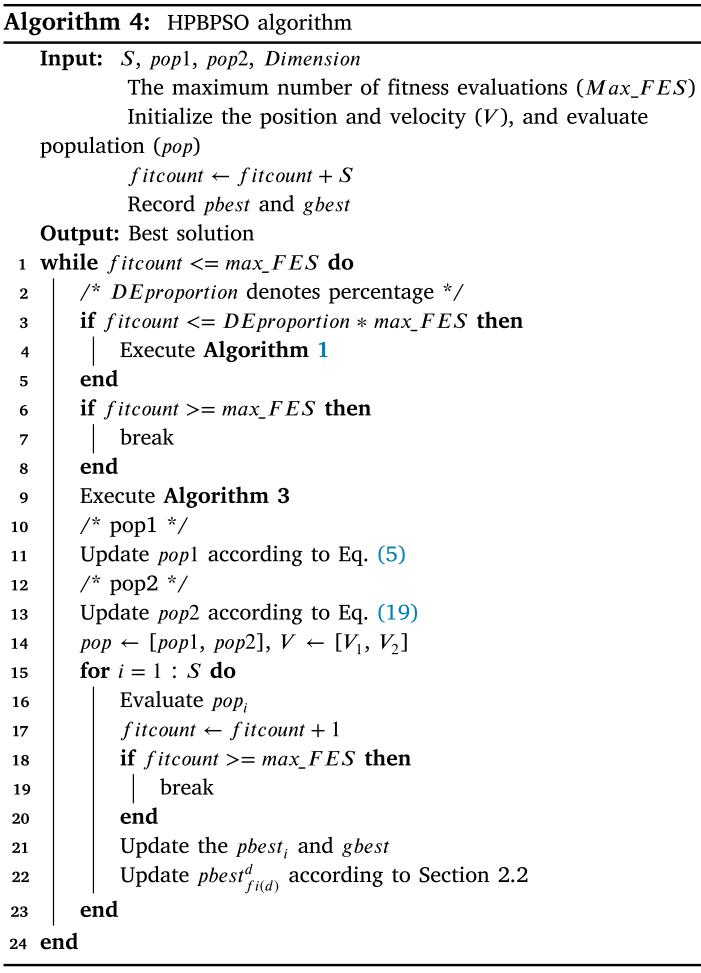

针对PSO算法中探索---开发平衡难以有效解决的问题,本文提出一种综合学习策略------异构 pbest 引导的综合学习粒子群算法(HPBPSO)。该算法将种群划分为探索子群与开发子群:探索子群引入pbest引导机制,并通过动态交叉使非精英个体向精英pbest学习;开发子群采用精英学习与组内学习两类机制,并加入组间扰动以加速收敛。

2.异构 pbest 引导的综合学习粒子群算法

为平衡PSO的全局探索与局部开发,并引导粒子朝更优方向搜索,HPBPSO采用pbest引导的综合学习(CL)策略将群体划分为两类子群:pop1侧重全局探索,寻找更有潜力的区域;pop2侧重局部开发,加快收敛速度。

pbest引导机制

在HCLPSO中,两类子群的粒子都由综合学习(CL)策略产生的示例引导:

V i d ( t + 1 ) = w ∗ V i d ( t ) + c 1 ∗ r 1 ∗ ( p b e s t f i ( d ) d ( t ) − X i d ( t ) ) + c 2 ∗ r 2 ∗ ( g b e s t d ( t ) − X i d ( t ) ) V_{i}^{d}(t+1)=w*V_{i}^{d}(t)+c_{1}*r1*\left(pbest_{fi(d)}^{d}(t)-X_{i}^{d}(t)\right)+c_{2}*r2*\left(gbest^{d}(t)-X_{i}^{d}(t)\right) Vid(t+1)=w∗Vid(t)+c1∗r1∗(pbestfi(d)d(t)−Xid(t))+c2∗r2∗(gbestd(t)−Xid(t))

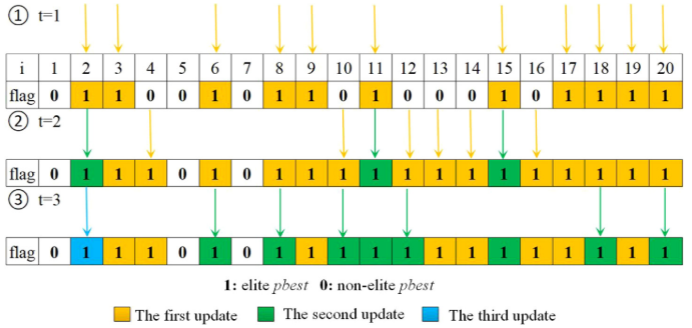

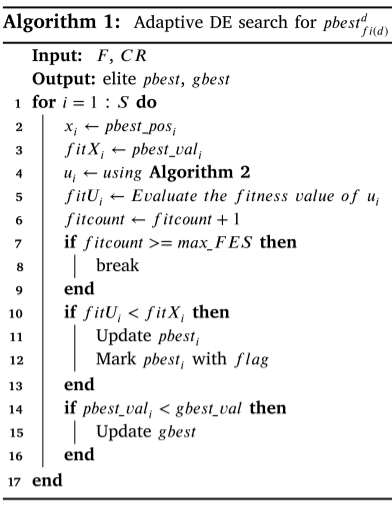

通过自适应差分进化(DE)在综合学习PSO中生成更优的学习示例,将pbest分为精英与非精英两类,并用DE变异交叉产生候选解,按适应度更新pbest与gbest。参数F递减、CR递增,并结合两种变异策略与边界处理,使精英pbest持续优化,从而提升学习质量。

动态交叉策略

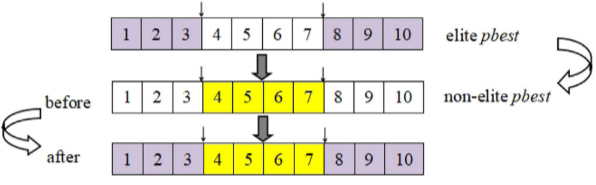

自适应DE能生成优质pbest但不足以覆盖全部精英个体,因此对非精英pbest引入交叉策略,通过交叉产生更有价值的pbest、扩大搜索范围,并随迭代与种群质量动态更新。

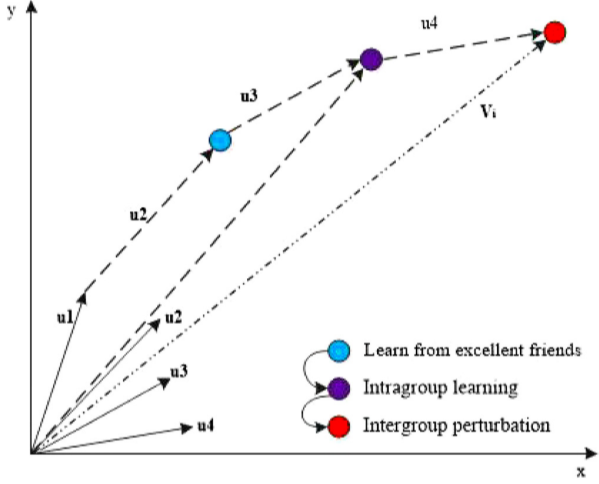

组间扰动

进化后期种群多样性下降、易陷入局部最优,本文提出组间扰动机制,对速度更新公式进行小幅修改,引导粒子向全局最优gbest 靠近,从而促进收敛并降低陷入局部最优的风险:

V i d ( t + 1 ) = w ∗ V i d ( t ) + c 1 ∗ r 1 ∗ ( p b e s t f i ( d ) d ( t ) − X i d ( t ) ) + c 2 ∗ r 2 ∗ ( g b e s t d ( t ) − X i d ( t ) ) + ( r 3 ) λ ∗ ( g b e s t d ( t ) − p b e s t i d ( t ) ) \begin{gathered}V_{i}^{d}(t+1)=w*V_{i}^{d}(t)+c_{1}*r1*\left(pbest_{fi(d)}^{d}(t)-X_{i}^{d}(t)\right)\\+c_{2}*r2*\left(gbest^{d}(t)-X_{i}^{d}(t)\right)\\+(r3)^{\lambda}*(gbest^{d}(t)-pbest_{i}^{d}(t))\end{gathered} Vid(t+1)=w∗Vid(t)+c1∗r1∗(pbestfi(d)d(t)−Xid(t))+c2∗r2∗(gbestd(t)−Xid(t))+(r3)λ∗(gbestd(t)−pbestid(t))

定义与个体最优、全局最优相关的方向项(如 P x = c 1 ( p b e s t f i ( d ) − X i ) P_x=c_1(pbest_{fi(d)}-X_i) Px=c1(pbestfi(d)−Xi)、 G x = c 2 ( g b e s t − X i ) G_x=c_2(gbest-X_i) Gx=c2(gbest−Xi)),再将速度更新分解为若干加权分量 u 1 ∼ u 4 u_1\sim u_4 u1∼u4,把等是表示成清向量叠加形式,便于分析粒子受各项驱动的作用:

V i = w ∗ V i + r 1 ∗ P x + r 2 ∗ G x + r 3 ′ ∗ G x ′ = u 1 + u 2 + u 3 + u 4 \mathbf{V_{i}}=w*\mathbf{V_{i}}+r1*\mathbf{P_{x}}+r2*\mathbf{G_{x}}+r3^{\prime}*\mathbf{G_{x}^{\prime}}=\mathbf{u1}+\mathbf{u2}+\mathbf{u3}+\mathbf{u4} Vi=w∗Vi+r1∗Px+r2∗Gx+r3′∗Gx′=u1+u2+u3+u4

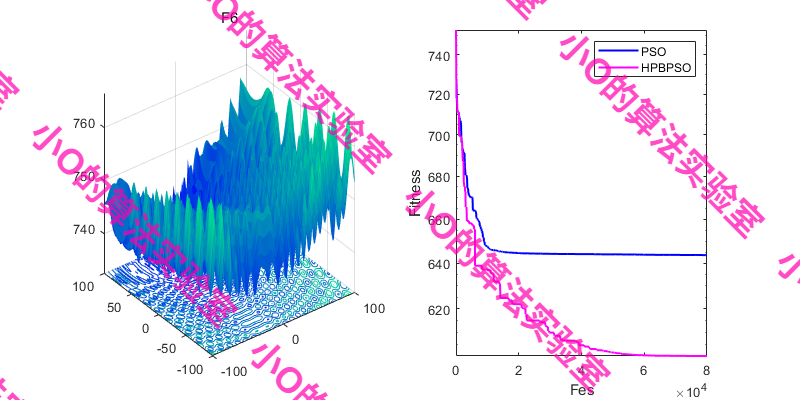

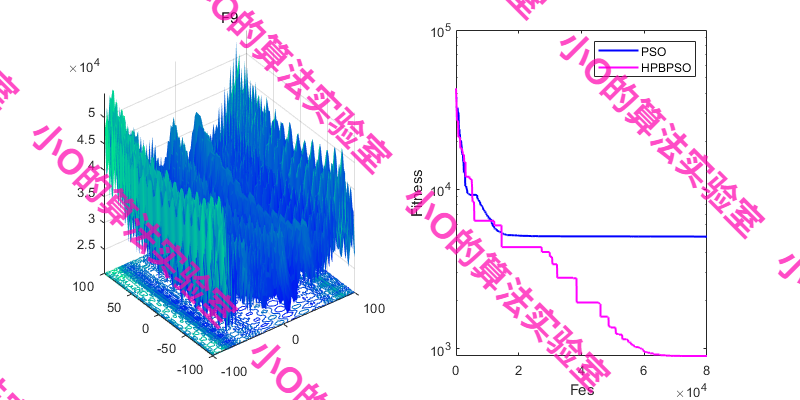

4.结果展示

5.参考文献

1\] Meng X, Li H. Heterogeneous pbest-guided comprehensive learning particle swarm optimization\[J\]. Applied Soft Computing, 2024, 162: 111874. ### 6.代码获取 xx ### 7.算法辅导·应用定制·读者交流 xx