目录

- [1. kubeadm、kubelet、kubectl安装](#1. kubeadm、kubelet、kubectl安装)

- [2. 安装containerd](#2. 安装containerd)

-

- [2.1 解压安装包,设置systemd](#2.1 解压安装包,设置systemd)

- [2.2 安装runc](#2.2 安装runc)

- [2.3 安装CNI插件](#2.3 安装CNI插件)

- [3. 使用cgroup v2](#3. 使用cgroup v2)

- [4. 集群部署](#4. 集群部署)

-

- [4.1 第一个master节点](#4.1 第一个master节点)

- [4.2 增加控制面节点](#4.2 增加控制面节点)

- [4.3 calico安装](#4.3 calico安装)

- 注意点

-

- [1. registry.k8s.io/pause:3.10.1镜像](#1. registry.k8s.io/pause:3.10.1镜像)

- [2. 可用的镜像站点](#2. 可用的镜像站点)

1. kubeadm、kubelet、kubectl安装

2. 安装containerd

2.1 解压安装包,设置systemd

参考https://github.com/containerd/containerd/blob/main/docs/getting-started.md

- 先把https://github.com/containerd/containerd/releases,找一个最新的安装包解压到本地,然后解压

shell

tar Cxzvf /usr/local/ containerd-2.2.1-linux-amd64.tar.gz

bin/

bin/containerd-shim-runc-v2

bin/containerd-shim

bin/ctr

bin/containerd-shim-runc-v1

bin/containerd

bin/containerd-stress- If you intend to start containerd via systemd, you should also download the containerd.service unit file from https://raw.githubusercontent.com/containerd/containerd/main/containerd.service into

/usr/local/lib/systemd/system/containerd.service, and run the following commands:

shell

systemctl daemon-reload

systemctl enable --now containerd2.2 安装runc

- 上面官方文档里有写

shell

install -m 755 runc.amd64 /usr/local/sbin/runc2.3 安装CNI插件

- 命令如下

shell

mkdir -p /opt/cni/bin

tar Cxzvf /opt/cni/bin cni-plugins-linux-amd64-v1.9.0.tgz结果

./

./bandwidth

./host-device

./LICENSE

./loopback

./ptp

./vrf

./tuning

./host-local

./static

./tap

./bridge

./README.md

./macvlan

./firewall

./dummy

./sbr

./ipvlan

./portmap

./dhcp

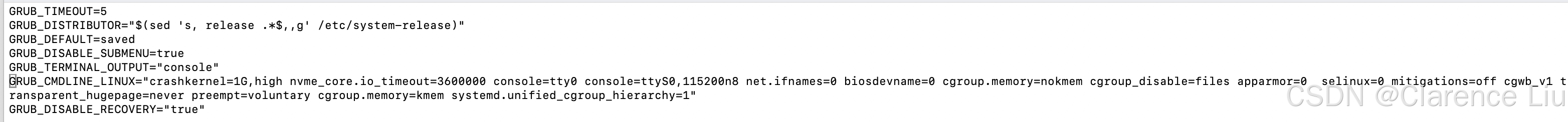

./vlan3. 使用cgroup v2

/etc/containerd/config.toml文件内容如下

toml

[plugins.'io.containerd.cri.v1.runtime'.containerd.runtimes.runc]

[plugins.'io.containerd.cri.v1.runtime'.containerd.runtimes.runc.options]

SystemdCgroup = true- 由于

cgroups v1 support is deprecated and will be removed in a future release. Please migrate to cgroups v2. To explicitly enable cgroups v1 support for kubelet v1.35 or newer, you must set the kubelet configuration option 'FailCgroupV1' to 'false'. You must also explicitly skip this validation. For more information, see https://git.k8s.io/enhancements/keps/sig-node/5573-remove-cgroup-v1,我们需要把启用cgroups v2,文档参考https://kubernetes.io/zh-cn/docs/concepts/architecture/cgroups/ - 首先使用

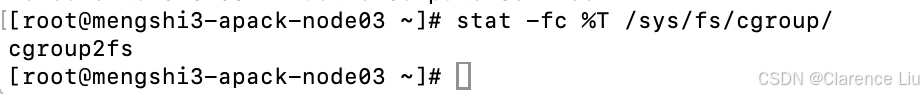

stat -fc %T /sys/fs/cgroup/,看Linux系统当前使用的cgroup版本,对于CGroup v1,输出tmpfs;对于CGroup v2输出cgroup2fs

我当前的输出是tmpfs

- 需要在

/etc/default/grub的GRUB_CMDLINE_LINUX中添加systemd.unified_cgroup_hierarchy=1,然后执行下面的命令(不同发行版不一样)

shell

# Debian/Ubuntu(默认已安装)

sudo update-grub

# CentOS/RHEL 7+

sudo grub2-mkconfig -o /boot/grub2/grub.cfg

# Fedora(UEFI模式)

sudo grub2-mkconfig -o /boot/efi/EFI/fedora/grub.cfg

# Arch Linux

sudo grub-mkconfig -o /boot/grub/grub.cfg- 重启操作系统

shell

sudo reboot再次执行stat -fc %T /sys/fs/cgroup/,发现输出变成cgroup2fs

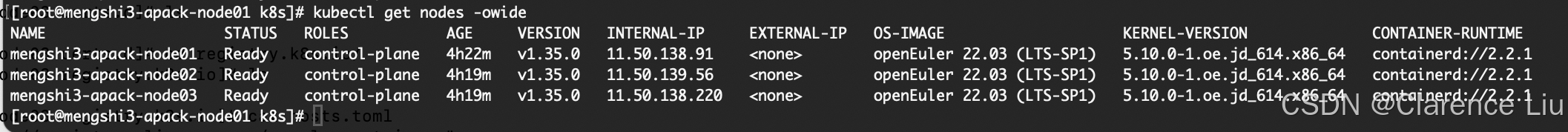

4. 集群部署

4.1 第一个master节点

- 先看下文章最后的 注意点1

- 使用下面的命令。

control-plane-endpoint是负载均衡器的访问地址,可以暂时使用某个master节点

shell

kubeadm init \

--control-plane-endpoint=11.50.138.91:6443 \

--image-repository=registry.cn-hangzhou.aliyuncs.com/google_containers \

--kubernetes-version=v1.35.0 \

--pod-network-cidr=10.244.0.0/16等待组件都就绪,然后执行

shell

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

export KUBECONFIG=/etc/kubernetes/admin.conf然后可以使用kubectl命令了

4.2 增加控制面节点

- 在第一个master节点上生成认证密钥

shell

kubeadm init phase upload-certs --upload-certs结果如下

[root@mengshi3-apack-node01 ~]# kubeadm init phase upload-certs --upload-certs

[upload-certs] Storing the certificates in Secret "kubeadm-certs" in the "kube-system" Namespace

[upload-certs] Using certificate key:

2921c3475df1449711486d503a7202f5d2a97126f416dd4627c35a52faf5db0d然后生成添加控制面节点的命令

shell

kubeadm token create --print-join-command --certificate-key 2921c3475df1449711486d503a7202f5d2a97126f416dd4627c35a52faf5db0d会生成下面的命令。在需要加进来的节点机器上执行,即可把节点作为控制面节点加入k8s集群

kubeadm join 11.50.138.91:6443 --token wicgtt.nc2z5fj7cqa2ypah --discovery-token-ca-cert-hash sha256:2ffcfac3c76d84c0aceff773e9ec8a7a59155f721eeaaa024df1f055abfe4c96 --control-plane --certificate-key 2921c3475df1449711486d503a7202f5d2a97126f416dd4627c35a52faf5db0d4.3 calico安装

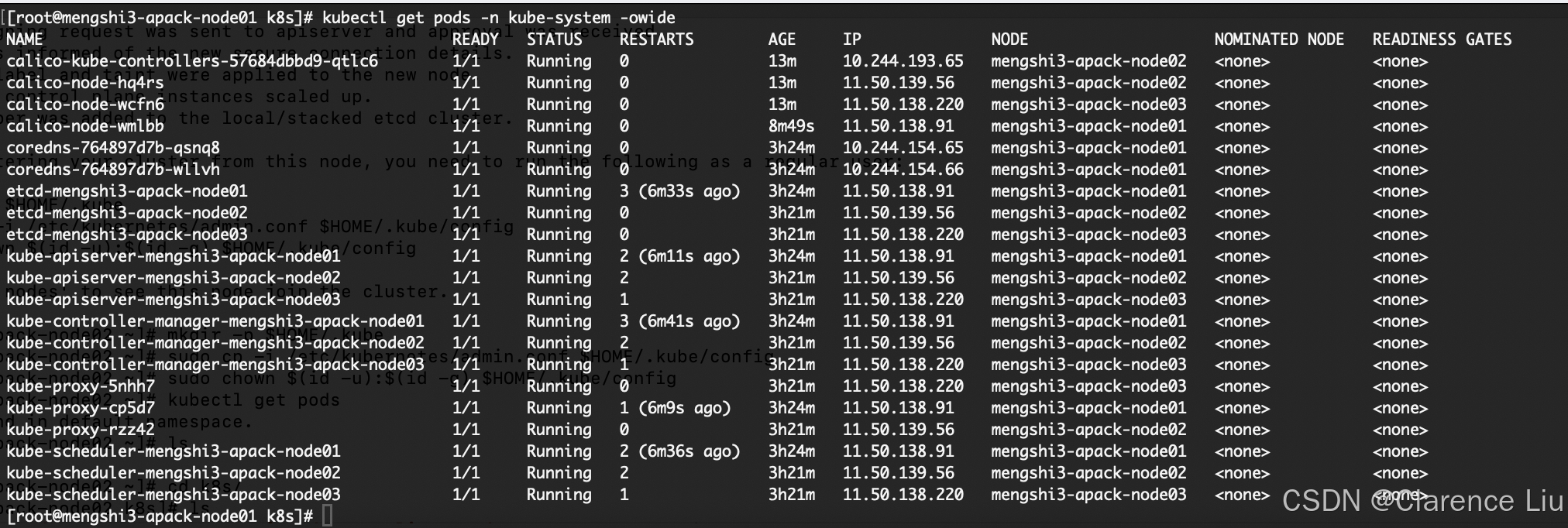

- 上面的组件装完之后,节点状态是

NotReady,这时候,需要安装网络插件以支持集群的节点间网络通信,常见的插件有flannel和calico,对于简单的小集群可以使用flannel,这里我们选择功能更强的calico - https://raw.githubusercontent.com/projectcalico/calico/v3.27.0/manifests/calico.yaml这是

calico的yaml文件,可以修改镜像地址之后apply到集群。安装完了之后,观察组件状态是否全部Running

- 然后

Node Ready,集群部署成功

注意点

1. registry.k8s.io/pause:3.10.1镜像

需要在containerd的k8s.io ns下放一个registry.k8s.io/pause:3.10.1镜像,在拉起核心组件的时候需要。但我们无法直接访问这个仓库,所以可能需要tag一下。使用下面的命令

shell

ctr -n k8s.io images tag registry.cn-hangzhou.aliyuncs.com/google_containers/pause:3.10.1 registry.k8s.io/pause:3.10.12. 可用的镜像站点

docker.m.daocloud.io