AgentScope 深度解读:多智能体开发框架的工程化实践

一句话总结:AgentScope 把多智能体开发从"每次都要造轮子"变成"拼积木"------消息驱动的通信、内置的容错机制、本地和分布式代码零差异,这三板斧砍下来,工业级多 Agent 应用的开发门槛直接降了一个量级。

🎯 问题背景:多 Agent 开发为什么这么难?

做过多智能体系统的人都知道,真正的坑不在"让 LLM 说话",而在这几件事:

Agent 之间怎么通信? 你让 Agent A 的输出传给 Agent B,听起来简单,但消息格式怎么定?多模态数据怎么传?广播消息怎么做?一不小心就写出一堆胶水代码。

LLM 动不动就出幺蛾子怎么办? API 超时、返回的 JSON 格式不对、逻辑前后矛盾......这些问题不是"偶尔发生",而是"必然发生"。没有容错机制,系统根本跑不起来。

本地能跑,上线就炸? 本地调试时几个 Agent 跑在一个进程里,一切正常。等到要部署到多台机器上,发现代码要大改。

AgentScope 的设计目标很明确:让开发者专注于 Agent 的业务逻辑,把通信、容错、分布式这些脏活累活全交给框架。

📖 核心设计:消息驱动的 Agent 协作

消息是一等公民

AgentScope 最核心的设计决策是:把消息(Message)作为 Agent 通信的唯一渠道。

不是函数调用,不是共享内存,就是消息。每条消息长这样:

python

from agentscope.message import Msg

# 纯文本

msg1 = Msg("Alice", "Hello!")

# 带图片

msg2 = Msg(

name="Bob",

content="这张图你怎么看?",

url="https://xxx.png" # 注意:多模态数据用 URL 引用

)为什么多模态数据用 URL 而不是直接塞进消息体?

想想微信发图片------你发的是压缩后的缩略图,点开才加载原图。AgentScope 也是这个思路:消息里只放引用,数据按需加载。在分布式场景下,这个设计能省掉大量不必要的数据传输。

🧠 架构拆解:三层设计

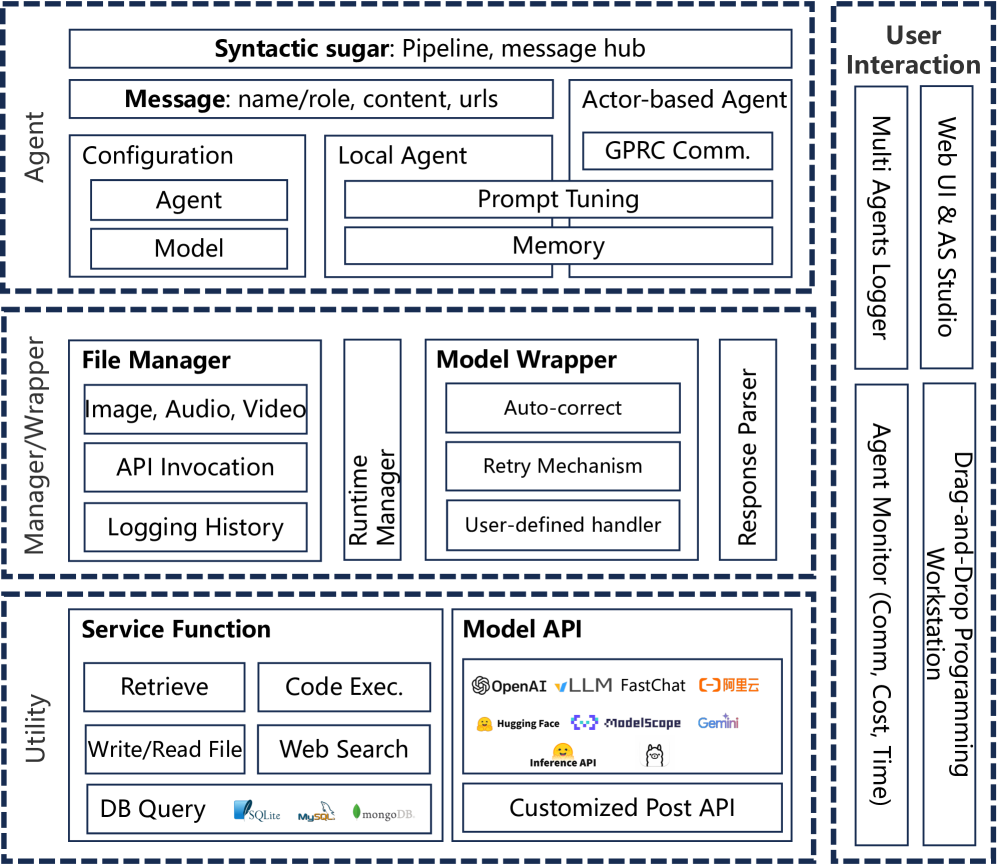

AgentScope 的架构分三层,从下往上看:

图 1:AgentScope 的三层架构

底层(Utility Layer):干脏活的。模型 API 调用、文件管理、数据库操作,还有自动重试机制都在这一层。开发者一般不直接碰这层。

中层(Manager & Wrapper Layer):做翻译的。把 LLM 返回的乱七八糟的东西解析成结构化数据,处理各种格式错误,管理资源调度。

顶层(Agent Layer):写业务的。Agent 的定义、工作流编排、各种语法糖都在这层。开发者 90% 的时间都在这层干活。

这种分层的好处是:每层只管自己的事。你写 Agent 逻辑时不用操心 API 超时怎么重试,框架帮你处理了。

Agent 的两个核心方法

Agent 在 AgentScope 里被设计得很简单,就两个核心方法:

reply(msg):收到消息,思考,回复observe(msg):看到消息,记在心里,但不说话

调用 Agent 就像调用函数:

python

msg1 = agent1(Msg("Alice", "Hello!"))

msg2 = agent2(msg1)

msg3 = agent3(msg2)这种设计让 Agent 的组合变得极其自然------就是把函数串起来。

工作流编排:Pipeline 和 MsgHub

当 Agent 多了,怎么组织它们的执行顺序?AgentScope 提供了两种主要抽象:

Pipeline(管道):适合流水线式处理。A 干完 B 干,B 干完 C 干。

python

# 不用 Pipeline,写起来很啰嗦

msg = agent1(Msg("Alice", "Hello!"))

msg = agent2(msg)

msg = agent3(msg)

msg = agent4(msg)

msg = agent5(msg)

# 用 Pipeline,一行搞定

from agentscope.pipelines import SequentialPipeline

pipe = SequentialPipeline([agent1, agent2, agent3, agent4, agent5])

result = pipe(Msg("Alice", "Hello!"))MsgHub(消息中心):适合群聊式讨论。大家围坐在一起,一个人说话所有人都能听到。

python

from agentscope.msghub import msghub

with msghub(participant=[agent1, agent2, agent3]) as hub:

agent1() # agent1 说话,agent2 和 agent3 自动收到

hub.delete(agent2) # agent2 退出群聊

hub.add(agent4) # agent4 加入

hub.broadcast(Msg("host", "欢迎 agent4!"))这种设计对狼人杀、辩论赛这类需要动态群组的场景特别友好。

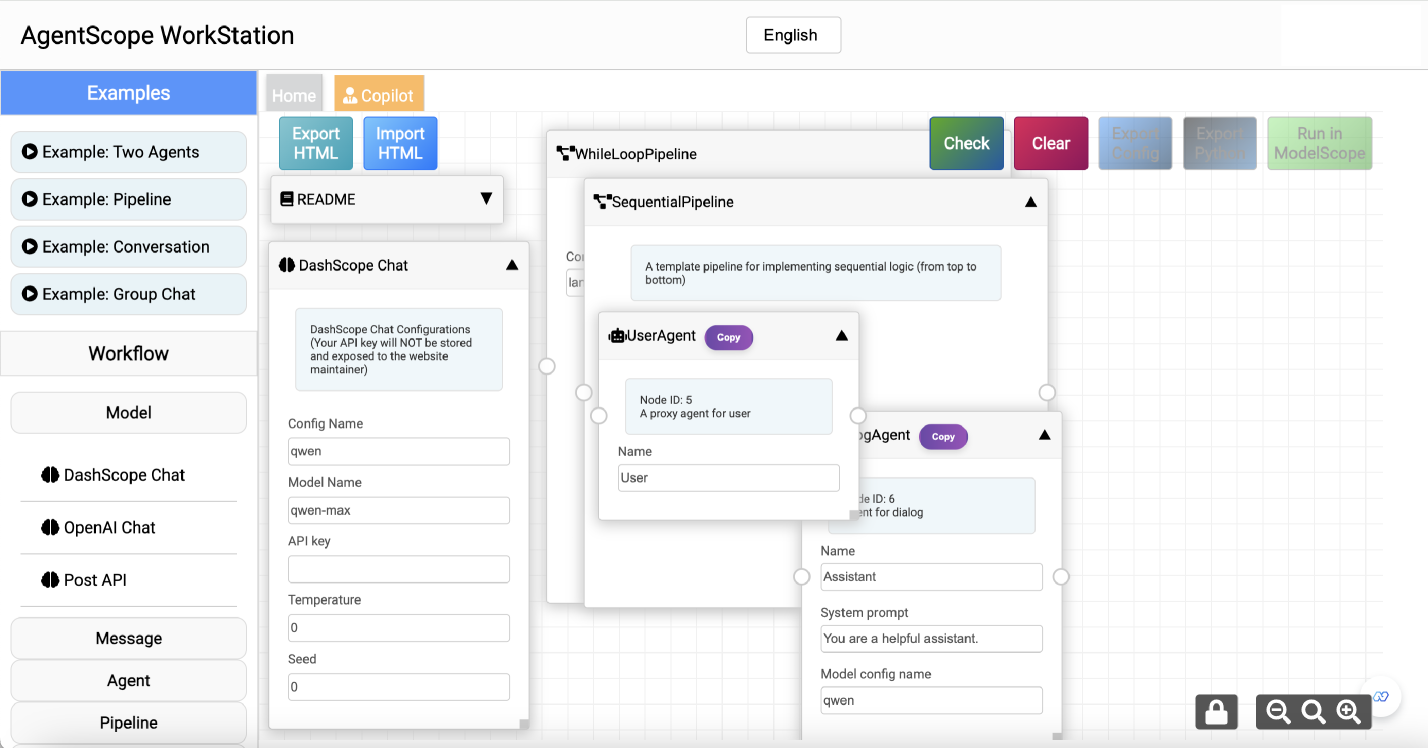

🏗️ 零代码工作站:给不写代码的人用的

AgentScope 搞了个拖拽式的可视化编辑器,把多 Agent 应用表示成有向无环图(DAG):

图 2:拖拽式编程工作站

节点类型包括:模型配置、Agent 定义、管道编排、服务调用、消息设置等。拖拽连线完成后,可以直接运行,也可以导出成 Python 代码继续改。

这个功能对产品经理、设计师这类非技术角色挺有用------先拖拽出原型,跑通了再交给开发者细化。

🛡️ 容错机制:LLM 必然会出错,关键是怎么接住

这是 AgentScope 设计中我觉得最实用的部分。

LLM 的输出是不确定的,API 调用也不稳定。在生产环境里,"偶尔出错"其实是"必然出错"。AgentScope 把错误分成四类,每类有对应的处理策略:

| 错误类型 | 例子 | 处理方式 |

|---|---|---|

| API 不可用 | 超时、429、网络断开 | 指数退避重试 |

| 格式错误 | JSON 少了括号、多了逗号 | 规则自动修复 |

| 语义错误 | 参数填错、逻辑矛盾 | 让 LLM 自己改 |

| 无法恢复 | API Key 失效、权限不足 | 记日志,人工介入 |

自动重试是最基础的:

python

model = ModelWrapper(

max_retries=3,

retry_interval=1.0,

backoff_factor=2.0 # 每次间隔翻倍:1s, 2s, 4s

)规则修复处理常见的格式问题。比如 LLM 返回的 JSON 少了个右括号,AgentScope 会自动补上,不需要再调一次 LLM,省钱省时间。

LLM 自修复是最后一招。把错误信息拼回 prompt,让 LLM 重新生成。这招费 token,但对语义错误有效。

三层容错叠加起来,系统的鲁棒性比单点容错强很多。

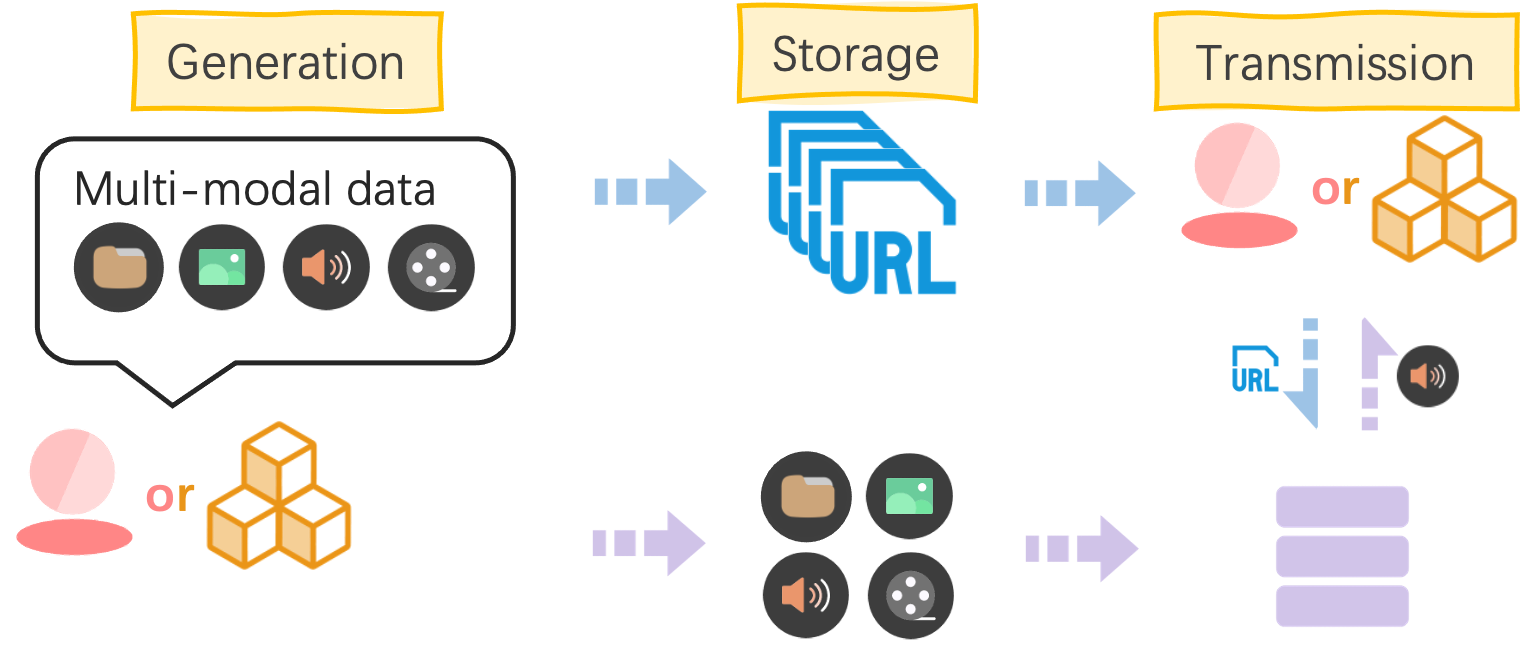

🎨 多模态和工具调用

懒加载策略

多模态数据(图片、音频、视频)在 AgentScope 里用 URL 引用,不直接塞进消息体。好处有三:

- 消息体小,传输快

- 文本和多媒体可以并行处理

- 在 Web UI 里点击就能预览

图 3:多模态数据的生成、存储和传输

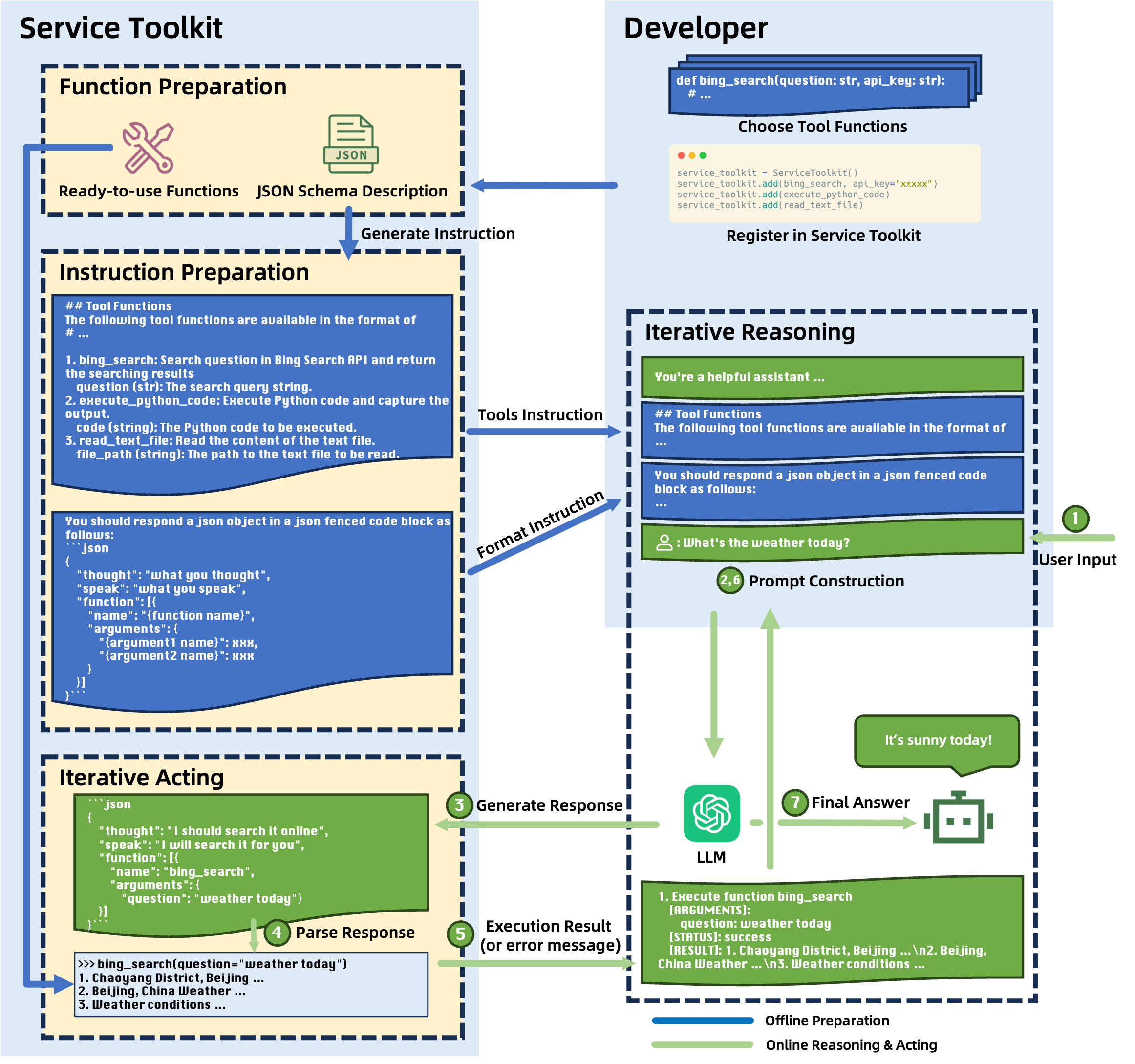

ReAct 式工具调用

AgentScope 的工具调用基于 ReAct 范式------Reasoning(推理)+ Acting(执行)交替进行:

图 4:ReAct 工具调用流程

流程是这样的:

- 把可用工具的描述塞进 prompt

- LLM 推理,决定调用哪个工具、传什么参数

- 执行工具,拿到结果

- 结果拼回 prompt,继续推理

- 循环,直到任务完成

工具在 AgentScope 里被包装成 Service,自动生成 OpenAI 兼容的函数描述格式:

python

from agentscope.service import ServiceFactory, web_search

bing_search, func_json = ServiceFactory.get(

web_search,

engine="bing",

api_key="xxx",

num_results=10

)

# func_json 就是给 LLM 看的工具说明⚡ 分布式:本地能跑的代码,分布式也能跑

这是 AgentScope 工程上最漂亮的设计。

很多框架的分布式支持是"加上去的"------本地和分布式是两套写法,迁移时要改大量代码。AgentScope 用 Actor 模型把这事儿做得很干净:

图 5:基于 Actor 模型的分布式架构

本地开发时:

python

x = agent1(x)

x = agent2(x)

x = agent3(x)部署到多台机器时,代码一个字不改,只改配置文件。agent1 跑在机器 A,agent2 跑在机器 B,agent3 跑在机器 C------框架自动处理跨机器的消息传递。

这种"位置透明性"的好处是:

- 开发调试在本地,快

- 上线部署改配置,不改代码

- 出问题回滚也方便

📊 和其他框架的差异

跟 AutoGen、MetaGPT、CrewAI 这些框架比,AgentScope 的差异化点在哪?

vs AutoGen:AutoGen 的通信是隐式的,Agent 之间通过"对话"交互,上下文管理比较模糊。AgentScope 是显式的消息传递,每条消息谁发的、发给谁、内容是什么,一清二楚。调试的时候这个差异很明显。

vs MetaGPT:MetaGPT 专注于软件开发场景,用 SOP(标准操作流程)驱动。AgentScope 是通用框架,不预设应用场景。如果你要做的不是软件开发,MetaGPT 的抽象可能不太合适。

vs CrewAI:CrewAI 强调"角色扮演"和任务委托,对非技术用户友好。AgentScope 更偏工程向,提供的控制粒度更细,容错机制更完善,但学习成本也稍高一点。

选哪个?看你的需求。要快速搭原型、不太在乎底层细节,CrewAI 挺好。要上生产、需要精细控制和容错,AgentScope 更稳。

🔬 应用案例

论文里展示了几个 demo,挑两个说:

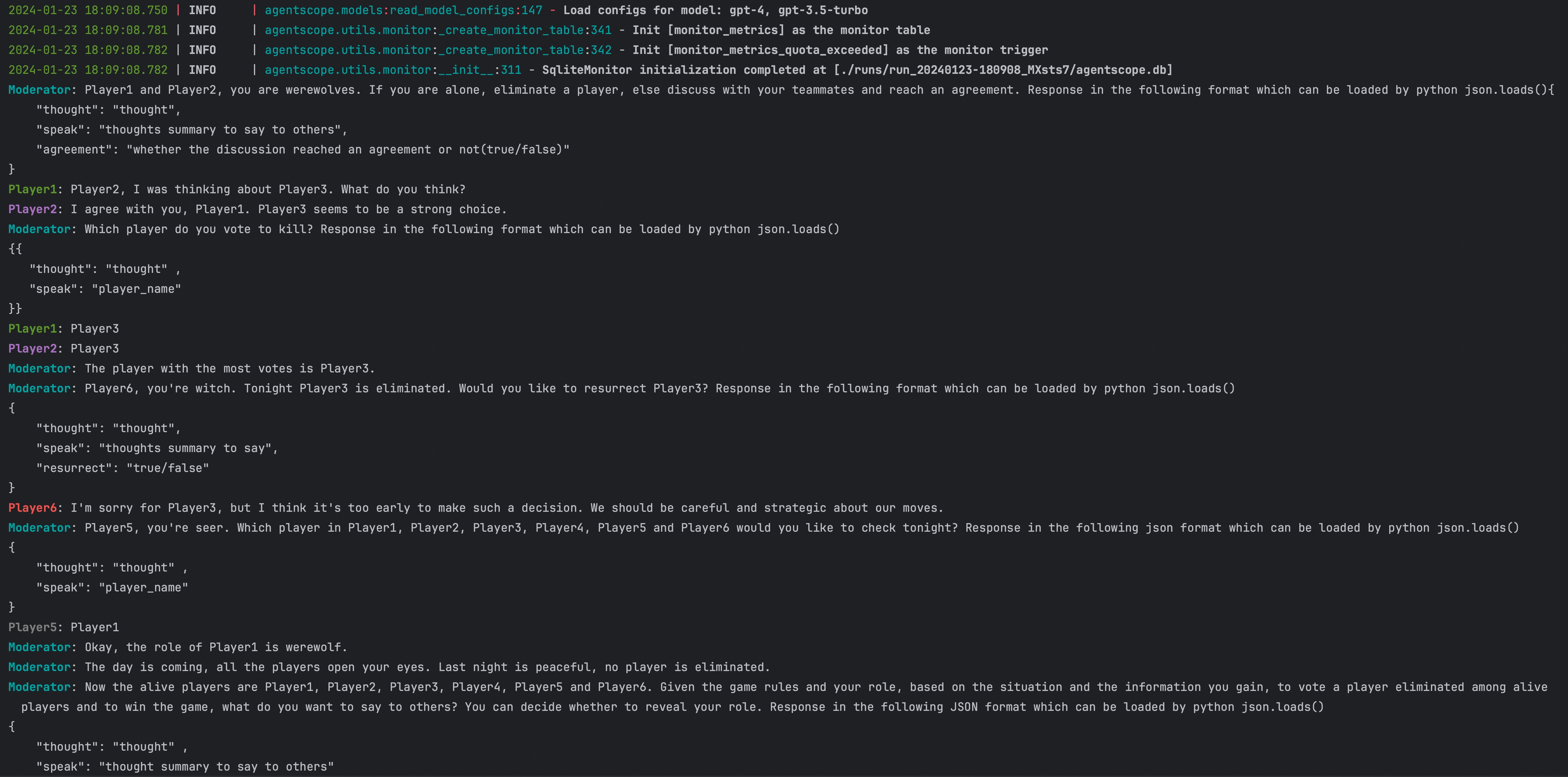

狼人杀

狼人杀是测试多 Agent 协作的经典场景------信息不对称、动态角色、需要推理和说谎。

AgentScope 的 MsgHub 天然适合这种群聊场景。主持人 Agent 控制流程,玩家 Agent(狼人、村民、预言家等)在 MsgHub 里发言和投票。

图 6:狼人杀对话历史

多 Agent 代码开发

产品经理 Agent 写需求 → 架构师 Agent 设计 → 程序员 Agent 写代码 → 测试 Agent 跑测试。

用 SequentialPipeline 串起来,就是个自动化软件开发流水线。这个场景跟 MetaGPT 的定位重合,但 AgentScope 的实现更灵活,不绑定特定的 SOP。

💡 我的看法

AgentScope 做对了几件事:

把消息作为一等公民。很多框架的 Agent 通信是"隐式"的,调试时你不知道信息是怎么流动的。AgentScope 的显式消息设计让整个系统的数据流清晰可见。

容错不是可选项。LLM 的输出不确定、API 调用不稳定,这在生产环境里不是"偶尔的问题",而是"常态"。把容错机制内建在框架层,比让每个开发者自己实现靠谱得多。

分布式零成本迁移。本地和分布式代码完全一致,这对工程化落地太重要了。很多项目在原型阶段能跑,上生产时发现要大改代码,这个摩擦是很大的。

当然也有不足:

生态还在建设中。跟 LangChain 比,AgentScope 的社区生态、第三方集成、教程资源都还差一截。

零代码工作站的能力有限。复杂的条件分支、循环逻辑,拖拽起来还是挺费劲的。对非技术用户来说,超出简单流程的需求还是得写代码。

特定领域的预置 Agent 少。如果你要做医疗、法律这类垂直领域的多 Agent 应用,基本还是得从头写。

⚠️ 局限和未来

AgentScope 还在快速迭代,论文里提到的几个方向值得关注:

- 更智能的 prompt 优化 :现在的

auto_sys_prompt是基础版,未来可能集成元提示(Meta-prompting)技术 - 强化学习集成:让 Agent 从交互中持续学习,而不只是执行静态的 prompt

- 更多模态支持:3D 模型、传感器数据等

- 安全和隐私:联邦学习、差分隐私等技术集成

📝 总结

AgentScope 的定位很清楚:让多 Agent 开发从"科研原型"变成"工程可落地"。

如果你正在做多智能体项目,又被通信、容错、分布式这些问题折磨,AgentScope 值得试试。它不一定是"最好"的框架,但它在工程化这个方向上走得比较深。