这是一个"没有标准答案"的评估问题

在大模型项目里,评估往往被认为是一个"技术收尾"的环节:

- 跑几个指标

- 对比一下 loss

- 看看示例输出

但一旦你进入创意生成类任务,比如春节祝福、文案创作、风格写作,这套方法几乎立刻失效。

因为你会发现:

- loss 在降,但输出没变好

- BLEU 在升,但读起来更像模板

- 指标很好,但用户说"没感觉"

于是问题变成了:

"走心"这种东西,

到底能不能被评估?

如果能,该怎么评?

「码上拜年」这个祝福 AI 的案例,恰好提供了一个非常真实、也非常典型的评估样本。

一、先承认现实:创意生成不存在"客观最优解"

在进入方法之前,必须先把一个前提说清楚:

春节祝福这种任务,

不存在唯一正确答案。

这意味着几件事:

- 不存在"标准参考文本"

- 不存在"绝对错误"的输出

- 很多输出在语法和逻辑上都没问题,但情感效果差异巨大

所以如果你还在问:

"我们能不能用一个分数,判断祝福好不好?"

那答案是:几乎不可能。

评估的目标,必须从"是否正确",转向:

是否符合我们期待的表达方式。

这也决定了后面的评估,一定是主观为主,但不能随意。

二、为什么传统指标在祝福场景里几乎没用

我们先快速把常见指标"判死刑",不是因为它们没价值,而是因为用错了地方。

1. loss:只能告诉你"模型更像训练数据了"

在祝福微调中,loss 的下降通常意味着:

- 模型更擅长复现训练语料的风格

- 对模板化表达更熟练

但它无法告诉你:

- 表达是否自然

- 是否过于用力

- 是否真的贴合关系

在「码上拜年」的实验中,你会看到一个很典型的现象:

loss 下降很平滑,

但"人味"的提升,

是跳跃式、主观感知很强的。

这说明 loss 在这里最多只能作为训练稳定性的参考。

2. BLEU / ROUGE:奖励"像",而不是"合适"

BLEU、ROUGE 本质上是在做一件事:

奖励和参考文本"像"的程度。

但在祝福这种任务里:

- 两句都很走心的祝福,可能完全不共享 n-gram

- 一句很模板的祝福,反而和训练语料高度相似

所以你会遇到一个非常尴尬的情况:

越模板,分数越高;

越自然,反而分数下降。

这不是指标的问题,而是任务不适配。

三、那我们到底在评估什么?

在创意生成类任务中,评估的目标,必须被重新定义。

在「码上拜年」这个案例中,一个"走心"的祝福,至少要满足三类条件:

- 没有事实错误

- 风格和关系是对的

- 读起来像"人说的",而不是"模型写的"

这三点,构成了后续评估维度的基础。

四、维度一:事实准确性(最低门槛,而不是亮点)

事实准确性在祝福任务中,并不是最重要的,但是最低门槛。

它主要检查的是:

- 是否捏造不存在的经历

- 是否错误理解用户提供的关系

- 是否把"客户"写成"朋友"

- 是否胡乱添加敏感或不合适的信息

在 Before / After 对比中,这个维度往往不是区分度最大的,但一旦出错,体验直接归零。

五、维度二:风格契合度(微调最容易体现价值的地方)

这是微调前后差异最明显、也最稳定的一个维度。

微调前常见问题

在未微调的通用模型中,祝福语常出现:

- 不管选什么风格,最后都变得"正式"

- 科技梗用得很生硬

- 商务祝福过于像公告

微调后变化

在「码上拜年」的 After 输出中,可以明显看到:

- 不同风格之间边界更清晰

- 轻松自然风不再"假装活泼"

- 科技风的梗更贴近真实技术语境

这类变化,很难用指标描述,但人一眼就能看出来。

六、维度三:表达自然度(最"玄",但最重要)

表达自然度,是最难定义、但用户最敏感的维度。

它通常体现在:

- 是否有明显的套话痕迹

- 句子长度是否自然

- 是否像真实聊天,而不是作文

- 情绪起伏是否合理

一个非常典型的评估方法是:

你愿不愿意不改一个字,直接发给对方?

在微调前,很多输出需要"人工润色";

而在微调后,很多输出已经可以直接用。

这正是"走心"的关键体现。

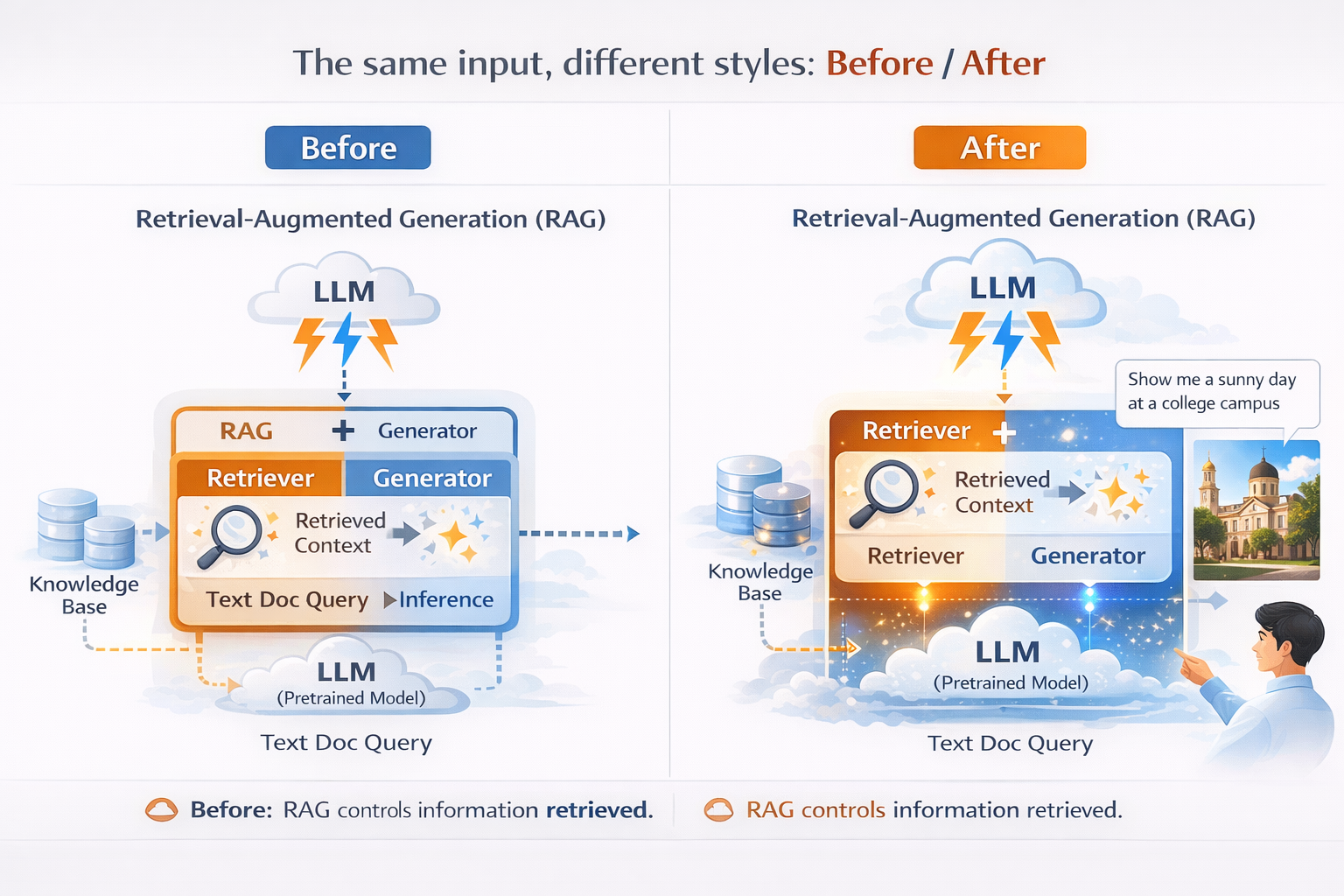

七、Before / After:用具体样例说话

以「码上拜年」中的一类场景为例(简化描述):

- 关系:多年同事

- 场合:微信拜年

- 风格:轻松自然

Before(通用模型)

"值此新春佳节之际,祝你新的一年身体健康、工作顺利、万事如意。"

问题不在对错,而在于:

- 谁都可以用

- 谁用都一样

- 完全感受不到"你们的关系"

After(微调模型)

"又一年了,想起去年一起熬夜改方案的那些天,真是又累又好笑。新的一年,祝你继续状态在线,少加班多快乐,项目顺顺利利!"

差异并不在"写得更漂亮",而在于:

- 具体

- 克制

- 像真实的人在说话

这正是评估要捕捉的东西。

八、如何把"主观评估"变得不那么随意

很多人一听"主观评估"就会担心:

"那不就很随意吗?"

其实不然。

在工程实践中,主观评估是可以被结构化的。

在祝福 AI 的评估中,一个可行的方法是:

- 固定一组输入场景

- 对比 base model 与微调模型

- 针对以下维度打分或打标签:

- 风格是否匹配

- 是否自然

- 是否具体

- 是否愿意直接发送

哪怕不做数值平均,这种结构化评估也能稳定反映趋势。

九、为什么"用户感受"才是最终评估标准

在「码上拜年」这个项目中,有一句总结非常重要:

祝福这件事,本质上不是"写得多好",

而是"有没有被感受到在用心"。

这意味着:

- 评估的终点不是模型

- 而是人

一个祝福 AI 是否成功,不取决于它写了多少漂亮句子,而取决于:

- 用户是否愿意用

- 是否愿意反复用

- 是否愿意把结果直接发出去

这些行为信号,往往比任何指标都真实。

在像「码上拜年」这样的创意生成任务中,效果评估往往比训练本身更难。用LLaMA-Factory Online进行微调前后的输出对照,更容易从风格一致性、自然度等维度判断:模型究竟是"更像数据",还是"更像人"。

总结:评估创意生成,评的不是模型,而是"人是否愿意用"

用一句话收尾这篇文章:

在创意生成类任务里,

最好的评估指标,

往往不是分数,

而是你愿不愿意相信这段话。

春节祝福 AI 这个案例,清楚地展示了一点:

- 微调是否成功

- 不在于模型变了多少

- 而在于输出是否开始承担"情绪责任"

当你开始用这样的标准去看模型效果,很多技术选择,反而会变得清晰起来。