在前面的章节中,我们已经系统掌握了神经网络的核心基础:从单神经元的加权和运算,到多层全连接网络(MLP)的前向传播逻辑;从损失函数的定义(MSE、交叉熵),到反向传播的梯度推导与参数更新(梯度下降、Adam优化器)。

但有一个最核心、最容易被忽略,却直接决定后续学习的问题,我们尚未深入拆解:神经网络到底在学习什么?权重矩阵的每一个数值,背后都代表着什么意义?

这一篇,我们将以最朴素的全连接网络(MLP)为载体,用数学推导+极简代码,彻底讲清"特征提取"的本质

一、什么是特征?学习特征的核心目的是什么?

在深度学习中,"特征"不是一个抽象概念,而是输入数据的某种可区分模式------对于图像任务(如MNIST手写数字识别),特征可以是像素的明暗差异、边缘、线段、拐角,甚至是数字的完整轮廓;对于文本任务,特征可以是词语的频次、语义关联。

学习特征的核心目的,是将原始输入(如28×28的像素矩阵)映射为一组"更具区分度"的向量,让模型能轻松通过这组向量,区分不同类别的数据(如区分数字"0"和"1")。

举个通俗的例子:我们看手写数字"5",不会去记住每一个像素的具体数值,而是会记住"它有一个拐角、一条竖线、一段弧线"------这些就是"5"的特征。神经网络的学习过程,本质上就是模仿人类的这种认知,自动从原始像素中提取出这些"可区分的特征"。

而这一切的基础,从单神经元就已经开始了。

二、数学视角:单神经元就是一个"基础特征检测器"

我们复用前文单神经元的数学表达式,拆解其"特征检测"的本质:

h=σ(∑i=1Dwixi+b)h = \sigma\left( \sum_{i=1}^D w_i x_i + b \right)h=σ(i=1∑Dwixi+b)

其中:xix_ixi 是输入(如MNIST图像展平后的单个像素值),wiw_iwi 是权重,bbb 是偏置,σ(⋅)\sigma(\cdot)σ(⋅) 是非线性激活函数(ReLU、Sigmoid等),hhh 是神经元的输出。

我们将这个公式拆成三步,每一步都对应"特征检测"的一个环节,彻底讲清权重和偏置的意义:

2.1 第一步:线性组合(∑i=1Dwixi\sum_{i=1}^D w_i x_i∑i=1Dwixi)------ 学习输入的"模式"

线性组合是特征提取的核心,权重 wiw_iwi 直接决定了"这个神经元关心输入的哪一部分"。我们以MNIST图像(28×28=784维输入)为例,用具体场景解读:

假设某个神经元的权重 wiw_iwi 满足以下规律(贴合图像边缘特征):

-

对应图像左侧区域的像素权重 wi=+1w_i = +1wi=+1;

-

对应图像中间区域的像素权重 wi=0w_i = 0wi=0;

-

对应图像右侧区域的像素权重 wi=−1w_i = -1wi=−1。

此时,线性组合的结果为:∑i=1784wixi=左侧像素总和−右侧像素总和\sum_{i=1}^{784} w_i x_i = \text{左侧像素总和} - \text{右侧像素总和}∑i=1784wixi=左侧像素总和−右侧像素总和。

这个线性组合的意义的的是:检测输入图像中"左侧亮、右侧暗"的模式------这正是图像"垂直边缘"的核心特征(左侧像素亮、右侧像素暗,二者差值大,线性组合结果就大)。

核心结论1:权重 wiw_iwi 的取值,决定了神经元"关注"输入的哪种模式;线性组合的结果,就是对这种模式的"匹配度评分"------评分越高,说明当前输入越符合该神经元所关注的模式。

2.2 第二步:偏置(bbb)------ 控制特征检测的"阈值"

偏置 bbb 的作用是调整线性组合结果的基线,避免因输入整体明暗差异,导致特征检测出现偏差。继续沿用上面的"垂直边缘检测"例子:

如果输入图像整体偏暗(所有像素值都很小),即使存在垂直边缘,线性组合的结果也可能很小;此时设置一个合适的偏置 bbb(如正数),可以抬高线性组合的基线,让"真实存在的边缘"能被有效检测到。

反之,如果输入图像整体偏亮,可设置负偏置,避免误检测(将非边缘区域判定为边缘)。

核心结论2:偏置 bbb 是特征检测的"阈值调节器",用于适配输入数据的整体分布,让神经元能更精准地检测目标模式。

值得一提的是,权重 wiw_iwi 和偏置 bbb 都是待学习参数,例子中只是给出了某种特定情况下的解读,至于网络能将参数学习成什么样,是不可预知的,我们只能知道大概可能的情况,也就是为什么深度学习的可解释性不高。

2.3 第三步:非线性激活(σ(⋅)\sigma(\cdot)σ(⋅))------ 强化特征的"区分度"

线性组合的结果是连续值,无法体现"是否检测到特征"的明确边界;而非线性激活函数的作用,就是将连续的"匹配度评分",转化为"是否符合特征"的离散响应(或强化响应差异)。

我们以最常用的ReLU激活函数(σ(x)=max(0,x)\sigma(x) = \max(0, x)σ(x)=max(0,x))为例,结合上面的垂直边缘检测:

-

当线性组合结果 > 0(存在垂直边缘,匹配度高):ReLU输出为线性组合结果,强化特征响应;

-

当线性组合结果 ≤ 0(无垂直边缘,匹配度低):ReLU输出为0,抑制非特征响应。

核心结论3:非线性激活函数打破了线性约束,让神经元能明确"是否检测到特征",同时强化不同输入的特征差异------这是后续多层网络能学习复杂特征的基础(即没有激活函数,多层网络等价于单层线性网络,无法学习复杂模式,我们在前面的章节中已经进行了证明)。

2.4 终极结论:单神经元的本质

每一个隐藏层神经元,都是一个"基础特征检测器":

wiw_iwi、bbb、hhh权重 决定"检测什么特征",偏置 决定"如何精准检测",激活输出 决定"是否检测到该特征"。

这就是神经网络学习特征的底层逻辑------没有玄学,只有"权重调整→模式匹配→非线性响应"的循环。

三、多层MLP:特征的层级化组合与抽象

单神经元只能检测"垂直边缘""水平边缘"这类最简单的底层特征;而多层全连接网络(MLP)的核心价值,就是将这些底层特征,逐层组合成更复杂、更具语义的高级特征------这正是深度学习"深度"的意义所在。

我们以"MNIST手写数字识别"为例,拆解多层MLP的特征层级(贴合实战,与后续CNN特征层级形成对比),每一层的特征都基于上一层的输出,逐步抽象:

3.1 第一层隐藏层(贴近输入):学习"底层基础特征"

第一层隐藏层的神经元,直接接收原始像素输入,因此学到的都是最基础、最局部的特征,主要包括:

-

边缘特征:垂直边缘、水平边缘、斜线边缘(对应前文单神经元的检测逻辑);

-

线段特征:短横线、短竖线、短斜线;

-

明暗特征:局部区域的亮斑、暗斑(对应像素的局部明暗差异)。

这一层的核心作用:将原始像素矩阵,转化为"基础特征矩阵"------每一个神经元的输出,都对应一个基础特征的检测结果。

3.2 第二层隐藏层(中间层):学习"组合特征"

第二层隐藏层的神经元,接收第一层的"基础特征输出"作为输入,因此学到的是"基础特征的组合模式",主要包括:

-

拐角特征:垂直边缘+水平边缘的组合(如数字"9"的右上角拐角);

-

轮廓片段特征:多条线段的组合(如数字"0"的上半部分弧线、数字"1"的竖线+短横线);

-

局部形状特征:小的封闭区域、连续的边缘组合。

这一层的核心作用:将零散的底层特征,组合成有意义的"特征片段",逐步接近数字的局部轮廓。

3.3 第三层隐藏层(贴近输出):学习"高级语义特征"

第三层隐藏层的神经元,接收第二层的"组合特征输出"作为输入,学到的是"组合特征的整体关联",也就是数字的"高级语义特征"------即能直接区分不同数字的完整特征模式,例如:

-

数字"0":封闭的圆形轮廓(多条弧线、边缘的组合);

-

数字"1":一条竖线+顶部/底部的短横线(线段的组合);

-

数字"5":一条竖线+一段弧线+一个拐角(多种组合特征的融合)。

这一层的核心作用:将局部的组合特征,融合成能直接用于分类的"全局特征"------输出的特征向量,已经能清晰区分不同类别的数字,后续通过输出层(全连接)映射为分类结果即可。

3.4 多层MLP的核心规律(关键衔接CNN)

通过上面的层级拆解,我们能总结出神经网络特征学习的通用规律,这也是后续CNN的核心逻辑基础:

特征学习是"层级化"的:从底层简单特征,到中层组合特征,再到高层语义特征,逐层抽象、逐层融合;每一层的特征,都是上一层特征的加权组合+非线性变换。

到这里,我们已经彻底讲清了MLP如何学习特征------但MLP的结构性缺陷,让它无法高效处理图像任务,这也正是我们后续需要引入CNN的核心原因。

四、MLP的致命缺陷

MLP能学习特征,能完成MNIST等简单图像任务,但它的两个结构性缺陷,让它在处理更复杂图像(如RGB彩色图、更大尺寸图像)时,效率极低、效果不佳------而这两个缺陷,恰好能被CNN完美解决,这也是"卷积能更高效提取图像特征"的核心前提。

4.1 缺陷1:全局连接,参数爆炸(效率极低)

MLP的隐藏层神经元,与上一层的所有输入神经元都完全连接(全局连接),导致参数数量呈指数级增长。我们以MNIST为例,做一个简单计算(贴合前文参数对比逻辑):

-

输入层:784个神经元(28×28);

-

第一层隐藏层:128个神经元;

-

仅这两层的权重参数数量:784 × 128 = 100352(约10万个);

-

若输入是3×224×224的RGB图像(150528维),第一层128个神经元,参数数量将达到150528×128 ≈ 1930万------参数过多会导致训练缓慢、过拟合严重。

核心问题:图像的特征(如边缘)是"局部的",一个神经元无需关注整个图像的所有像素,只需关注局部区域的像素即可------但MLP的全局连接,强制神经元关注所有像素,造成了大量的参数冗余。

4.2 缺陷2:破坏空间结构,丢失位置关联(效果不佳)

MLP处理图像时,必须先将28×28的二维像素矩阵,展平成784维的一维向量------这个操作,会彻底破坏像素之间的空间位置关系。

举个关键例子:数字"1"的竖线,可能在图像的左侧,也可能在右侧;展平后,左侧竖线的像素和右侧竖线的像素,在一维向量中处于完全不同的位置,MLP需要学习两组不同的权重来检测这两种情况------但实际上,它们都是"竖线"这一种特征,只是位置不同。

核心问题:图像的特征(边缘、纹理、轮廓),依赖于像素的空间位置关系(如"左侧亮、右侧暗"才能形成垂直边缘);MLP展平输入的操作,丢失了这种位置关联,导致它需要花费大量参数,去学习"相同特征、不同位置"的重复模式,效率极低,且泛化能力差。

通过上面的分析,我们可以提出一个自然的疑问:

既然MLP可以通过"加权和+非线性激活"学习特征,那我们能不能设计一种"局部版的加权和"------让神经元只关注输入的局部区域(避免全局连接,减少参数),同时保留输入的二维空间结构(避免展平,保留位置关联)?

答案,就是卷积(Convolution)。我们会在后续文章中继续讨论卷积

五、代码实战:直观展示MLP学到的特征

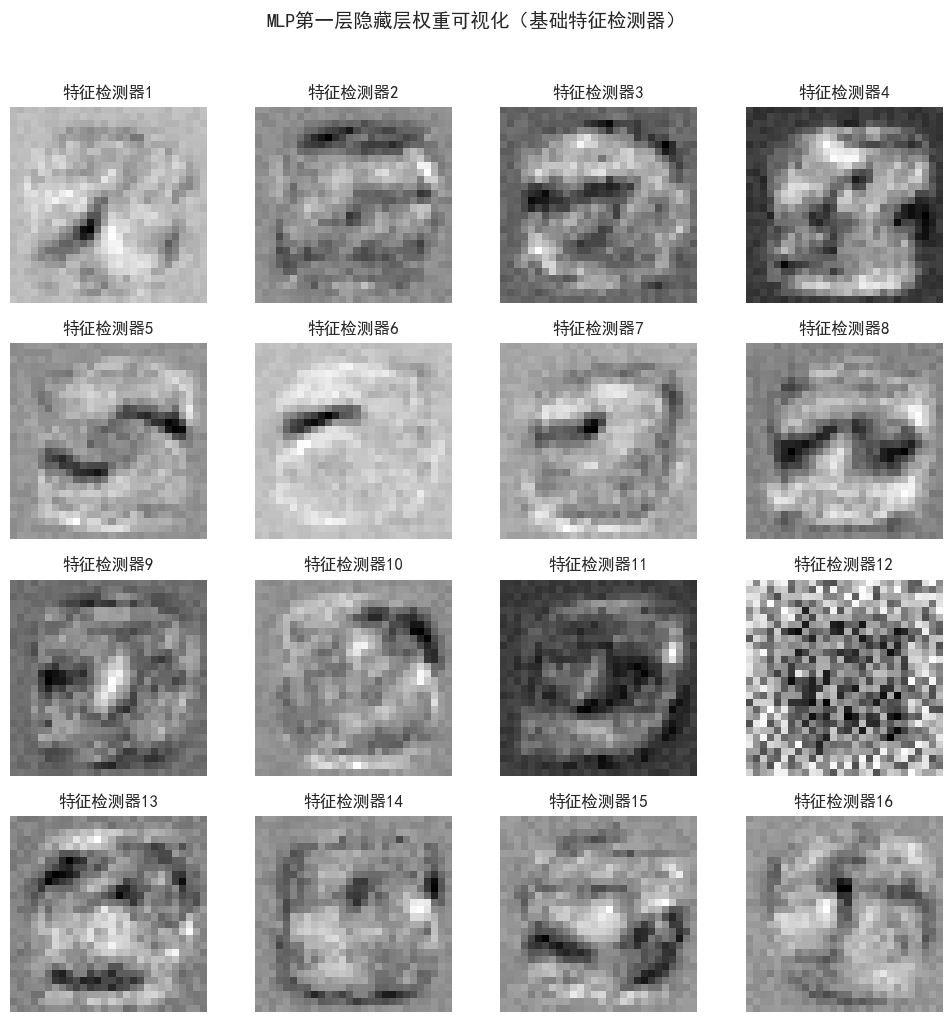

为了让大家更直观地感受"MLP确实能学到特征",我们用一段极简代码,训练一个小型MLP,然后可视化第一层隐藏层的权重------你会清晰地看到,权重的分布呈现出"边缘、明暗"等底层特征模式,与本文的数学推导完全一致。

训练网络

python

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import datasets, transforms

import matplotlib.pyplot as plt

# 设置matplotlib参数

plt.rcParams['figure.figsize'] = (12, 8)

plt.rcParams['font.size'] = 12

plt.style.use('seaborn-v0_8')

# 设置中文字体显示

plt.rcParams['font.sans-serif'] = ['SimHei', 'Microsoft YaHei', 'DejaVu Sans']

plt.rcParams['axes.unicode_minus'] = False

# 1. 数据预处理(极简适配,复用前文逻辑)

transform = transforms.Compose([

transforms.ToTensor(), # 转为Tensor,shape=(1,28,28)

transforms.Normalize((0.1307,), (0.3081,)) # MNIST标准化,提升训练稳定性

])

# 加载MNIST数据集(仅用训练集,重点验证特征学习,无需复杂测试)

train_dataset = datasets.MNIST('./data', train=True, download=True, transform=transform)

train_loader = torch.utils.data.DataLoader(train_dataset, batch_size=32, shuffle=True)

# 2. 构建小型MLP(仅两层隐藏层,便于可视化特征)

class TinyMLP(nn.Module):

def __init__(self):

super(TinyMLP, self).__init__()

# 第一层隐藏层:784→16(16个基础特征检测器),对应本文第一层特征学习

self.fc1 = nn.Linear(28*28, 16)

# 第二层隐藏层:16→8(8个组合特征检测器),对应本文第二层特征学习

self.fc2 = nn.Linear(16, 8)

# 输出层:8→10(MNIST 10分类)

self.fc3 = nn.Linear(8, 10)

# 激活函数(ReLU,复用前文知识,强化特征区分度)

self.relu = nn.ReLU()

def forward(self, x):

# 展平输入:(batch,1,28,28) → (batch,784)(MLP的固有操作,也是其缺陷)

x = x.flatten(1)

# 前向传播,对应本文特征层级:底层特征→组合特征→分类输出

x1 = self.relu(self.fc1(x)) # 第一层输出(底层特征)

x2 = self.relu(self.fc2(x1)) # 第二层输出(组合特征)

x = self.fc3(x2)

return x, x1, x2 # 返回各层输出,便于后续可视化

# 3. 初始化模型、损失函数、优化器(复用前文配置)

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

model = TinyMLP().to(device)

criterion = nn.CrossEntropyLoss() # 分类任务,适配MNIST

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 4. 简单训练(仅训练5个epoch,无需追求高精度,重点看特征学习效果)

epochs = 5

for epoch in range(epochs):

model.train()

total_loss = 0.0

for batch_idx, (inputs, labels) in enumerate(train_loader):

inputs, labels = inputs.to(device), labels.to(device)

# 前向传播,获取各层输出

outputs, x1, x2 = model(inputs)

# 计算损失、反向传播、参数更新

loss = criterion(outputs, labels)

optimizer.zero_grad()

loss.backward()

optimizer.step()

total_loss += loss.item()

# 每200个批次打印一次损失,监控训练状态

if batch_idx % 200 == 199:

print(f'[{epoch+1}, {batch_idx+1}] 训练损失: {total_loss/200:.4f}')

total_loss = 0.0

print("\nMLP训练完成,开始可视化第一层隐藏层权重(特征检测器)")

经过五个epoch后,损失如图

可视化

python

# 5. 可视化第一层隐藏层权重(核心环节,验证本文特征学习逻辑)

# 第一层权重shape:(16, 784) → 转为(16, 28, 28),对应16个28×28的特征检测器

fc1_weights = model.fc1.weight.data.cpu().view(16, 28, 28)

# 绘制16个特征检测器(4行4列)

plt.figure(figsize=(10, 10))

for i in range(16):

plt.subplot(4, 4, i+1)

# 显示权重分布(cmap='gray',明暗对应权重大小)

plt.imshow(fc1_weights[i], cmap='gray')

plt.title(f'特征检测器{i+1}')

plt.axis('off') # 关闭坐标轴,更清晰展示特征模式

plt.suptitle('MLP第一层隐藏层权重可视化(基础特征检测器)', y=1.02, fontsize=14)

plt.tight_layout()

plt.show()

# 补充:可视化第一层输出特征(随机选一张图像,看特征检测结果)

model.eval()

with torch.no_grad():

# 取一张测试图像

test_img, test_label = next(iter(train_loader))[0][0:1], next(iter(train_loader))[1][0]

test_img = test_img.to(device)

# 获取各层输出

_, x1, _ = model(test_img)

# 第一层输出shape:(1,16) → 转为(16,1,1),便于绘制

x1_feat = x1.cpu().view(16, 1, 1).repeat(1, 28, 28) # 重复成28×28,便于显示

# 归一化x1_feat到0-1范围,提升可视化区分度

x1_feat_min = x1_feat.min()

x1_feat_max = x1_feat.max()

if x1_feat_max > x1_feat_min:

x1_feat = (x1_feat - x1_feat_min) / (x1_feat_max - x1_feat_min)

else:

x1_feat = torch.zeros_like(x1_feat)

# 绘制原始图像和对应的16个特征响应

plt.figure(figsize=(12, 8))

# 原始图像

plt.subplot(4, 5, 1)

plt.imshow(test_img.cpu().squeeze(), cmap='gray')

plt.title(f'原始图像(数字{test_label.item()})')

plt.axis('off')

# 16个特征响应

for i in range(16):

plt.subplot(4, 5, i+2)

plt.imshow(x1_feat[i], cmap='gray', vmin=0, vmax=1)

plt.title(f'特征{i+1}响应')

plt.axis('off')

plt.suptitle('MLP第一层特征响应可视化(检测到特征则响应强)', y=1.02, fontsize=14)

plt.tight_layout()

plt.show()

代码结果解读

(注意:代码中只可视化了第一层,因此数字分类结果是不可靠的)

-

权重可视化结果:可以清晰地看到,16个特征检测器(权重矩阵)呈现出明显的"边缘、明暗"模式------有的权重矩阵左侧亮、右侧暗(垂直边缘检测器),有的呈现水平明暗差异(水平边缘检测器),有的呈现局部亮斑(明暗特征检测器),与本文第二节的数学推导完全一致,证明MLP确实能学到底层基础特征。

-

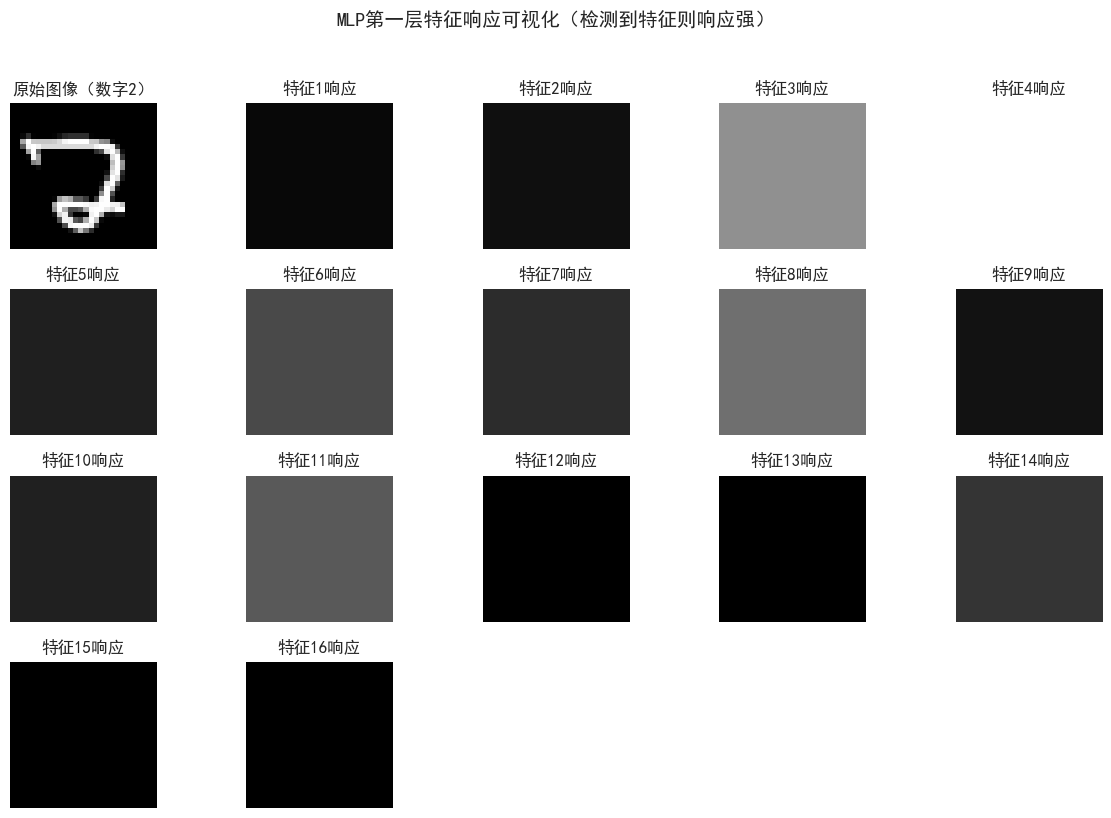

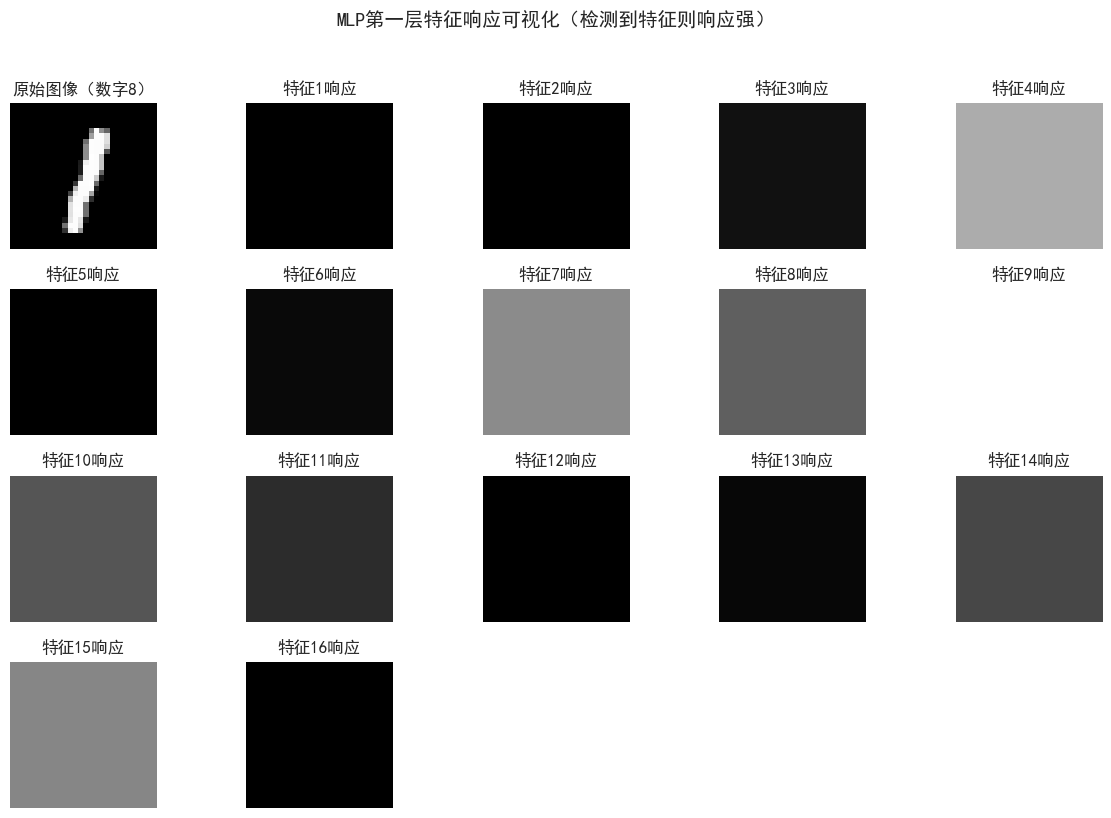

特征响应可视化结果:原始图像输入后,与特征检测器匹配度高的区域,特征响应(亮度)更强------例如,若图像有垂直边缘,对应的垂直边缘检测器响应会明显更亮,这正是"线性组合+ReLU激活"的作用效果,验证了"特征检测"的逻辑。

-

关键启示:这段代码直观证明了"MLP能学习特征",但同时也能感受到MLP的缺陷------我们需要16个特征检测器,去学习不同位置、不同方向的边缘,造成了参数冗余;而后续的卷积,通过"参数共享",只用一个卷积核,就能检测整个图像中所有位置的同一种边缘,完美解决这一问题。

六、总结

本文核心是解决"神经网络为什么能学习特征"这一底层问题,为后续铺垫基础,重点掌握以下三个核心知识点:

-

单神经元的特征检测逻辑:权重决定"检测什么特征",偏置控制"检测阈值",激活函数强化"特征区分度",本质是"线性组合+非线性激活"的特征匹配过程;

-

多层MLP的特征层级:从底层基础特征(边缘、线段),到中层组合特征(拐角、轮廓片段),再到高层语义特征(数字整体结构),逐层抽象、逐层融合;

-

MLP的致命缺陷:全局连接导致参数爆炸,输入展平导致空间结构丢失------这两个缺陷,正是CNN出现的原因,也是卷积能更高效提取图像特征的核心前提。