Ollama 是一个开源的、本地运行的 AI 聊天模型,允许在自己的设备上运行 LLM,无需依赖云服务。它支持多种 LLM。目前Ollama library已经支持Qwen2,可以直接使用。

首先安装ollama, 访问官网 下载 ollama 对应版本 Download Ollama on macOS

windows下选择exe ,然后运行安装,安装完成后。添加一个系统环境变量OLLAMA_MODELS,否则Ollama 会将模型默认下载到C盘,比如我这里指了D盘:

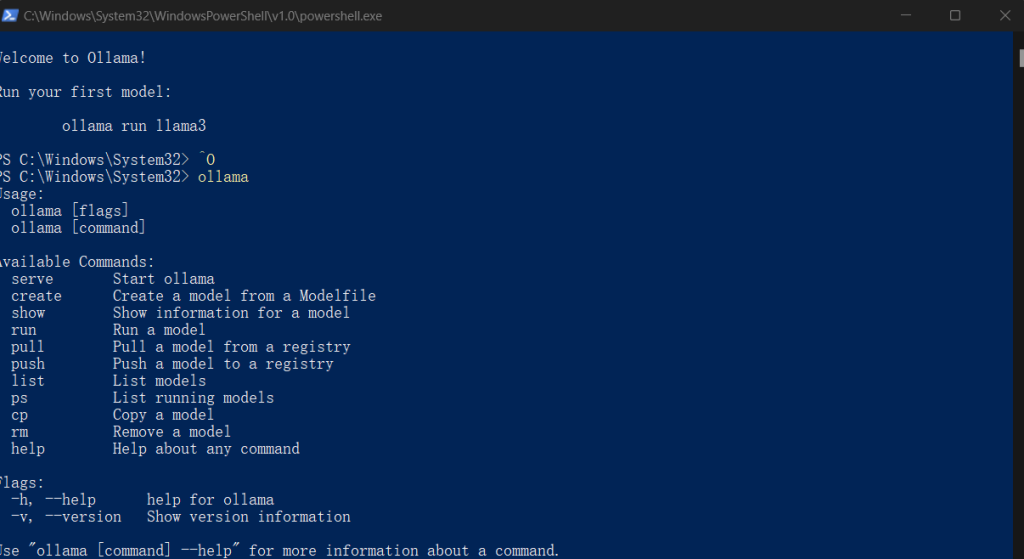

然后打开powershell 运行一下,注意不是CMD是powershell ,看是否安装成功

然后我们安装qwen大模型

ollama run qwen2:1.5b1.5b就是对应安装Qwen2 1.5b大模型,如果使用7b 就是 ollama run qwen2:7b

运行完成后就可以和大模型对话了,不过ollama 只有命令行模式运行,这里我下载了chatbox软件来运行,打开软件 模型设置选择ollama 以及 对应的ollama模型。

运行结果: