一、双向循环神经网络

(1)诞生背景

双向循环神经网络 (Bidirectional Recurrenct Neural Network, BRNN )是在深度学习领域发展起来的一种特殊类型的循环神经网络(RNN),它诞生的背景是为了解决传统RNN只能单向处理序列信息的缺点。

命令实体识别为例

命令实体识别为例

上图例子中,"teddy"之前信息(上文)无法帮助模型判断"teddy"是不是人名,只有在得知后续的信息(下文)才能做出准确的判断。

传统RNN在处理序列数据时,存在这信息流动限制,只能从前向后或者从后向前传播信息。这意味着在给定时间点,模型的决策仅基于到目前为止的过去信息。这对于那些需要同时理解序列前后上下文的任务来说是个限制。

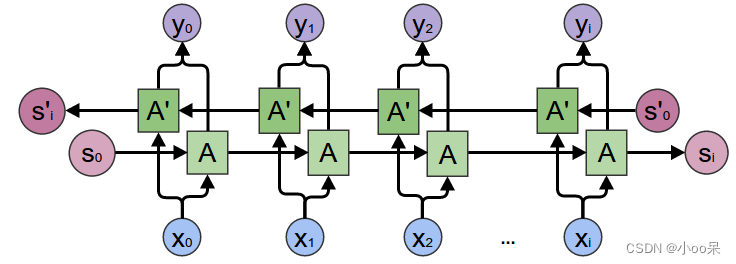

(2)BRNN的网络结构

双向循环神经网络(BRNN)的基本结构包含两个并行的循环神经网络层,一个负责正向传播信息(从过去到未来),另一个负责逆向传播信息(从未来到过去)。这两个方向的RNN共享同一个隐藏层的维度,但它们的权重通常不共享。

对上面图中BRNN典型架构进行说明,建议看的时候对照数学符号解释:

① 输入层(Input Layer):接收序列数据,每个时间步有一个输入向量。

② 正向循环层(Forward RNN Layer):这个层中的单元从序列的第一个元素开始,逐个时间步向前传播信息。每个时间步,它会根据当前输入和前一时间步的隐藏状态计算新的隐藏状态。

表示时间步

的输入。

③ 逆向循环层(Backward RNN Layer):与正向层平行运行,但方向相反,从序列的最后一个元素开始,向序列的起始处传播信息。同样,每个时间步,它根据当前输入(实际上是序列中的倒数第几个元素)和前一时间步(未来时间步的逆向看)的隐藏状态更新隐藏状态。

④ 合并层(Merge Layer):在每个时间步,正向和逆向隐藏状态会被合并,常见的合并方式有拼接、求和或乘积等,以形成一个综合的上下文向量。这个向量包含了当前位置基于整个序列上下文的信息。

⑤ 输出层(Output Layer):基于合并后的上下文向量,输出层负责生成最终的预测或分类结果。这可以通过全连接层加上适当的激活函数(如softmax用于多分类问题)来实现。

其中是输出层的激活函数,它常常是 softmax 函数用于分类任务。

和

是隐藏状态到输出的权重矩阵,

是输出层的偏置项。

| 符号 | 解释 |

|---|---|

| 时间步 |

|

| 时间步 |

|

| 时间步 |

|

| 正向 RNN 的激活函数 | |

| 反向 RNN 的激活函数 | |

| 输入到正向隐藏层权重 | |

| 正向隐藏层自身循环权重 | |

| 输入到反向隐藏层权重 | |

| 反向隐藏层自身循环权重 | |

| 正向隐藏层偏置项 | |

| 反向隐藏层偏置项 | |

| 时间步 |

|

| 从正向隐藏状态到输出的权重矩阵 | |

| 从反向隐藏状态到输出的权重矩阵 | |

| 输出层偏置项 | |

| 输出层激活函数,通常为 softmax | |

| [数学符号解释] |

(3)使用领域

双向循环神经网络的提出,是为了更有效地捕获和利用序列数据中的上下文信息,BRNN多使用在诸如一下场景中:

-

自然语言处理:在理解一句话的语义时,往往需要同时考虑前面的词(前向上下文)和后面的词(后向上下文)。比如情感分析任务中,"昨天晚上我吃了一顿美味的火锅,今天早上就拉肚子了。"在"火锅"的上文中我们得知,火锅是"美味的",情感是正向的。在下文中我们得知"拉肚子",情感是负向的。如果我们仅仅考上文,就无法准确的判断。

-

语音识别:在语音信号处理中,一个音素的准确识别可能依赖于其前后相邻的音素特征,双向结构有助于提高识别精度。

-

机器翻译:翻译任务要求模型理解源语言句子的整体含义,这通常需要综合考虑句子开头和结尾的信息。BRNN能够提供更为全面的上下文理解能力。

二、深度循环神经网络

(1)DRNN的定义

深度循环神经网络 (Deep Recurrent Neural Network,简称DRNN )是一种扩展了传统循环神经网络(RNN)结构的深度学习模型,特别适合处理长序列数据和复杂的时序依赖问题。在DRNN中,通过堆叠多个循环层,使得模型能够捕捉到更高层次的抽象特征和更长距离的时间依赖关系。

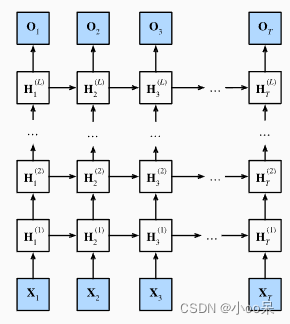

(2)DRNN的网络结构

在深度RNN中,每个时间步的输入会首先通过第一层循环网络,其输出会成为第二层循环网络的输入,这一过程会持续到达最顶层的循环网络。每一层都可以学习到不同程度的序列抽象,更底层的网络可能会学习到一些局部模式或特征,而更高层的网络则可能会捕捉到更加全局或抽象的信息。

深度循环神经网络结构

深度循环神经网络结构

(3)DRNN的优缺点

**优点:**这种架构允许模型捕获数据在不同时间尺度上的复杂性,因为每一层都可以捕捉到序列数据在不同时间尺度上的特征,这使得深度RNN在处理复杂的序列任务(如机器翻译、语音识别或长文本生成)时,比单层RNN具有更强的表示能力。

**缺点:**然而,深度RNN也引入了更多的复杂性和训练难度,例如更容易出现梯度消失或梯度爆炸的问题,因此通常需要采用一些高级技术(如梯度裁剪、层归一化、残差连接或使用LSTM、GRU等门控循环单元)来稳定训练过程。