随着大模型(LLMs)的快速发展,将视觉模态整合进LLMs以提升模型的交互能力已成为研究的热点。这些大型视觉语言模型(LVLMs)不仅展现出强大的视觉感知和理解能力,还能够通过对话与用户互动,提供更丰富的交互体验。然而,现有的评估工作存在一些问题,可能会误导对LVLMs实际多模态能力的理解。

在评估LVLMs时,一个关键的挑战是确保正确答案只能基于对视觉内容的深入理解而得出。然而,许多现有评估样本缺乏必要的视觉依赖性,即使没有图像输入,也能得出正确答案。例如,一些问题的答案直接包含在问题中,或者可以通过LLMs内部丰富的世界知识来轻松回答。

另一个问题是在LLM和LVLM的训练过程中存在无意的数据泄露。这意味着即使没有视觉内容,一些视觉必要的问题仍然可以通过"回忆"训练数据来正确回答。这种情况在LVLM训练中尤为严重,表明在大规模训练数据中可能无意中记忆了这些样本。

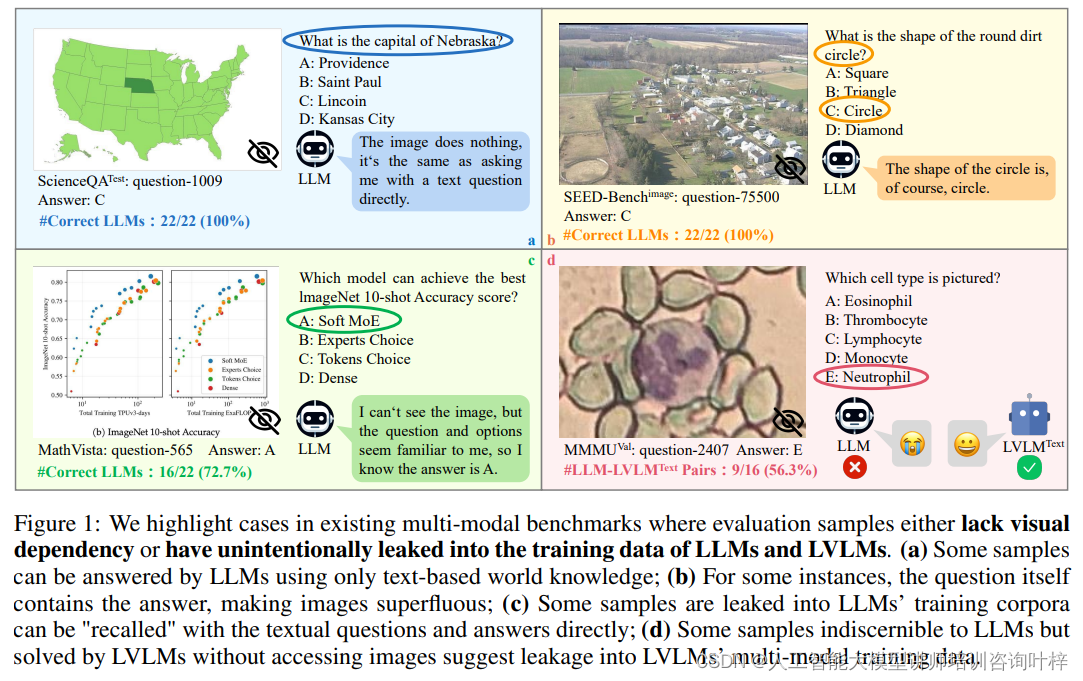

Figure 1 说明两个在评估大型视觉语言模型(LVLMs)时被忽视的主要问题:视觉依赖性的缺失和训练数据中的无意数据泄露。

-

视觉依赖性的缺失:如图中(a)和(b)所示,某些评估样本并不需要视觉信息即可被语言模型(LLMs)正确回答。例如,在(a)中,一些问题仅通过文本信息即可解答,因为问题中已经包含了足够的线索或答案本身。在(b)中,问题的表述中已经隐含了答案,使得图像信息变得多余。

-

训练数据中的无意数据泄露:如图中(c)和(d)所示,一些情况下,模型似乎能够在没有视觉输入的情况下回答需要视觉信息的问题,这表明模型可能在训练过程中已经接触过这些样本,因此在评估时能够"回忆"起答案。在(c)中,一些样本可能已经包含在了LLMs的训练数据中,因此模型可以直接回忆出正确答案。而在(d)中,即使LLMs无法正确回答的问题,LVLMs却能够在没有图像的情况下给出正确答案,这暗示了LVLMs的多模态训练数据中可能也存在泄露。

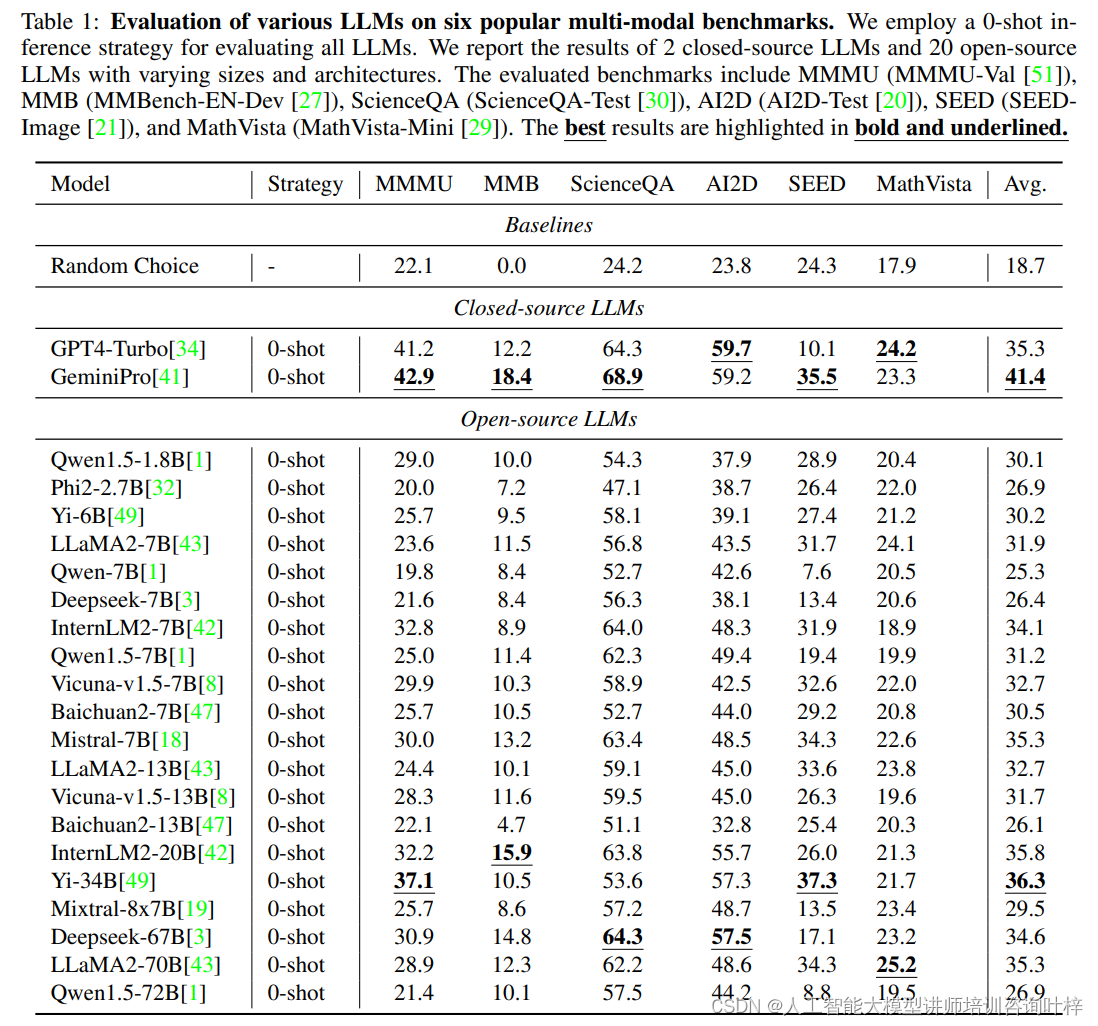

Table 1展示了在六个流行的多模态基准测试上,使用0-shot推理策略对各种大型语言模型(LLMs)进行评估的结果。这些结果用于揭示现有评估方法中的问题,即许多评估样本并不需要视觉内容,以及在LLM和LVLM训练中存在无意的数据泄露问题。

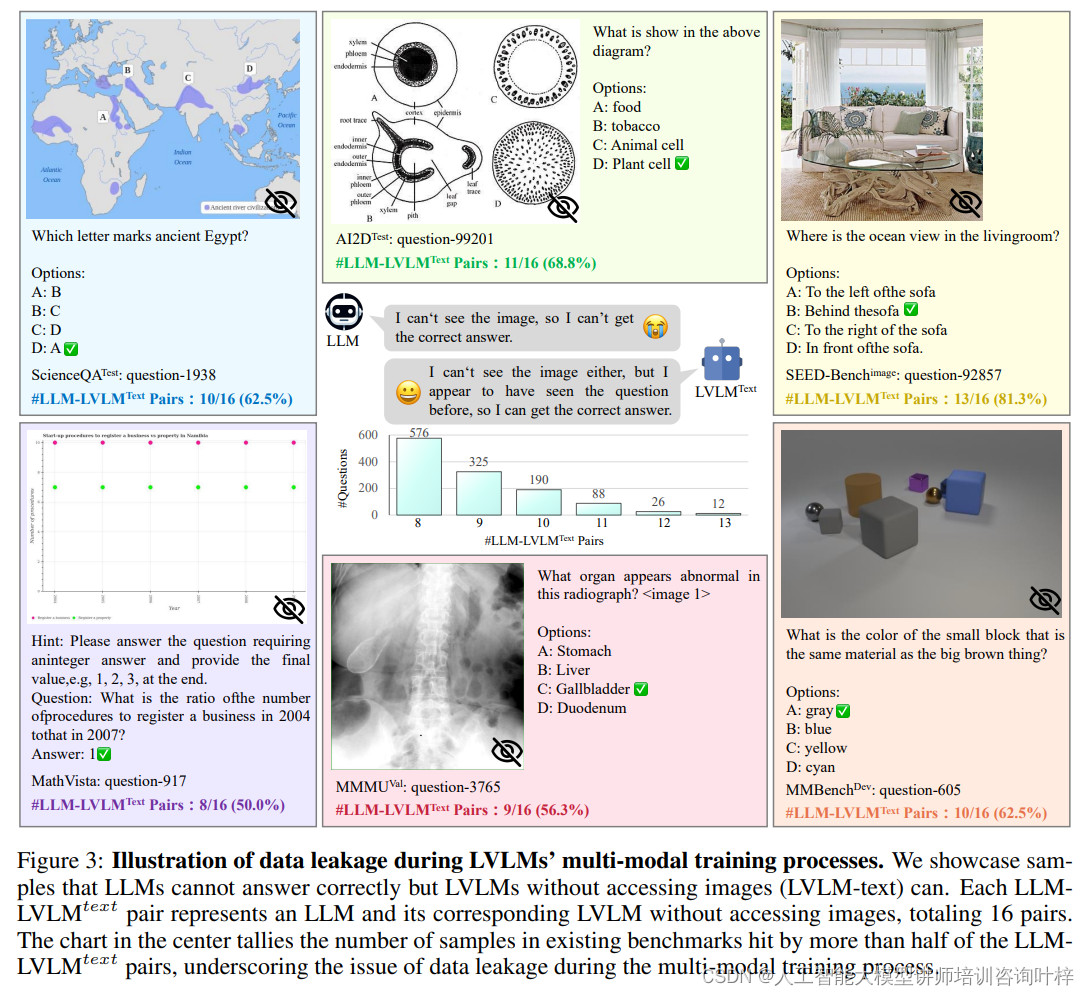

Figure 3这个图表通过对比仅使用文本信息的LVLMs(称为LVLM-text)和它们对应的大型语言模型(LLMs)的表现,来揭示数据泄露问题。在这个实验中,共有16对LLM和LVLM-text配对。图中展示了一些LLMs无法正确回答的问题样本,但是LVLM-text却能够正确回答。这表明即使没有图像输入,LVLMs依然能够给出正确答案,这很可能是由于它们在训练过程中不小心记住了这些样本,即发生了数据泄露。图表的中心部分统计了现有基准测试中被超过一半的LLM-LVLM-text配对正确回答的样本数量。这个数字强调了在多模态训练过程中数据泄露问题的严重性。如果一个样本被多个模型作为正确答案"回忆"起来,这可能意味着该样本在模型的训练数据中出现过,从而导致在评估时这些模型能够不依赖于图像内容而给出正确答案。

Figure 3这个图表通过对比仅使用文本信息的LVLMs(称为LVLM-text)和它们对应的大型语言模型(LLMs)的表现,来揭示数据泄露问题。在这个实验中,共有16对LLM和LVLM-text配对。图中展示了一些LLMs无法正确回答的问题样本,但是LVLM-text却能够正确回答。这表明即使没有图像输入,LVLMs依然能够给出正确答案,这很可能是由于它们在训练过程中不小心记住了这些样本,即发生了数据泄露。图表的中心部分统计了现有基准测试中被超过一半的LLM-LVLM-text配对正确回答的样本数量。这个数字强调了在多模态训练过程中数据泄露问题的严重性。如果一个样本被多个模型作为正确答案"回忆"起来,这可能意味着该样本在模型的训练数据中出现过,从而导致在评估时这些模型能够不依赖于图像内容而给出正确答案。

这些问题的存在不仅影响了评估结果的准确性,也可能误导后续的研究工作。为了更准确地评估LVLMs的多模态能力,需要设计出能够确保视觉内容必要性和减少数据泄露的评估方法。这包括精心设计评估样本,确保每个问题都需要对视觉内容的深入理解才能回答,并且在训练过程中采取措施防止数据泄露,确保模型的答案是真正基于对视觉和语言信息的整合处理得出的。

多模态基准测试MMStar

数据筛选

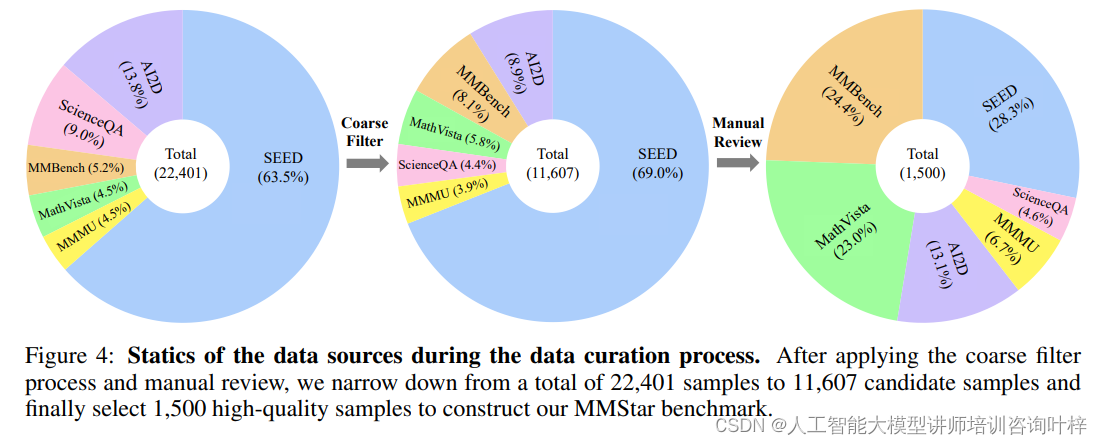

在构建MMStar这一多模态基准测试时,面临的首要任务是确保所选样本真正需要视觉内容来得出正确答案,并且要最大限度地减少数据泄露的风险。为此,研究者设计了一个包含自动化筛选和人工审核的数据筛选流程。

在自动化筛选阶段,研究者从现有的基准测试中选取了大量样本,并利用一组强大的LLMs作为检查员来初步评估这些样本。研究者采用了两种闭源的API(GPT4-Turbo和GeminiPro)和六种领先的开源模型,如LLaMA-70B、Qwen-1.5-72B等,对样本进行评估。这一步骤的目的是识别出那些不需要视觉内容就能被LLMs正确回答的样本,因为这些样本可能已经无意中包含在了LLMs的训练语料库中,或者它们的视觉内容对于回答问题并不重要。

自动化筛选后,得到了一个初步的样本池。接下来,为了进一步提高样本的质量,研究者引入了人工审核。在这一阶段,三位专家对样本进行了细致的审查,以确保每个样本都严格满足以下三个标准:视觉依赖性,即正确答案必须基于对图像内容的理解;最小化数据泄露,即样本不应在LLMs的训练数据中出现过;以及需要高级多模态能力,即样本应挑战模型在视觉和语言整合方面的高级能力。

通过人工审核从初步筛选后的样本池中精选出了1500个高质量的样本。这些样本不仅覆盖了不同的难度级别,而且要求模型必须运用其多模态能力来解答。通过人工审核确保了MMStar基准测试的公正性和全面性,使其能够真正考验LVLMs的多模态能力。

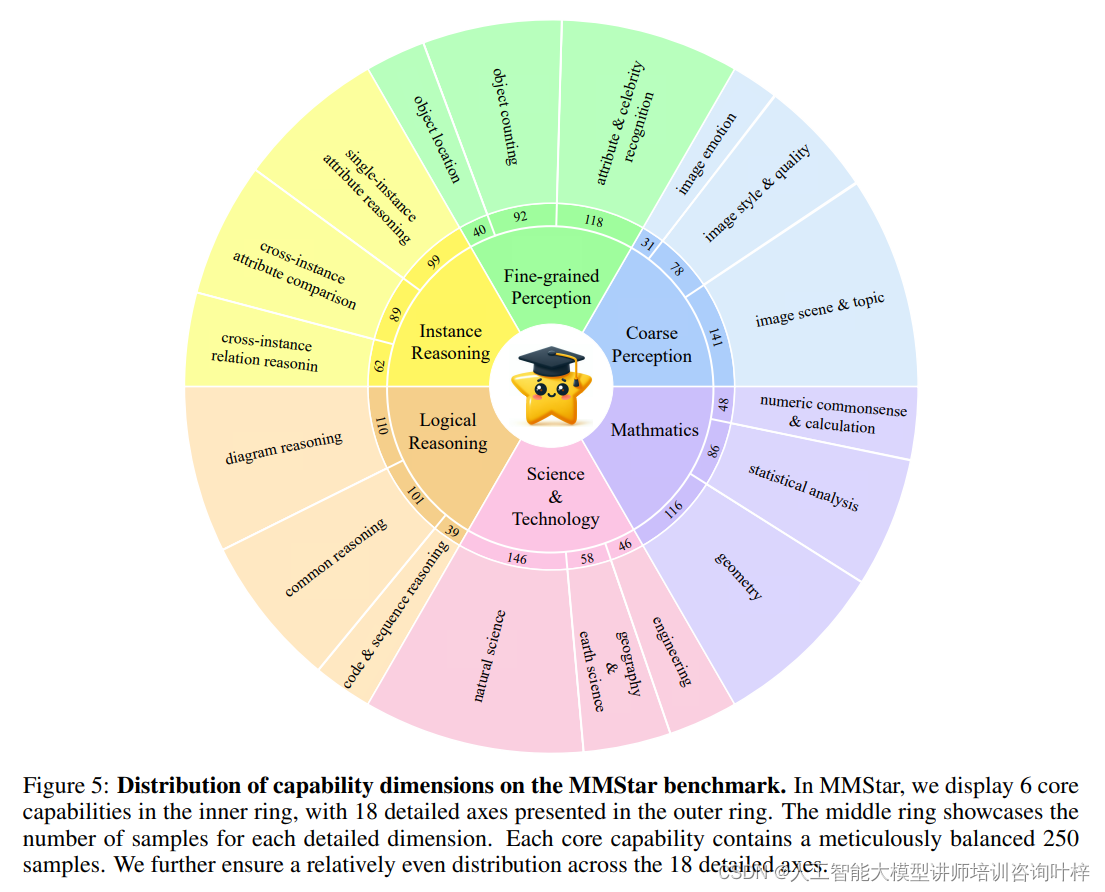

核心能力

基准测试包含了六个核心能力维度和十八个详细轴。这些维度旨在覆盖LVLMs在理解和处理视觉及语言信息时所展现的关键技能。

- 在粗略感知(Coarse Perception, CP)维度中,研究者们着重于模型对图像整体特征和主题的理解能力。这要求模型能够识别图像的风格、场景和情感,而无需深入细节。例如,模型可能需要判断一张图片是风景照还是肖像照,或者识别图片所传达的总体情绪。

- 精细感知(Fine-grained Perception, FP)维度则要求模型展现对图像细节的深入理解,这包括对图像中特定属性和名人的识别、物体的位置以及数量的准确统计。这个维度考验模型是否能够识别图像中的细微差别,例如区分不同种类的动物或植物。

- 实例推理(Instance Reasoning, IR)维度挑战模型对图像中单个或多个对象属性及其相互关系的分析能力。这要求模型不仅识别对象,还要理解对象间的关系,如一个物体相对于另一个物体的位置,或者它们之间的功能联系。

- 逻辑推理(Logical Reasoning, LR)维度则更侧重于模型使用逻辑和推理来解释视觉内容的能力。这包括对图表的理解、代码和序列推理以及一般性推理任务。

- 科学与技术(Science & Technology, ST)维度结合了自然科学、工程和地理及地球科学等领域的知识,要求模型能够将视觉信息与这些领域的专业知识结合起来,以解决相关问题。

- 数学(Mathematics, MA)维度评估模型在处理数量常识、几何和统计分析等数学相关问题时的能力。这个维度考验模型是否能够准确理解和应用数学概念来解决视觉场景中的问题。

通过这六个维度及其对应的详细轴,MMStar基准测试能够全面地考验LVLMs在多模态任务中的表现,从而为研究者提供了一个深入理解和评估模型性能的工具。

多模态增益/泄露度量

为了评估LVLMs在多模态训练中的实际性能提升和数据泄露程度,他们提出了两个新的度量指标:多模态增益(MG)和多模态泄露(ML)。

多模态增益(MG)指标旨在量化模型在接收到视觉信息时相对于仅使用文本信息时的性能提升。具体来说,MG是通过计算模型在有视觉输入(Sv)和没有视觉输入(Swv)时的得分差异来得出的。如果模型在整合视觉信息时表现出显著的性能提升,那么MG值将会是正值,这表明模型能够有效地利用视觉信息来提高其在多模态任务中的表现。

多模态泄露(ML)指标用于评估模型在训练过程中可能无意中记忆的数据的程度。ML是通过比较模型在没有视觉输入时的得分(Swv)和其基础语言模型(LLM)在相同条件下的得分(St)来计算的。如果模型在没有视觉输入的情况下得分高于其基础语言模型,这可能表明模型在训练过程中已经接触过类似的数据,从而在评估时能够"回忆"起正确答案,这并不是模型真正理解和推理能力的表现。

通过这两个指标,研究者们能够更准确地评估LVLMs的多模态能力,并识别出训练数据中可能存在的问题。MG和ML指标为研究者提供了一种方法,以确保模型的评估是基于其真正的多模态处理能力,而不是依赖于对特定数据的记忆。

实验

我们评估了包括两个闭源和二十个开源的LLMs和LVLMs。实验使用了0-shot和2-shot策略,并开发了启发式匹配规则来计算准确性。

MMStar的评估结果

在MMStar基准测试的评估中,研究者们发现即便是性能最优的模型,其平均得分也未能超过60%,这一结果揭示了现有大型视觉语言模型(LVLMs)在多模态能力上存在显著的提升空间。这表明尽管LVLMs在视觉和语言的结合处理上取得了一定的进展,但要在复杂和多样化的多模态任务中达到高准确率,仍有较长的路要走。

评估结果还揭示了LVLMs在多模态推理、逻辑推理、科学技术和数学等核心能力方面的挑战尤为突出。这些问题的解决需要模型不仅要对视觉信息有深刻的理解,还要能够将这些信息与语言信息有效结合,进行复杂的逻辑推导和数学计算。研究者们观察到,即使是设计得相当精巧的模型,在这些高难度的任务上也难以取得令人满意的成绩。

值得注意的是,一些规模较小的LVLMs在特定领域或任务上表现出了不俗的能力,这挑战了"模型规模越大性能越好"的传统观念。这表明在多模态任务中,模型的设计和训练策略可能比规模更为关键。研究者们认为,这为未来LVLMs的研究方向提供了新的思路,即通过精心设计的模型架构和训练方法,即使是较小规模的模型也有可能在多模态任务中取得优异的性能。

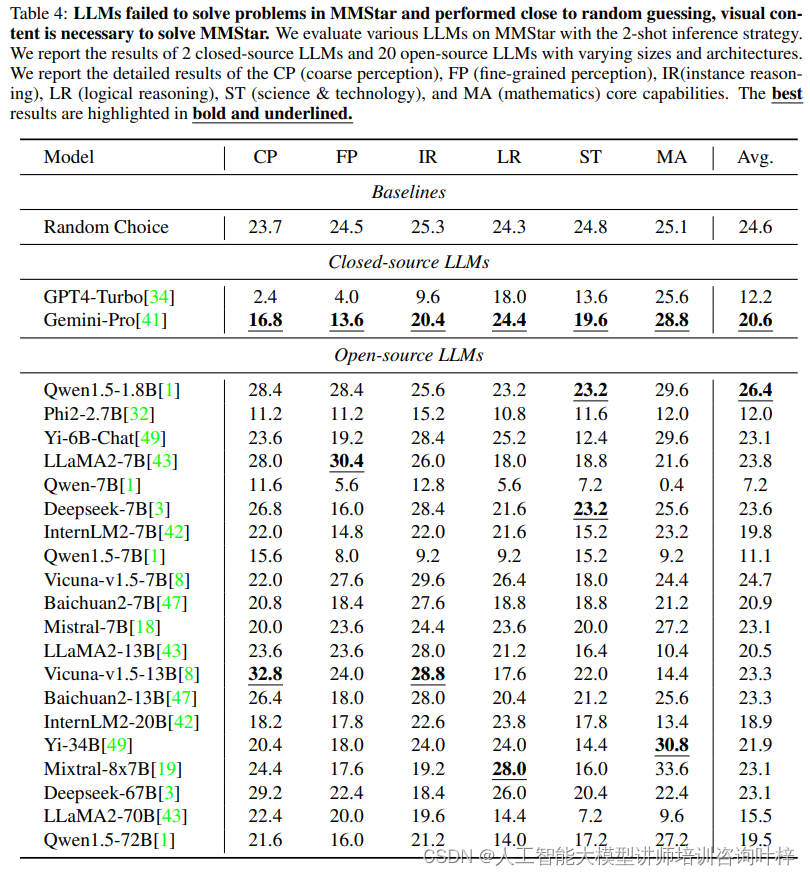

Table 4中研究者们使用了两种闭源 LLMs(GPT4-Turbo 和 GeminiPro)以及多种不同规模和架构的开源 LLMs。这些模型在 MMStar 上的表现几乎与随机猜测无异,这一发现验证了 MMStar 样本具有显著的视觉依赖性,并且从 LLMs 的训练数据中泄露的信息很少。值得注意的是,规模最小的模型 Qwen1.5-1.8B 在这些模型中表现最佳,这可能是因为它受到的安全限制较少,从而减少了拒绝回答的情况。

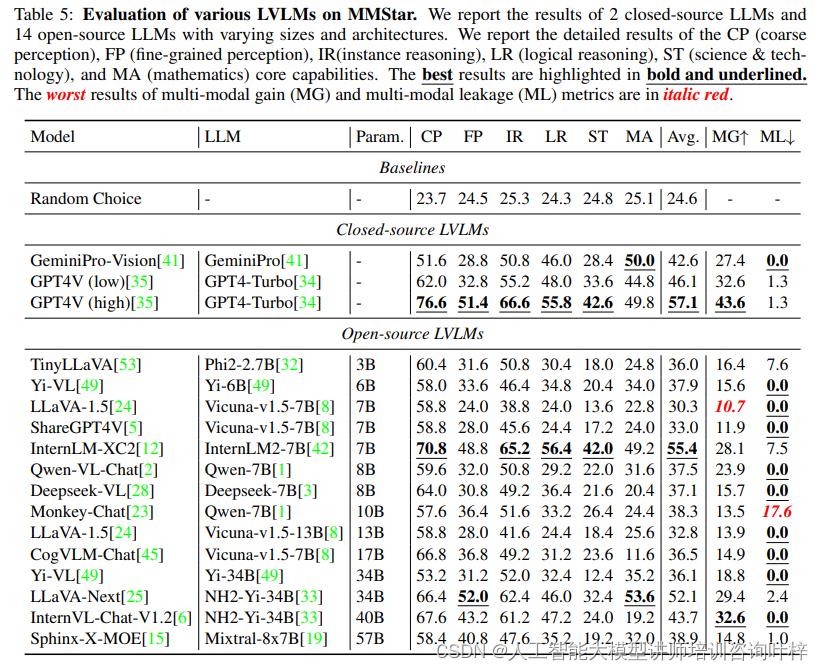

Table 5 评估 LVLMs,包括两种闭源 LVLMs(GPT4V 和 GeminiPro-Vision)和十四种开源 LVLMs。结果显示,具有高分辨率设置的 GPT4V 在所有 LVLMs 中平均得分最高,达到了 57.1%。这表明提高图像分辨率和图像标记的数量可以显著提升模型的得分。在开源 LVLMs 中,InternLM-XC2 取得了令人印象深刻的得分,而 LLaVA-Next 甚至在数学核心能力上超越了 GPT4V 和 GeminiPro-Vision。这些结果强调了高质量标注数据对于提升 LVLMs 性能的重要性,并揭示了即使是较小规模的模型,通过精心设计和训练也能在多模态任务中展现出竞争力。

MG/ML度量结果分析

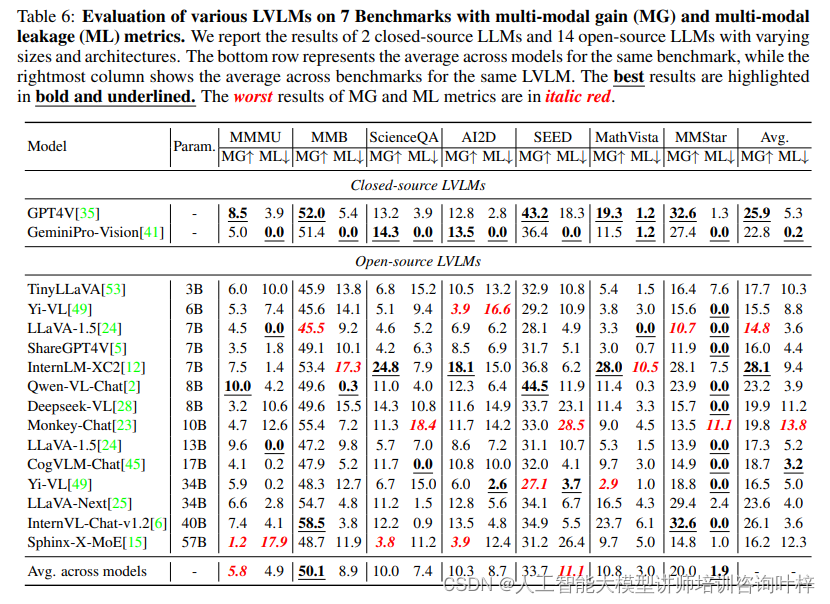

研究者们通过对六个多模态基准测试和MMStar基准测试的多模态增益(MG)和多模态泄露(ML)度量结果进行分析,为研究社区提供了深刻的见解。这些见解对于如何收集多模态训练数据和制定新的基准测试具有重要的指导意义。

MG/ML度量结果显示,不同模型在多模态训练中的数据泄露程度存在显著差异。一些模型在多模态训练中表现出了较高的数据泄露,这意味着它们在评估时可能过多地依赖于对训练数据的记忆,而不是真正的多模态理解能力。这种数据泄露问题可能会导致评估结果的不公平,因为它不能真实反映模型在面对新、未见数据时的性能。

研究者们发现某些模型在MMBench基准测试中的平均多模态增益较高,这表明这些模型的训练数据与MMBench的领域有较大的重叠。而另一些模型在MMMU基准测试中的平均多模态增益较低,这可能意味着这些模型的训练数据与MMMU涵盖的领域重叠较少,或者模型在这些领域的多模态能力有待提高。

MMStar基准测试特意设计来最小化数据泄露,其结果显示了较低的平均多模态泄露,这为比较不同模型提供了一个更加公平和可靠的环境。研究者们认为,评估模型时应考虑MG和ML指标,这有助于研究社区更准确地理解模型的多模态能力,并为未来的模型改进和基准测试设计提供了科学依据。

研究者们还发现,即使是在相同架构下,使用高质量的标注数据的模型在MG/ML度量上也表现更好,这强调了高质量训练数据对于提升LVLMs性能的重要性。这些发现促使研究者们在未来的工作中进一步探索如何优化多模态训练数据的收集和处理,以及如何设计能够更全面评估LVLMs多模态能力的基准测试。

Table 6 展示了在七个多模态基准测试中,对不同大型视觉语言模型(LVLMs)的多模态增益(MG)和多模态泄露(ML)的评估结果。研究者们分析了两个闭源和十四个开源的LVLMs,它们在规模和架构上各不相同。表格中,每一行代表一个模型在各个基准测试上的表现,而每一列则对应不同基准测试中模型的平均MG和ML值。最佳结果用粗体和下划线标出,而最差结果用斜体红色标出。

Table 6 中的评估结果进一步凸显了在多模态训练中,不同模型间性能增益和数据泄露程度的显著差异,为了推动该领域向更高层次发展,必须解决现有评估方法中的视觉依赖性缺失和无意数据泄露问题。随着MMStar等基准测试的不断发展和完善,以及MG和ML等度量指标的广泛应用,研究者们将能够更有效地评估和提升LVLMs的性能,推动多模态人工智能领域的进一步进步。通过这些努力,我们期待LVLMs能够在更广泛的应用场景中发挥关键作用,为人类社会带来更多的价值和便利。