基于LangChain-Chatchat实现的本地知识库的问答应用-快速上手(检索增强生成(RAG)大模型)

基于 ChatGLM 等大语言模型与 Langchain 等应用框架实现,开源、可离线部署的检索增强生成(RAG)大模型知识库项目。

1.介绍

-

依托于本项目支持的开源 LLM 与 Embedding 模型,本项目可实现全部使用开源 模型离线私有部署。与此同时,本项目也支持 OpenAI GPT API 的调用,并将在后续持续扩充对各类模型及模型 API 的接入。

-

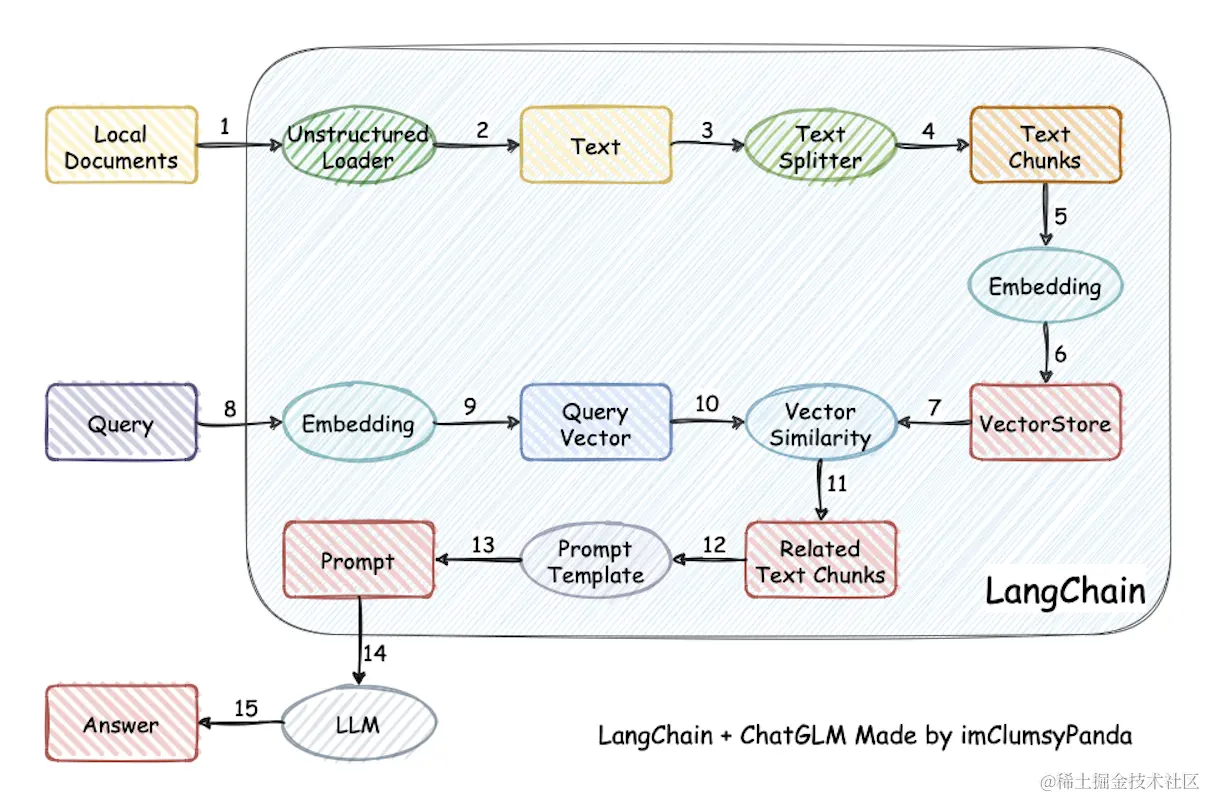

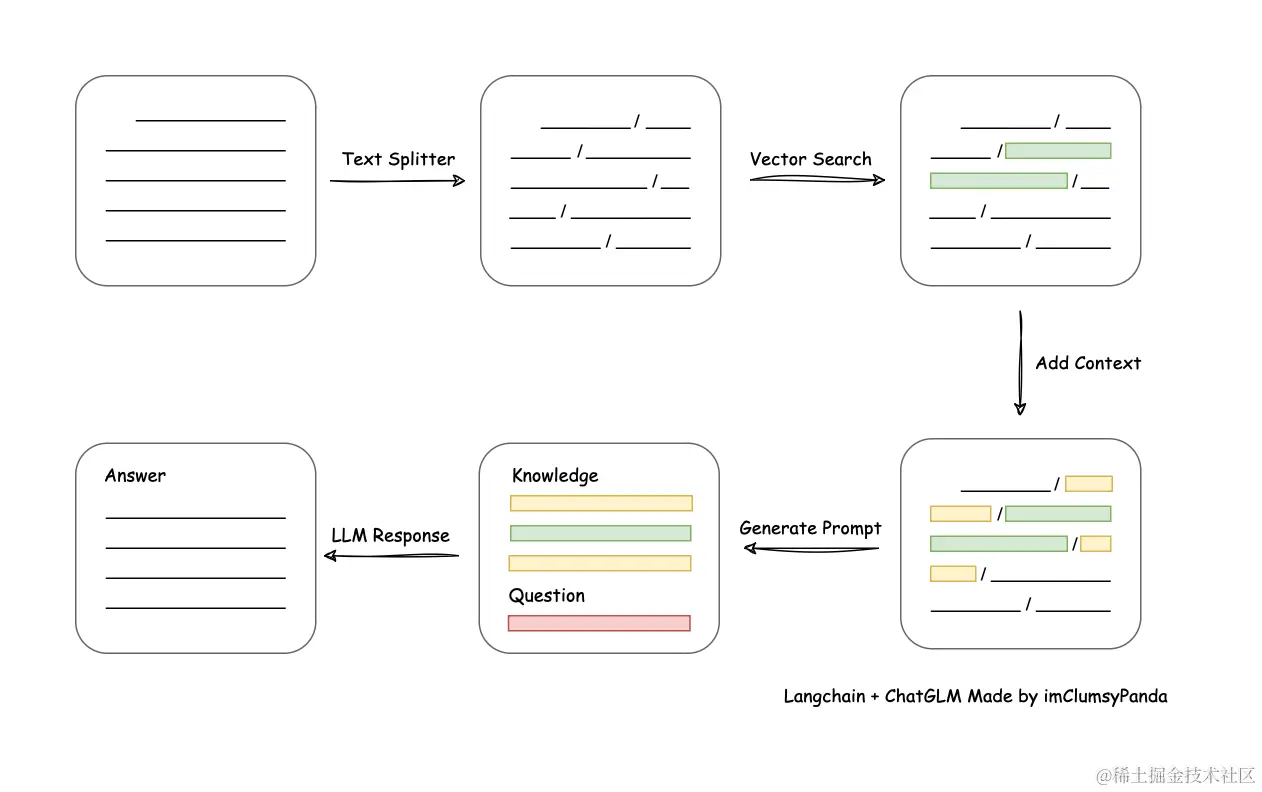

本项目实现原理如下图所示,过程包括加载文件 -> 读取文本 -> 文本分割 -> 文本向量化 -> 问句向量化 -> 在文本向量中匹配出与问句向量最相似的

top k个 -> 匹配出的文本作为上下文和问题一起添加到prompt中 -> 提交给LLM生成回答。

从文档处理角度来看,实现流程如下:

-

本项目未涉及微调、训练过程,但可利用微调或训练对本项目效果进行优化。

-

AutoDL 镜像\] 中 `0.2.10`版本所使用代码已更新至本项目 `v0.2.10` 版本。

-

本次更新后同时支持DockerHub、阿里云、腾讯云镜像源:

docker run -d --gpus all -p 80:8501 isafetech/chatchat:0.2.10

docker run -d --gpus all -p 80:8501 uswccr.ccs.tencentyun.com/chatchat/chatchat:0.2.10

docker run -d --gpus all -p 80:8501 registry.cn-beijing.aliyuncs.com/chatchat/chatchat:0.2.10

2. 解决的痛点

该项目是一个可以实现 __完全本地化__推理的知识库增强方案, 重点解决数据安全保护,私域化部署的企业痛点。本开源方案采用Apache License,可以免费商用,无需付费。

我们支持市面上主流的本地大语言模型和Embedding模型,支持开源的本地向量数据库。支持列表详见[Wiki]

3.快速实现案例

3.1. 环境配置

-

首先,确保你的机器安装了 Python 3.8 - 3.11 (我们强烈推荐使用 Python3.11)。

$ python --version

Python 3.11.7

接着,创建一个虚拟环境,并在虚拟环境内安装项目的依赖

#拉取仓库

$ git clone https://github.com/chatchat-space/Langchain-Chatchat.git

#进入目录

$ cd Langchain-Chatchat

#安装全部依赖

$ pip install -r requirements.txt

$ pip install -r requirements_api.txt

$ pip install -r requirements_webui.txt

#默认依赖包括基本运行环境(FAISS向量库)。如果要使用 milvus/pg_vector 等向量库,请将 requirements.txt 中相应依赖取消注释再安装。如果在安装"pip install -r requirements.txt "遇到报错:

distutils.errors.DistutilsError: Command '['/Users/didiyu/ENTER/envs/chain/bin/python', '-m', 'pip', '--disable-pip-version-check', 'wheel', '--no-deps', '-w', '/var/folders/yd/mp5rd9bx1x3670cth1fp7n180000gn/T/tmpkl7z5ekl', '--quiet', 'setuptools_scm']' returned non-zero exit status 1.

[end of output]

note: This error originates from a subprocess, and is likely not a problem with pip.

error: metadata-generation-failed

× Encountered error while generating package metadata.

╰─> See above for output.

note: This is an issue with the package mentioned above, not pip.

hint: See above for details.-

解决方案

step1: pip install setuptools_scm

step 2: pip install wavedrom -i https://pypi.tuna.tsinghua.edu.cn/simple

请注意,LangChain-Chatchat 0.2.x 系列是针对 Langchain 0.0.x 系列版本的,如果你使用的是 Langchain 0.1.x系列版本,需要降级您的Langchain版本。

3.2. 模型下载

如需在本地或离线环境下运行本项目,需要首先将项目所需的模型下载至本地,通常开源 LLM 与 Embedding模型可以从 HuggingFace 下载。

以本项目中默认使用的 LLM 模型 THUDM/ChatGLM3-6B 与 Embedding模型 BAAI/bge-large-zh 为例:

下载模型需要先安装 Git LFS ,然后运行

$ git lfs install

$ git clone https://huggingface.co/THUDM/chatglm3-6b

$ git clone https://huggingface.co/BAAI/bge-large-zh-

如果遇到模型下载缓慢的情况,可以从魔塔下载

-

chatglm3-6b: modelscope.cn/models/Zhip...

-

bge-large-zh-v1.5: modelscope.cn/models/AI-M...

git clone https://www.modelscope.cn/ZhipuAI/chatglm3-6b.git

git clone https://www.modelscope.cn/Xorbits/bge-large-zh.git

git clone https://www.modelscope.cn/AI-ModelScope/bge-large-zh-v1.5.git

3.3 Embedding模型介绍

3.4 ChatGLM3-6B

ChatGLM3-6B 是 ChatGLM 系列最新一代的开源模型,在保留了前两代模型对话流畅、部署门槛低等众多优秀特性的基础上,ChatGLM3-6B 引入了如下特性:

-

更强大的基础模型: ChatGLM3-6B 的基础模型 ChatGLM3-6B-Base 采用了更多样的训练数据、更充分的训练步数和更合理的训练策略。在语义、数学、推理、代码、知识等不同角度的数据集上测评显示,ChatGLM3-6B-Base 具有在 10B 以下的预训练模型中最强的性能。

-

更完整的功能支持: ChatGLM3-6B 采用了全新设计的 Prompt 格式,除正常的多轮对话外。同时原生支持工具调用(Function Call)、代码执行(Code Interpreter)和 Agent 任务等复杂场景。

-

更全面的开源序列: 除了对话模型 ChatGLM3-6B 外,还开源了基础模型 ChatGLM-6B-Base、长文本对话模型 ChatGLM3-6B-32K。

pip install protobuf 'transformers>=4.30.2' cpm_kernels 'torch>=2.0' gradio mdtex2html sentencepiece accelerate

-

模型下载

pip install modelscope

from modelscope import snapshot_download

model_dir = snapshot_download("ZhipuAI/chatglm3-6b", revision = "v1.0.0") -

git下载

git lfs install

git clone https://www.modelscope.cn/ZhipuAI/chatglm3-6b.git -

代码调用

from modelscope import AutoTokenizer, AutoModel, snapshot_download

model_dir = snapshot_download("ZhipuAI/chatglm3-6b", revision = "v1.0.0")

tokenizer = AutoTokenizer.from_pretrained(model_dir, trust_remote_code=True)

model = AutoModel.from_pretrained(model_dir, trust_remote_code=True).half().cuda()

model = model.eval()

response, history = model.chat(tokenizer, "你好", history=[])

print(response)

response, history = model.chat(tokenizer, "晚上睡不着应该怎么办", history=history)

print(response)

3.5. 初始化知识库和配置文件

按照下列方式初始化自己的知识库和简单的复制配置文件

$ python copy_config_example.py

$ python init_database.py --recreate-vs- 配置文件下内容

-

basic_config.py.example

import logging

import os

import langchain

import tempfile

import shutil#是否显示详细日志

log_verbose = False

langchain.verbose = False#通常情况下不需要更改以下内容

#日志格式

LOG_FORMAT = "%(asctime)s - %(filename)s[line:%(lineno)d] - %(levelname)s: %(message)s"

logger = logging.getLogger()

logger.setLevel(logging.INFO)

logging.basicConfig(format=LOG_FORMAT)#日志存储路径

LOG_PATH = os.path.join(os.path.dirname(os.path.dirname(file)), "logs")

if not os.path.exists(LOG_PATH):

os.mkdir(LOG_PATH)#临时文件目录,主要用于文件对话

BASE_TEMP_DIR = os.path.join(tempfile.gettempdir(), "chatchat")

try:

shutil.rmtree(BASE_TEMP_DIR)

except Exception:

pass

os.makedirs(BASE_TEMP_DIR, exist_ok=True) -

kb_config.py.example

import os

#默认使用的知识库

DEFAULT_KNOWLEDGE_BASE = "samples"#默认向量库/全文检索引擎类型。可选:faiss, milvus(离线) & zilliz(在线), pgvector, chromadb 全文检索引擎es

DEFAULT_VS_TYPE = "faiss"#缓存向量库数量(针对FAISS)

CACHED_VS_NUM = 1#缓存临时向量库数量(针对FAISS),用于文件对话

CACHED_MEMO_VS_NUM = 10#知识库中单段文本长度(不适用MarkdownHeaderTextSplitter)

CHUNK_SIZE = 250#知识库中相邻文本重合长度(不适用MarkdownHeaderTextSplitter)

OVERLAP_SIZE = 50#知识库匹配向量数量

VECTOR_SEARCH_TOP_K = 3#知识库匹配的距离阈值,一般取值范围在0-1之间,SCORE越小,距离越小从而相关度越高。

#但有用户报告遇到过匹配分值超过1的情况,为了兼容性默认设为1,在WEBUI中调整范围为0-2

SCORE_THRESHOLD = 1.0#默认搜索引擎。可选:bing, duckduckgo, metaphor

DEFAULT_SEARCH_ENGINE = "duckduckgo"#搜索引擎匹配结题数量

SEARCH_ENGINE_TOP_K = 3 -

model_config.py.example

import os

#可以指定一个绝对路径,统一存放所有的Embedding和LLM模型。

#每个模型可以是一个单独的目录,也可以是某个目录下的二级子目录。

#如果模型目录名称和 MODEL_PATH 中的 key 或 value 相同,程序会自动检测加载,无需修改 MODEL_PATH 中的路径。

MODEL_ROOT_PATH = ""#选用的 Embedding 名称

EMBEDDING_MODEL = "bge-large-zh-v1.5"#Embedding 模型运行设备。设为 "auto" 会自动检测(会有警告),也可手动设定为 "cuda","mps","cpu","xpu" 其中之一。

EMBEDDING_DEVICE = "auto"#选用的reranker模型

RERANKER_MODEL = "bge-reranker-large"

#是否启用reranker模型

USE_RERANKER = False

RERANKER_MAX_LENGTH = 1024#如果需要在 EMBEDDING_MODEL 中增加自定义的关键字时配置

EMBEDDING_KEYWORD_FILE = "keywords.txt"

EMBEDDING_MODEL_OUTPUT_PATH = "output"#要运行的 LLM 名称,可以包括本地模型和在线模型。列表中本地模型将在启动项目时全部加载。

#列表中第一个模型将作为 API 和 WEBUI 的默认模型。

#在这里,我们使用目前主流的两个离线模型,其中,chatglm3-6b 为默认加载模型。

#如果你的显存不足,可使用 Qwen-1_8B-Chat, 该模型 FP16 仅需 3.8G显存。 -

prompt_config.py.example

#prompt模板使用Jinja2语法,简单点就是用双大括号代替f-string的单大括号

#本配置文件支持热加载,修改prompt模板后无需重启服务。

#LLM对话支持的变量:

#- input: 用户输入内容

#知识库和搜索引擎对话支持的变量:

#- context: 从检索结果拼接的知识文本

#- question: 用户提出的问题

#Agent对话支持的变量:

#- tools: 可用的工具列表

#- tool_names: 可用的工具名称列表

#- history: 用户和Agent的对话历史

#- input: 用户输入内容

#- agent_scratchpad: Agent的思维记录 -

server_config.py.example

import sys

from configs.model_config import LLM_DEVICE#httpx 请求默认超时时间(秒)。如果加载模型或对话较慢,出现超时错误,可以适当加大该值。

HTTPX_DEFAULT_TIMEOUT = 300.0#API 是否开启跨域,默认为False,如果需要开启,请设置为True

#is open cross domain

OPEN_CROSS_DOMAIN = False#各服务器默认绑定host。如改为"0.0.0.0"需要修改下方所有XX_SERVER的host

DEFAULT_BIND_HOST = "0.0.0.0" if sys.platform != "win32" else "127.0.0.1"#webui.py server

WEBUI_SERVER = {

"host": DEFAULT_BIND_HOST,

"port": 8501,

}

4. 一键启动

按照以下命令启动项目

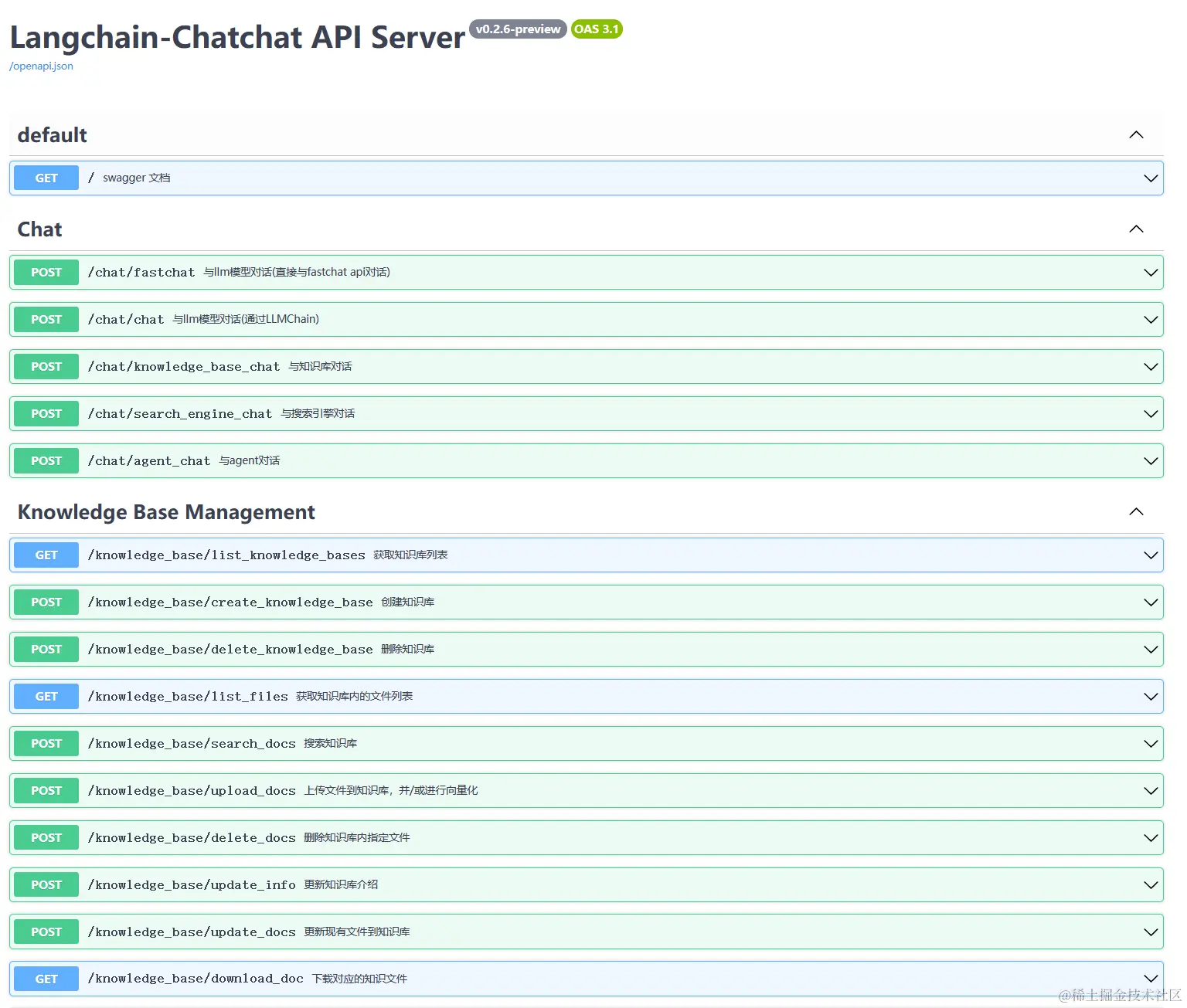

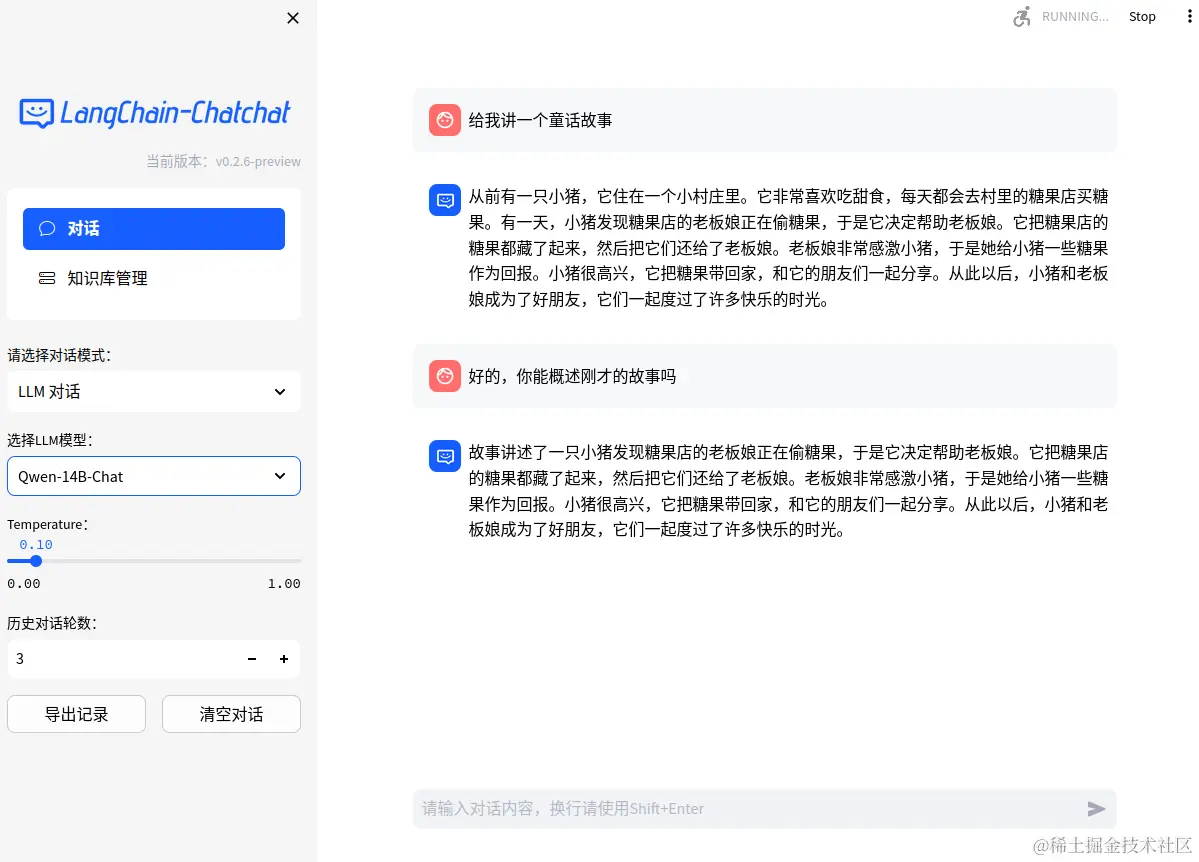

$ python startup.py -a5. 启动界面示例

如果正常启动,你将能看到以下界面

- FastAPI Docs 界面

- Web UI 启动界面示例:

- Web UI 对话界面:

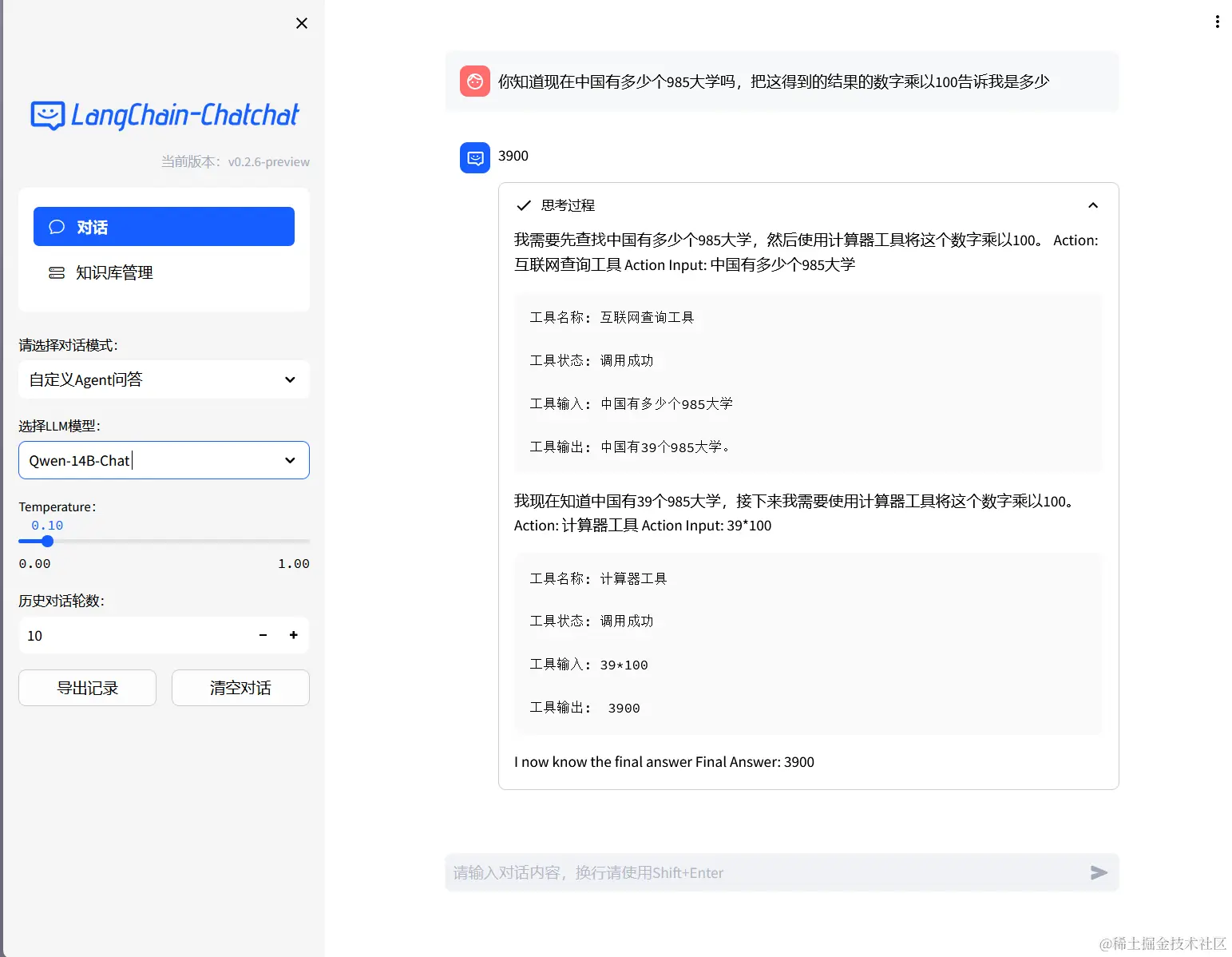

- Agent-Tool效果

- Web UI 知识库管理页面:

如何学习AI大模型?

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

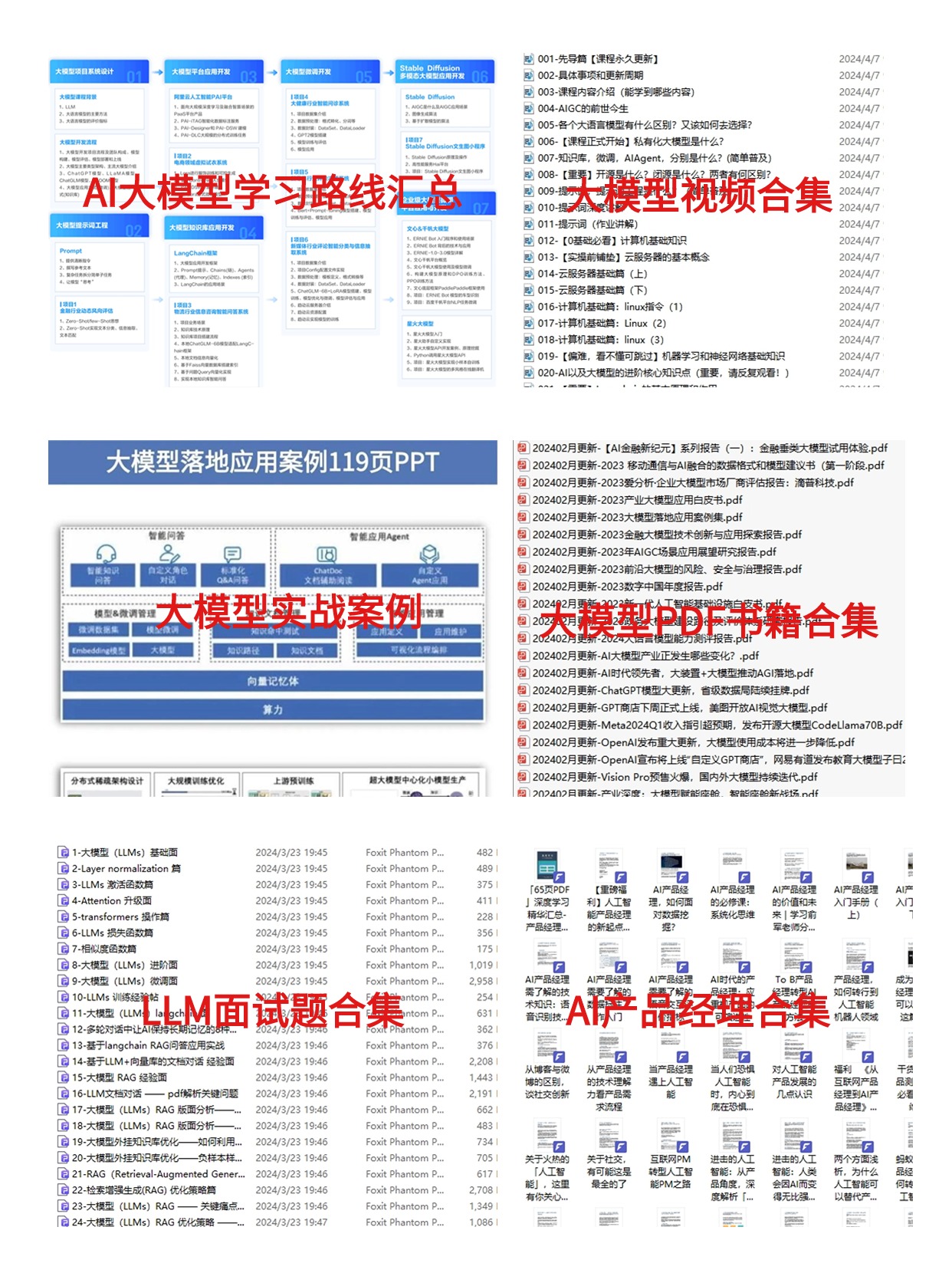

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓