概述

本文是对利用知识图谱(KG)的综合人工智能(CAI)的全面调查研究,其中 CAI 被定义为可解释人工智能(XAI)和可解释机器学习(IML)的超集。

首先,本文澄清了 CAI 的概念,并提出了一种分类法,根据 KG 的表示方案、任务和基本方法对 KG 进行分类。在此分类法的基础上,分别对利用 KG 的 IML 和 XAI 方法进行了详细分析。

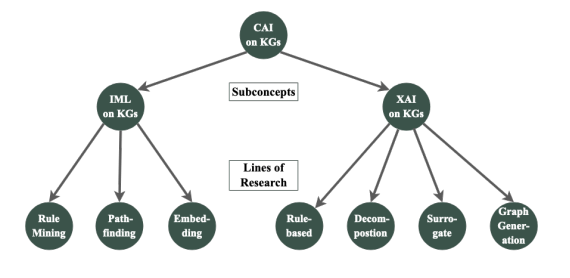

IML 方法介绍了规则提取、路径查找和嵌入方法,XAI 方法介绍了基于规则、基于分解、基于替代模型和基于图生成的方法。对每种方法的特点和挑战进行了细致的梳理,并提出了使用 KG 的 CAI 的现状和未来研究方向。

论文地址:https://arxiv.org/pdf/2107.00651.pdf

介绍

近年来,人工智能(AI)系统已经超越了研究领域,正在渗透到我们的日常生活中。特别是自 21 世纪初以来,基于知识图谱的人工智能方法的应用激增,并被广泛应用于许多领域。然而,解释人工智能系统的决策是用户的需求,在许多应用领域也受到监管。

知识图谱具有作为可理解人工智能(CAI)基础的巨大潜力,因为它们可以以人类和机器都能理解的形式来表示连接数据(即知识)。在本文中,我们回顾了知识图谱 CAI 的历史,明确区分了可解释人工智能(XAI)和可解释机器学习(IML)的概念,并提出将 CAI 作为两者的总概念。

相关研究

在这一研究领域有几篇调查论文。例如,Tiddi 和 Schlobach [35]从广义上讨论了利用 KG 的 CAI。另一方面,Bianchi 等人[36] 综述了使用 KG 作为输入的一般人工智能方法,并提到了这方面的 CAI 方法;Lecue[37] 按 AAAI 论文类别整理了利用 KG 的 XAI 挑战和方法。

然而,在以前的这些研究中,XAI 和 IML 之间的概念区分并不明确,这两个术语往往容易混淆。此外,使用 KG 系统组织 CAI 方法的研究也很有限。

建议方法

本文提出的分类方法包括以下四个方面

-

表示法:将知识图谱表示为人工智能模型输入的一种方法。它可分为三种类型:符号表示法、次符号表示法和神经符号表示法。

-

任务:CAI 方法要解决的问题类型。它们包括链接预测、节点聚类、图聚类、聚类和推荐。

-

基础:实现 CAI 的机器学习算法和方法。其中包括因式分解机、转化学习、基于规则的学习、神经网络和强化学习。强化学习)。

可理解性(可理解性):代表了 CAI 的两种方法。可解释机器学习(IML)和可解释人工智能(XAI)。

该分类法提供了一个框架,用于在知识图谱上系统地组织 CAI 方法,并明确识别每种方法的特征。这样,研究人员就能了解 CAI 方法之间的差异和关系,从而开发新方法并改进现有方法。该分类法还可用作鸟瞰 CAI 研究趋势的工具。

调查结果

调查显示,IML 有三个研究方向:规则挖掘、寻路和基于嵌入。另一方面,XAI 研究显示有四条路线:基于规则的学习、分解方法、代理模型和图生成。

图 6 总结了 IML 和 XAI 的研究脉络。这阐明了每种方法的特点和相关性。

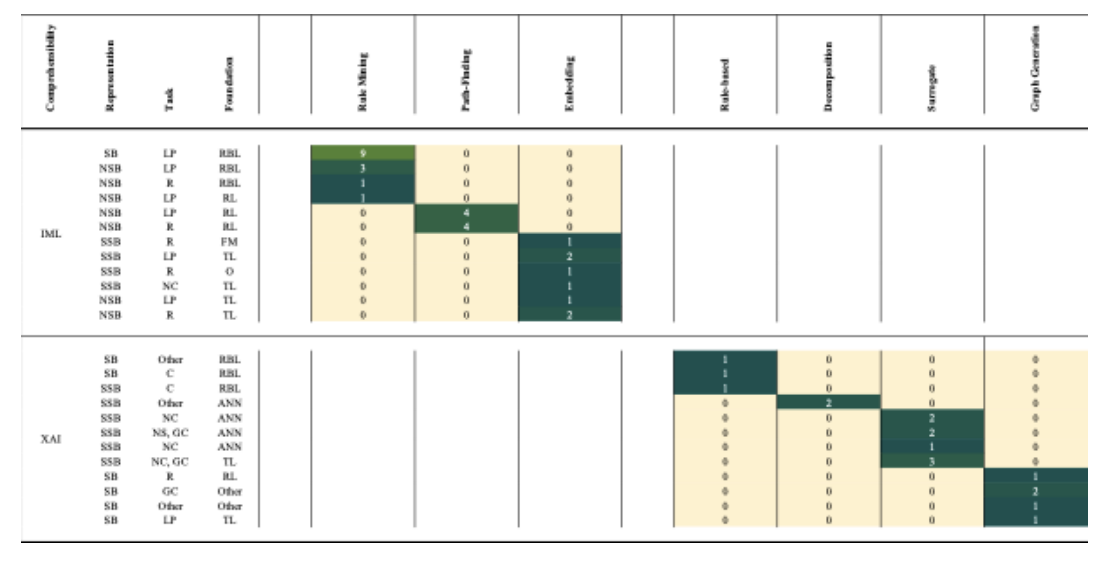

图 10 显示了一张热图,从代表性、任务和基本方法的角度总结了调查论文。热图分别显示了 IML 和 XAI,每个单元格的颜色强度表示研究的集中程度。这样,当前的研究趋势和空白领域就一目了然了。例如,XAI 研究表明,很少有论文涉及链接预测,也很少有研究使用符号或神经符号作为表征。另一方面,可以看出 IML 研究中关于图聚类的论文较少,而基于规则学习的研究较多。

这些图表在概述知识图谱上 CAI 研究的总体情况、确定每种方法的特点和相关性、研究趋势和未来研究机会方面发挥了重要作用。

未来展望

作者指出了今后研究知识图谱 CAI 的以下问题

将XAI 方法应用于链接预测

2.利用语义信息改进对知识图谱的解释

3.为 XAI 方法之间的比较评估建立共同标准

- 将IML 方法应用于图谱聚类

5.改进向用户传达 IML 模型解释的方法