背景介绍

作为一种动态可编程光学元件,液晶空间光调制器(LC-SLM)在波前整形和光束控制等精密光学调控应用中发挥着非常重要的作用。典型的纯相位SLM工作原理是通过加载的电压控制在每个液晶像素处诱导相位延迟,实现对入射光波波前的调控。

随着光场调控技术朝着精细化方向发展,对相位型LC-SLM的调制精度提出了更高的要求。如:在超快智能加工领域需求相位型SLM实现高相位调制精度的波前精细调控;在显微成像领域需求相位型SLM实现高信噪比、高分辨率的成像;在无接触光学微操纵领域需求相位型SLM实现高精度、高效的微粒捕获等。然而, 通常商用SLM会出现相位失真,导致LCOS器件在波前控制实际应用中存在诸多问题:如光利用效率低、调制精度差,最终无法实现相应的功能。

追其本源,相位失真主要由SLM物理结构和环境条件的相位调制非线性和不均匀性引起,具体可归因于两个因素:

1) 施加在液晶(LC)上的错误驱动电信号;

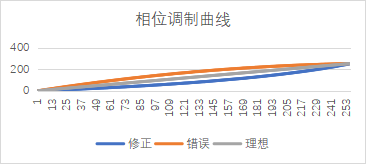

图1 动态调制LUT调制误差

2) SLM衬底或背板曲率和LC层厚度不均匀引起的畸变;

图2 SLM硬件引入畸变

前者属于驱动模块控制误差导致动态相位响应误差,可通过LUT来实现修正;而后者属于产品器件的固有特性,会影响效率和波前质量,调制的相位轮廓的精度相对较低,直接影响了相位调制的精度。为了解决这一问题,需要对SLM的硬件(光阀)进行面型测量及修正。

SLM面型测试和校准原理

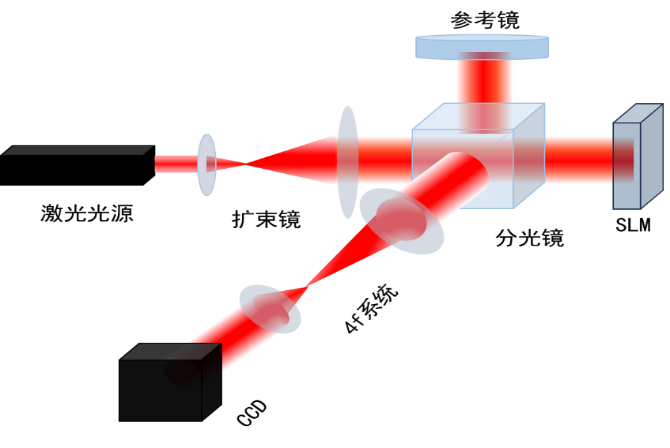

为了响应基于高精度相位调制的应用需求,同时提升SLM产品性能,中科微星基于泰曼-格林干涉法开发了测量SLM的静态波面误差和修正技术,系统光路示意如图3所示,具体工作原理:在激光光束扩束和准直之后形成平面波,经分束器(BS)分成两个光束,一束光经BS透射照射到SLM,并经SLM调制后反射;另一束光经BS反射照射到参考镜,并经参考镜反射,经SLM调制后的反射光与经平面镜(M)反射的光通过BS时发生干涉,然后CCD可通过其前端配置的4f系统对干涉条纹进行采集和记录。

图3 泰曼格林干涉测量光路

将SLM置于图3中所示的位置,通过光路系统中CCD采集干涉条纹,图4为测得的SLM干涉条纹。

图4 采集的干涉条纹图

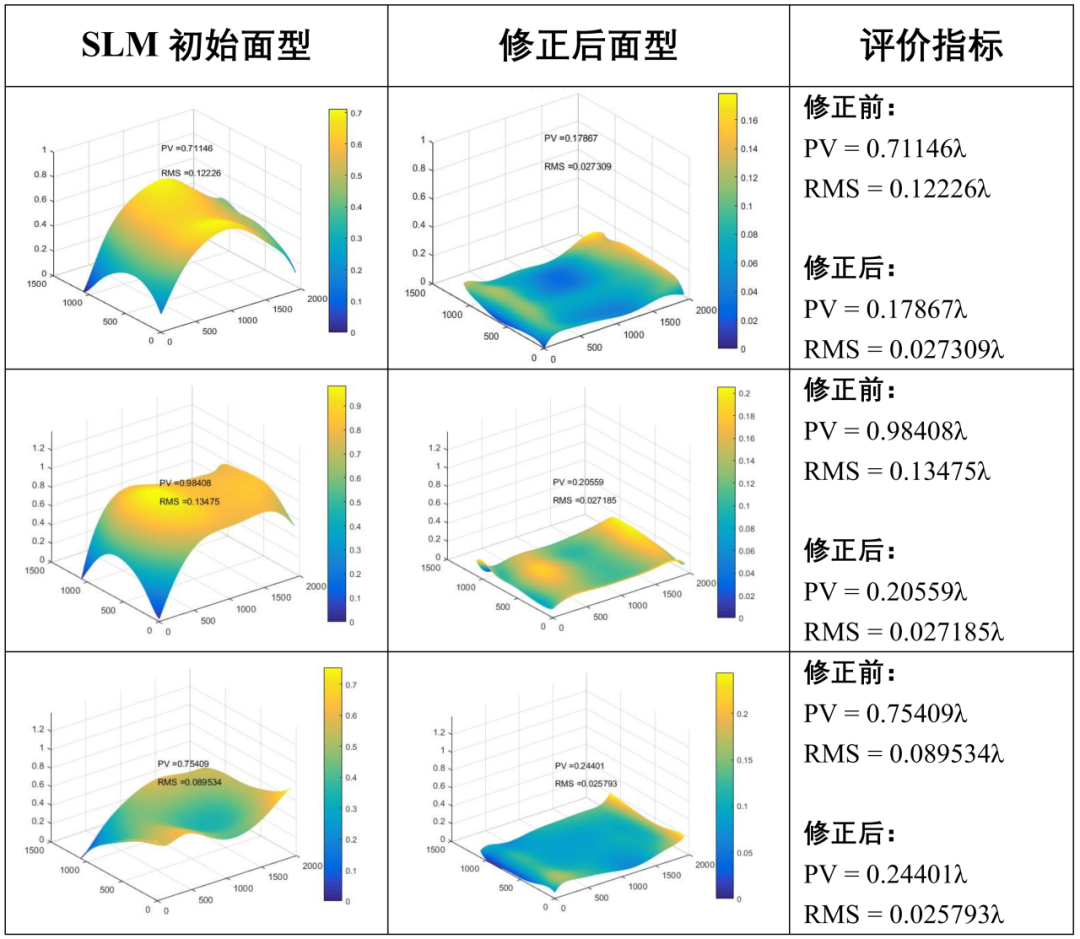

然后通过干涉条纹处理算法可得到SLM初始面型图像和数据;通过面型修正算法可得到SLM修正后面型数据和图像,并用常用的面型评价指标PV、RMS进行量化表征。下表1列举的为测试和修正的3种SLM的测试和修正面型图像和数据。

表1 不同类型SLM初始及修正后面型

从上表可得到:修正后面型相较于初始面型,面型基本趋于平坦度,面型精度RMS基本可达1/35λ@632.8nm。

面型校准对调制效果的影响

为了更好对比面型修正前后SLM的调制性能,通过搭建实际光场测试系统测试了3种常用光束(高斯光束、艾里光束、涡旋光束)修正前后调制效果。

表2 SLM面型修正前后对实际光场调试结果

从上述测试结果可以得到,修正后的SLM调制效果会更完美,更接近于理论效果。

产品推出

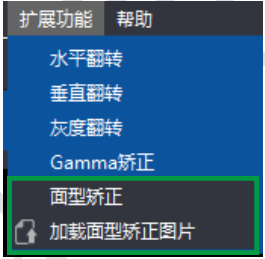

公司最新3.0软件已经预留面型补偿接口,支持相位型SLM(针对532nm和635nm)面型检测和修正标定,根据不同工作波长配置相应的面型修正文件,并通过配套软件实现面型修正的补偿。