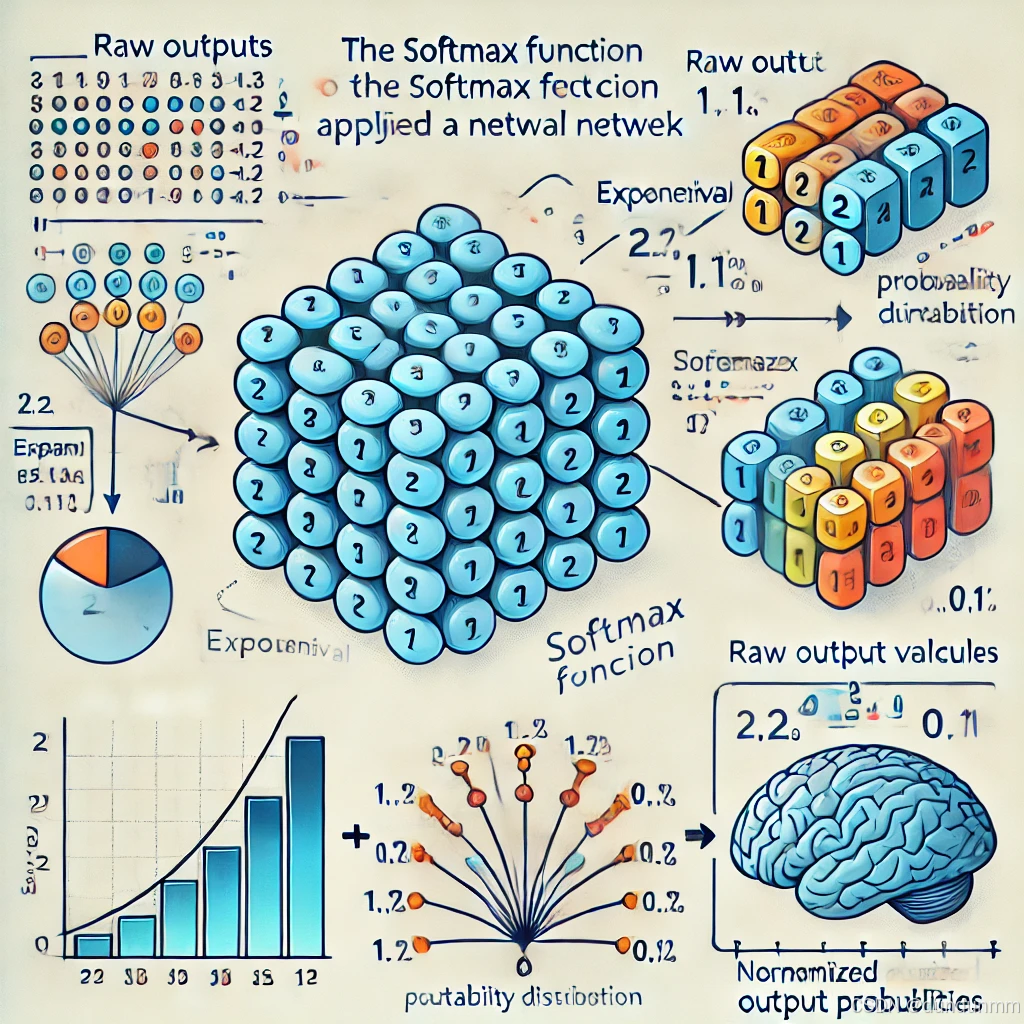

Softmax 函数是神经网络中常用的一种激活函数,尤其在分类问题中广泛应用。它将一个实数向量转换为概率分布,使得每个输出值都位于 [0, 1] 之间,并且所有输出值的和为 1。这样,Softmax 可以用来表示各类别的预测概率。

Softmax 函数的定义

给定一个实数向量 z=[z1,z2,...,zn],Softmax 函数的输出是一个概率分布,定义如下:

其中:

- zi是输入向量 z 中的第 i 个元素。

- ezi是 zi 的指数。

- 分母是对所有元素的指数进行求和,确保输出的概率和为 1。

Softmax 的特点

- 输出范围:每个输出值在 [0, 1] 之间,适合作为概率。

- 归一化:所有输出的和为 1,这使得输出可以视为概率。

- 强化最大值:Softmax 将输入向量中最大的元素映射为最大的概率,通常用于多分类问题的最终输出层。

应用场景

- 多类分类问题:在神经网络的输出层,Softmax 通常用于多分类问题,例如图像分类、文本分类等。它将每个类别的原始预测值(即神经网络的输出)转换为概率,从而能够判断输入属于每个类别的概率。

- 回归任务:虽然 Softmax 主要用于分类问题,但在某些情况下它也可以应用于回归任务中的概率预测。

计算示例

假设有一个网络的输出向量 z=[2,1,0.1],我们想计算该向量通过 Softmax 函数后的输出:

-

计算每个 e^{z_i}:

- e2≈7.389e^2

- e1≈2.718e^1

- e0.1≈1.105e^{0.1}

-

求和:

-

计算每个类别的概率:

最终,Softmax 输出的概率分布为 [0.659,0.242,0.099],即该网络认为输入属于第一个类别的概率为 65.9%,属于第二个类别的概率为 24.2%,属于第三个类别的概率为 9.9%。

总结

Softmax 是神经网络中用于多类分类问题的常见激活函数,通过将网络的输出转化为概率分布,帮助我们理解模型的预测结果,并且通过概率值判断输入属于各类别的可能性。