一台有GPU的虚拟机如果没有安装CUDA的驱动,是需要我们手动去进行安装的,介绍Ubuntu操作系统的安装教程。

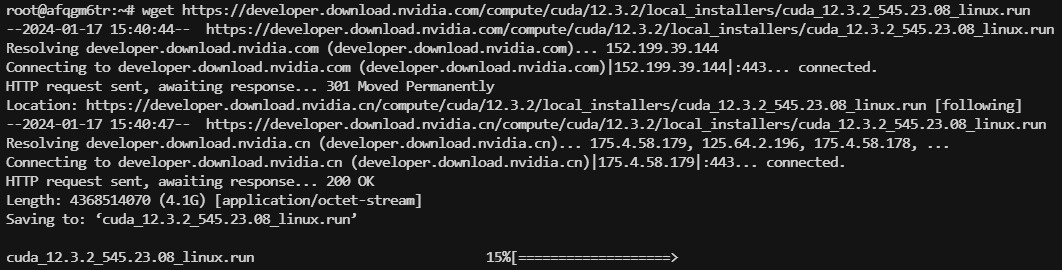

1. 下载安装文件

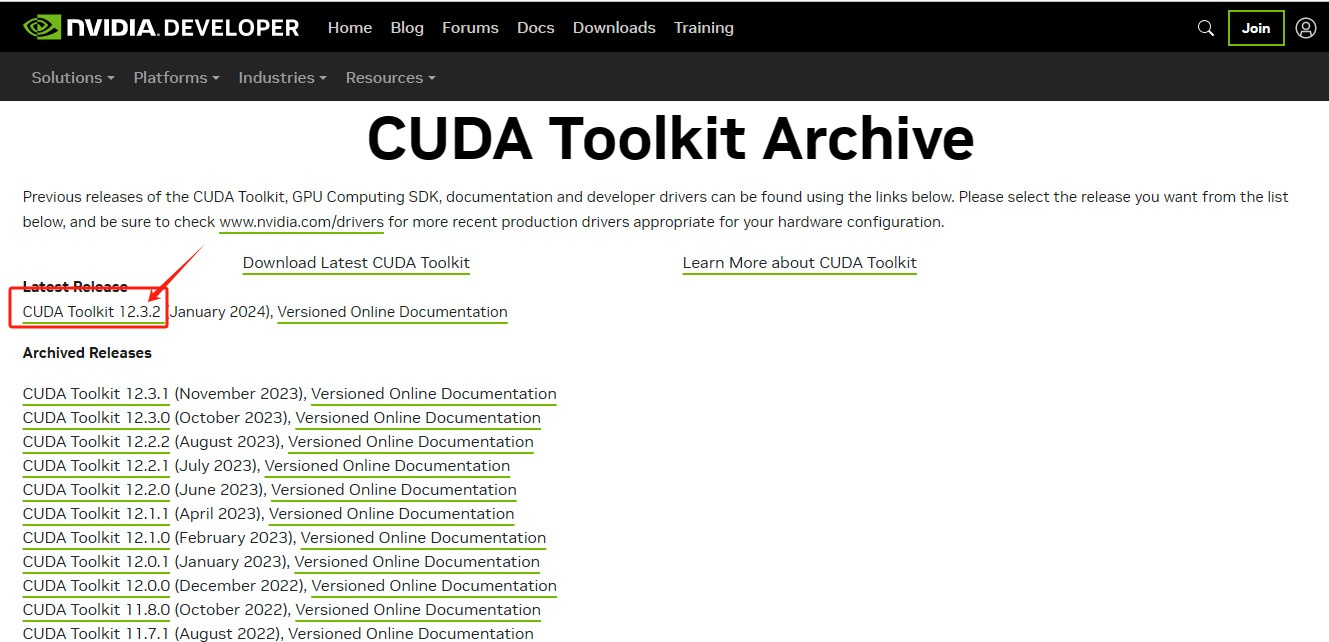

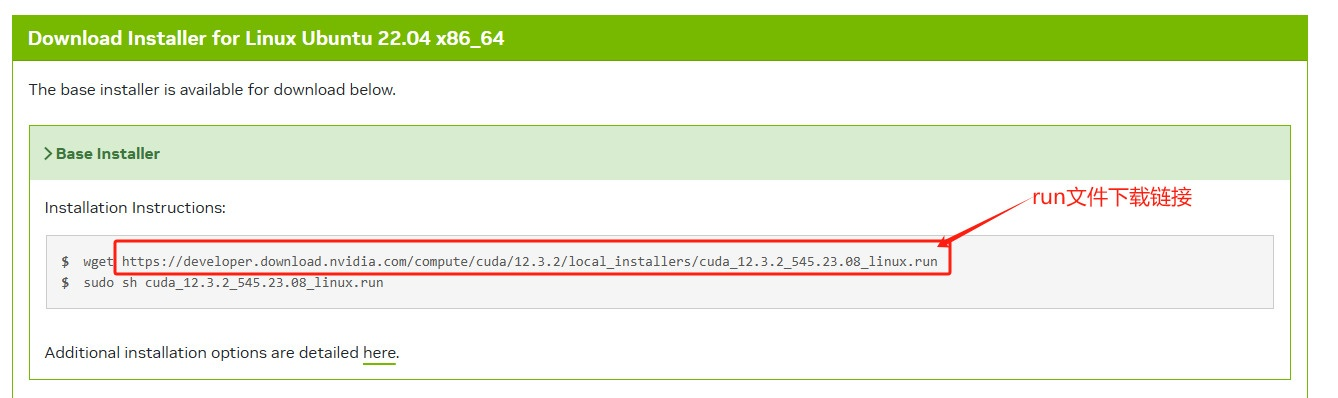

点击上面链接,进入CUDA Toolkit Archive,下载需要的CUDA工具包,本文章以CUDA Toolkit 12.3.2版本举例(可能需要代理加速访问网页)

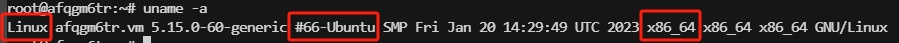

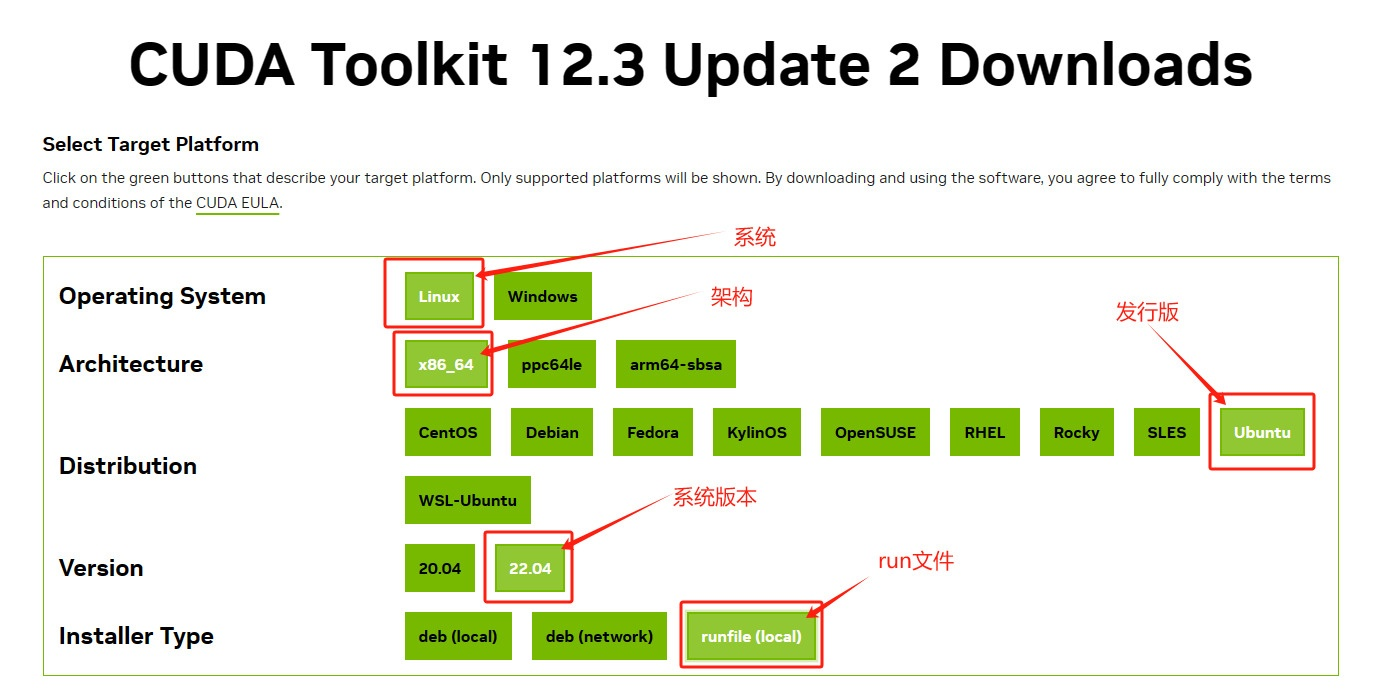

选择对应的系统,架构,发行版本,选择run文件安装方式

(可在服务器中输入uname -a查看当前服务器系统版本信息)

选择完后会出现run文件下载链接,可复制wget命令直接在服务器中下载,也可复制下载链接到浏览器上,通过本地浏览器下载再上传至服务器中。(注意:只下载不执行)

2. 禁用 nouveau 驱动

sudo vim /etc/modprobe.d/blacklist-nouveau.conf文件最后加入以下内容 (如果没有需要添加,否则忽略这步操作)

blacklist nouveau

options nouveau modeset=0更新使其生效

sudo update-initramfs -u重启机器之后检查,

没有内容输出,说明禁用成功

reboot

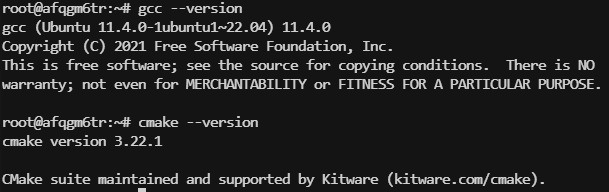

lsmod | grep nouveau3. 安装gcc/cmake

依次执行

sudo apt-get update

sudo apt-get install gcc

sudo apt-get install cmake

# 查看版本

gcc --version

cmake --version

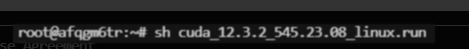

4. 运行安装文件

输入ls命令查看运行文件

输入chmod -x {文件名}赋予run文件执行权限

输入sh {文件名}运行run文件

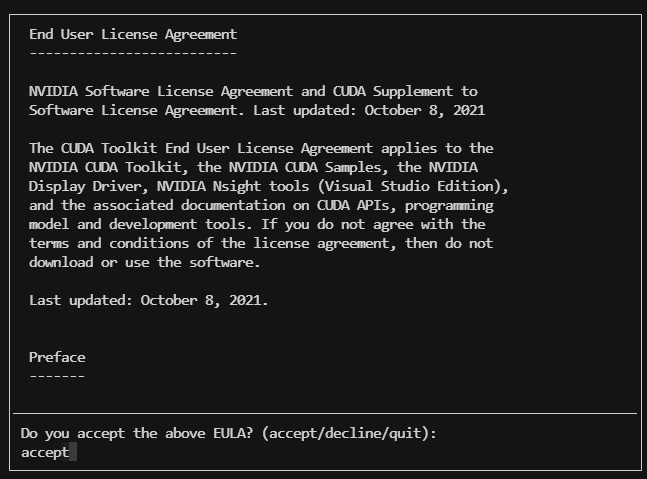

等待一会儿后会弹出NVIDIA用户协议输入accept同意

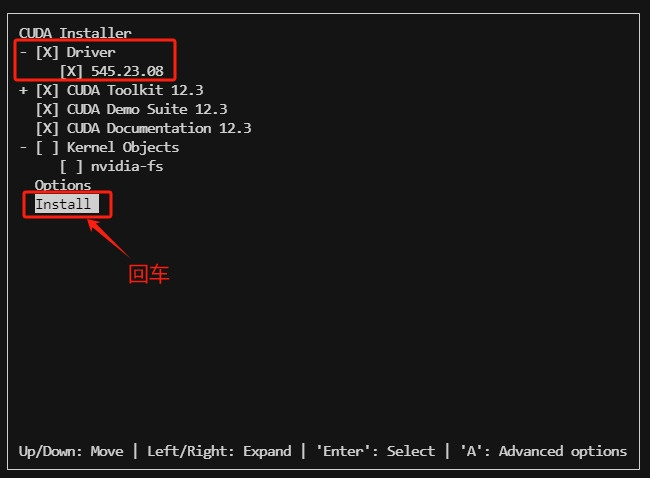

默认选中显卡驱动,一起安装即可

等待程序运行。。。。

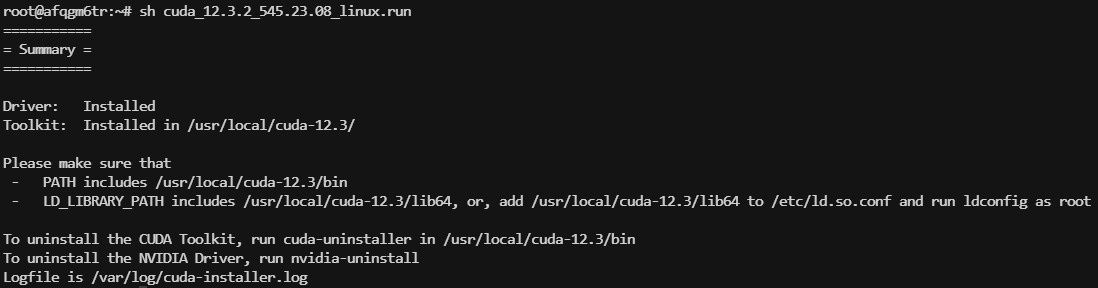

安装完成后,如下图

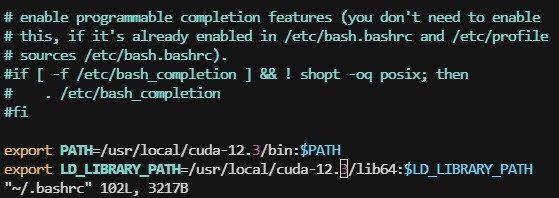

添加自己需要的cuda版本到环境变量, vim ~/.bashrc,添加以下内容到最后,如:

export PATH=/usr/local/cuda-12.3/bin:$PATH

export LD_LIBRARY_PATH=/usr/local/cuda-12.3/lib64:$LD_LIBRARY_PATH

内容输入后,:wq 保存退出,

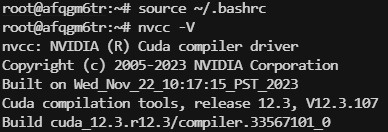

输入source ~/.bashrc 更新环境变量使刚刚输入的环境变量生效,输入nvcc -V 查看CUDA版本

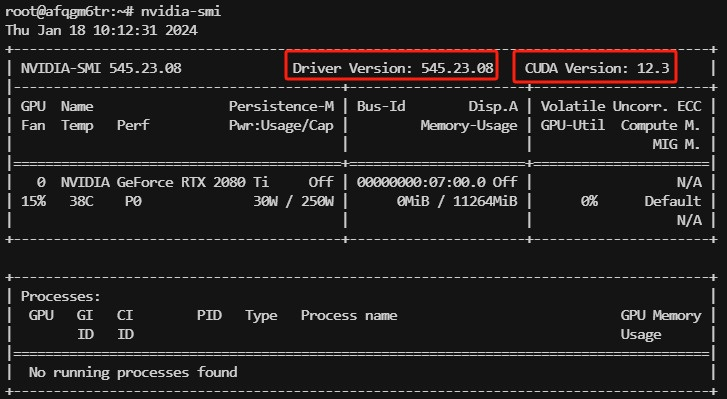

输入命令nvidia-smi查看显卡驱动与CUDA版本,如下图所示,说明安装成功。

启动显卡持久化服务及其守护程序

cat <<EOF >> /etc/systemd/system/nvidia-persistenced.service

[Unit]

Description=NVIDIA Persistence Daemon

Wants=syslog.target

[Service]

Type=forking

ExecStart=/usr/bin/nvidia-persistenced

ExecStopPost=/bin/rm -rf /var/run/nvidia-persistenced

[Install]

WantedBy=multi-user.target

EOF

systemctl daemon-reload

systemctl start nvidia-persistenced

systemctl enable nvidia-persistenced在安装NVIDIA CUDA Toolkit时,cuDNN库并不是必须同时安装的,但安装cuDNN可以提供额外的性能优化,特别是在深度学习和某些高性能计算任务中。以下是一些关于是否需要安装cuDNN的考虑因素:

- 深度学习应用:如果你的工作或项目涉及到深度学习,特别是需要使用GPU加速的深度学习框架(如TensorFlow、PyTorch等),那么安装cuDNN是非常推荐的。cuDNN提供了针对深度学习算法的优化实现,可以显著提高训练和推理的速度。

- 性能需求:如果你的应用需要高性能的计算能力,并且对计算速度有较高的要求,那么安装cuDNN可以提供额外的性能提升。

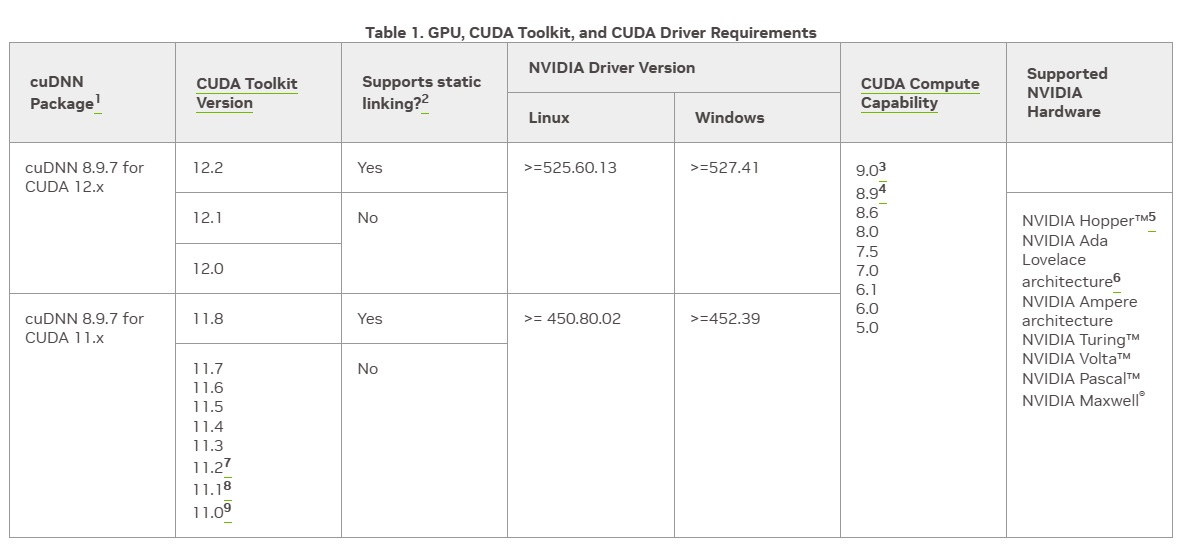

- 兼容性:确保你安装的CUDA Toolkit版本与cuDNN版本兼容。NVIDIA提供了不同版本的CUDA Toolkit和cuDNN,它们之间有特定的兼容性要求。

- 空间和资源:cuDNN是一个额外的库,会占用一定的磁盘空间和系统资源。如果你的系统资源有限,或者你不需要cuDNN提供的性能优化,那么可以考虑不安装。

- 框架支持 :一些深度学习框架可能已经内置了对cuDNN的支持,或者提供了使用cuDNN的选项。在这种情况下,安装cuDNN可以使得这些框架能够利用GPU加速。

总的来说,是否需要安装cuDNN取决于你的具体需求。如果你不确定是否需要cuDNN,可以先安装CUDA Toolkit,然后在需要的时候再安装cuDNN。这样,你可以在不牺牲性能的情况下,根据实际需求灵活地选择是否使用cuDNN。

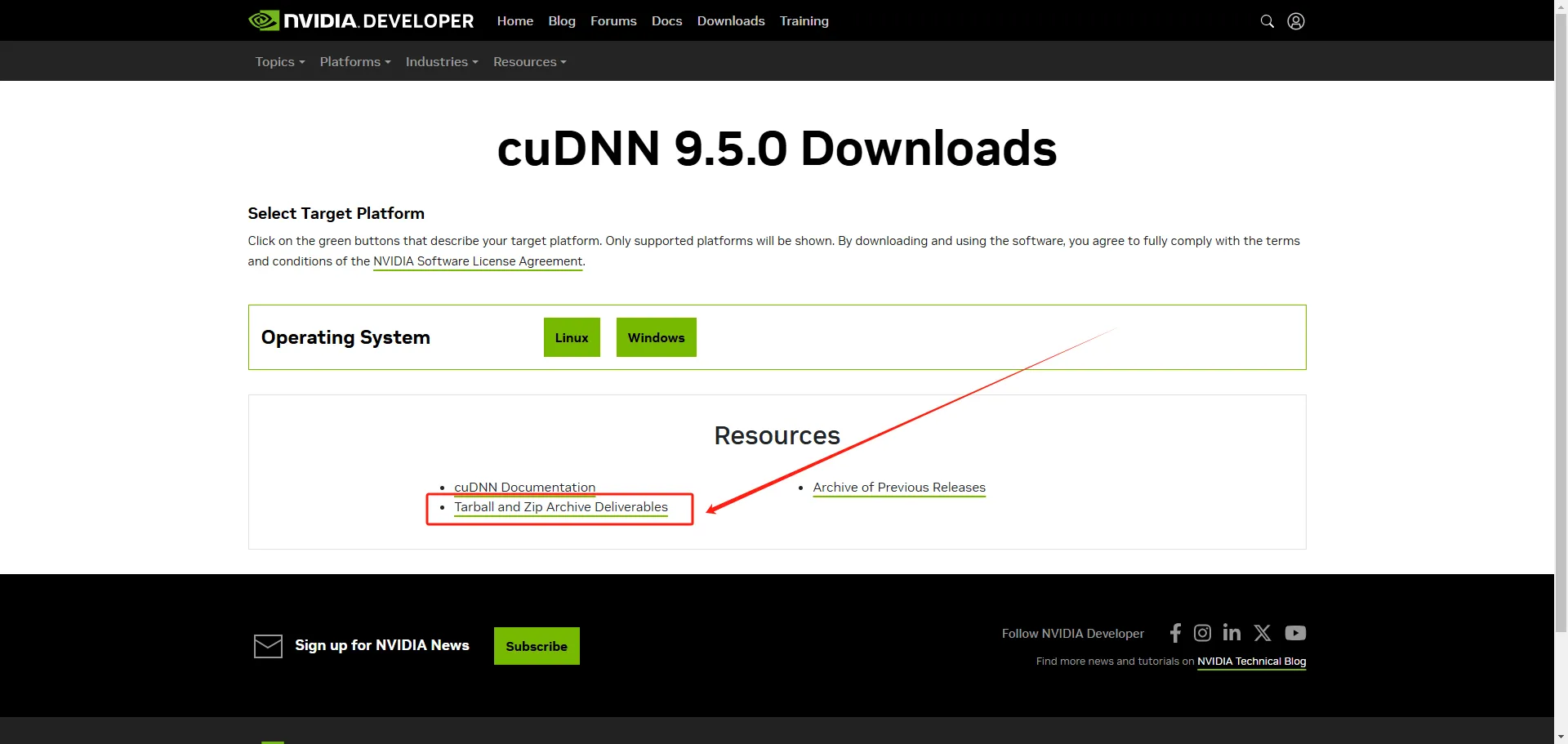

5. 配置cuDNN库

cuDNN比CUDA安装简单,下载对应版本压缩包,拷贝文件到指定目录,给予权限就好了。

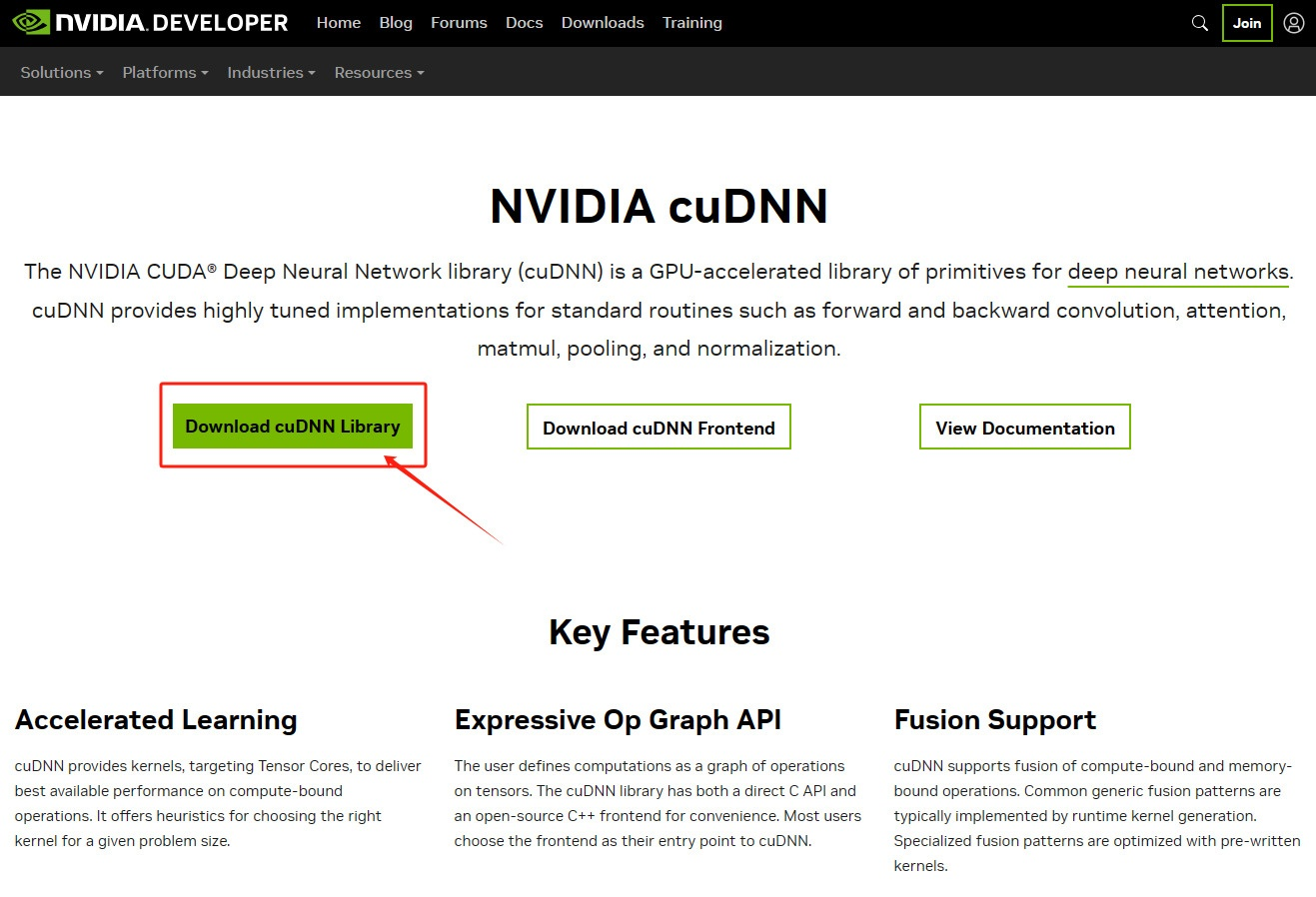

cuDNN官方下载地址(如果下载不了,需要登录NVIDIA账号)

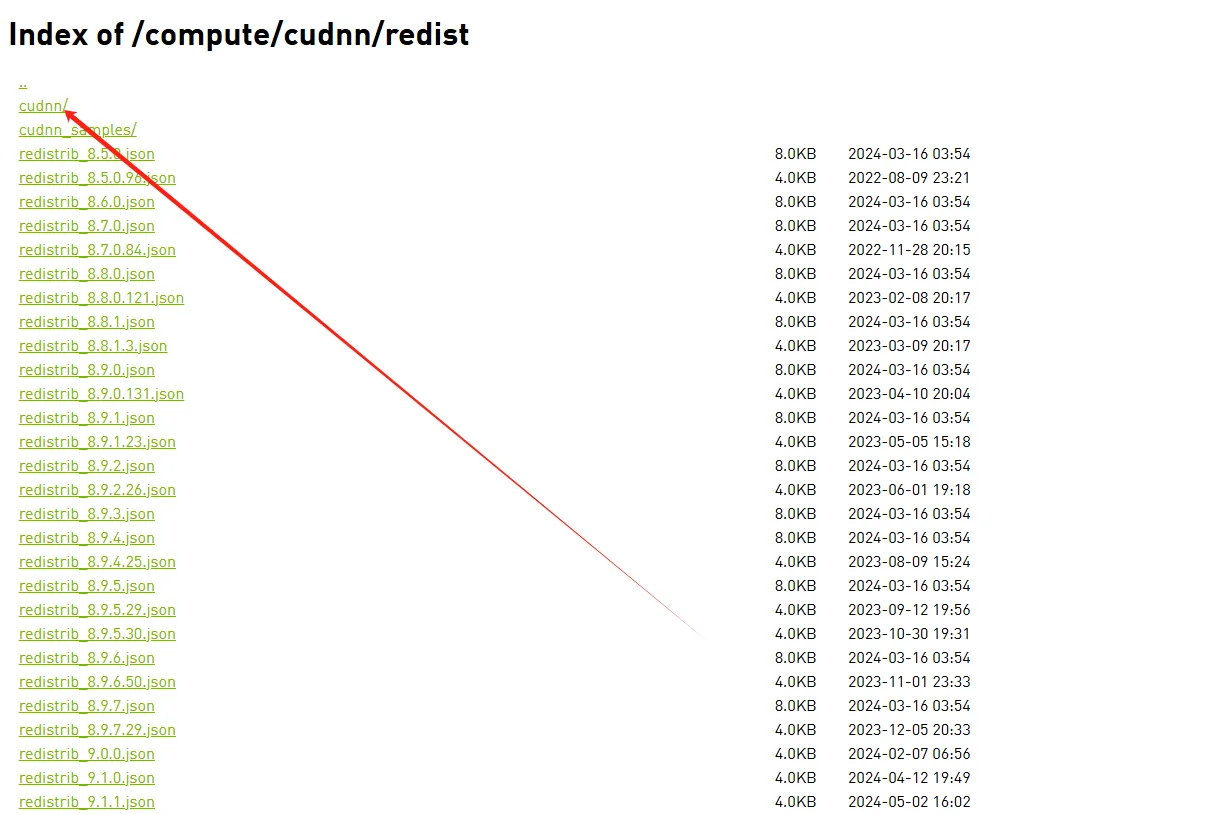

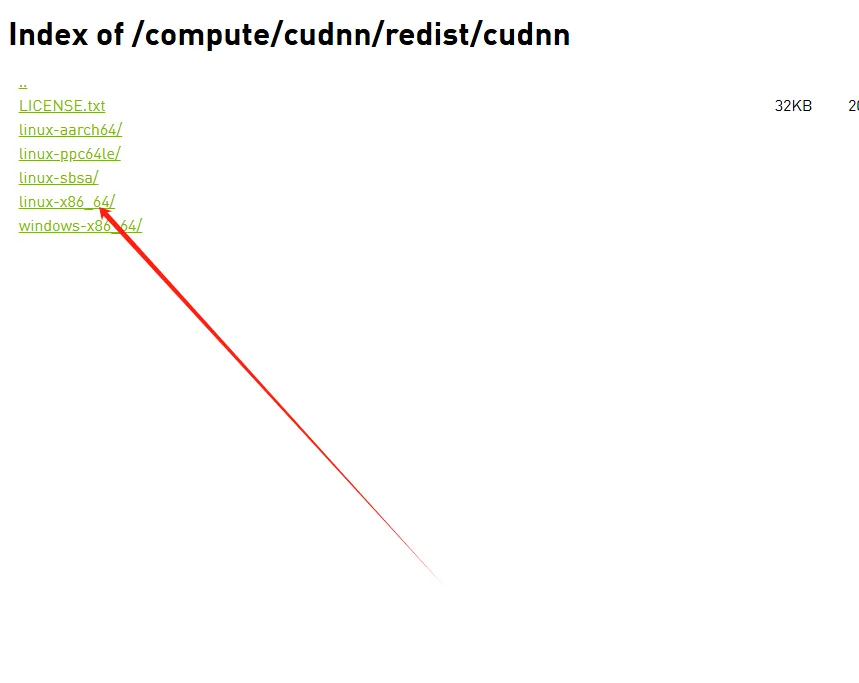

下图为cuDNN对应版本关系

将tar包下载至服务器上,解压tar包,并将文件cp至对应位置命令如下:

tar -xvf cudnn-linux-$arch-8.x.x.x_cudaX.Y-archive.tar.xz

cp cudnn-*-archive/include/cudnn*.h /usr/local/cuda/include

cp -P cudnn-*-archive/lib/libcudnn* /usr/local/cuda/lib64

chmod a+r /usr/local/cuda/include/cudnn*.h /usr/local/cuda/lib64/libcudnn*

#加上版本号后,实际执行命令如下

tar -xvf cudnn-linux-x86_64-8.9.7.29_cuda12-archive.tar.xz

cp cudnn-linux-x86_64-8.9.7.29_cuda12-archive/include/cudnn*.h /usr/local/cuda/include

cp -P cudnn-linux-x86_64-8.9.7.29_cuda12-archive/lib/libcudnn* /usr/local/cuda/lib64

chmod a+r /usr/local/cuda/include/cudnn*.h /usr/local/cuda/lib64/libcudnn*使用以下命令查看cuDNN是否配置完成

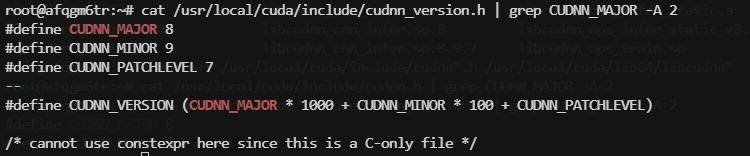

cat /usr/local/cuda/include/cudnn_version.h | grep CUDNN_MAJOR -A 2