工业设施数字孪生中的机器人模拟

文章目录

- 工业设施数字孪生中的机器人模拟

-

- 数字孪生技术的价值

- [NVIDIA Omniverse平台](#NVIDIA Omniverse平台)

- 工业机器人仿真的核心组件

- [示例一:使用Isaac Sim创建基本机器人场景](#示例一:使用Isaac Sim创建基本机器人场景)

- 示例二:机器人运动规划和轨迹执行

- 示例三:传感器集成与感知模拟

- 数字孪生仿真的优势

- 实际应用场景

- 总结

- 参考资料

在当今智能制造的时代,工业设施数字孪生技术正在彻底改变我们设计、测试和优化机器人系统的方式。NVIDIA提供的先进仿真技术允许工程师在虚拟环境中准确模拟机器人行为,从而加速开发周期,降低成本,并提高最终部署系统的质量和安全性。本文将探讨如何利用NVIDIA的工具在工业设施数字孪生中进行机器人模拟。

数字孪生技术的价值

数字孪生是真实物理对象或系统的虚拟复制品,它能够在虚拟环境中模拟真实世界的行为和性能。在工业自动化领域,数字孪生特别有价值,因为它们允许工程师:

- 在物理硬件可用之前进行设计和测试

- 加速开发过程而不损害质量

- 在不中断生产或危及设备的情况下进行实验

- 轻松测试各种操作场景和边缘情况

NVIDIA Omniverse平台

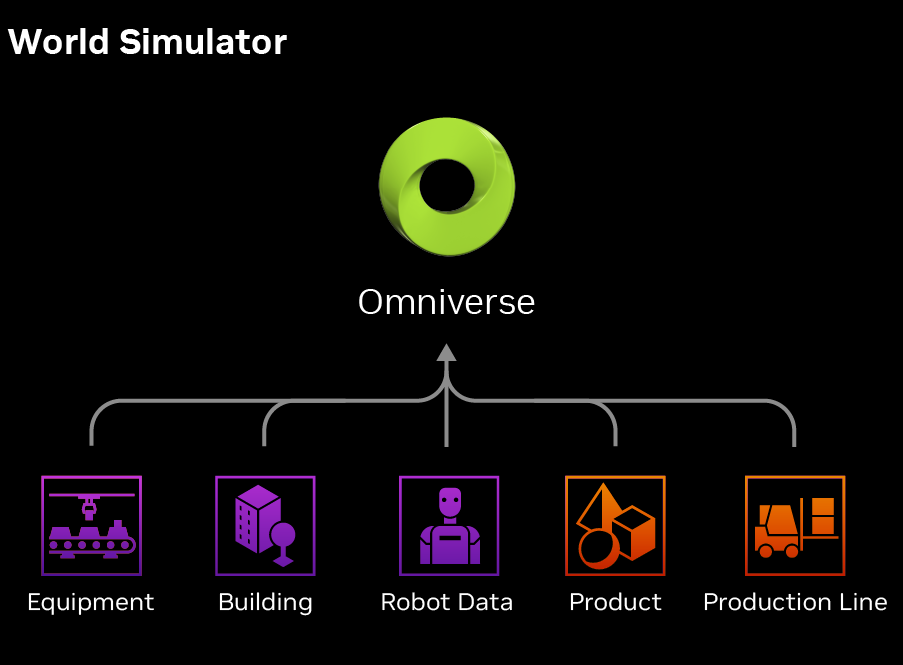

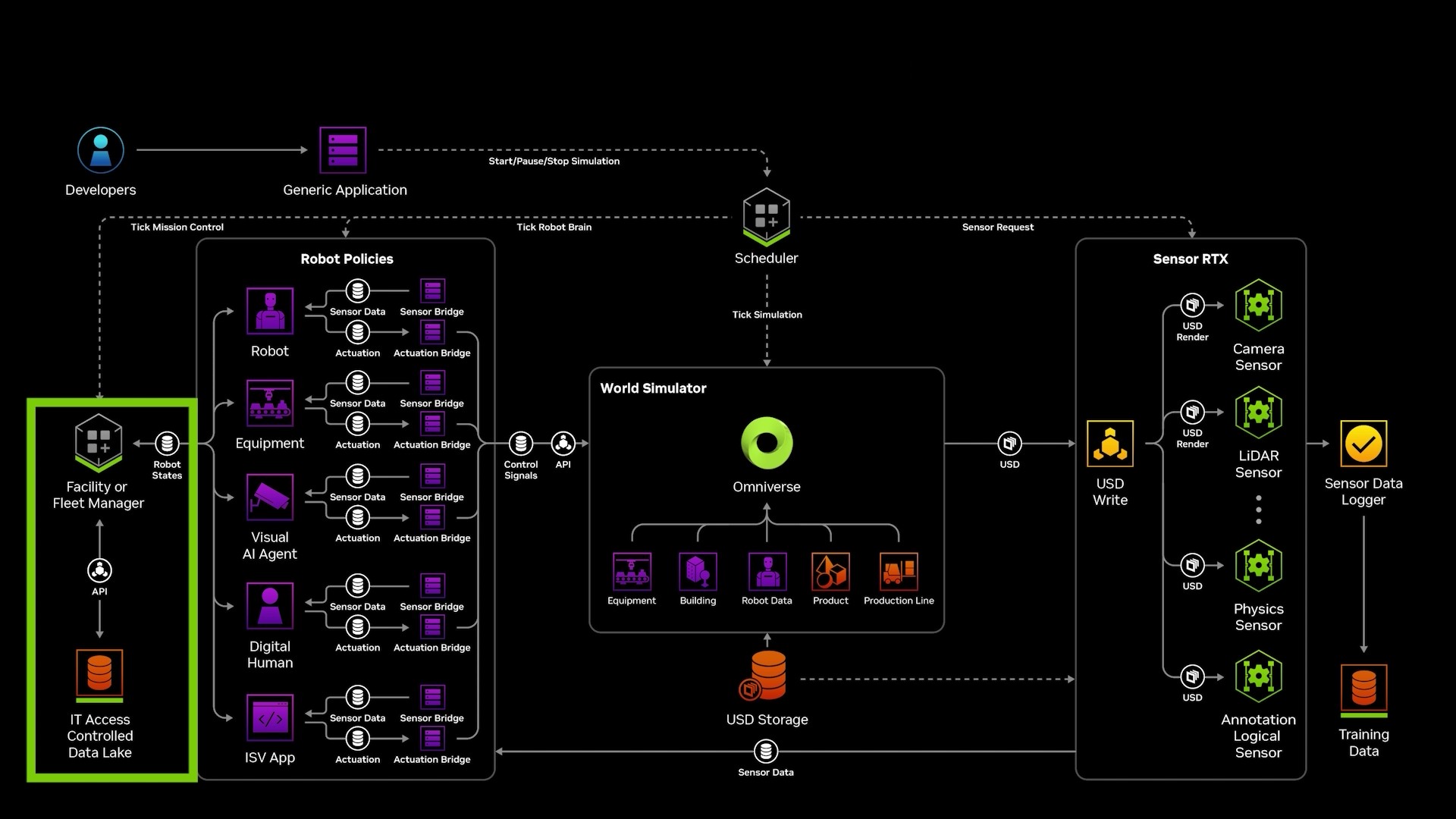

NVIDIA Omniverse是构建数字孪生的理想平台,它提供了基于USD(通用场景描述)的协作环境,支持实时物理仿真和逼真的渲染。对于机器人模拟,Omniverse集成了多种工具:

- Isaac Sim:专为机器人仿真设计

- Omniverse Physics:提供高精度物理仿真

- RTX渲染:生成逼真的视觉效果

- OmniGraph:用于创建仿真逻辑

工业机器人仿真的核心组件

在工业环境中模拟机器人系统需要几个关键组件:

- 精确的3D场景:包括工厂布局、设备和障碍物

- 机器人模型:具有正确关节、动力学和运动学的精确表示

- 传感器仿真:模拟相机、激光雷达和其他传感器

- 控制系统:实现机器人的决策和动作逻辑

- 物理引擎:提供真实的物理交互

示例一:使用Isaac Sim创建基本机器人场景

以下是使用NVIDIA Isaac Sim创建基本工业机器人仿真场景的代码示例:

python

import omni.isaac.core.utils.stage as stage_utils

from omni.isaac.core.robots import Robot

from omni.isaac.core.utils.nucleus import get_assets_root_path

from omni.isaac.core.prims import RigidPrim

import numpy as np

# 初始化机器人仿真场景

stage = stage_utils.create_new_stage()

assets_root_path = get_assets_root_path()

# 加载工厂环境

# 注意:这里我们加载的是一个预制的工厂环境USD文件

factory_env_path = assets_root_path + "/Environments/Factory/factory_floor.usd"

stage_utils.add_reference_to_stage(factory_env_path, "/World/Factory")

# 加载工业机器人模型

# 这里使用的是一个通用的UR10机器人模型

robot_path = assets_root_path + "/Robots/UR10/ur10.usd"

robot_prim_path = "/World/Robot"

stage_utils.add_reference_to_stage(robot_path, robot_prim_path)

# 创建一个机器人对象,用于控制

robot = Robot(

prim_path=robot_prim_path,

name="industrial_robot",

position=np.array([0, 0, 0]) # 设置机器人在场景中的位置

)

# 添加一个工作台作为机器人的工作区域

workbench_path = assets_root_path + "/Props/Industrial/workbench.usd"

stage_utils.add_reference_to_stage(workbench_path, "/World/Workbench")

# 设置工作台位置,使其位于机器人前方

workbench = RigidPrim(

prim_path="/World/Workbench",

name="robot_workbench",

position=np.array([1.0, 0, 0]) # 工作台放置在机器人前方1米处

)

# 添加一些工作对象(如零件)

part_path = assets_root_path + "/Props/Industrial/metal_part.usd"

stage_utils.add_reference_to_stage(part_path, "/World/Part")

part = RigidPrim(

prim_path="/World/Part",

name="target_part",

position=np.array([1.0, 0, 0.5]) # 零件放在工作台上

)

# 设置物理属性

# 为零件添加物理属性,使其能够被抓取和移动

part.get_applied_physics_rep().enable_rigid_body_physics()

part.get_applied_physics_rep().set_mass(1.0) # 设置零件质量为1千克

print("工业机器人仿真场景已创建完成")这段代码展示了如何创建一个基本的工业机器人仿真场景,包括加载工厂环境、放置机器人和工作对象,以及设置基本的物理属性。

示例二:机器人运动规划和轨迹执行

下面的代码展示了如何为工业机器人实现基本的运动规划和轨迹执行:

python

import omni.isaac.motion_generation as mg

from omni.isaac.core.articulations import ArticulationController

import numpy as np

import time

# 假设我们已经有了上面示例中创建的机器人

# 这里我们将实现机器人的运动规划和执行

# 创建运动控制器

controller = ArticulationController(robot.get_articulation())

# 定义机器人的关节目标位置(弧度)

# 这里示例了一系列关节角度,代表机器人的不同姿态

home_position = np.array([0.0, -1.57, 0.0, -1.57, 0.0, 0.0]) # 机器人的初始姿态

pick_position = np.array([0.5, -1.0, 0.5, -1.2, 1.57, 0.0]) # 抓取姿态

place_position = np.array([-0.5, -1.0, 0.5, -1.2, 1.57, 0.0]) # 放置姿态

# 创建运动规划器

# RRT(快速随机树)是一种常用的路径规划算法

motion_planner = mg.lula.RRT(

robot_articulation=robot.get_articulation(),

robot_prim_path=robot_prim_path

)

# 设置避障参数

motion_planner.set_collision_check_parameters(

enable_collision_check=True, # 启用碰撞检测

collision_check_distance=0.02, # 碰撞检测距离阈值(米)

self_collision_check=True, # 检查自碰撞

collision_category="robots" # 碰撞类别

)

# 执行拾取和放置任务的函数

def perform_pick_and_place():

"""执行简单的拾取和放置任务"""

print("开始执行拾取和放置任务")

# 步骤1:移动到初始位置

print("移动到初始位置...")

plan_to_home = motion_planner.plan_path(

end_joint_positions=home_position,

max_planning_time=2.0 # 最大规划时间(秒)

)

# 检查规划是否成功

if not plan_to_home.success:

print("无法规划到初始位置")

return False

# 执行计划

execute_plan(plan_to_home)

# 步骤2:移动到拾取位置

print("移动到拾取位置...")

plan_to_pick = motion_planner.plan_path(

end_joint_positions=pick_position,

max_planning_time=2.0

)

if not plan_to_pick.success:

print("无法规划到拾取位置")

return False

execute_plan(plan_to_pick)

# 这里应有抓取逻辑

print("抓取物体...")

time.sleep(1) # 模拟抓取动作的时间

# 步骤3:移动到放置位置

print("移动到放置位置...")

plan_to_place = motion_planner.plan_path(

end_joint_positions=place_position,

max_planning_time=2.0

)

if not plan_to_place.success:

print("无法规划到放置位置")

return False

execute_plan(plan_to_place)

# 这里应有释放物体的逻辑

print("释放物体...")

time.sleep(1) # 模拟释放动作的时间

# 返回初始位置

print("返回初始位置...")

plan_to_home_final = motion_planner.plan_path(

end_joint_positions=home_position,

max_planning_time=2.0

)

if not plan_to_home_final.success:

print("无法规划回初始位置")

return False

execute_plan(plan_to_home_final)

print("拾取和放置任务完成")

return True

# 执行规划好的路径

def execute_plan(plan):

"""执行规划好的路径

参数:

plan: 由运动规划器生成的路径计划

"""

# 获取轨迹中的所有路径点

trajectory_points = plan.trajectory.get_trajectory_points()

# 为每个路径点设置控制目标并等待执行完成

for point in trajectory_points:

# 设置关节位置目标

controller.set_joint_positions(point.positions)

# 等待机器人达到目标位置

# 在实际应用中,应该使用传感器反馈来确认位置

time.sleep(0.1) # 简化的等待时间

# 调用函数执行拾取和放置任务

perform_pick_and_place()这段代码演示了如何使用NVIDIA Isaac Sim的运动规划模块为工业机器人创建一个基本的拾取和放置任务。它包括路径规划、碰撞避免和轨迹执行。

示例三:传感器集成与感知模拟

在工业机器人仿真中,传感器仿真是另一个关键方面。以下代码展示了如何集成和使用视觉传感器:

python

import omni.kit.commands

from omni.isaac.sensor import Camera

import numpy as np

import cv2

# 创建相机传感器

# 假设我们已经有了上面示例中的机器人和场景

# 创建机器人末端执行器上的相机

camera_prim_path = "/World/Robot/camera"

# 创建相机传感器

camera = Camera(

prim_path=camera_prim_path,

position=np.array([0, 0, 0.1]), # 相对于末端执行器的位置

orientation=np.array([0, 0, 0, 1]), # 四元数表示的方向

width=640, # 图像宽度(像素)

height=480, # 图像高度(像素)

frequency=20 # 相机帧率(Hz)

)

# 将相机附加到机器人末端执行器

omni.kit.commands.execute(

"CreateRigidConstraintCommand",

constraint_type="Fixed", # 固定约束

source_prim_path="/World/Robot/ee_link", # 机器人末端执行器

target_prim_path=camera_prim_path, # 相机

offset_pos=np.array([0, 0, 0.1]), # 相对位置偏移

offset_rot=np.array([0, 0, 0]) # 相对旋转偏移(欧拉角)

)

# 实现一个简单的视觉处理函数

def process_camera_images():

"""处理相机图像以识别工作区域中的物体"""

# 获取当前相机图像

camera_data = camera.get_current_frame()

if camera_data is None:

print("无法获取相机图像")

return None

# 获取RGB图像和深度图

rgb_image = camera_data["rgb"] # RGB图像

depth_image = camera_data["depth"] # 深度图

# 将RGB图像转换为OpenCV格式用于处理

# RGB图像转BGR(OpenCV使用BGR格式)

bgr_image = cv2.cvtColor(rgb_image, cv2.COLOR_RGB2BGR)

# 简单的图像处理:转换为灰度图并进行阈值分割

# 这只是一个基本示例,实际应用可能需要更复杂的计算机视觉算法

gray_image = cv2.cvtColor(bgr_image, cv2.COLOR_BGR2GRAY)

_, thresh_image = cv2.threshold(gray_image, 128, 255, cv2.THRESH_BINARY)

# 查找轮廓

contours, _ = cv2.findContours(thresh_image, cv2.RETR_EXTERNAL, cv2.CHAIN_APPROX_SIMPLE)

# 如果找到轮廓,处理最大的轮廓(假设它是我们的目标物体)

detected_objects = []

if contours:

# 按轮廓面积排序

sorted_contours = sorted(contours, key=cv2.contourArea, reverse=True)

# 处理最大的几个轮廓

for i, contour in enumerate(sorted_contours[:3]): # 取最大的三个轮廓

# 计算轮廓的边界矩形

x, y, w, h = cv2.boundingRect(contour)

# 计算轮廓中心

center_x = x + w/2

center_y = y + h/2

# 从深度图获取此位置的深度

# 注意:真实应用中应考虑深度图的噪声和有效性

depth = depth_image[int(center_y), int(center_x)]

# 将2D图像坐标转换为3D世界坐标的函数

# 这里简化处理,实际应用需要相机内参和外参进行精确转换

world_x = (center_x - 320) * depth * 0.001 # 简化的计算

world_y = (center_y - 240) * depth * 0.001 # 简化的计算

world_z = depth * 0.001 # 将深度从毫米转换为米

# 添加到检测到的物体列表

detected_objects.append({

"id": i,

"position": [world_x, world_y, world_z],

"size": [w, h],

"contour": contour

})

# 在图像上绘制边界框

cv2.rectangle(bgr_image, (x, y), (x+w, y+h), (0, 255, 0), 2)

cv2.putText(bgr_image, f"Obj {i}", (x, y-10),

cv2.FONT_HERSHEY_SIMPLEX, 0.5, (0, 255, 0), 2)

# 保存处理后的图像(实际应用中可能不需要)

cv2.imwrite("/tmp/processed_image.jpg", bgr_image)

return {

"original_image": rgb_image,

"processed_image": bgr_image,

"depth_image": depth_image,

"detected_objects": detected_objects

}

# 使用相机数据进行物体检测和机器人导航的示例

def visual_servoing_example():

"""使用视觉反馈控制机器人的示例"""

# 获取并处理相机图像

vision_data = process_camera_images()

if vision_data is None or not vision_data["detected_objects"]:

print("未检测到物体")

return

# 获取第一个检测到的物体

target_object = vision_data["detected_objects"][0]

target_position = target_object["position"]

print(f"检测到目标物体,位置: {target_position}")

# 在实际应用中,这里会使用目标位置来规划机器人路径

# 这里只是简单打印信息,实际实现需要与运动规划系统集成

print(f"机器人将移动到目标位置进行抓取")

# 在仿真循环中定期调用视觉处理函数

# 在实际应用中,这应该在仿真的主循环或特定的回调函数中执行

visual_servoing_example()这段代码展示了如何在工业机器人仿真中添加相机传感器,并使用计算机视觉技术处理图像数据以识别和定位物体。这对于视觉引导的机器人任务,如抓取和装配非常重要。

数字孪生仿真的优势

NVIDIA仿真技术为工业机器人开发提供了诸多优势:

- 加速开发周期:在物理原型可用之前测试设计和算法

- 降低成本:减少对物理硬件测试的需求,降低开发和调试成本

- 提高安全性:在虚拟环境中测试极端情况和故障模式,无安全风险

- 优化性能:快速迭代和测试多种配置以找到最佳设置

- 改进协作:不同团队可以同时在同一虚拟环境中工作

- 简化培训:为操作人员提供安全的培训环境

实际应用场景

数字孪生机器人仿真在工业领域有广泛应用:

- 生产线优化:模拟并优化整条生产线的机器人布局和工作流程

- 柔性制造:测试快速切换不同产品生产的能力

- 预测性维护:模拟组件磨损和潜在故障模式

- 人机协作:测试和优化人类工人与机器人的安全协作

- 场景复制:复制真实工厂中的问题场景进行分析和修复

总结

工业设施数字孪生中的机器人仿真是未来智能制造的关键技术。通过NVIDIA提供的强大工具,工程师可以创建高度逼真的虚拟环境,模拟机器人操作,优化性能,并在物理部署前识别潜在问题。

随着计算能力的不断提升和仿真技术的进步,我们可以期待数字孪生技术在工业自动化中发挥越来越重要的作用,推动智能制造进入新的发展阶段。