本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。

最近在 GitHub 上发现了一个超级硬核的大语言模型(LLM)课程,它提供了一套完整的学习路线图和可以直接上手的 Colab 笔记,目标就是带你从入门到精通,无论是想深入研究模型,还是想开发应用,都能找到清晰的路径。

这个项目真心不错,结构化得特别好,把复杂的 LLM 领域拆解成了三个清晰的部分,对想系统学习的同学来说,简直是福音。

快速上手

想体验这门课程?非常简单,不需要复杂的环境配置,一个浏览器就够了。

- 访问项目:打开 GitHub 项目主页,先点个 Star 收藏一下。

- 选择路径 :根据你的兴趣,选择

The LLM Scientist(聚焦于构建和优化模型)或The LLM Engineer(聚焦于构建和部署应用)的学习路线。 - 打开 Notebook:在项目里找到你感兴趣的 Notebook,比如"Fine-tune Llama 3.1 with Unsloth",点击旁边的 "Open in Colab" 按钮,直接在浏览器里跟着代码跑起来。

功能演示

这个课程最大的亮点就是它的体系化和实践性。它把学习路径分成了三个阶段,每个阶段都有清晰的路线图。

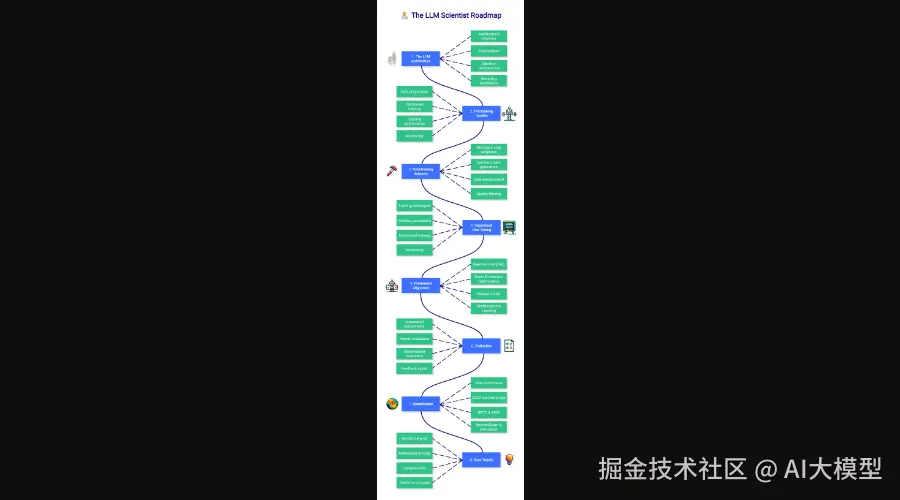

1. LLM 科学家路线

如果你对模型本身更感兴趣,想知道如何训练、微调、评估一个最好的 LLM,这条路线就是为你准备的。

它涵盖了从 Transformer 架构、预训练、监督微调(SFT)、偏好对齐(DPO/RLHF)到模型评估和量化的所有核心环节。

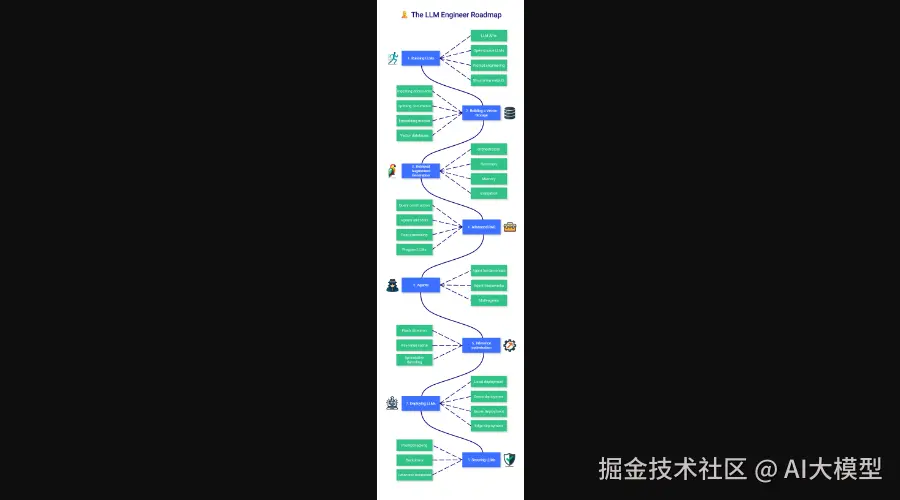

2. LLM 工程师路线

如果你更关注如何用 LLM 来解决实际问题,构建应用,那么工程师路线会更适合你。

这条路径聚焦于如何运行和部署 LLM、构建 RAG(检索增强生成)系统、使用 Agents、优化推理性能,以及如何保障 LLM 应用的安全。

3. 大量即用型代码示例

这门课程最实在的地方在于提供了海量的 Colab Notebooks。这些不是干巴巴的理论,而是可以直接运行的代码。

比如,你想学习如何微调最新的 Llama 3.1 模型?这里有现成的 Notebook:

Fine-tune Llama 3.1 with Unsloth:教你如何在免费的 Colab 环境中高效地进行监督微调。

想了解如何量化模型,让它能在消费级硬件上跑起来?

Quantization with GGUF and llama.cpp:手把手教你用 llama.cpp 量化模型。

这些 Notebook 把学习门槛降到了最低,让你可以快速上手实践,获得正反馈。

项目技术栈

这个项目本身是一个课程,不涉及特定的后端技术栈,但它所教授和使用的技术,基本涵盖了当前 LLM 领域的主流框架和工具。

在"科学家"路径中,你会接触到 PyTorch 、Hugging Face Transformers 、TRL 、Unsloth 和 Axolotl 等用于模型训练和微调的核心库。课程会带你深入理解 LoRA、QLoRA 等参数高效微调技术,以及 DPO 这样的偏好对齐算法。

在"工程师"路径中,则侧重于应用层技术,比如使用 LangChain 和 LlamaIndex 构建 RAG 应用,利用 FAISS 或 Chroma 搭建向量数据库,以及使用 Gradio 或 Streamlit 快速部署应用原型。可以说,这是一个非常全面的技术图谱。

总而言之,这个项目就像一份精心绘制的藏宝图,无论你是 AI 新手还是有经验的开发者,都能从中找到自己的学习路径和宝贵资源。

免费,开源,好用,respect!

GitHub 项目地址: github.com/mlabonne/ll...

学习资源推荐

如果你想更深入地学习大模型,以下是一些非常有价值的学习资源,这些资源将帮助你从不同角度学习大模型,提升你的实践能力。

本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。