欢迎关注[【AIGC论文精读】](https://blog.csdn.net/youcans/category_12321605.html)原创作品

【DeepSeek论文精读】1. 从 DeepSeek LLM 到 DeepSeek R1

【DeepSeek论文精读】13. DeepSeek-OCR: 上下文光学压缩

【DeepSeek论文精读】13. DeepSeek-OCR: 上下文光学压缩

-

- [0. DeepSeek-OCR 模型介绍](#0. DeepSeek-OCR 模型介绍)

-

- [0.1 模型概述](#0.1 模型概述)

- [0.2 论文简介](#0.2 论文简介)

- [0.3 摘要](#0.3 摘要)

- [1. 引言](#1. 引言)

- [2. 相关工作](#2. 相关工作)

-

- [2.1 VLMs中的典型视觉编码器](#2.1 VLMs中的典型视觉编码器)

- [2.2 端到端OCR模型](#2.2 端到端OCR模型)

- [3. 方法](#3. 方法)

-

- [3.1 架构](#3.1 架构)

- [3.2 DeepEncoder](#3.2 DeepEncoder)

-

- [3.2.1 DeepEncoder的架构](#3.2.1 DeepEncoder的架构)

- [3.2.2 多分辨率支持](#3.2.2 多分辨率支持)

- [3.3 MoE解码器](#3.3 MoE解码器)

- [3.4 数据引擎](#3.4 数据引擎)

-

- [3.4.1 OCR 1.0数据](#3.4.1 OCR 1.0数据)

- [3.4.2 OCR 2.0数据](#3.4.2 OCR 2.0数据)

- [3.4.3 通用视觉数据](#3.4.3 通用视觉数据)

- [3.4.4 文本Only数据](#3.4.4 文本Only数据)

- [3.5 训练流程](#3.5 训练流程)

-

- [3.5.1 训练DeepEncoder](#3.5.1 训练DeepEncoder)

- [3.5.2 训练DeepSeek-OCR](#3.5.2 训练DeepSeek-OCR)

- [4. 评估](#4. 评估)

-

- [4.1 视觉-文本压缩研究](#4.1 视觉-文本压缩研究)

- [4.2 OCR实际性能](#4.2 OCR实际性能)

- [4.3 定性研究](#4.3 定性研究)

-

- [4.3.1 深度解析](#4.3.1 深度解析)

- [4.3.2 多语言识别](#4.3.2 多语言识别)

- [4.3.3 通用视觉理解](#4.3.3 通用视觉理解)

- [5. 讨论](#5. 讨论)

- [6. 结论](#6. 结论)

- [7. 项目下载与使用](#7. 项目下载与使用)

- [8. 参考文献](#8. 参考文献)

0. DeepSeek-OCR 模型介绍

2025 年 10月,DeepSeek 在 GitHub 平台开源 DeepSeek-OCR模型,该模型通过光学二维映射压缩技术,在长文本识别场景中实现 97% 的识别精度,为OCR领域树立新的技术标杆。

DeepSeek-OCR模型采用双模块架构设计,由 DeepEncoder 视觉编码器与 DeepSeek3B-MoE-A570M 混合专家解码器构成。其中,DeepEncoder可在处理高分辨率图像时自动维持低激活状态,通过动态压缩生成最优数量的视觉特征令牌(visual tokens),较传统方法减少60%的计算冗余。

0.1 模型概述

-

要解决的问题

- 长文本处理的计算挑战:当前大语言模型处理长文本时面临二次方计算复杂度问题

- 视觉-文本压缩需求:探索如何利用视觉模态作为文本信息的高效压缩媒介

- OCR效率优化:解决传统OCR模型需要大量视觉token的问题,探索最少需要多少视觉token来解码文本

-

核心架构

- DeepEncoder(380M参数):核心视觉编码器,包含SAM-base(80M)和CLIP-large(300M)串联

- MoE解码器:基于DeepSeek-3B-MoE,激活参数约570M

-

关键技术

- 分层编码设计

- 多分辨率支持

- 高效数据引擎

-

主要结果

- 当文本令牌数量在视觉令牌数量的 10 倍以内(即压缩比 < 10倍)时,模型可以实现 97% 的解码(OCR)精度。

- 在 20倍 的压缩比下,OCR 准确率仍保持在约 60%。

0.2 论文简介

- 论文标题:DeepSeek-OCR: Contexts Optical Compression(DeepSeek-OCR:上下文光学压缩)

- 发布时间:2025 年 10 月

- 论文作者:HaoranWei, Yaofeng Sun, Yukun Li

下载地址: arxiv

项目地址: github, Hugging Face

0.3 摘要

我们提出 DeepSeek-OCR,作为通过光学二维映射压缩长上下文的可行性初步研究。

DeepSeek-OCR 包含两个组件:DeepEncoder 和作为解码器的 DeepSeek3B-MoE-A570M。具体而言,DeepEncoder 作为核心引擎,旨在高分辨率输入下保持低激活量,同时实现高压缩比,以确保视觉令牌数量达到最优且易于管理。

实验表明,当文本令牌数量在视觉令牌数量的 10 倍以内(即压缩比 < 10倍)时,模型可以实现 97% 的解码(OCR)精度。即使在 20倍 的压缩比下,OCR 准确率仍保持在约 60%。这对于历史长上下文压缩和大型语言模型中的记忆遗忘机制等研究领域展现了可观的前景。除此之外,DeepSeek-OCR 也展示了很高的实用价值。在 OmniDocBench 上,它仅使用 100 个视觉令牌就超越了 GOT-OCR2.0(每页 256 令牌),并且在使用少于 800 个视觉令牌的同时,性能超过了 MinerU2.0(平均每页 6000+ 令牌)。在实际生产中,DeepSeek-OCR 每天(单张 A100-40G)可以生成 20万+ 页的 LLM/VLM 训练数据。

代码和模型权重公开在 http://github.com/deepseek-ai/DeepSeek-OCR。

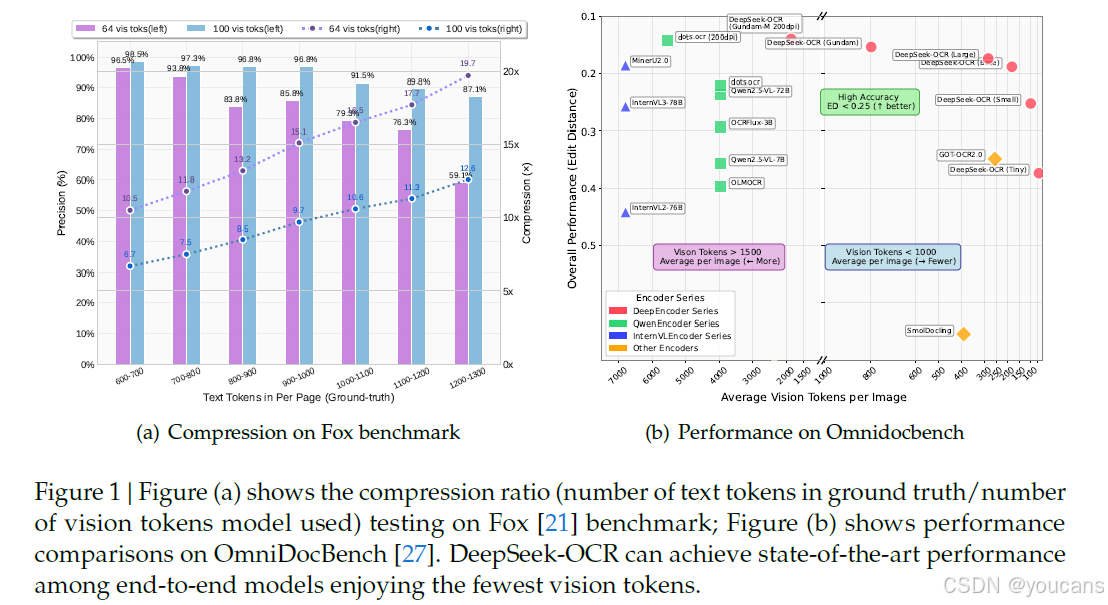

图 1 | 图 (a) 显示了在 Fox [21] 基准测试中的压缩比(真实文本标记数/模型使用的视觉标记数);图 (b) 显示了在 OmniDocBench [27] 上的性能比较。

DeepSeek-OCR 可以在享受最少视觉标记的数量的同时,实现端到端模型中的最佳性能。

1. 引言

当前的大型语言模型在处理长文本内容时,由于序列长度的二次方缩放特性,面临着显著的计算挑战。我们探索了一种潜在的解决方案:利用视觉模态作为文本信息的高效压缩媒介。包含文档文本的单个图像可以用比等效数字文本少得多的令牌来表示丰富的信息,这表明通过视觉令牌进行光学压缩可以实现更高的压缩比。

这一见解促使我们从以LLM为中心的视角重新审视视觉语言模型,重点关注视觉编码器如何提高LLM处理文本信息的效率,而非人类擅长的基本VQA [12; 16; 24; 32; 41]。OCR任务作为连接视觉和语言的中间模态,为这种视觉-文本压缩范式提供了理想的试验场,因为它们在视觉和文本表示之间建立了自然的压缩-解压缩映射,同时提供了定量评估指标。

据此,我们提出了DeepSeek-OCR,这是一个VLM,旨在作为高效视觉-文本压缩的初步概念验证。我们的工作做出了三个主要贡献:

-

首先,我们提供了视觉-文本令牌压缩比的全面定量分析。在具有多样化文档布局的Fox [21]基准测试中,我们的方法在9-10倍文本压缩下实现了96%以上的OCR解码精度,在10-12倍压缩下达到约90%,在20倍压缩下达到约60%(考虑到输出与真实值之间的格式差异,实际准确率甚至更高),如图1(a)所示。结果表明,紧凑的语言模型可以有效地学习解码压缩的视觉表示,这表明更大的LLM通过适当的预训练设计可以轻松获得类似的能力。

-

其次,我们引入了DeepEncoder,这是一种新颖的架构,即使在高分辨率输入下也能保持低激活内存和最少的视觉令牌。它通过一个16倍卷积压缩器串联连接窗口注意力和全局注意力编码器组件。这种设计确保了窗口注意力组件处理大量视觉令牌,而压缩器在视觉令牌进入密集的全局注意力组件之前减少其数量,从而实现有效的内存和令牌压缩。

-

第三,我们基于DeepEncoder和DeepSeek3B-MoE [19; 20]开发了DeepSeek-OCR。如图1(b)所示,它在OmniDocBench上的端到端模型中实现了最先进的性能,同时使用了最少的视觉令牌。此外,我们还为模型配备了解析图表、化学公式、简单几何图形和自然图像的能力,以进一步增强其实用性。在生产中,DeepSeek-OCR每天可以使用20个节点(每个节点配备8个A100-40G GPU)为LLM或VLM生成3300万页数据。

总之,这项工作对使用视觉模态作为LLM中文本信息处理的高效压缩媒介进行了初步探索。通过DeepSeek-OCR,我们证明了视觉-文本压缩可以为不同的历史上下文阶段实现显著的令牌减少(7-20倍),为解决大型语言模型中的长上下文挑战提供了一个有前景的方向。我们的定量分析为VLM令牌分配优化提供了经验指导,而提出的DeepEncoder架构展示了实际可行性及现实部署能力。尽管作为概念验证专注于OCR,但这种范式为重新思考如何协同结合视觉和语言模态以增强大规模文本处理和智能体系统中的计算效率开辟了新的可能性。

2. 相关工作

2.1 VLMs中的典型视觉编码器

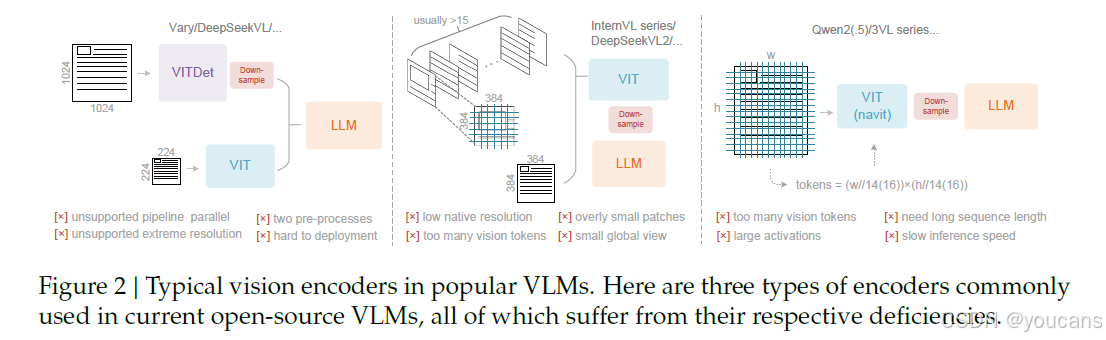

当前开源的VLM主要采用三种类型的视觉编码器,如图2所示。

第一种是以Vary [36]为代表的双塔架构,它利用并行的SAM [17]编码器来增加视觉词汇参数以处理高分辨率图像。虽然这种方法提供了可控的参数和激活内存,但它存在显著缺点:需要双图像预处理,这使部署复杂化,并在训练时使编码器流水线并行具有挑战性。

第二种是以InternVL2.0 [8]为代表的基于分块的方法,该方法通过将图像分割成小块进行并行计算来处理图像,在高分辨率设置下减少激活内存。尽管能够处理极高的分辨率,但由于其通常较低的本机编码器分辨率(低于512x512),这种方法存在显著限制,导致大图像过度碎片化并产生大量视觉令牌。

第三种是以Qwen2-VL [35]为代表的自适应分辨率编码,它采用NaViT [10]范式,通过基于图像块的分割直接处理完整图像,而无需分块并行化。虽然这种编码器可以灵活处理不同的分辨率,但由于大量激活内存消耗可能导致GPU内存溢出,它在处理大图像时面临巨大挑战,并且序列打包在训练期间需要极长的序列长度。长的视觉令牌会减慢推理的预填充和生成阶段。

图 2 | 流行 VLM 中典型的视觉编码器。这里介绍了三种常用的主题编码器,所有这些编码器都各自存在缺陷。

2.2 端到端OCR模型

OCR,特别是文档解析任务,一直是图像到文本领域非常活跃的主题。随着VLM的发展,大量端到端OCR模型涌现,通过简化OCR系统,从根本上改变了传统 pipeline 架构(该架构需要独立的检测和识别专家模型)。Nougat [6]首次在arXiv上采用端到端框架进行学术论文OCR,展示了模型在处理密集感知任务方面的潜力。GOT-OCR2.0 [38]将OCR 2.0的范围扩展到包括更多合成图像解析任务,并设计了一个在性能和效率之间权衡的OCR模型,进一步凸显了端到端OCR研究的潜力。此外,通用视觉模型如Qwen-VL系列[35]、InternVL系列[8]及其许多衍生模型不断增强其文档OCR能力,以探索密集视觉感知的边界。

然而,当前模型尚未解决一个关键的研究问题是:对于包含1000个单词的文档,至少需要多少视觉令牌才能进行解码? 这个问题对于研究 "一图胜千言" 的原理具有重要意义。

3. 方法

3.1 架构

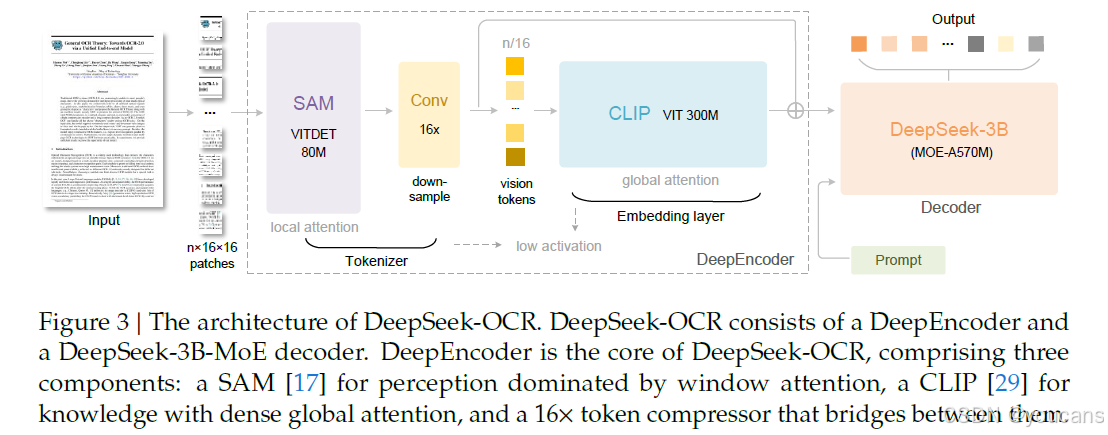

如图3所示,DeepSeek-OCR采用统一的端到端VLM架构,由一个编码器和一个解码器组成。

- 编码器(即DeepEncoder)负责提取图像特征并对视觉表示进行令牌化和压缩。

- 解码器用于根据图像令牌和提示生成所需的结果。

DeepEncoder的参数约为380M,主要由一个80M的SAM-base [17]和一个300M的CLIP-large [29]串联组成。解码器采用3B的MoE [19, 20]架构,激活参数为570M。在接下来的段落中,我们将深入探讨模型组件、数据工程和训练技巧。

图 3 | DeepSeek-OCR 的架构。DeepSeek-OCR由一个DeepEncoder和一个DeepSeek-3B-MoE解码器组成。DeepEncoder是DeepSeek-OCR的核心,包含三个组件:一个以窗口注意力为主的用于感知的SAM [17],一个具有密集全局注意力的用于知识的CLIP [29],以及一个连接它们之间的16倍令牌压缩器。

3.2 DeepEncoder

为了探索上下文光学压缩的可行性,我们需要一个具有以下特征的视觉编码器:

- 能够处理高分辨率;

- 在高分辨率下具有低激活量;

- 视觉令牌数量少;

- 支持多分辨率输入;

- 参数量适中。

然而,如第 2.1节所述,当前的开源编码器不能完全满足所有这些条件。因此,我们自行设计了一种新颖的视觉编码器,命名为DeepEncoder。

3.2.1 DeepEncoder的架构

DeepEncoder主要由两个组件组成:一个以窗口注意力为主的视觉感知特征提取组件,以及一个具有密集全局注意力的视觉知识特征提取组件。

为了受益于前人工作的预训练成果,我们分别使用SAM-base(patch-size 16)和CLIP-large作为这两个组件的主要架构。对于CLIP,我们移除了第一个patch embedding层,因为其输入不再是图像,而是来自前一个流水线的输出令牌。在两个组件之间,我们借鉴了Vary [36]的方法,使用一个2层卷积模块对视觉令牌进行16倍下采样。每个卷积层的核大小为3,步长为2,填充为1,通道数从256增加到1024。

假设我们输入一张1024×1024的图像,DeepEncoder会将其分割成1024/16 × 1024/16 = 4096个patch令牌。由于编码器的前半部分以窗口注意力为主且仅有80M参数,其激活量是可接受的。在进入全局注意力之前,4096个令牌会经过压缩模块,令牌数量变为4096/16 = 256,从而使整体激活内存可控。

3.2.2 多分辨率支持

假设我们有一张包含1000个光学字符的图像,我们想测试解码需要多少视觉令牌。这就要求模型支持可变数量的视觉令牌。也就是说,DeepEncoder需要支持多分辨率。

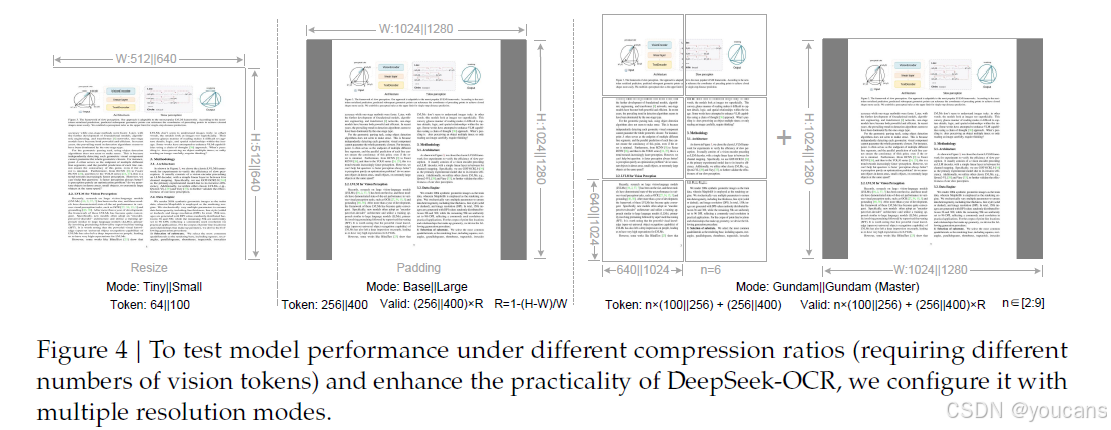

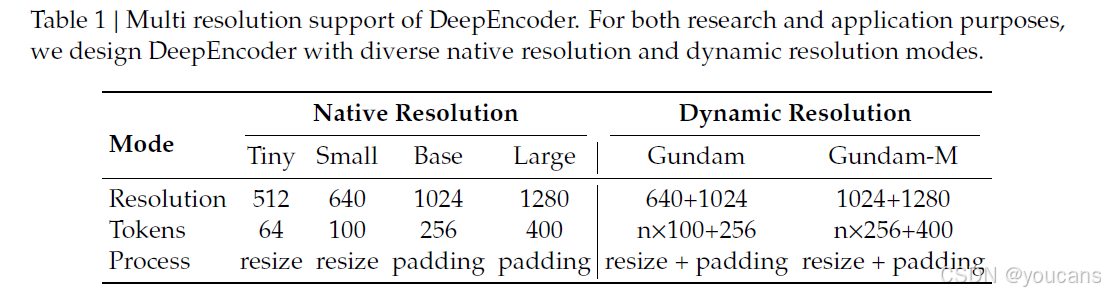

我们通过位置编码的动态插值来满足上述要求,并设计了若干分辨率模式用于同步模型训练,以实现单个DeepSeek-OCR模型支持多分辨率的能力。如图4所示,DeepEncoder主要支持两种主要的输入模式:原生分辨率和动态分辨率。每种模式都包含多个子模式。

原生分辨率支持四种子模式:Tiny、Small、Base 和 Large,对应的分辨率和令牌数量分别为 512×512(64)、640×640(100)、1024×1024(256)和 1280×1280(400)。由于 Tiny 和 Small 模式的分辨率相对较小,为避免浪费视觉令牌,图像通过直接调整原始形状来处理。对于 Base 和 Large 模式,为了保持原始图像的宽高比,图像会被填充到相应尺寸。填充后,有效视觉令牌的数量少于实际视觉令牌的数量,计算公式如下:

𝑁 𝑣 𝑎 𝑙 𝑖 𝑑 = ⌈ 𝑁 𝑎 𝑐 𝑡 𝑢 𝑎 𝑙 × [ 1 − ( ( 𝑚 𝑎 𝑥 ( 𝑤 , h ) − 𝑚 𝑖 𝑛 ( 𝑤 , h ) ) / ( 𝑚 𝑎 𝑥 ( 𝑤 , h ) ) ) ] ⌉ 𝑁𝑣𝑎𝑙𝑖𝑑 = ⌈𝑁𝑎𝑐𝑡𝑢𝑎𝑙 × [1 − ( (𝑚𝑎𝑥(𝑤, ℎ) − 𝑚𝑖𝑛(𝑤, ℎ))/(𝑚𝑎𝑥(𝑤, ℎ)))]⌉ Nvalid=⌈Nactual×[1−((max(w,h)−min(w,h))/(max(w,h)))]⌉

其中 𝑤 和 ℎ 表示原始输入图像的宽度和高度。

动态分辨率可以由两种原生分辨率组合而成。例如,Gundam 模式包含 n×640×640 的分块(局部视图)和一个 1024×1024 的全局视图。分块方法遵循 InternVL2.0 [8]。支持动态分辨率主要是出于应用考虑,特别是针对超高分辨率输入(如报纸图像)。分块是次级窗口注意力的一种形式,可以进一步有效降低激活内存。值得注意的是,由于我们的原生分辨率相对较大,在动态分辨率下图像不会过度碎片化(分块数量控制在 2 到 9 的范围内)。在 Gundam 模式下,DeepEncoder 输出的视觉令牌数量为:𝑛 × 100 + 256,其中 𝑛 是分块数量。对于宽度和高度均小于 640 的图像,𝑛 设置为 0,即 Gundam 模式将降级为 Base 模式。

Gundam 模式与四种原生分辨率模式一起训练,以实现单一模型支持多种分辨率的目标。需要注意的是,Gundam-master 模式(1024×1024 局部视图 + 1280×1280 全局视图)是通过在训练好的 DeepSeek-OCR 模型上继续训练得到的。这主要是为了负载均衡,因为 Gundam-master 的分辨率过大,一起训练会降低整体训练速度。

图 4 | 为了在不同压缩率(需要不同数量的视觉令牌)下测试模型性能,并提升 DeepSeek-OCR 的实用性,我们为其配置了多种分辨率模式。

3.3 MoE解码器

我们的解码器使用DeepSeekMoE [19; 20],具体来说是DeepSeek-3B-MoE。在推理过程中,模型从64个路由专家中激活6个以及2个共享专家,激活参数约为570M。这个3B的DeepSeekMoE非常适合以领域为中心(对我们而言是OCR)的VLM研究,因为它获得了3B模型的表达能力,同时享有500M小模型的推理效率。

解码器从DeepEncoder的压缩潜在视觉令牌中重建原始文本表示:

f dec : R n × d latent → R N × d text ; X ^ = f dec ( Z ) , n ≤ N f_{\text{dec}}:\mathbb{R}^{n\times d_{\text{latent}}}\rightarrow\mathbb{R}^{N\times d_{\text{text}}};\quad \hat{\mathbf{X}}=f_{\text{dec}}(\mathbf{Z})\quad,n\leq N fdec:Rn×dlatent→RN×dtext;X^=fdec(Z),n≤N

Z ∈ R n × d latent \mathbf{Z}\in\mathbb{R}^{n\times d_{\text{latent}}} Z∈Rn×dlatent 是来自DeepEncoder的压缩潜在(视觉)令牌,而 X ^ ∈ R N × d text \hat{\mathbf{X}}\in\mathbb{R}^{N\times d_{\text{text}}} X^∈RN×dtext 是重建的文本表示。函数 f dec f_{\text{dec}} fdec 表示一个非线性映射,紧凑的语言模型可以通过OCR风格的训练有效地学习该映射。可以合理推测,通过专门的预训练优化,LLM将展示出对此类能力更自然的整合。

3.4 数据引擎

我们为DeepSeek-OCR构建了复杂多样的训练数据,包括:

- OCR 1.0数据:主要包括传统OCR任务,如场景图像OCR和文档OCR。

- OCR 2.0数据:主要包括复杂人工图像的解析任务,如常见图表、化学公式和平面几何解析数据。

- 通用视觉数据:主要用于向DeepSeek-OCR注入一定的通用图像理解能力,并保留通用视觉接口。

3.4.1 OCR 1.0数据

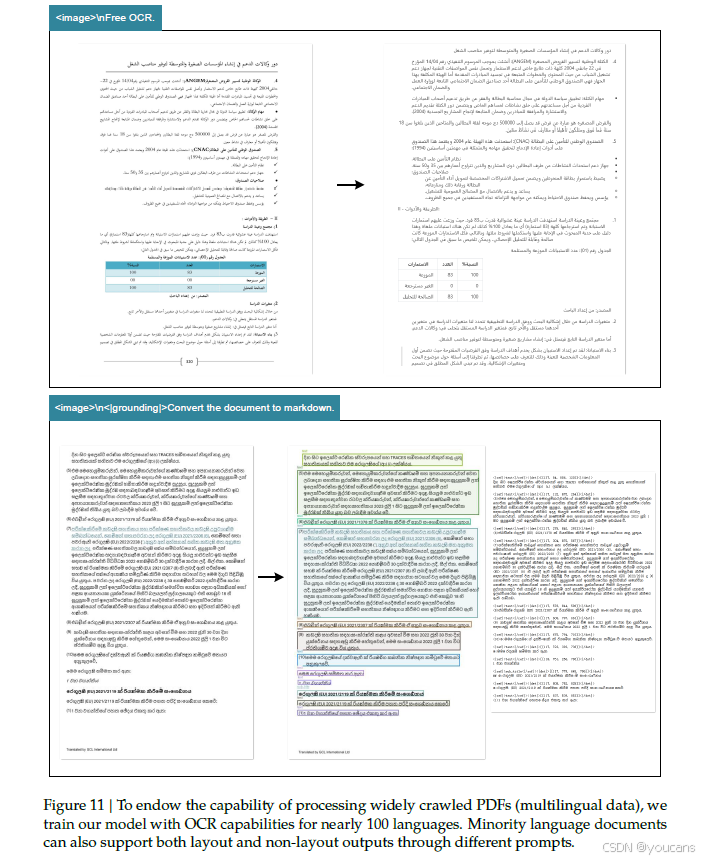

文档数据是DeepSeek-OCR的重中之重。我们从互联网收集了3000万页多样化的PDF数据,覆盖约100种语言,其中中文和英文约占2500万页,其他语言约占500万页。对于这些数据,我们创建了两种类型的真实标注:粗标注和细标注。

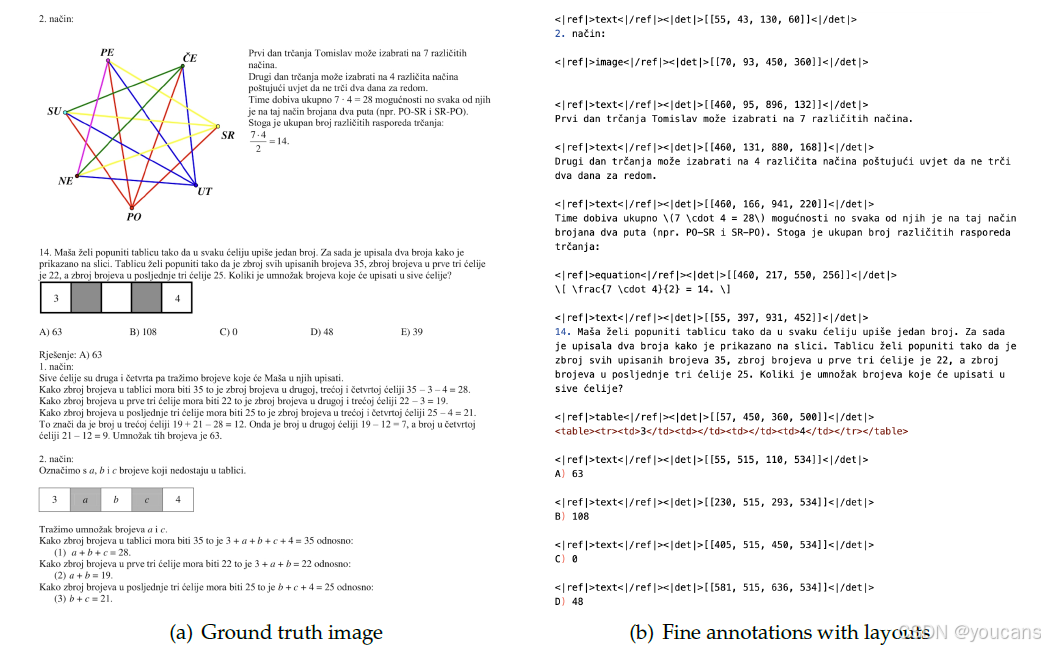

粗标注使用 fitz 从完整数据集中直接提取,旨在教导模型识别光学文本,特别是少数民族语言。细标注包括中文和英文各200万页,使用先进的布局模型(如PP-DocLayout [33])和OCR模型(如MinuerU [34]和GOT-OCR2.0 [38])进行标注,以构建检测和识别交错的数据。对于少数民族语言,在检测部分,我们发现布局模型具有一定的泛化能力。在识别部分,我们使用 fitz 创建小图块数据来训练GOT-OCR2.0,然后使用训练好的模型对布局处理后的小图块进行标注,采用模型飞轮创建了60万个数据样本。在DeepSeek-OCR的训练过程中,粗标签和细标签通过不同的提示词进行区分。细标注图像-文本对的真实标注示例如图5所示。

我们还收集了300万 Word 数据,通过直接提取内容构建没有布局的高质量图像-文本对。这些数据主要对公式和HTML格式的表格有益。此外,我们选择了一些开源数据[28, 37]作为补充。

对于自然场景OCR,我们的模型主要支持中文和英文。图像数据来源为LAION [31]和Wukong [13],使用PaddleOCR [9]进行标注,中文和英文各1000万个数据样本。与文档OCR类似,自然场景OCR也可以通过提示词控制是否输出检测框。

图 5 | OCR 1.0 细标注展示。我们将 ground truth 格式化为交错布局和文本格式,其中每个文本段落前都有其在原图中的坐标和标签。所有坐标都归一化为 1000 个区间。

3.4.2 OCR 2.0数据

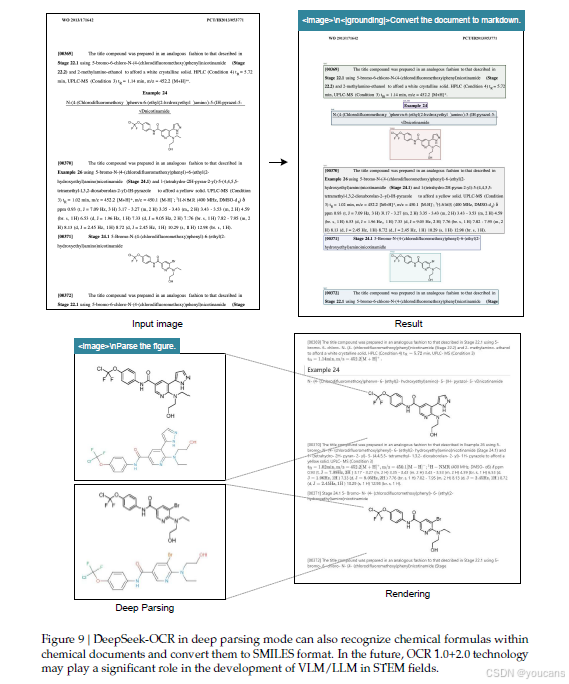

遵循GOT-OCR2.0 [38]的方法,我们将图表、化学公式和平面几何解析数据称为OCR 2.0数据。

-

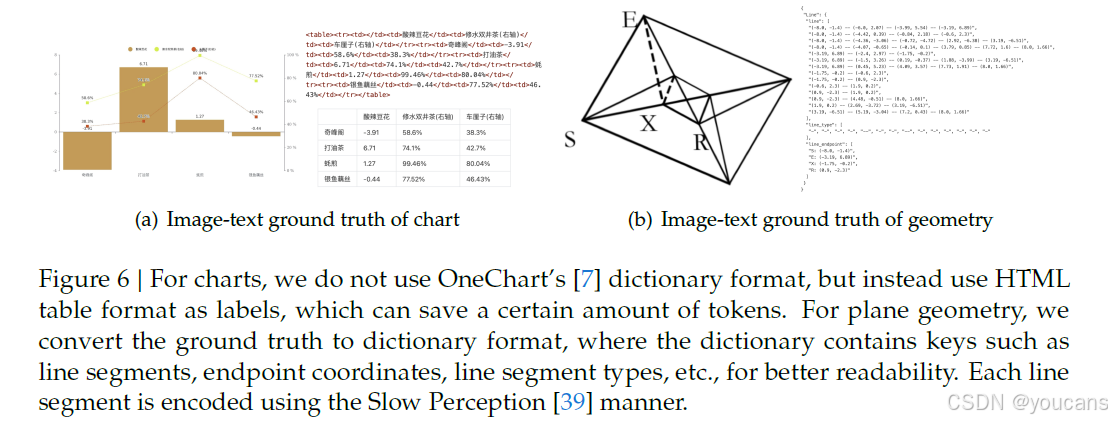

对于图表数据,遵循OneChart [7]的方法,我们使用pyecharts和matplotlib渲染1000万张图像,主要包括常用的折线图、柱状图、饼图和复合图表。我们将图表解析定义为图像到HTML表格的转换任务,如图6(a)所示。

-

对于化学公式,我们利用PubChem中的SMILES格式作为数据源,并使用RDKit将其渲染成图像,构建了500万个图像-文本对。

-

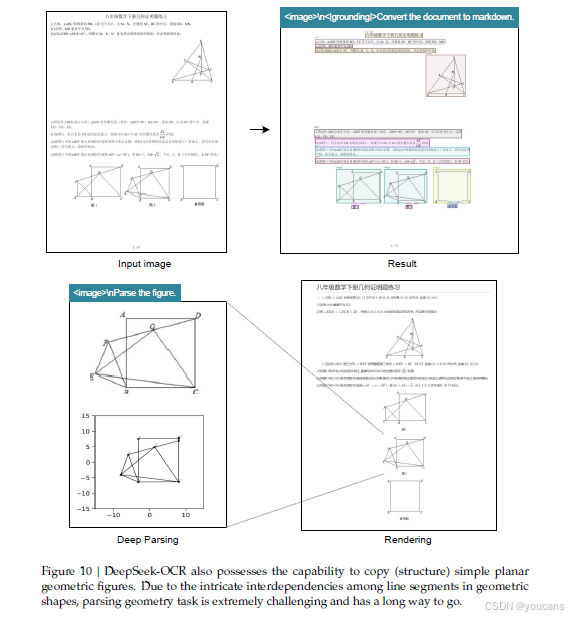

对于平面几何图像,我们遵循Slow Perception [39]的方法进行生成。

具体来说,我们使用感知标尺大小为4来建模每个线段。为了增加渲染数据的多样性,我们引入了几何平移不变性数据增强,其中相同的几何图像在原始图像中进行平移,对应于在坐标系中心位置绘制的相同真实标注。基于此,我们总共构建了100万个平面几何解析数据,如图6(b)所示。

图 6 | 对于图表,我们不使用 OneChart [7] 的字典格式,而是使用 HTML 表格格式作为标签,这可以节省一定数量的令牌。对于平面几何,我们将 ground truth 转换为字典格式,其中字典包含线段、端点坐标、线段类型等键,以便于阅读。每个线段采用 Slow Perception [39] 的编码方式。

3.4.3 通用视觉数据

DeepEncoder 能够受益于 CLIP 的预训练成果,并且拥有足够的参数来融合通用视觉知识。因此,我们也为 DeepSeek-OCR 准备了一些相应的数据。遵循 DeepSeek-VL2 [40] 的方法,我们为图像描述、目标检测和定位等任务生成了相关数据。需要注意的是,DeepSeek-OCR 并非通用 VLM 模型,这部分数据仅占总数据量的 20%。我们引入此类数据主要是为了保留通用视觉接口,以便未来对我们模型和通用视觉任务感兴趣的研究人员能够方便地推进他们的工作。

3.4.4 文本Only数据

为确保模型的语言能力,我们引入了10%的内部文本Only预训练数据,所有数据处理成8192个令牌的长度,这也是DeepSeek-OCR的序列长度。总之,在训练DeepSeek-OCR时,OCR数据占70%,通用视觉数据占20%,文本Only数据占10%。

3.5 训练流程

我们的训练流程非常简单,主要包括两个阶段:

a) 独立训练 DeepEncoder;

b) 训练完整的 DeepSeek-OCR。

需要注意的是,Gundam-master 模式是通过在预训练的 DeepSeek-OCR 模型上使用 600 万采样数据继续训练得到的。由于训练协议与其他模式相同,我们在后续内容中省略详细描述。

3.5.1 训练DeepEncoder

遵循Vary [36]的方法,我们利用一个紧凑的语言模型[15]并使用下一令牌预测框架来训练DeepEncoder。在此阶段,我们使用前面提到的所有OCR 1.0和2.0数据,以及从LAION [31]数据集中采样的1亿通用数据。所有数据训练2个周期,批大小为1280,使用AdamW [23]优化器,采用余弦退火调度器[22],学习率为5e-5。训练序列长度为4096。

3.5.2 训练DeepSeek-OCR

在DeepEncoder准备就绪后,我们使用第3.4节中提到的数据来训练DeepSeek-OCR,整个训练过程在HAI-LLM [14]平台上进行。整个模型使用流水线并行(PP),分为4个部分,其中DeepEncoder占两部分,解码器占两部分。对于DeepEncoder,我们将SAM和压缩器视为视觉令牌化器,将它们放置在PP0中并冻结其参数,同时将CLIP部分作为输入嵌入层放置在PP1中,并解冻权重进行训练。对于语言模型部分,由于DeepSeek3B-MoE有12层,我们在PP2和PP3上各放置6层。我们使用20个节点(每个节点配备8个A100-40G GPU)进行训练,数据并行(DP)度为40,全局批大小为640。我们使用AdamW优化器,采用基于步长的调度器,初始学习率为3e-5。对于纯文本数据,训练速度为每天900亿令牌,而对于多模态数据,训练速度为每天700亿令牌。

4. 评估

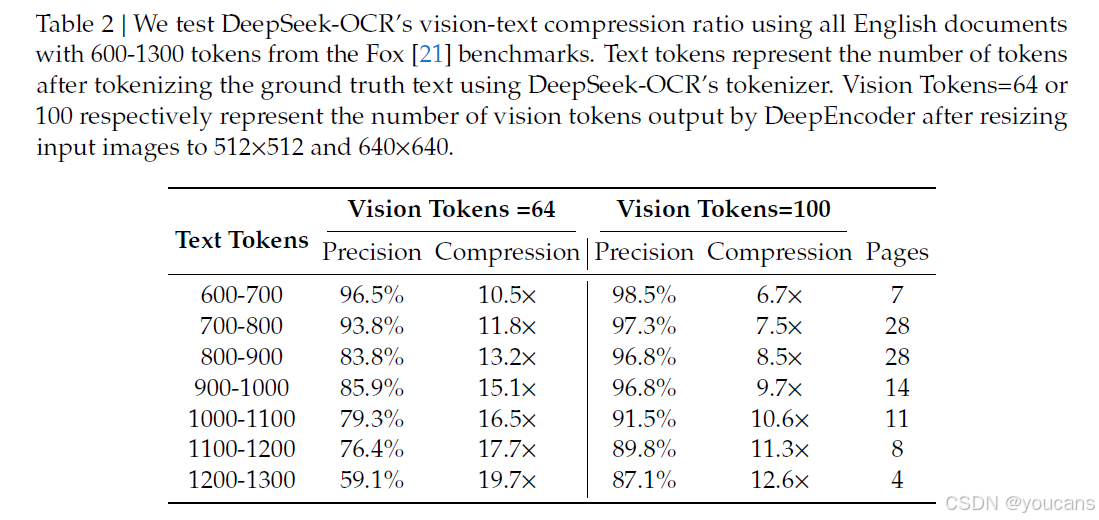

4.1 视觉-文本压缩研究

我们选择Fox [21]基准测试来验证DeepSeek-OCR对文本丰富文档的压缩-解压缩能力,以初步探索上下文光学压缩的可行性和边界。我们使用Fox的英文文档部分,用DeepSeek-OCR的分词器(词汇量约12.9万)对真实文本进行分词,并选择包含600-1300个令牌的文档进行测试,正好是100页。由于文本令牌数量不大,我们只需要测试Tiny和Small模式的性能,其中Tiny模式对应64个令牌,Small模式对应100个令牌。我们使用提示词"\nFree OCR."(无布局)来控制模型的输出格式。尽管如此,输出格式仍然无法完全匹配Fox基准测试,因此实际性能会比测试结果稍高一些。

如表2所示,在10倍压缩比内,模型的解码精度可以达到约97%,这是一个非常有希望的结果。未来,通过文本到图像的方法,可能实现近10倍的无损上下文压缩。当压缩比超过10倍时,性能开始下降,这可能有两个原因:一是长文档的布局变得更加复杂,另一个原因可能是长文本在512×512或640×640分辨率下变得模糊。第一个问题可以通过将文本渲染到单一布局页面来解决,而我们相信第二个问题将成为遗忘机制的一个特征。

当令牌压缩接近20倍时,我们发现精度仍能接近60%。这些结果表明,光学上下文压缩是一个非常值得研究的方向,而且这种方法不会带来任何额外开销,因为它可以利用VLM基础设施,而多模态系统本身就需要额外的视觉编码器。

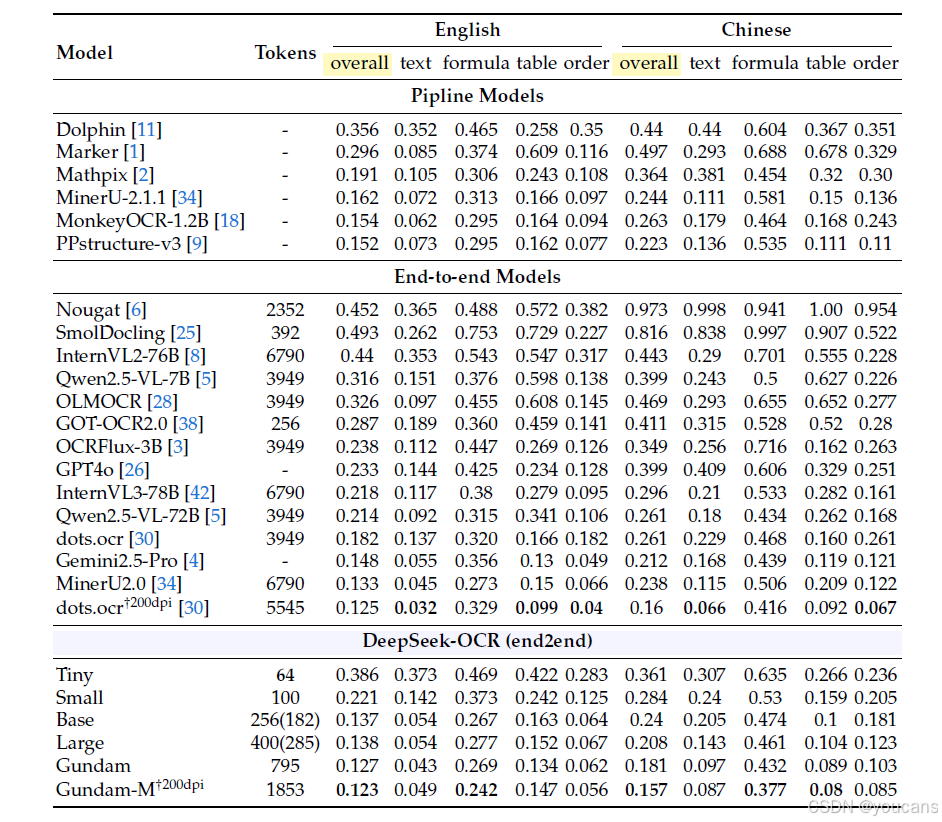

4.2 OCR实际性能

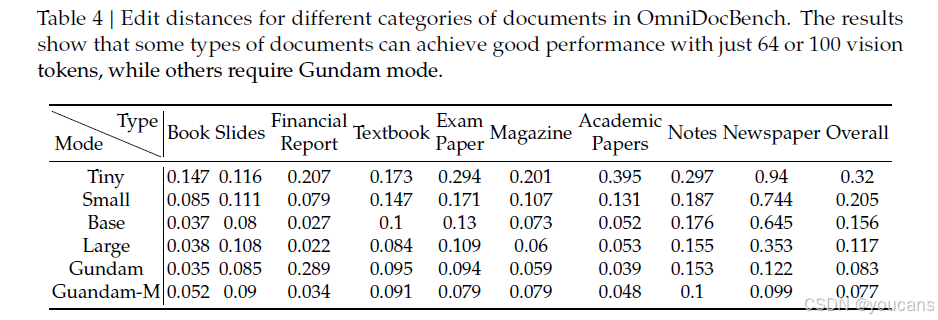

DeepSeek-OCR不仅是一个实验模型,还具有强大的实际能力,可以为LLM/VLM预训练构建数据。为了量化OCR性能,我们在OmniDocBench [27]上测试了DeepSeek-OCR,结果如表3所示。仅需100个视觉令牌(640×640分辨率),DeepSeek-OCR就超越了使用256个令牌的GOT-OCR2.0 [38];使用400个令牌(285个有效令牌,1280×1280分辨率),它在该基准测试中达到了与最先进模型相当的性能。使用少于800个令牌(Gundam模式),DeepSeek-OCR优于需要近7000个视觉令牌的MinerU2.0 [34]。这些结果表明,我们的DeepSeek-OCR模型在实际应用中非常强大,并且由于更高的令牌压缩率,它具有更高的研究上限。

如表4所示,某些类别的文档只需要很少的令牌就能达到令人满意的性能,例如幻灯片只需64个视觉令牌。对于书籍和报告文档,DeepSeek-OCR仅需100个视觉令牌就能实现良好的性能。结合第4.1节的分析,这可能是因为这些文档类别中的大多数文本令牌都在1000个以内,意味着视觉令牌压缩比不超过10倍。对于报纸,需要Gundam甚至Gundam-master模式才能达到可接受的编辑距离,因为报纸中的文本令牌达到4000-5000个,远远超过其他模式的10倍压缩。这些实验结果进一步证明了上下文光学压缩的边界,这可能为VLM中视觉令牌优化以及LLM中的上下文压缩和遗忘机制的研究提供有效的参考。

4.3 定性研究

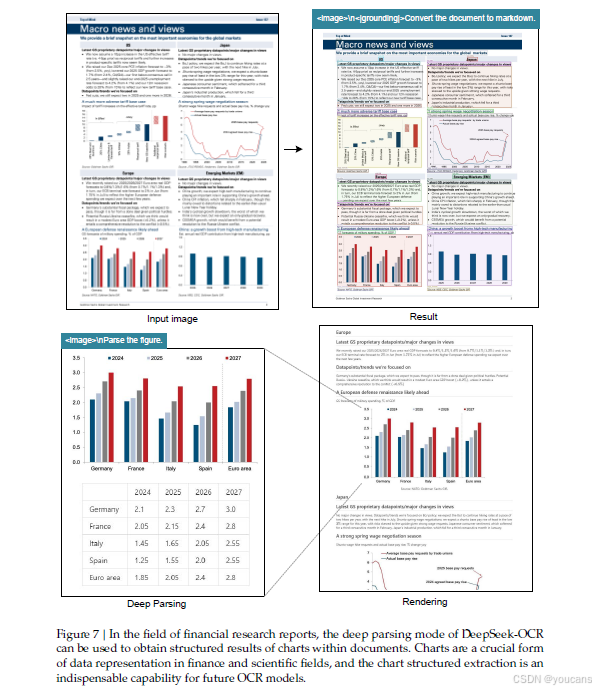

4.3.1 深度解析

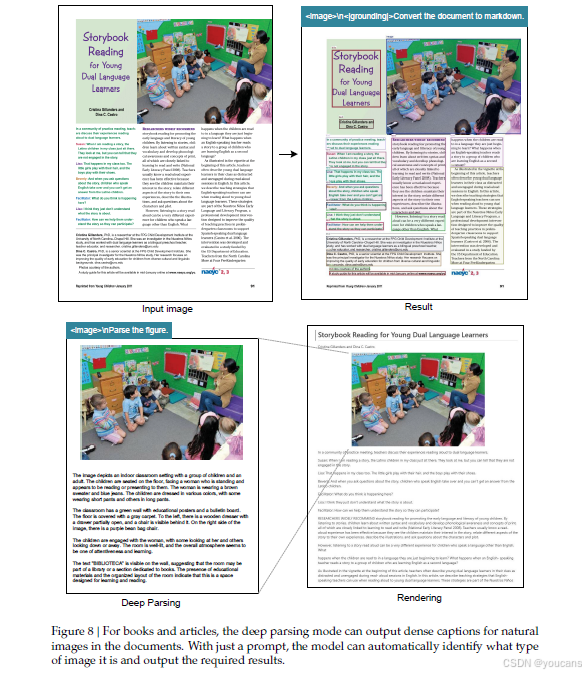

DeepSeek-OCR具备布局和OCR 2.0能力,使其能够通过二次模型调用进一步解析文档中的图像,我们称之为"深度解析"。如图7、8、9、10所示,我们的模型可以对图表、几何图形、化学公式甚至自然图像进行深度解析,只需要统一的提示词即可。

4.3.2 多语言识别

互联网上的PDF数据不仅包含中文和英文,还包含大量多语言数据,这在训练LLM时也至关重要。对于PDF文档,DeepSeek-OCR可以处理近100种语言。与中英文文档一样,多语言数据也支持布局和非布局OCR格式。可视化结果如图11所示,我们选择阿拉伯语和僧伽罗语来展示结果。

4.3.3 通用视觉理解

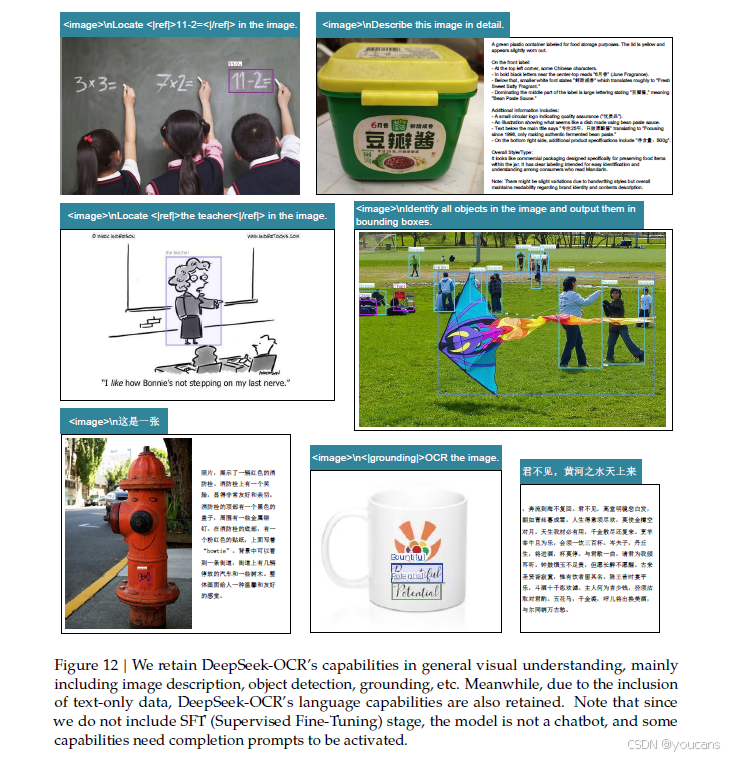

我们还为DeepSeek-OCR提供了一定程度的通用图像理解能力。相关的可视化结果如图12所示。

5. 讨论

我们的工作代表了对视觉-文本压缩边界的初步探索,研究了需要多少视觉令牌才能解码 𝑁 个文本令牌。初步结果令人鼓舞:DeepSeek-OCR 在大约 10 倍压缩比下实现了接近无损的 OCR 压缩,而 20 倍压缩仍能保持 60% 的准确率。这些发现为未来的应用指明了有前景的方向,例如在多轮对话中对 𝑘 轮以上的对话历史实施光学处理,以实现 10 倍的压缩效率。

对于较早的上下文,我们可以逐渐缩小渲染图像的尺寸以进一步减少令牌消耗。这一假设的灵感来源于人类记忆随时间自然衰退与视觉感知随空间距离退化之间的自然相似性------两者都表现出渐进式信息丢失的相似模式,如图 13 所示。通过结合这些机制,上下文光学压缩方法实现了一种类似于生物遗忘曲线的记忆衰退形式,其中近期信息保持高保真度,而遥远的记忆则通过增加的压缩比自然淡出。

虽然我们的初步探索显示了可扩展的超长上下文处理的潜力,即近期上下文保持高分辨率而较早上下文消耗更少资源,但我们承认这是早期工作,需要进一步研究。该方法为理论上无限的上下文架构指明了一条道路,该架构在信息保留和计算约束之间取得平衡,尽管这种视觉-文本压缩系统的实际影响和局限性需要在未来研究中更深入地探讨。

6. 结论

在本技术报告中,我们提出了 DeepSeek-OCR,并通过该模型初步验证了上下文光学压缩的可行性,证明了模型能够从少量视觉令牌中有效解码出超过其数量 10 倍的文本令牌。我们相信这一发现将促进未来 VLM 和 LLM 的发展。此外,DeepSeek-OCR 是一个高度实用的模型,能够进行大规模预训练数据生产,是 LLM 不可或缺的助手。当然,仅凭 OCR 不足以完全验证真正的上下文光学压缩,我们未来将进行数字-光学文本交错预训练、大海捞针测试等评估。从另一个角度来看,光学上下文压缩仍然存在巨大的研究和改进空间,代表着一个有前景的新方向。

7. 项目下载与使用

项目地址: github, Hugging Face

安装

我们的环境是 cuda11.8+torch2.6.0。

- 克隆此仓库并进入 DeepSeek-OCR 文件夹

bash

git clone https://github.com/deepseek-ai/DeepSeek-OCR.git- 创建 Conda 环境

bash

conda create -n deepseek-ocr python=3.12.9 -y

conda activate deepseek-ocr- 安装包:下载 vllm-0.8.5 whl 文件

bash

pip install torch==2.6.0 torchvision==0.21.0 torchaudio==2.6.0 --index-url https://download.pytorch.org/whl/cu118

pip install vllm-0.8.5+cu118-cp38-abi3-manylinux1_x86_64.whl

pip install -r requirements.txt

pip install flash-attn==2.7.3 --no-build-isolation注意:如果您希望 vLLM 和 transformers 代码在同一个环境中运行,无需担心此类安装错误:vllm 0.8.5+cu118 要求 transformers>=4.51.1

VLLM 推理

VLLM:

注意:请在 DeepSeek-OCR-master/DeepSeek-OCR-vllm/config.py 中更改 INPUT_PATH/OUTPUT_PATH 及其他设置

bash

cd DeepSeek-OCR-master/DeepSeek-OCR-vllm- 图像:流式输出

bash

python run_dpsk_ocr_image.py- PDF:并发约 2500 令牌/秒(一张 A100-40G)

bash

python run_dpsk_ocr_pdf.py- 基准测试的批量评估

bash

python run_dpsk_ocr_eval_batch.pyTransformers-Inference

python

from transformers import AutoModel, AutoTokenizer

import torch

import os

os.environ["CUDA_VISIBLE_DEVICES"] = '0'

model_name = 'deepseek-ai/DeepSeek-OCR'

tokenizer = AutoTokenizer.from_pretrained(model_name, trust_remote_code=True)

model = AutoModel.from_pretrained(model_name, _attn_implementation='flash_attention_2', trust_remote_code=True, use_safetensors=True)

model = model.eval().cuda().to(torch.bfloat16)

# prompt = "<image>\nFree OCR. "

prompt = "<image>\n<|grounding|>Convert the document to markdown. "

image_file = 'your_image.jpg'

output_path = 'your/output/dir'

# infer(self, tokenizer, prompt='', image_file='', output_path = ' ', base_size = 1024, image_size = 640, crop_mode = True, test_compress = False, save_results = False):

# Tiny: base_size = 512, image_size = 512, crop_mode = False

# Small: base_size = 640, image_size = 640, crop_mode = False

# Base: base_size = 1024, image_size = 1024, crop_mode = False

# Large: base_size = 1280, image_size = 1280, crop_mode = False

# Gundam: base_size = 1024, image_size = 640, crop_mode = True

res = model.infer(tokenizer, prompt=prompt, image_file=image_file, output_path = output_path, base_size = 1024, image_size = 640, crop_mode=True, save_results = True, test_compress = True)8. 参考文献

bash

[1] Marker. URL https://github.com/datalab-to/marker.

[2] Mathpix. URL https://mathpix.com/.

[3] Ocrflux, 2025. URL https://github.com/chatdoc-com/OCRFlux.

[4] G. AI. Gemini 2.5-pro, 2025. URL https://gemini.google.com/.

[5] S. Bai, K. Chen, X. Liu, J. Wang, W. Ge, S. Song, K. Dang, P. Wang, S. Wang, J. Tang,H. Zhong, Y. Zhu, M. Yang, Z. Li, J. Wan, P. Wang, W. Ding, Z. Fu, Y. Xu, J. Ye, X. Zhang,T. Xie, Z. Cheng, H. Zhang, Z. Yang, H. Xu, and J. Lin. Qwen2.5-vl technical report. arXivpreprint arXiv:2502.13923, 2025.

[6] L. Blecher, G. Cucurull, T. Scialom, and R. Stojnic. Nougat: Neural optical understandingfor academic documents. arXiv preprint arXiv:2308.13418, 2023.

[7] J. Chen, L. Kong, H.Wei, C. Liu, Z. Ge, L. Zhao, J. Sun, C. Han, and X. Zhang. Onechart:Purify the chart structural extraction via one auxiliary token. In Proceedings of the 32ndACM International Conference on Multimedia, pages 147--155, 2024.

[8] Z. Chen, W. Wang, H. Tian, S. Ye, Z. Gao, E. Cui, W. Tong, K. Hu, J. Luo, Z. Ma, et al. Howfar are we to gpt-4v? closing the gap to commercial multimodal models with open-sourcesuites. arXiv preprint arXiv:2404.16821, 2024.

[9] C. Cui, T. Sun, M. Lin, T. Gao, Y. Zhang, J. Liu, X.Wang, Z. Zhang, C. Zhou, H. Liu, et al.Paddleocr 3.0 technical report. arXiv preprint arXiv:2507.05595, 2025.

[10] M. Dehghani, J. Djolonga, B. Mustafa, P. Padlewski, J. Heek, J. Gilmer, A. Steiner, M. Caron,R. Geirhos, I. Alabdulmohsin, et al. Patch n' pack: Navit, a vision transformer for any aspectratio and resolution. Advances in Neural Information Processing Systems, 36:3632--3656,2023.

[11] H. Feng, S. Wei, X. Fei, W. Shi, Y. Han, L. Liao, J. Lu, B. Wu, Q. Liu, C. Lin, et al. Dolphin:Document image parsing via heterogeneous anchor prompting. arXiv preprintarXiv:2505.14059, 2025.

[12] Y. Goyal, T. Khot, D. Summers-Stay, D. Batra, and D. Parikh. Making the v in vqa matter:Elevating the role of image understanding in visual question answering. In Proceedings ofthe IEEE conference on computer vision and pattern recognition, pages 6904--6913, 2017.

[13] J. Gu, X. Meng, G. Lu, L. Hou, N. Minzhe, X. Liang, L. Yao, R. Huang,W. Zhang, X. Jiang,et al. Wukong: A 100 million large-scale chinese cross-modal pre-training benchmark.Advances in Neural Information Processing Systems, 35:26418--26431, 2022.

[14] High-flyer. HAI-LLM: Efficient and lightweight training tool for large models, 2023. URLhttps://www.high-flyer.cn/en/blog/hai-llm.

[15] S. Iyer, X. V. Lin, R. Pasunuru, T. Mihaylov, D. Simig, P. Yu, K. Shuster, T. Wang, Q. Liu, P. S.Koura, et al. Opt-iml: Scaling language model instruction meta learning through the lensof generalization. arXiv preprint arXiv:2212.12017, 2022.

[16] S. Kazemzadeh, V. Ordonez, M. Matten, and T. Berg. Referitgame: Referring to objectsin photographs of natural scenes. In Proceedings of the 2014 conference on empiricalmethods in natural language processing (EMNLP), pages 787--798, 2014.

[17] A. Kirillov, E. Mintun, N. Ravi, H. Mao, C. Rolland, L. Gustafson, T. Xiao, S. Whitehead,A. C. Berg,W.-Y. Lo, et al. Segment anything. arXiv preprint arXiv:2304.02643, 2023.

[18] Z. Li, Y. Liu, Q. Liu, Z. Ma, Z. Zhang, S. Zhang, Z. Guo, J. Zhang, X. Wang, and X. Bai.Monkeyocr: Document parsing with a structure-recognition-relation triplet paradigm.arXiv preprint arXiv:2506.05218, 2025.

[19] A. Liu, B. Feng, B. Wang, B. Wang, B. Liu, C. Zhao, C. Dengr, C. Ruan, D. Dai, D. Guo,et al. Deepseek-v2: A strong, economical, and efficient mixture-of-experts language model.arXiv preprint arXiv:2405.04434, 2024.

[20] A. Liu, B. Feng, B. Xue, B.Wang, B.Wu, C. Lu, C. Zhao, C. Deng, C. Zhang, C. Ruan, et al.Deepseek-v3 technical report. arXiv preprint arXiv:2412.19437, 2024.

[21] C. Liu, H. Wei, J. Chen, L. Kong, Z. Ge, Z. Zhu, L. Zhao, J. Sun, C. Han, and X. Zhang.Focus anywhere for fine-grained multi-page document understanding. arXiv preprintarXiv:2405.14295, 2024.

[22] I. Loshchilov and F. Hutter. Sgdr: Stochastic gradient descent with warm restarts. arXivpreprint arXiv:1608.03983, 2016.

[23] I. Loshchilov and F. Hutter. Decoupled weight decay regularization. In ICLR, 2019.

[24] A. Masry, D. X. Long, J. Q. Tan, S. Joty, and E. Hoque. Chartqa: A benchmark for questionanswering about charts with visual and logical reasoning. arXiv preprint arXiv:2203.10244,2022.

[25] A. Nassar, A. Marafioti, M. Omenetti, M. Lysak, N. Livathinos, C. Auer, L. Morin, R. T.de Lima, Y. Kim, A. S. Gurbuz, et al. Smoldocling: An ultra-compact vision-languagemodel for end-to-end multi-modal document conversion. arXiv preprint arXiv:2503.11576,2025.

[26] OpenAI. Gpt-4 technical report, 2023.

[27] L. Ouyang, Y. Qu, H. Zhou, J. Zhu, R. Zhang, Q. Lin, B.Wang, Z. Zhao, M. Jiang, X. Zhao,et al. Omnidocbench: Benchmarking diverse pdf document parsing with comprehensiveannotations. In Proceedings of the Computer Vision and Pattern Recognition Conference,pages 24838--24848, 2025.

[28] J. Poznanski, A. Rangapur, J. Borchardt, J. Dunkelberger, R. Huff, D. Lin, C. Wilhelm, K. Lo,and L. Soldaini. olmocr: Unlocking trillions of tokens in pdfs with vision language models.arXiv preprint arXiv:2502.18443, 2025.

[29] A. Radford, J. W. Kim, C. Hallacy, A. Ramesh, G. Goh, S. Agarwal, G. Sastry, A. Askell,P. Mishkin, J. Clark, et al. Learning transferable visual models from natural languagesupervision. In International conference on machine learning, pages 8748--8763. PMLR,2021.

[30] Rednote. dots.ocr, 2025. URL https://github.com/rednote-hilab/dots.ocr.

[31] C. Schuhmann, R. Vencu, R. Beaumont, R. Kaczmarczyk, C. Mullis, A. Katta, T. Coombes,J. Jitsev, and A. Komatsuzaki. Laion-400m: Open dataset of clip-filtered 400 million imagetextpairs. arXiv preprint arXiv:2111.02114, 2021.

[32] A. Singh, V. Natarajan, M. Shah, Y. Jiang, X. Chen, D. Batra, D. Parikh, and M. Rohrbach. Towardsvqa models that can read. In Proceedings of the IEEE/CVF conference on computervision and pattern recognition, pages 8317--8326, 2019.

[33] T. Sun, C. Cui, Y. Du, and Y. Liu. Pp-doclayout: A unified document layout detection modelto accelerate large-scale data construction. arXiv preprint arXiv:2503.17213, 2025.

[34] B. Wang, C. Xu, X. Zhao, L. Ouyang, F. Wu, Z. Zhao, R. Xu, K. Liu, Y. Qu, F. Shang, et al.Mineru: An open-source solution for precise document content extraction. arXiv preprintarXiv:2409.18839, 2024.

[35] P. Wang, S. Bai, S. Tan, S. Wang, Z. Fan, J. Bai, K. Chen, X. Liu, J. Wang, W. Ge, et al.Qwen2-vl: Enhancing vision-language model's perception of the world at any resolution.arXiv preprint arXiv:2409.12191, 2024.

[36] H. Wei, L. Kong, J. Chen, L. Zhao, Z. Ge, J. Yang, J. Sun, C. Han, and X. Zhang. Vary:Scaling up the vision vocabulary for large vision-language model. In European Conferenceon Computer Vision, pages 408--424. Springer, 2024.

[37] H. Wei, L. Kong, J. Chen, L. Zhao, Z. Ge, E. Yu, J. Sun, C. Han, and X. Zhang. Smalllanguage model meets with reinforced vision vocabulary. arXiv preprint arXiv:2401.12503,2024.

[38] H. Wei, C. Liu, J. Chen, J. Wang, L. Kong, Y. Xu, Z. Ge, L. Zhao, J. Sun, Y. Peng, et al.General ocr theory: Towards ocr-2.0 via a unified end-to-end model. arXiv preprintarXiv:2409.01704, 2024.

[39] H.Wei, Y. Yin, Y. Li, J.Wang, L. Zhao, J. Sun, Z. Ge, X. Zhang, and D. Jiang. Slow perception:Let's perceive geometric figures step-by-step. arXiv preprint arXiv:2412.20631, 2024.

[40] Z. Wu, X. Chen, Z. Pan, X. Liu, W. Liu, D. Dai, H. Gao, Y. Ma, C. Wu, B. Wang, et al.Deepseek-vl2: Mixture-of-experts vision-language models for advanced multimodal understanding.arXiv preprint arXiv:2412.10302, 2024.

[41] W. Yu, Z. Yang, L. Li, J.Wang, K. Lin, Z. Liu, X.Wang, and L.Wang. Mm-vet: Evaluatinglarge multimodal models for integrated capabilities. arXiv preprint arXiv:2308.02490, 2023.

[42] J. Zhu, W. Wang, Z. Chen, Z. Liu, S. Ye, L. Gu, H. Tian, Y. Duan, W. Su, J. Shao, et al.Internvl3: Exploring advanced training and test-time recipes for open-source multimodalmodels. arXiv preprint arXiv:2504.10479, 2025.版权声明:

本文由 youcans@xidian 对论文 DeepSeek-OCR: Contexts Optical Compression(DeepSeek-OCR:上下文光学压缩) 进行摘编和翻译,只供研究学习使用。

youcans@xidian 作品 ,转载必须标注原文链接:

【DeepSeek论文精读】13. DeepSeek-OCR:上下文光学压缩Copyright 2025 youcans, XIDIAN

Created:2025-10