TL;DR

- 场景 :把训练好的机器人策略在仿真→现实→回放三阶段可量化验证,快速定位失败根因。

- 结论 :用统一的 MRE+SOP 跑 1000+ 批量仿真,按 成功率≥85% / 关键指标门槛 才进现实测试;失败用 速查卡 与 回滚剧本闭环。

- 产出:批量仿真/数据收集、指标对比表模板、失败案例报告模板、回滚剧本。

机器人模型-验证与反馈

训练出的模型需要经过严格的验证评估,并根据反馈不断改进。

验证方式模板

shell

# 1) 启 8 并发仿真 * 128 轮 = 1024 次

python tools/sim_runner.py \

--env pose_pick_v1 \

--episodes 128 --workers 8 \

--randomize light:50-1000, friction:0.8-1.2, mass:0.85-1.15 \

--out runs/2025-10-21/

# 2) 汇总指标(成功率/完成时长/奖励),生成 CSV+图表

python tools/aggregate.py runs/2025-10-21/ --save metrics/

# 3) 产生评估报告(含消融/失败Top-10回放)

python tools/report.py --in metrics/ --out report/2025-10-21/Step 1|仿真批测

- 输入:env/参数随机范围

- 核验:success_rate≥85%,均值±方差稳定

- 常见错:时钟不同步 → 同步 /use_sim_time

Step 2|消融分析

- 输入:传感器/模块开关矩阵

- 核验:移除X后成功率下降≥Δ阈值 → 记录贡献

Step 3|现实小样本

- 输入:实验室标准场(n=50)

- 核验:抓取成功率≥80%,MTBF≥X小时

- 常见错:光照/反光 → 相机曝光与滤波配置

Step 4|回放评估

- 输入:失败case轨迹

- 核验:新策略在同起点不再复现同类失败

- 常见错:时间戳错位 → 全链路对时/插值

指标与门槛模板

| 任务 | 成功率 | 平均完成时长 | 抖动/稳定性 | 备注 |

|---|---|---|---|---|

| 抓取 | ≥85% | ≤T秒 | 角速度方差≤V | 1024 仿真样本 |

| 导航 | ≥90% | ≤T秒 | 路径偏差≤E cm | 含动态障碍 |

失败速查卡模板

| 症状 | 可能根因 | 快速定位 | 修复动作 |

|---|---|---|---|

| 识别不到目标 | 过曝/反光/分布漂移 | 看图像直方图/IoU分布 | 调曝光+数据增强;补半透明样本 |

| 控制抖动 | 控制频率过高/缺少滤波 | 频谱分析/命令方差 | 低通滤波;降频;轨迹规划前置 |

| 抓取偏差 | 外参/摩擦不符 | 标定重投影误差 | 重标定;仿真摩擦贴合现实 |

回滚剧本模板

shell

# 恢复安全配置

ros2 param set /controller max_speed 0.2

ros2 param set /gripper force 0.3

# 切回上版策略与参数

ros2 launch app bringup.launch.py policy:=2025-10-01.yaml

# 记录黑匣子数据并生成故障报告

ros2 bag record /cam /lidar /cmd /state -o bags/fail_$(date +%F_%H%M)

python tools/make_failure_report.py --bag bags/... --out report/failure_...理论知识补充

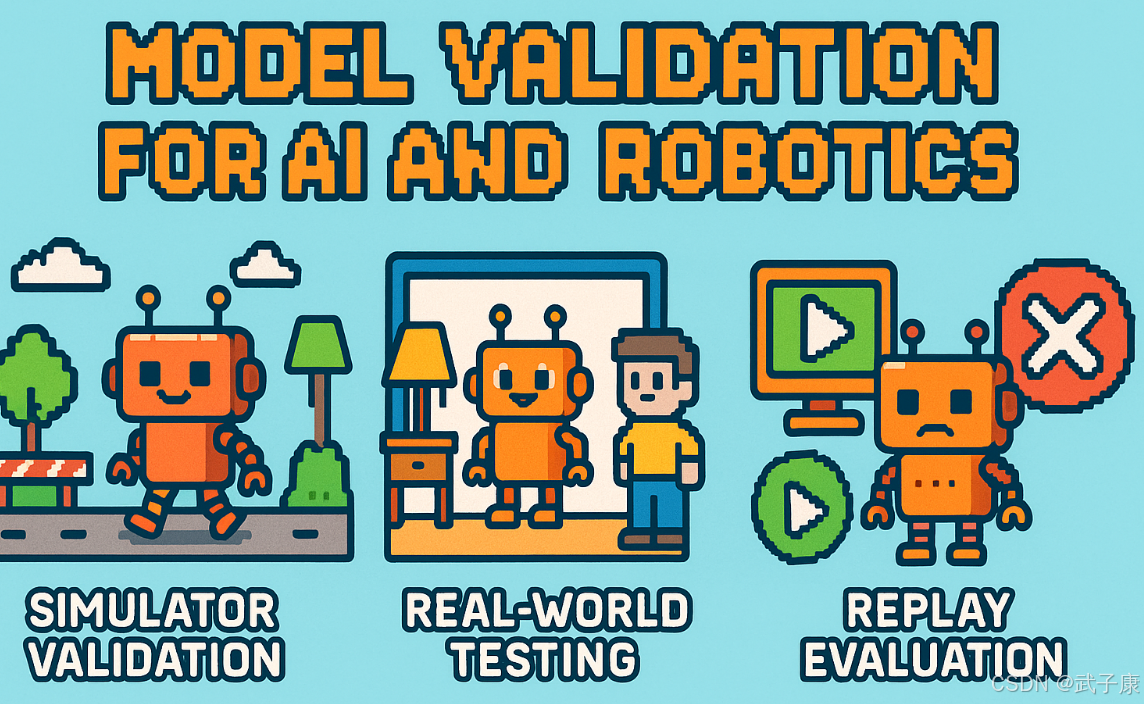

模拟器验证

模拟器验证是模型策略测试中至关重要的第一步,它提供了最安全高效的验证方式。具体实施过程包括以下关键环节:

环境配置

- 精确复现训练环境参数,包括物理引擎设置、传感器配置等

- 扩展测试场景集,如:

- 光照条件变化(从50lux到1000lux随机调整)

- 物体材质参数扰动(摩擦系数±20%,质量±15%)

- 动态障碍物引入(移动速度0.1-1.5m/s随机设置)

测试执行

- 采用批量测试模式,通常建议执行1000+次仿真运行

- 自动化测试流程配置:

- 并行启动多个仿真实例

- 随机化测试场景参数

- 自动收集运行数据

指标评估

-

核心性能指标:

- 任务成功率(达到预期目标的运行比例)

- 平均完成时间(从启动到任务完成的耗时)

- 奖励函数值(对强化学习模型特别重要)

-

健壮性指标:

- 极端条件下的表现

- 传感器失效时的性能降级程度

消融分析

- 系统性地评估各模块贡献度:

- 移除/屏蔽特定传感器输入(如关闭深度摄像头)

- 限制算法功能(如禁用路径规划模块)

- 记录性能变化幅度

强化学习专项验证

-

训练环境验证:

- 检查收益曲线收敛性

- 评估策略稳定性(多次运行的方差)

-

泛化能力测试:

- 在20%未见过的新场景中测试

- 检查成功率是否保持在可接受水平

现实验证

现实验证:最终还是要在真实机器人上测试模型。因为真实世界复杂性往往超出仿真,现实验证能发现许多仿真环境难以模拟的问题:

- 感知系统方面:

- 相机可能遇到光照变化、动态模糊等问题

- 激光雷达在透明/反光物体前测量异常

- 多传感器数据不同步导致融合误差

- 执行机构方面:

- 电机发热导致扭矩下降

- 齿轮间隙引起的迟滞效应

- 地面摩擦系数与仿真参数不匹配

阶段化测试流程

实验室环境测试(1-2周)

- 铺设有标记的地面

- 固定障碍物布局

- 人工照明控制

- 使用安全绳防护

半结构化环境测试(1周)

- 办公室走廊

- 轻度人流

- 可移动家具

完全野外测试(持续进行)

- 商场/地铁站

- 密集人流

- 复杂地形

数据采集规范

- 同步记录:

- 多视角视频(≥30fps)

- 全传感器原始数据

- 控制指令时间戳

- 存储格式:

- ROS bag文件

- 时间同步的CSV

- 带标注的视频

量化评估指标示例

-

导航任务:

- 路径跟踪误差(cm)

- 避障成功率(%)

- 平均速度(m/s)

-

抓取任务:

- 物体识别准确率

- 抓取成功率

- 完成时间分布

基准对比方法

人类专家基准:

- 邀请熟练操作员

- 相同任务条件下

- 取10次均值

传统算法对比:

- 基于规则的控制器

- 经典视觉算法

- 统计显著性检验(p<0.05)

压力测试设计原则

- 渐进式增加难度:

- 从5人到50人的人群

- 从静态到动态障碍

- 极端条件组合:

- 低光照+潮湿地面

- 强电磁干扰场景

- 故障注入测试:

- 模拟传感器失效

- 人为施加干扰力

每次测试后应进行

- 即时问题分析会议

- 故障模式影响分析(FMEA)

- 更新回归测试用例集

- 修订仿真环境参数

注意:重要测试需准备:

- 备用电源

- 急停按钮分布图

- 应急响应预案

- 保险覆盖确认

回放评估

回放评估(replay evaluation)是一种重要的模型评估方法,其核心是将训练或验证过程中收集的数据重新输入模型进行测试。具体实施时,可以分为以下几个步骤:

数据收集阶段

- 在模型训练或验证过程中,系统会记录完整的交互轨迹

- 包括环境状态、模型输入、模型输出动作、奖励信号等关键信息

- 特别需要标记出失败案例或异常情况

评估执行阶段

- 针对验证集中的失败案例,提取初始状态重新输入模型

- 记录模型在相同情境下的决策行为

- 对比原始决策和新决策的差异

- 例如在自动驾驶场景中,重放导致碰撞的初始路况,观察模型是否依然会做出危险决策

在离线强化学习(Offline RL)中的应用

- 使用验证数据集计算策略的预期奖励

- 虽然受限于数据集覆盖范围,不能完全反映真实性能

- 但可以提供有价值的性能参考指标

- 例如在机器人控制任务中,可以评估策略在历史数据上的平均得分

可视化分析功能

- 重放关键决策时刻的模型内部状态

- 可视化展示注意力权重分布

- 对比模型输出动作与专家示范动作

- 例如在游戏AI中,可以回放关键战斗时刻,分析模型的决策依据

这种方法的价值在于:

- 可以精确复现特定问题场景

- 便于进行归因分析和错误诊断

- 支持迭代改进时的效果验证

- 为模型解释性提供直观依据

典型应用场景包括:

- 自动驾驶系统的安全性验证

- 游戏AI的策略优化

- 机器人控制算法的调试

- 推荐系统的A/B测试

失败案例分析

失败案例分析:对模型失败的情况,要进行系统性的深入分析以找出根本原因。这通常包括三个关键方面的检查:

传感器输入分析

- 检查是否存在传感器故障或数据丢失

- 分析模型是否无法感知关键环境信息

- 评估输入数据与训练数据的分布差异

例如:机器人抓取失败时,可能因为:- 工业相机被环境光线干扰导致图像过曝

- 训练数据中缺少半透明物体的样本

- 目标物体表面反光严重造成点云缺失

模型输出诊断

- 检查输出是否超出合理范围(异常值)

- 分析输出序列的稳定性(抖动情况)

- 验证输出是否符合物理约束

典型问题包括:- 机械臂关节角度指令超出硬件限位

- 连续控制指令出现高频振荡

- 夹爪开合指令与物体尺寸不匹配

环境因素评估

- 识别测试环境与训练环境的差异

- 检查是否存在动态干扰因素

- 评估任务难度是否超出模型能力

常见环境问题

- 实际场景的桌面反光率高于仿真环境

- 存在训练时未见的障碍物布局

- 目标物体的摆放姿态超出训练范围

针对感知问题:

- 增加数据增强策略(随机光照、遮挡等)

- 采用更鲁棒的视觉模型(如注意力机制)

- 引入多传感器融合方案

针对控制问题:

- 添加输出平滑滤波(如低通滤波器)

- 降低控制频率并增加运动规划

- 引入物理仿真器验证输出合理性

每个失败案例都应建立详细的诊断报告,包含:

- 问题现象描述

- 复现步骤说明

- 根本原因分析

- 改进方案设计

- 验证测试计划

这种结构化的分析流程能确保每个失败案例都能转化为有价值的反馈信号,指导模型的迭代优化。特别要注意建立失败案例库,对同类问题进行归类分析,发现潜在的系统性缺陷。

安全与恢复机制

安全与恢复机制是机器人系统验证过程中的关键环节,需要从多个维度进行设计和完善。以下是更详细的展开:

安全防护层面

- 物理限制器:在关节处安装机械挡板,限制运动范围

- 力/力矩监控:实时检测各关节的受力情况,超过阈值立即停止

- 速度梯度控制:根据环境拥挤程度动态调整最大运动速度

- 深度摄像头+激光雷达的多传感器避障系统,以50Hz频率更新环境地图

故障检测机制

- 姿态稳定性检测:通过IMU实时计算重心投影,当偏离支撑多边形超过30%时触发警报

- 接触异常检测:预期接触力与实际测量值偏差超过20%持续100ms即判为异常

- 视觉伺服验证:对抓取目标进行连续帧比对,发现位移异常立即中断操作

恢复策略库

- 跌倒预防:检测到失衡时快速跨步调整(步频提升至5Hz)

- 抓取失败处理流程:

- 退回机械臂到安全位置

- 重新扫描目标(3D重建精度提升至0.1mm)

- 调整抓取角度(±15°范围内分5级尝试)

- 最多尝试3次后请求人工干预

- 导航异常处理:

- 局部路径阻塞:切换D*算法实时规划

- 全局定位丢失:返回最近的路标点重初始化

学习型恢复机制

- 通过深度强化学习训练恢复策略网络:

- 输入层:200维状态特征(关节角、接触力、视觉特征等)

- 隐藏层:3层512节点的LSTM网络

- 输出层:23个自由度控制指令

- 采用课程学习:

- 第一阶段:实验室环境单一故障恢复

- 第二阶段:干扰环境组合故障处理

- 第三阶段:真实场景迁移学习

验证方法

- 故障注入测试:在仿真环境中随机注入300种故障模式

- 极限测试:让机器人连续工作72小时,记录异常处理成功率

- 人机协作安全测试:在操作空间内随机加入人体模型,验证避让反应时间(<200ms)

这些机制需要根据具体应用场景进行参数调优,例如服务机器人需要更保守的安全阈值,而工业机器人则可适当提高操作效率的优先级。同时要建立完善的黑匣子记录系统,保存故障发生前10秒的完整传感器数据用于事后分析。

用户测试与长时性能

用户测试与长时性能验证是机器人产品化过程中的关键环节,需要从多个维度进行系统性的评估:

实际场景测试

- 典型应用场景:家庭服务机器人需要支持8-12小时的连续工作,包括清洁、物品递送、陪伴等多种任务

- 测试环境应包含:多房间布局、动态障碍物(如宠物、儿童)、光线变化等真实家庭条件

- 测试周期建议:至少持续2-4周,覆盖不同时间段和使用场景

关键性能指标

- 长时成功率:统计每日任务完成率,区分首次尝试成功率和最终成功率

- 异常发生率:

- 硬件异常(如传感器失效)

- 软件异常(如算法崩溃)

- 行为异常(如错误响应)

- 平均故障间隔时间(MTBF)和平均修复时间(MTTR)

用户反馈机制

- 量化评估:

- 满意度评分(1-5分制)

- 易用性评分

- 可靠性评分

- 质性评估:

- 定期用户访谈

- 使用日志分析

- 痛点问题收集

重点关注维度

- 行为自然度:动作流畅性、响应时机把握

- 社交礼仪:保持适当距离、礼貌用语

- 安全性能:避障灵敏度、紧急停止响应

- 个性化适应:学习用户习惯的能力

持续优化机制

- 建立问题分级处理流程:

- 紧急问题(安全相关):24小时内修复

- 重要问题(功能缺陷):1周内优化

- 改进建议:纳入后续版本规划

- 采用A/B测试验证优化效果

- 定期更新测试用例库,覆盖新发现的使用场景

数据收集与分析

- 详细记录:

- 系统日志

- 传感器数据

- 用户交互记录

- 建立分析看板:

- 性能趋势图

- 问题分布图

- 用户满意度变化曲线

其他系列

🚀 AI篇持续更新中(长期更新)

AI炼丹日志-29 - 字节跳动 DeerFlow 深度研究框斜体样式架 私有部署 测试上手 架构研究 ,持续打造实用AI工具指南!

AI-调查研究-108-具身智能 机器人模型训练全流程详解:从预训练到强化学习与人类反馈

🔗 AI模块直达链接

💻 Java篇持续更新中(长期更新)

Java-154 深入浅出 MongoDB 用Java访问 MongoDB 数据库 从环境搭建到CRUD完整示例

MyBatis 已完结,Spring 已完结,Nginx已完结,Tomcat已完结,分布式服务正在更新!深入浅出助你打牢基础!

🔗 Java模块直达链接

📊 大数据板块已完成多项干货更新(300篇):

包括 Hadoop、Hive、Kafka、Flink、ClickHouse、Elasticsearch 等二十余项核心组件,覆盖离线+实时数仓全栈!

大数据-278 Spark MLib - 基础介绍 机器学习算法 梯度提升树 GBDT案例 详解

🔗 大数据模块直达链接