最近我一头扎进了DataWhale China精心打造的All-in-RAG学习旅程,今天,我要和大家重点唠唠我在学习"数据加载"和"文本分块"这两部分内容时的满满收获,尤其是文本分块,那可真是信息处理界的"神奇魔法"!

1.数据加载:信息旅程的起点

在04_data_load.md教程里,我深刻认识到数据加载的重要性,它如同信息旅程的起点,为后续处理分析筑牢根基,且需秉持"垃圾进,垃圾出 (Garbage In, Garbage Out)"理念,保证输入数据质量。

数据加载就像"宝藏挖掘机",能把各种格式、来源的数据有序引入系统。教程介绍了不同类型数据加载方式,不同数据类型如同不同锁,需找到正确加载方法,即"钥匙"。我按教程操作,从混乱到有序,体会到了数据加载的魅力。

同时,数据加载不只是"搬"数据,还要考虑完整性与准确性。如同做菜选新鲜食材,数据加载时需清洗预处理,去除"杂质",保证数据高质量。这让我意识到,数据加载是一门需细心耐心雕琢的艺术。

2.文本分块:信息处理的"秘密武器"

2.1. 为什么要文本分块?

在日常生活中,我们常遇大段文本,如长文章、复杂报告,直接处理如同吞大象,无从下口。文本分块则像把大象切成小块,便于处理。

从技术层面看,文本分块意义重大。其一,提高信息处理效率,计算机可并行处理分块文本,如同多人搬砖比一人快。其二,有助于提高信息检索准确性,分块后计算机能在特定"小池塘"快速找到"针"。其三,为后续文本分析和建模提供更好基础,许多自然语言处理算法对输入文本长度有限制,分块可让长文本适合算法处理。

2.2. 文本分块的方法大揭秘

(1)基于长度的分块方法

这是简单直接的方法,如用尺子量切蛋糕,按预先设定文本长度均匀分块,如设定每个分块500字符。此方法简单易行,但可能切断完整意思或句子,影响信息完整性和连贯性。

(2)基于语义的分块方法

为解决基于长度分块的问题,此方法应运而生。它像聪明读者,能理解文本意思,按语义完整性分块。例如通过分析句子结构、词汇关系等判断句子或段落是否表达完整意思,若表达完整则作为独立分块。此方法能更好保持信息完整性和连贯性,但实现难度大,需借助自然语言处理技术和算法,如词性标注、句法分析等。

(3)基于主题的分块方法

此方法像侦探,能从文本中找出不同主题,将相同主题文本归为一个分块。实际中可通过分析关键词、主题模型等方式确定文本主题。如一篇关于人工智能的文章涉及多个主题,此方法可将不同主题内容分成不同块,方便后续单独分析处理,对处理主题复杂文本有效。

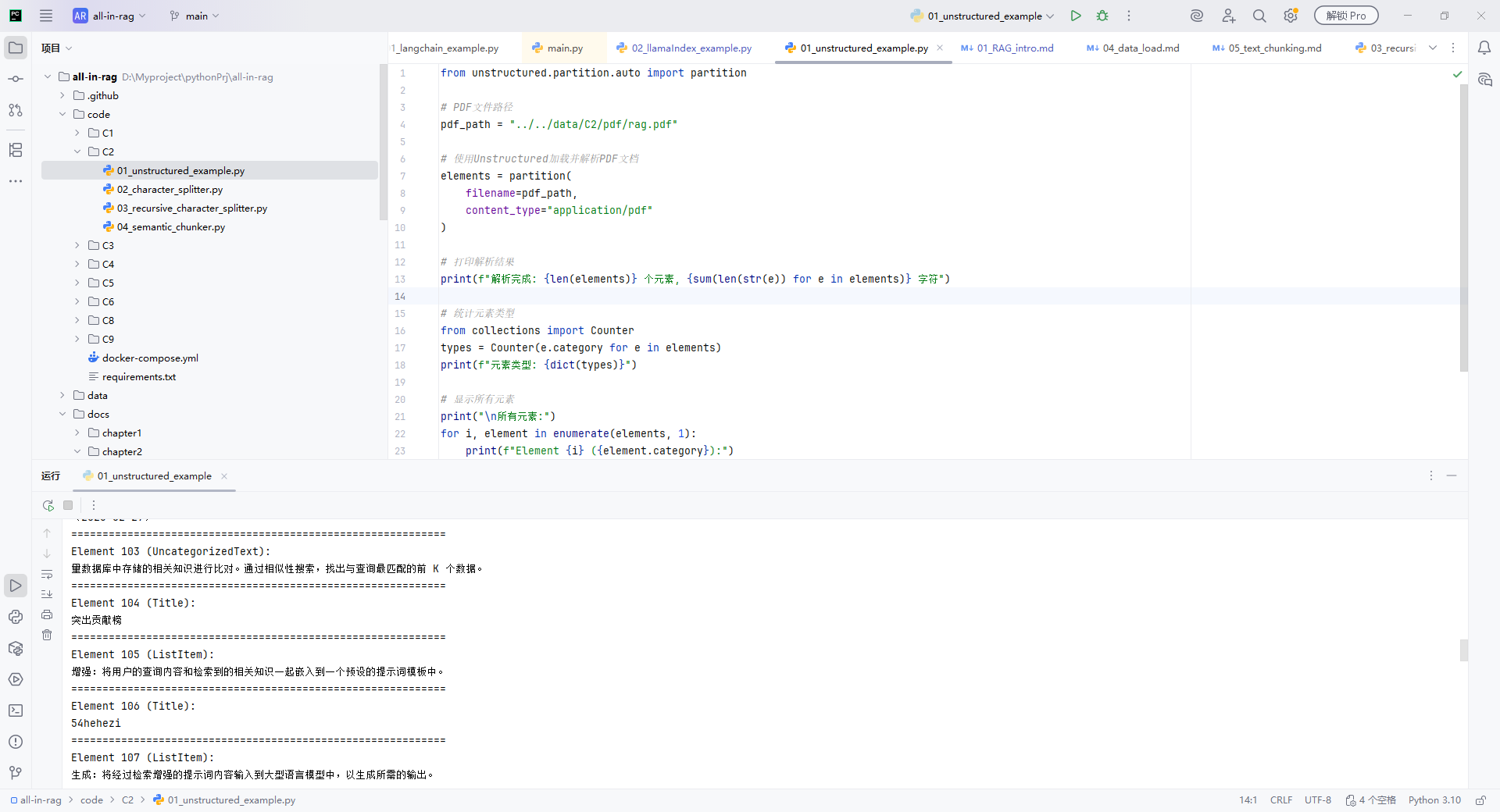

2.3. 实战演练:文本分块的魅力体验

我按教程指导,找一篇长科技文章进行文本分块实践。先尝试基于长度分块,设定每个分块300字符,虽分块快,但部分句子被切断,意思不完整。接着尝试基于语义分块,借助NLTK或Spacy等工具进行词性标注、句法分析,虽实现复杂,但分块后语义完整,读起来更流畅。最后尝试基于主题分块,利用LDA等主题模型算法进行主题分析,成功找到文章主要主题并分类,感觉像整理大师让信息井井有条。

3.总结与展望:文本分块的无限可能

通过学习All-in-RAG教程中"数据加载"和"文本分块"内容,我收获颇丰。数据加载为信息处理筑牢基础,"垃圾进,垃圾出"理念提醒把控数据加载质量。文本分块让信息处理更高效、准确、智能,它不仅是技术,更是思维方式,教会我们分解复杂问题、提取有价值信息。