博主介绍:✌全网粉丝50W+,前互联网大厂软件研发、集结硕博英豪成立软件开发工作室,专注于计算机相关专业项目实战6年之久,累计开发项目作品上万套。凭借丰富的经验与专业实力,已帮助成千上万的学生顺利毕业,选择我们,就是选择放心、选择安心毕业✌

> 🍅想要获取完整文章或者源码,或者代做,拉到文章底部即可与我联系了。🍅

2、大数据、计算机专业选题(Python/Java/大数据/深度学习/机器学习)(建议收藏)✅

1、项目介绍

- 技术栈:Python语言、Django框架、MySQL数据库、基于用户+基于物品的双协同过滤推荐算法、豆瓣电影数据、requests爬虫技术、Echarts可视化、HTML

- 这个项目的研究背景:当前电影信息分散在豆瓣等平台,用户面临"信息过载"问题,传统电影推荐多依赖热门榜单,缺乏个性化,难以精准匹配用户喜好;同时,人工采集豆瓣电影数据(如评分、导演、演员)效率低,数据缺乏直观可视化呈现,导致用户筛选电影时间成本高,亟需一套"数据采集-分析-推荐-可视化"一体化的系统解决这些痛点。

- 这个项目的研究意义:技术层面,通过requests爬虫解决豆瓣电影数据获取难题,双协同过滤算法提升推荐精准度,Echarts实现多维度可视化,Django+MySQL保障系统稳定运行;用户层面,提供电影浏览、搜索、个性化推荐及直观数据图表,降低选片难度;行业层面,为电影推荐领域提供"双算法融合+可视化"方案,推动从"泛化推荐"向"个性化推荐"转型,具备实际应用价值。

2、项目界面

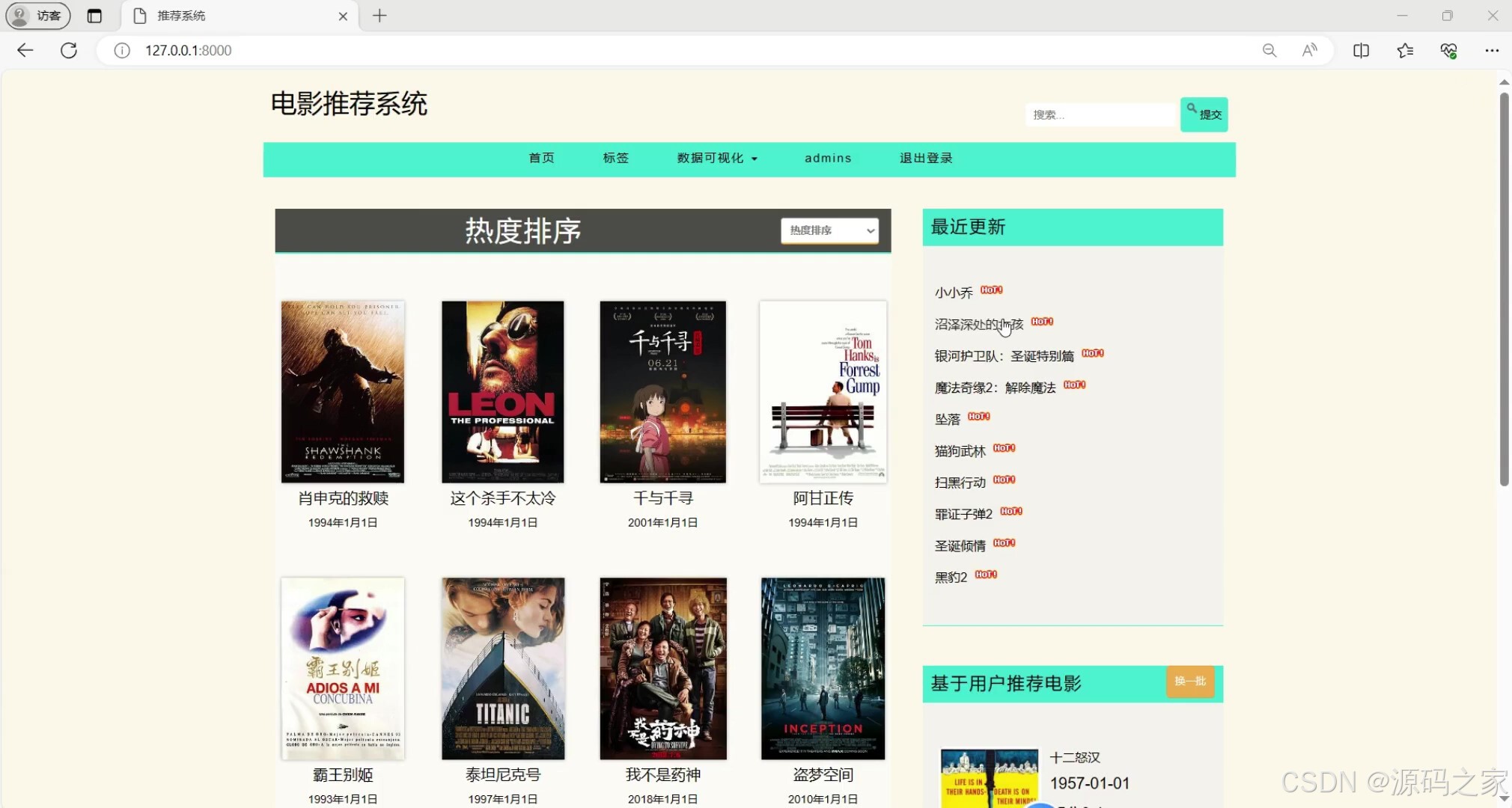

(1)电影数据展示

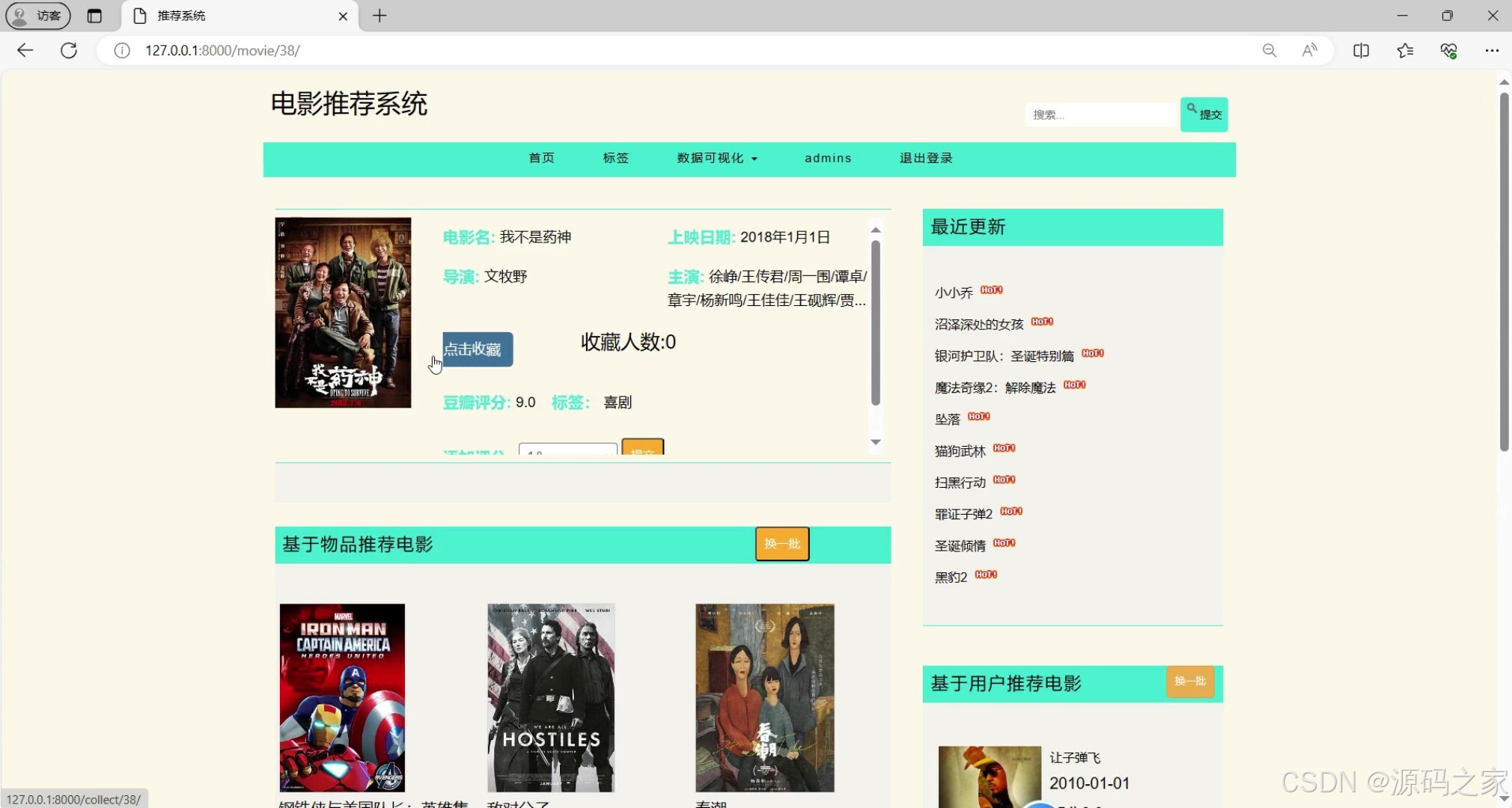

(2)电影数据详情页面

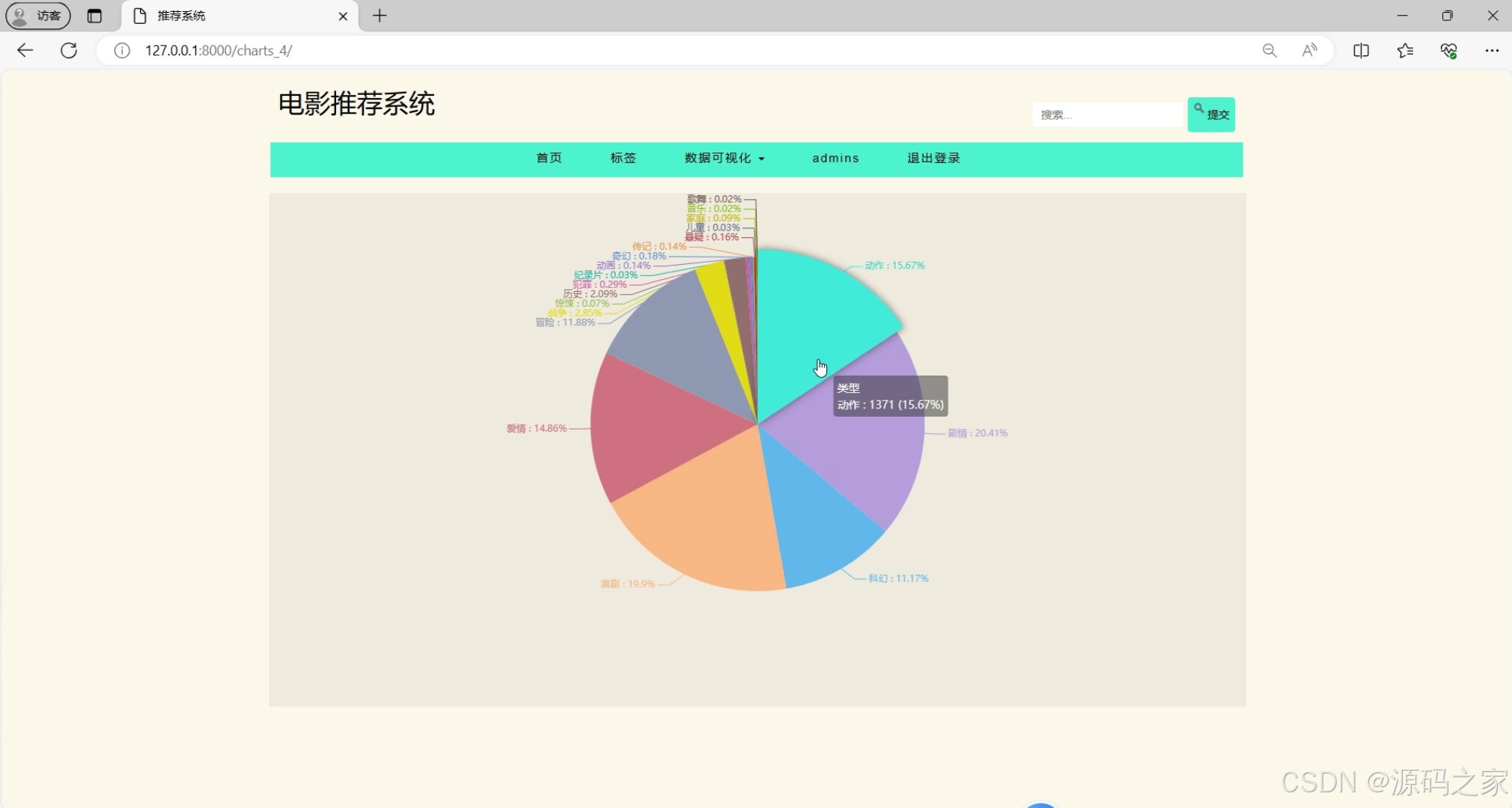

(3)电影数据可视化---饼状图分析

(4)电影数据可视化---词云图分析

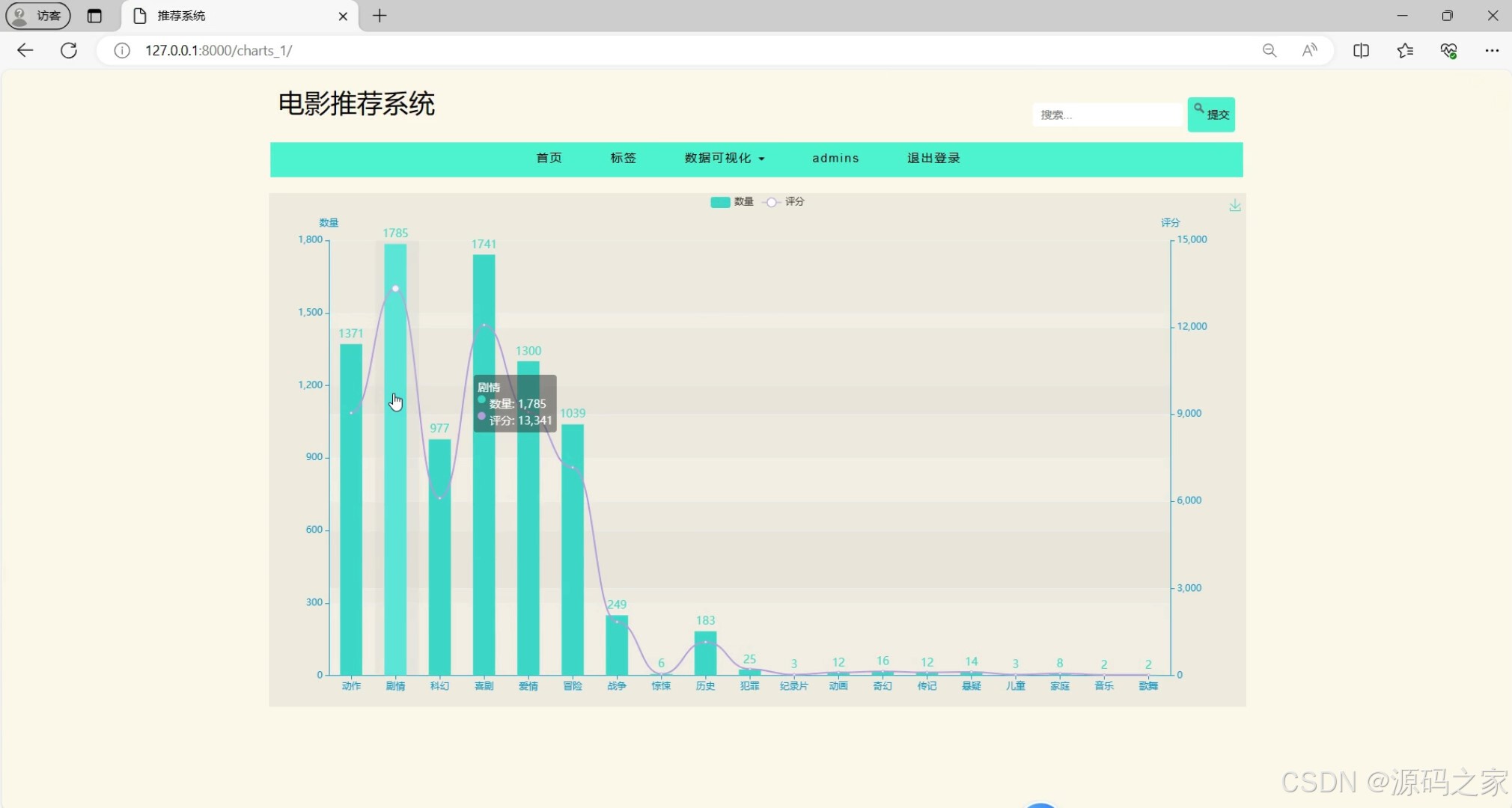

(5)电影数据可视化---柱状图分析

(6)电影数据可视化---曲线图分析

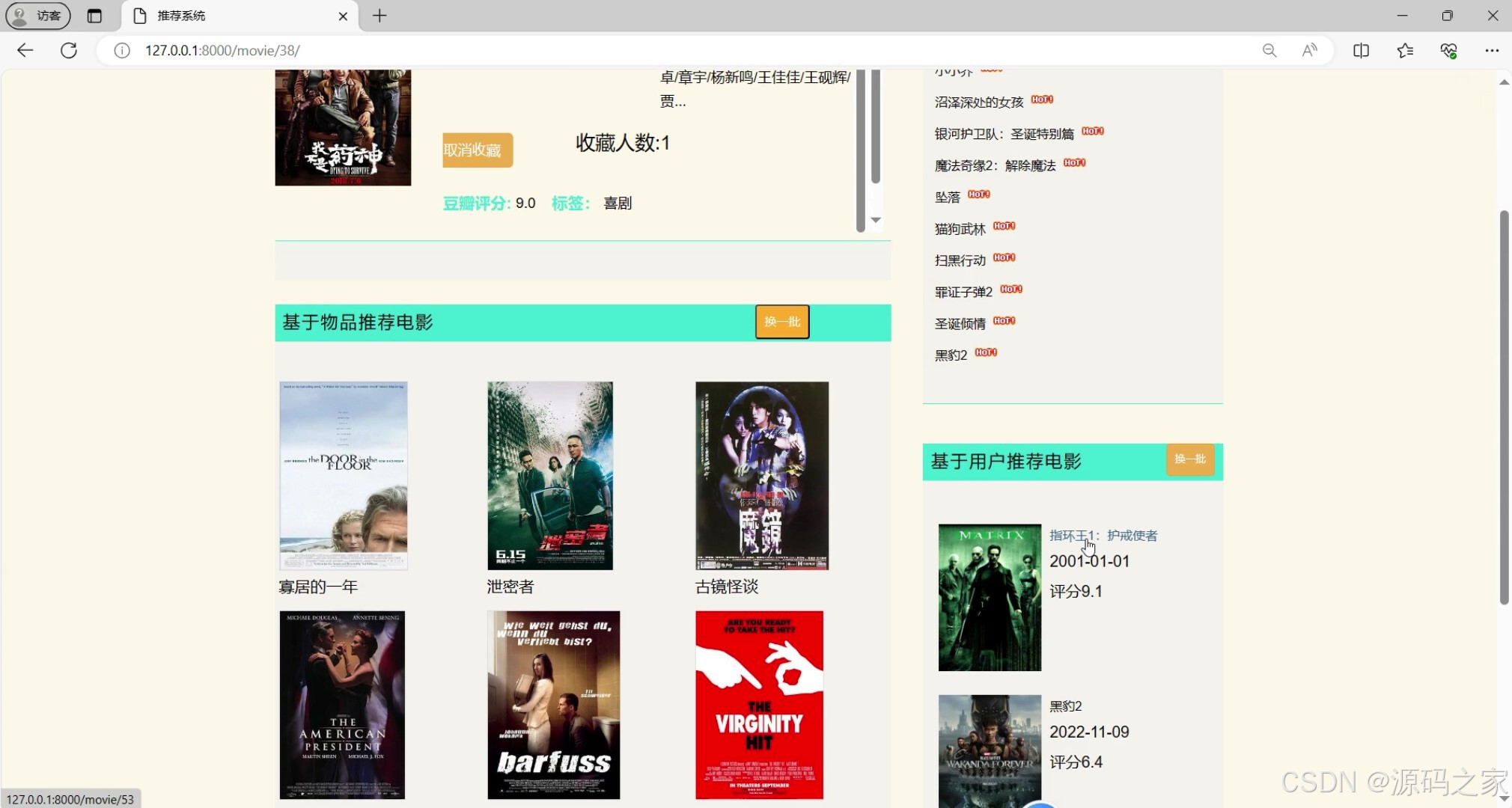

(7)电影推荐---基于用户和基于物品双推荐算法

(8)电影分类

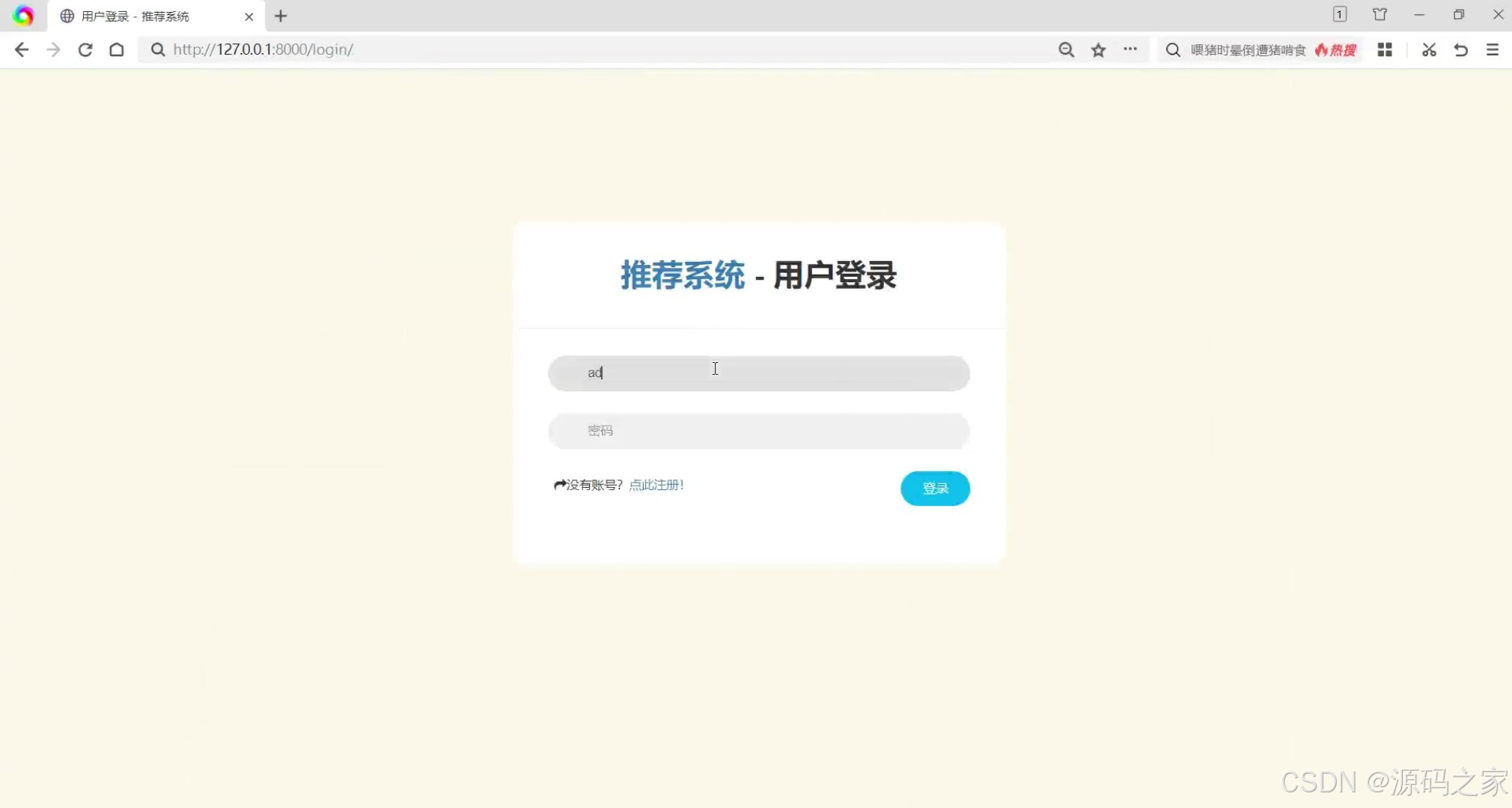

(9)注册登录界面

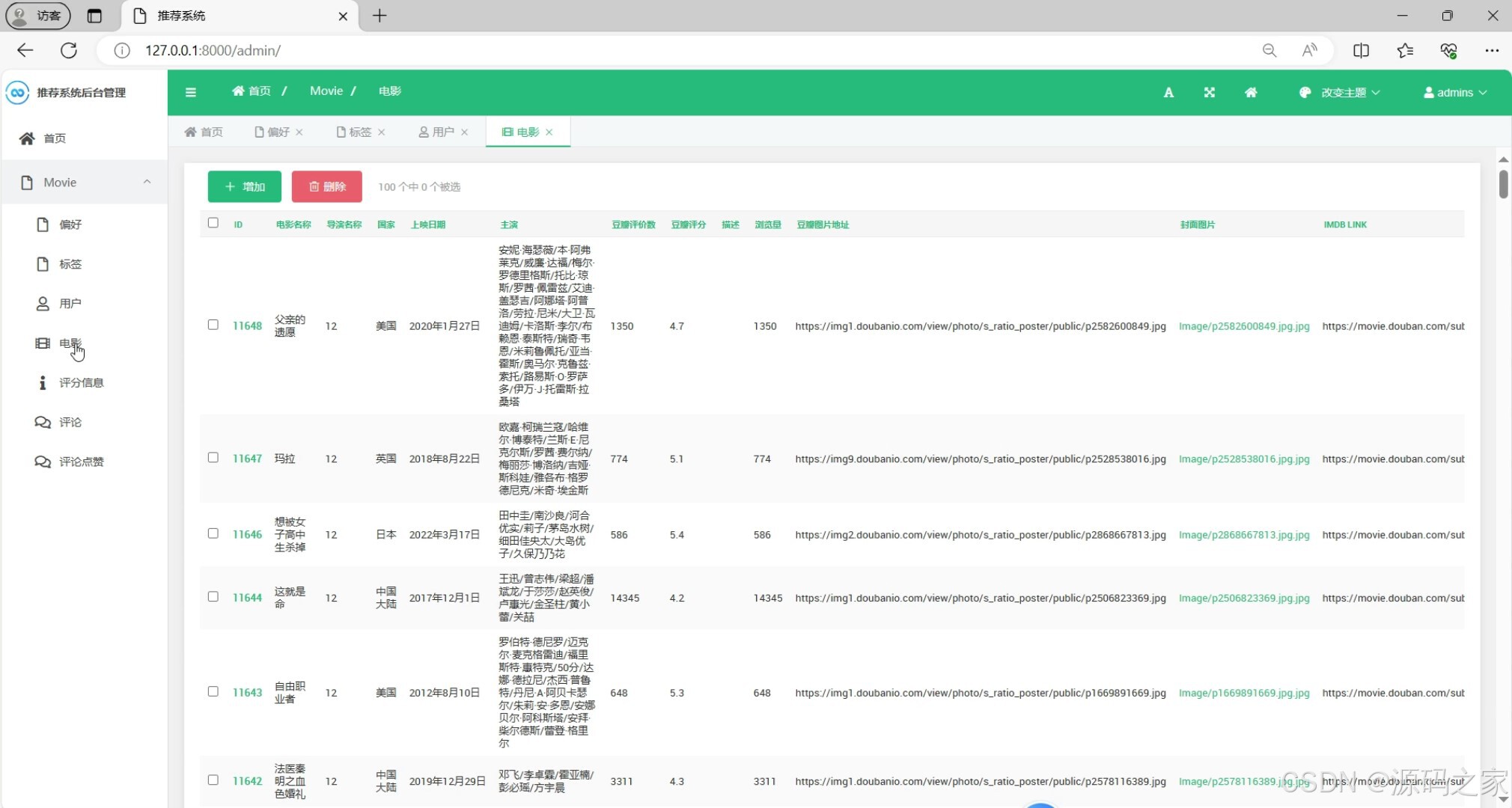

(10)后台数据管理

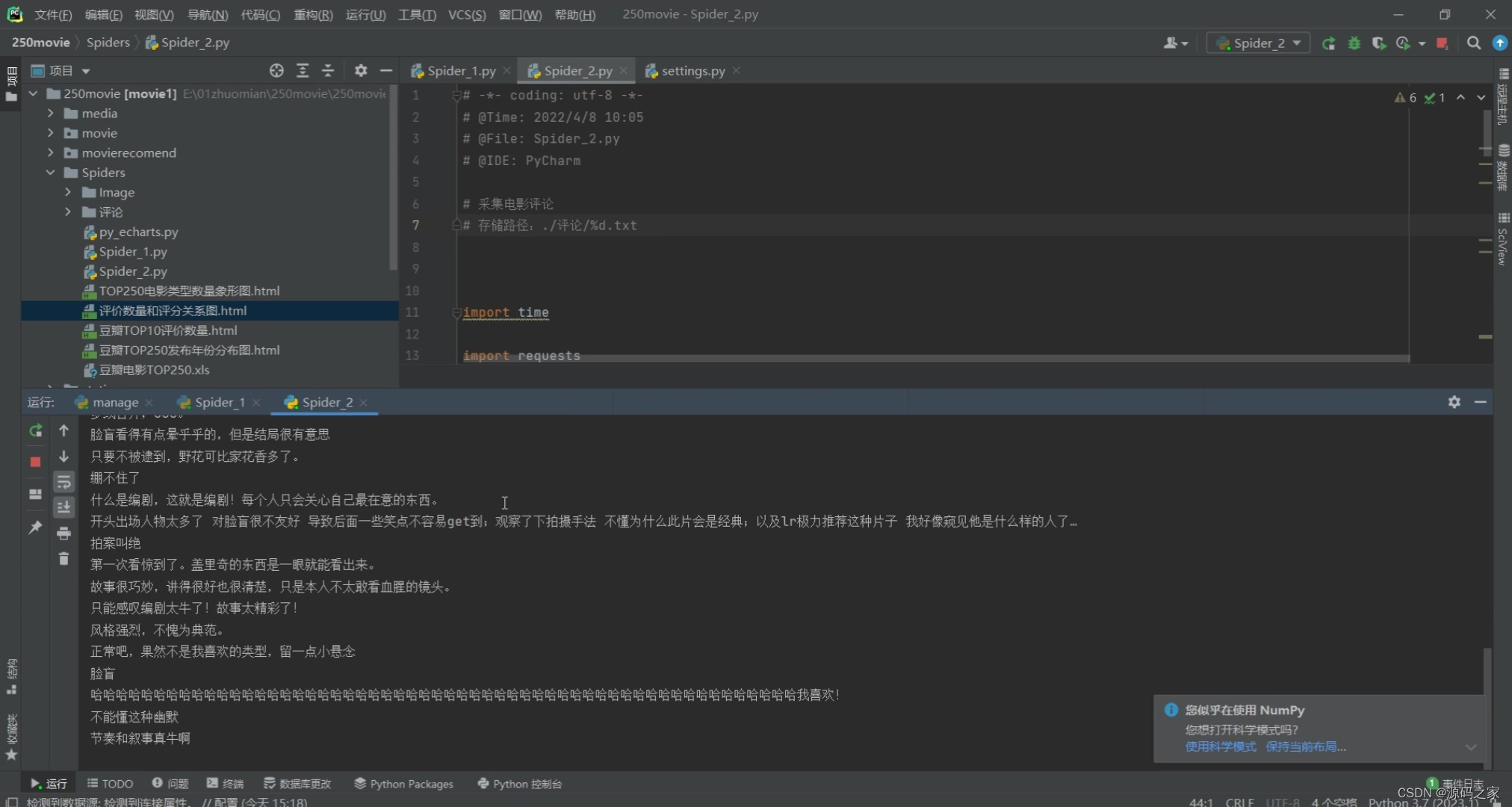

(12)电影数据采集页面

3、项目说明

本项目是基于Python语言与Django框架开发的豆瓣电影数据采集分析可视化推荐系统,整合requests爬虫、MySQL数据库、双协同过滤推荐算法(基于用户+基于物品)及Echarts可视化技术,构建"数据采集-存储-分析-推荐-展示-管理"的完整流程,旨在解决电影信息分散、推荐不精准、数据展示不直观的问题。

(1)数据采集与存储

系统通过requests爬虫技术定向分析豆瓣电影网页结构,提取电影名称、评分、导演、演员、类型、剧情简介等核心信息,经数据清洗(过滤无效数据、补全缺失值)后,存储至MySQL数据库,保障数据的完整性与可追溯性;同时提供"电影数据采集页面",支持手动触发爬虫任务,实时更新数据库中的电影数据,确保信息时效性。

(2)个性化推荐功能

核心采用双协同过滤推荐算法提升精准度:

- 基于用户的协同过滤:通过分析用户历史评分、收藏等行为数据,计算用户间兴趣相似度,找到与目标用户偏好一致的"相似用户群",推荐该群体喜欢的电影;

- 基于物品的协同过滤 :计算电影间的相似度(如类型匹配度、用户评分重合度),为用户推荐与其已喜欢电影风格相近的作品。

两种算法结合,有效避免单一推荐的局限性,让推荐结果更贴合用户个性化需求。

(3)数据可视化展示

借助Echarts可视化工具,将豆瓣电影数据以多维度图表呈现:

- 饼状图分析电影类型占比、评分分布;

- 词云图提炼热门电影关键词、演员/导演热度;

- 柱状图对比不同导演作品数量、电影评分排行;

- 曲线图展示电影评分随时间变化趋势。

直观的可视化效果帮助用户快速把握电影市场规律,降低数据理解门槛。

(4)Web系统与功能模块

基于Django框架搭建Web应用,分为前台用户端与后台管理端:

- 前台用户端:支持注册登录、电影浏览/搜索/查看详情、电影分类筛选、接收个性化推荐,用户可通过评分、收藏等操作优化推荐精度;

- 后台管理端:提供电影数据管理(增删改查)、用户信息管理、爬虫任务监控等功能,保障系统数据有序性与运营稳定性。

整体而言,系统既满足用户"找片-看片推荐"的核心需求,又通过技术整合实现电影数据的高效利用,为电影推荐领域提供"爬虫+算法+可视化"的一体化解决方案,具备较强的实用性与可扩展性。

4、核心代码

python

import requests # 导包

from lxml import etree # 导包

import time

import xlwt

def main(): # 定义主函数

print('开始爬取数据...')

data_list = get_data(headers) # 获取数据列表

save_data(data_list)

print('爬取完毕!')

def get_data(headers):

data_list = []

start_url = 'https://movie.douban.com?start=' # 起始地址

for i in range(0, 10):

print('开始爬取第%d页...' % (i + 1))

url = start_url + '%d&filter=' % (i * 25) # 拼接请求地址

response = requests.get(url, headers=headers).text

req_html = etree.HTML(response) # 把网页转换为etree对象

div_data = req_html.xpath('//div[@class="item"]')

for data in div_data:

movie_list = []

movie_num = data.xpath('./div[1]/em/text()')[0] # 排名

movie_name = data.xpath('./div[2]/div[1]/a/span[1]/text()')[0] # 电影名

movie_datas = data.xpath('./div[2]/div[2]/p[1]/text()') # 年代/国家/剧情

movie_datas = "".join(movie_datas) # 拼接列表

movie_datas = movie_datas.split('\n')

movie_datas = movie_datas[2].replace(' ', '').replace('\xa0', '').split('/')

movie_date = movie_datas[0].replace('(中国大陆)', '') # 年代

movie_year = movie_datas[1] # 国家

movie_plot = movie_datas[2] # 剧情类型

movie_score = data.xpath('./div[2]/div[2]/div/span[2]/text()')[0] # 评分

movie_evaluate = data.xpath('./div[2]/div[2]/div/span[4]/text()')[0] # 评价数量

movie_url = data.xpath('./div[1]/a/@href')[0] # 电影链接

movie_list.append(movie_num) # 添加到列表信息

movie_list.append(movie_name)

movie_list.append(movie_date)

movie_list.append(movie_year)

movie_list.append(movie_plot)

movie_list.append(movie_score)

movie_list.append(movie_evaluate.replace('人评价', ''))

# print(movie_list)

movie_list.append(movie_url)

data_list.append(movie_list) # 将电影信息添加到数据列表以便数据持久化

time.sleep(3) # 等待3S接着爬

return data_list # 返回数据列表

def save_data(data_list):

print('开始保存数据...')

book = xlwt.Workbook(encoding="utf-8", style_compression=0)

sheet = book.add_sheet('豆瓣电影', cell_overwrite_ok=True)

col = ("电影排名", "电影名", "电影年代", "发行国家", "剧情类型", "评分", "评论数量", "电影链接") # 表头名

for i in range(0, 8):

sheet.write(0, i, col[i]) # 列表名称

for k in range(0, len(data_list)): # 行

data = data_list[k]

for j in range(0, 8):

sheet.write(k + 1, j, data[j]) # 写入数据第二行,第0-7列

book.save('./豆瓣电影.xls')

if __name__ == '__main__':

main()🍅✌**感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目编程以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!**🍅✌

5、源码获取方式

🍅**由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。**🍅

点赞、收藏、关注,不迷路,下方查看 👇🏻获取联系方式👇🏻