一、简介

本文深入解析AKAZE特征检测算法的核心原理(对比KAZE、SIFT/SURF的差异),并通过OpenCV Python实现从图像读取、特征检测、暴力匹配到透视变换的完整流程,结合代码细节与结果分析,帮助快速掌握高效特征匹配的实践方法。

二、KAZE与AKAZE:算法原理与差异

KAZE(日语"风"的音译)是一种基于非线性尺度空间的局部特征检测算法,解决了SIFT、SURF等传统算法因线性尺度空间(高斯金字塔)过度平滑图像边缘的问题。其核心步骤包括:

- 非线性尺度空间构造:通过非线性扩散滤波保留边缘细节,生成更准确的尺度空间;

- Hessian矩阵特征点检测 :在尺度空间中用Hessian矩阵检测极值点,保证尺度不变性;

- 方向指定与描述子生成 :基于一阶微分图像为特征点指定主方向(旋转不变性 ),并对描述子进行归一化(光照不变性)。

AKAZE(Accelerated KAZE)是KAZE的加速版本,通过**快速显式扩散(FED)**优化非线性扩散过程,在保持非线性尺度空间优势的同时,将检测速度提升数倍(原文提到KAZE需2秒以上,AKAZE仅需0.几秒),更适合实时应用。

三、OpenCV Python实现流程

1. 环境准备

需安装包含扩展算法的OpenCV库:

bash

pip install opencv-python opencv-contrib-python2. 代码实现步骤

(1)读取图像

首先读取两张灰度图像(AKAZE特征检测通常基于灰度图,减少计算量):

python

import cv2

import numpy as np

# 读取灰度图像(替换为你的图像路径)

img1 = cv2.imread('1.png', cv2.IMREAD_GRAYSCALE)

img2 = cv2.imread('2.png', cv2.IMREAD_GRAYSCALE)

# 显示第一张图像

cv2.namedWindow('Input Image 1', cv2.WINDOW_AUTOSIZE)

cv2.imshow('Input Image 1', img1)(2)AKAZE特征检测与描述子提取

创建AKAZE检测器,检测图像中的特征点并计算描述子(用于后续匹配):

python

# 初始化AKAZE检测器(默认使用二进制描述子)

akaze = cv2.AKAZE_create()

# 检测特征点并计算描述子(mask为None表示无区域限制)

kp1, des1 = akaze.detectAndCompute(img1, None)

kp2, des2 = akaze.detectAndCompute(img2, None)(3)暴力匹配(Brute-Force Matching)

使用暴力匹配器 (BFMatcher)匹配两张图像的特征描述子。由于AKAZE默认生成二进制描述子,需使用汉明距离 (cv2.NORM_HAMMING)衡量相似性:

python

# 初始化暴力匹配器(crossCheck=False表示不要求双向匹配)

bf = cv2.BFMatcher(cv2.NORM_HAMMING, crossCheck=False)

# 匹配两张图像的描述子

matches = bf.match(des1, des2)

# 绘制暴力匹配结果(保留单特征点)

match_img = cv2.drawMatches(

img1, kp1, img2, kp2, matches, None,

flags=cv2.DRAW_MATCHES_FLAGS_DEFAULT

)

cv2.imshow('Brute-Force Matching Result', match_img)

cv2.waitKey()

(4)筛选"好的匹配"(Good Matches)

暴力匹配会产生大量冗余结果,需通过匹配距离筛选高质量匹配(距离越小,匹配越精准):

python

# 计算所有匹配的最小距离(初始化为无穷大)

min_dist = float('inf')

for match in matches:

if match.distance < min_dist:

min_dist = match.distance

# 筛选规则:距离 < max(1.5×最小距离, 0.02)(避免最小距离过小时筛选过严)

good_matches = [match for match in matches if match.distance < max(1.5 * min_dist, 0.02)]

# 绘制好的匹配结果(不显示单特征点)

good_match_img = cv2.drawMatches(

img1, kp1, img2, kp2, good_matches, None,

flags=cv2.DRAW_MATCHES_FLAGS_NOT_DRAW_SINGLE_POINTS

)

cv2.imshow('Good Matches Result', good_match_img)

cv2.waitKey()

(5)透视变换与对象定位

通过好的匹配计算单应性矩阵(Homography),实现图像的透视变换,定位目标对象在第二张图像中的位置:

python

# 收集好的匹配对应的特征点坐标(转换为Numpy数组)

src_pts = np.float32([kp1[match.queryIdx].pt for match in good_matches]).reshape(-1, 1, 2)

dst_pts = np.float32([kp2[match.trainIdx].pt for match in good_matches]).reshape(-1, 1, 2)

# 计算单应性矩阵(使用RANSAC去除异常值,阈值5.0)

H, mask = cv2.findHomography(src_pts, dst_pts, cv2.RANSAC, 5.0)

# 获取第一张图像的四个角点(用于透视变换)

h, w = img1.shape

src_corners = np.float32([[0, 0], [w, 0], [w, h], [0, h]]).reshape(-1, 1, 2)

# 透视变换角点到第二张图像的坐标

dst_corners = cv2.perspectiveTransform(src_corners, H)

# 在匹配图上绘制变换后的矩形(第二张图像的x坐标需加第一张图像的宽度)

img2_width = img1.shape[1]

for i in range(4):

# 计算矩形顶点坐标(匹配图中第二张图像的起始x为img1宽度)

start = dst_corners[i][0] + np.array([img2_width, 0])

end = dst_corners[(i+1)%4][0] + np.array([img2_width, 0])

# 绘制红色矩形(线宽2)

cv2.line(good_match_img, (int(start[0]), int(start[1])), (int(end[0]), int(end[1])), (0, 0, 255), 2)

# 显示最终结果

cv2.imshow('Perspective Transform Result', good_match_img)

# 等待按键退出

cv2.waitKey(0)

cv2.destroyAllWindows()

四、结果分析

通过上述流程,我们实现了从AKAZE特征检测到透视变换的完整 pipeline:

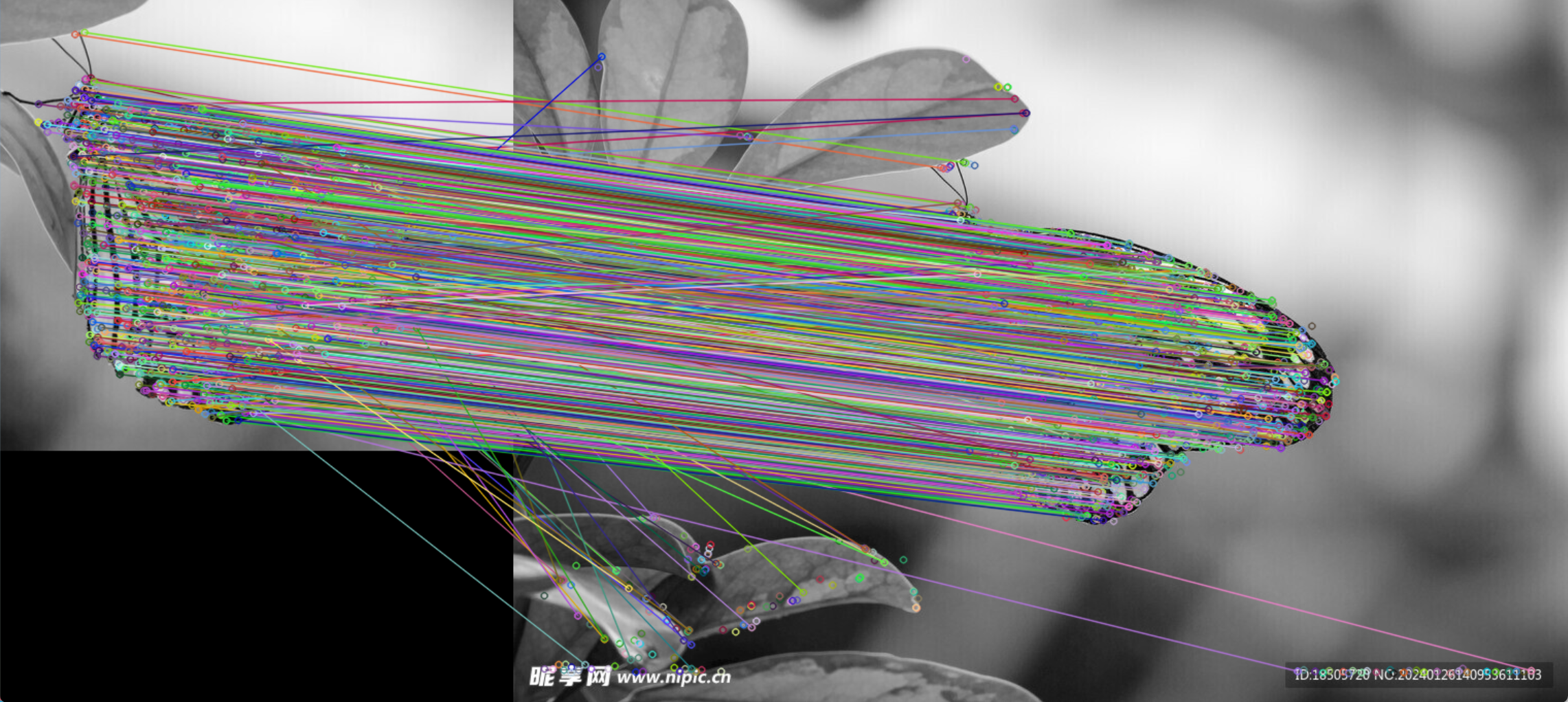

- 暴力匹配:展示了两张图像的所有特征对应关系,但包含大量冗余匹配;

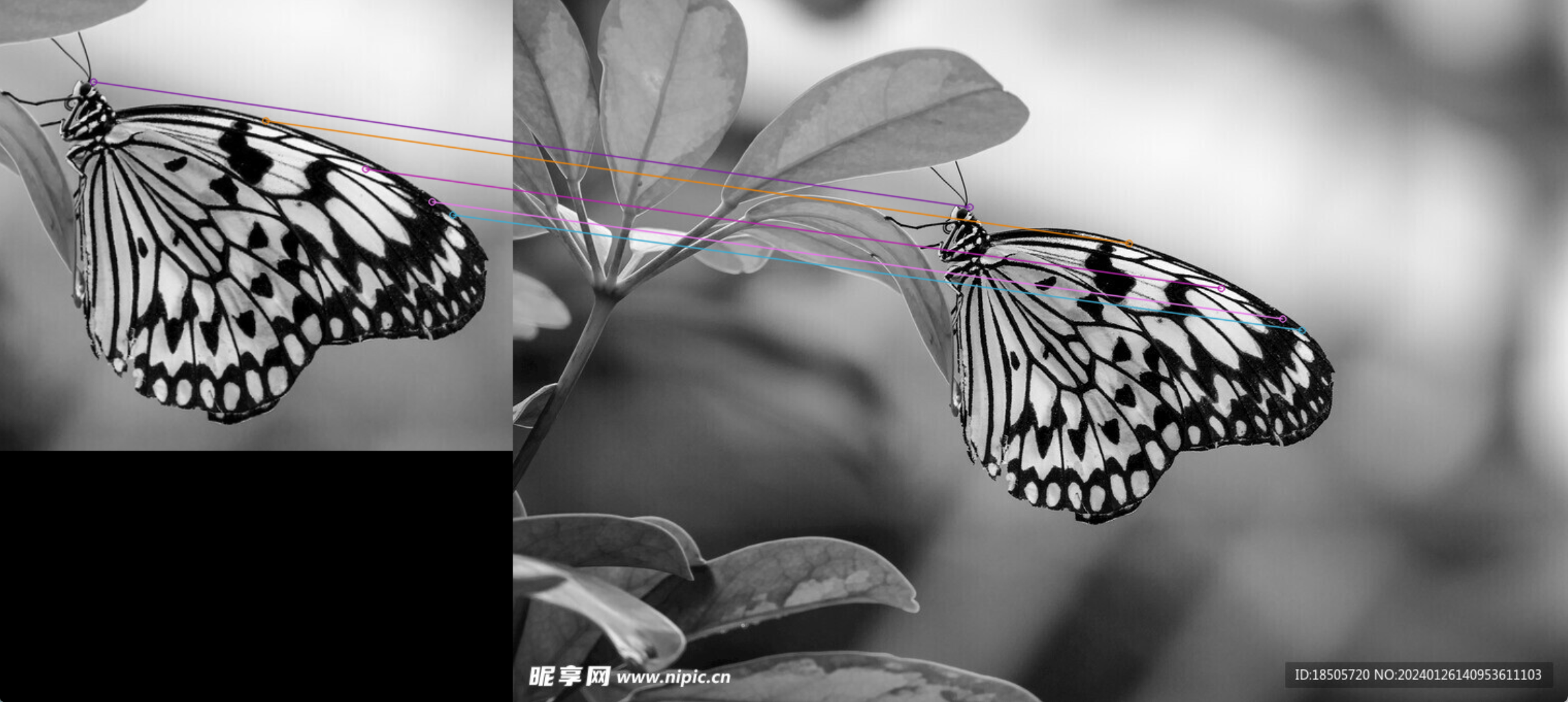

- 好的匹配:通过距离筛选显著提升了匹配准确性,保留了核心特征对应;

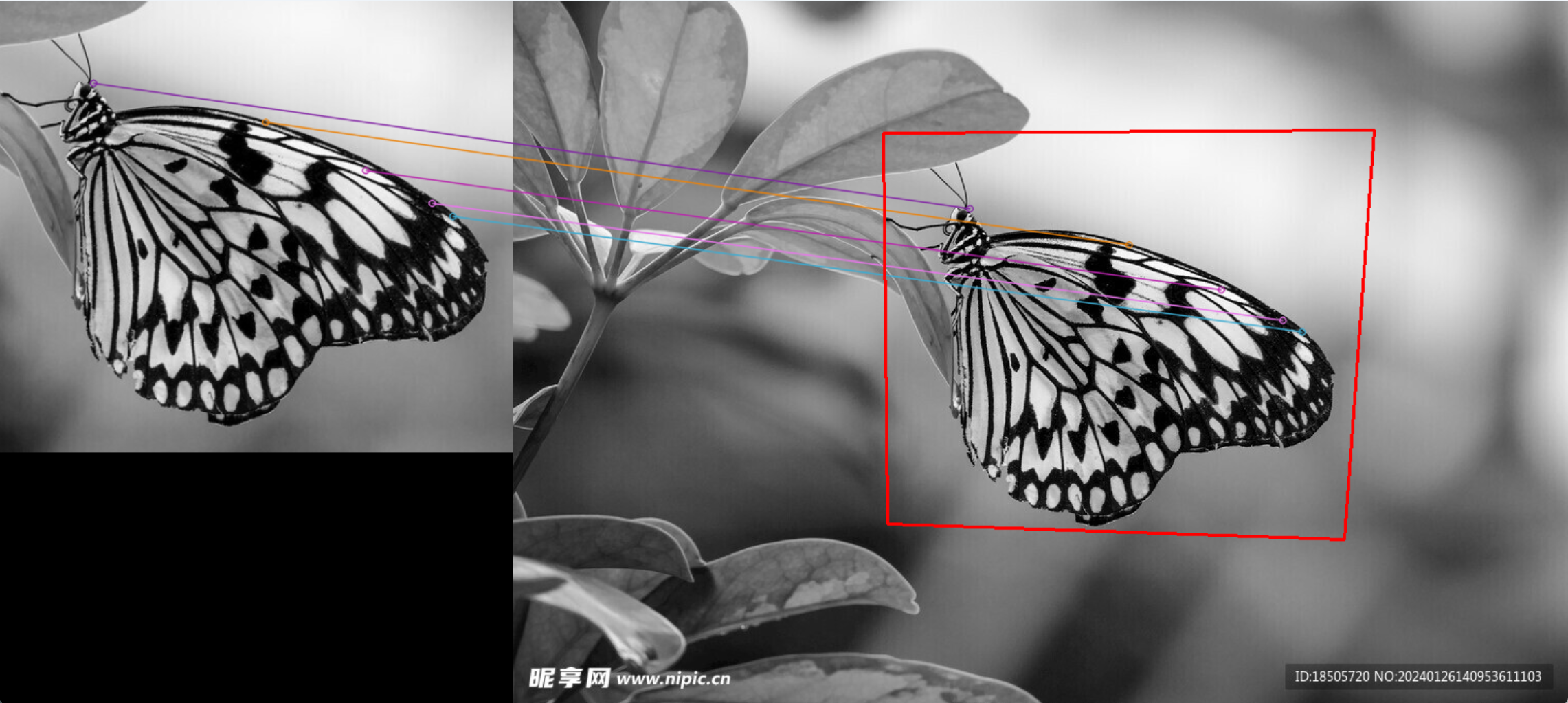

- 透视变换:通过单应性矩阵定位了目标对象在第二张图像中的位置,红色矩形清晰标记了对象边界。

AKAZE的非线性尺度空间设计使其在保留边缘信息的同时,检测速度远快于KAZE,是实时特征匹配(如目标跟踪、图像拼接)的理想选择。