在深度学习模型部署到边缘设备或资源受限环境中时,模型压缩是绕不开的关键步骤。其中,模型剪枝(Pruning)因其在保持模型精度方面的优秀表现而广受关注。本文将从神经科学和信息论的底层视角出发,详细解析神经网络中存在的冗余性 ,解释模型剪枝如何精准定位并移除这些冗余连接和参数,最终实现模型压缩、加速推理,同时保持甚至有时微弱提升模型性能的秘密。

1. 冗余性的根源:深度神经网络的"过参数化"

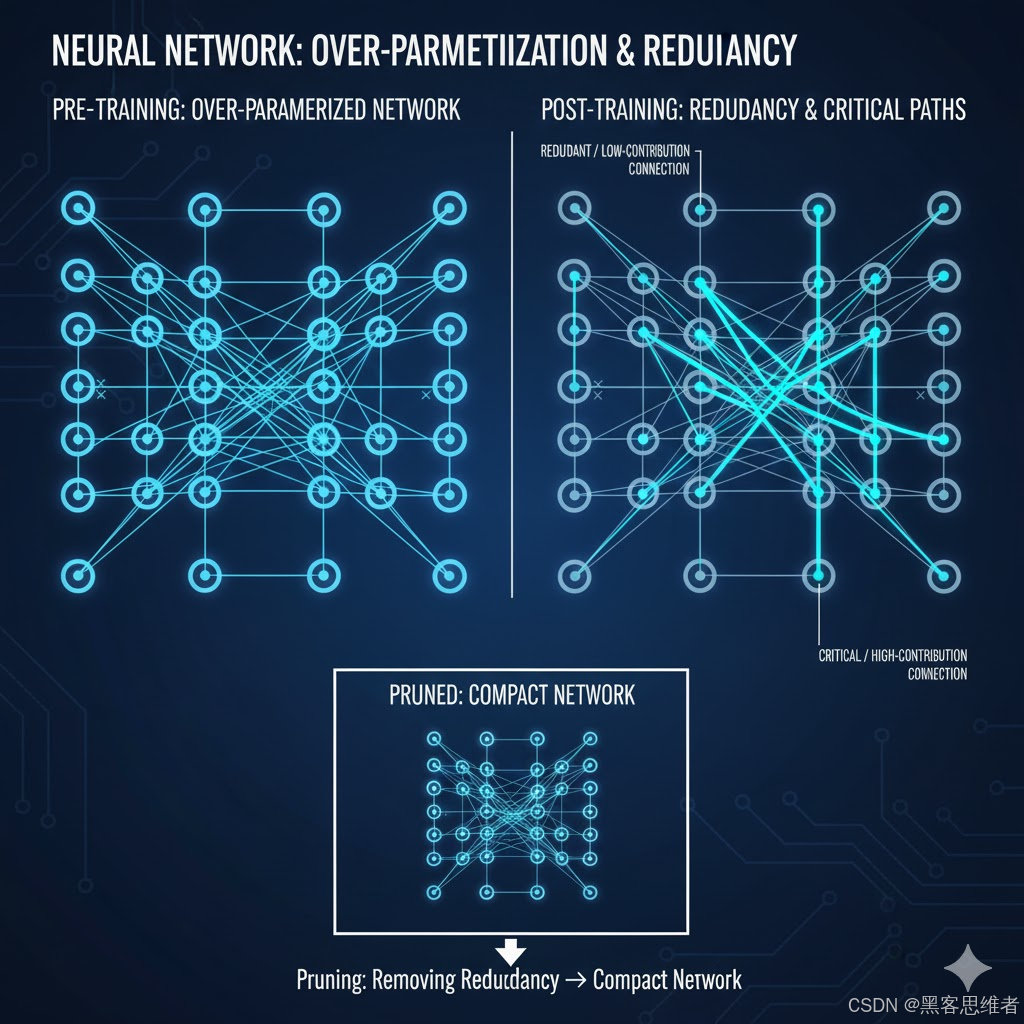

要理解剪枝的作用,首先要明确深度学习模型,尤其是大型网络(如 ResNet, Transformer),普遍存在的**"过参数化"(Over-parameterization)**现象。

1.1 学习能力的超额储备

当我们训练一个大型神经网络时,我们往往采用远超过完成任务所需参数量的模型。这种过参数化的设计初衷是:

- 易于优化: 参数冗余能使损失函数曲面(Loss Surface)更平滑,更容易找到全局或近似全局最优解,避免陷入局部最优。

- 泛化保障: 提供足够的容量来学习复杂的特征表示。

然而,这种设计也引入了一个副作用:巨大的冗余性。

1.2 神经科学的启发:稀疏编码

从神经生物学角度看,人脑在执行复杂任务时并非所有神经元都处于活跃状态,而是采用一种**稀疏编码(Sparse Coding)**的机制。只有那些携带关键信息的神经元和连接会被激活。

类比到神经网络:**在训练完成后,许多权重(Weight)和连接(Connection)的值接近于零,对模型的最终输出贡献极小,甚至为零。**它们虽然存在于计算图中,但实际上只是"占位符"。这些便是剪枝的主要目标------冗余连接。

2. 剪枝的底层原理:定位"沉默的多数"与保留"关键路径"

模型剪枝的核心逻辑是:通过移除这些对结果贡献极小的冗余参数,只保留网络中学习到的**"关键知识路径"(Critical Knowledge Path)**。

2.1 识别冗余:基于权重的敏感度分析

最常见的剪枝方法是基于权重大小进行剪枝。

- 原理: 在一个训练好的网络中,如果一个权重 Wi,jW_{i, j}Wi,j 的绝对值 ∣Wi,j∣|\mathbf{W}{i, j}|∣Wi,j∣ 极小,那么它对该神经元 jjj 的输入贡献 ∑iWi,j⋅xi\sum{i} W_{i, j} \cdot x_{i}∑iWi,j⋅xi 也必然很小。移除它,对整体输出的扰动微乎其微。

- 数学定义: 剪枝器设定一个阈值 τ\tauτ。对于任何满足 ∣Wi,j∣<τ|\mathbf{W}_{i, j}| < \tau∣Wi,j∣<τ 的权重,将其置为零或直接移除。

更精细的方法会采用泰勒展开(Taylor Expansion)或敏感度分析(Sensitivity Analysis),计算移除某个参数后损失函数增加的幅度。如果增加幅度极小,则该参数是冗余的。

2.2 知识固化:关键路径的重新强化

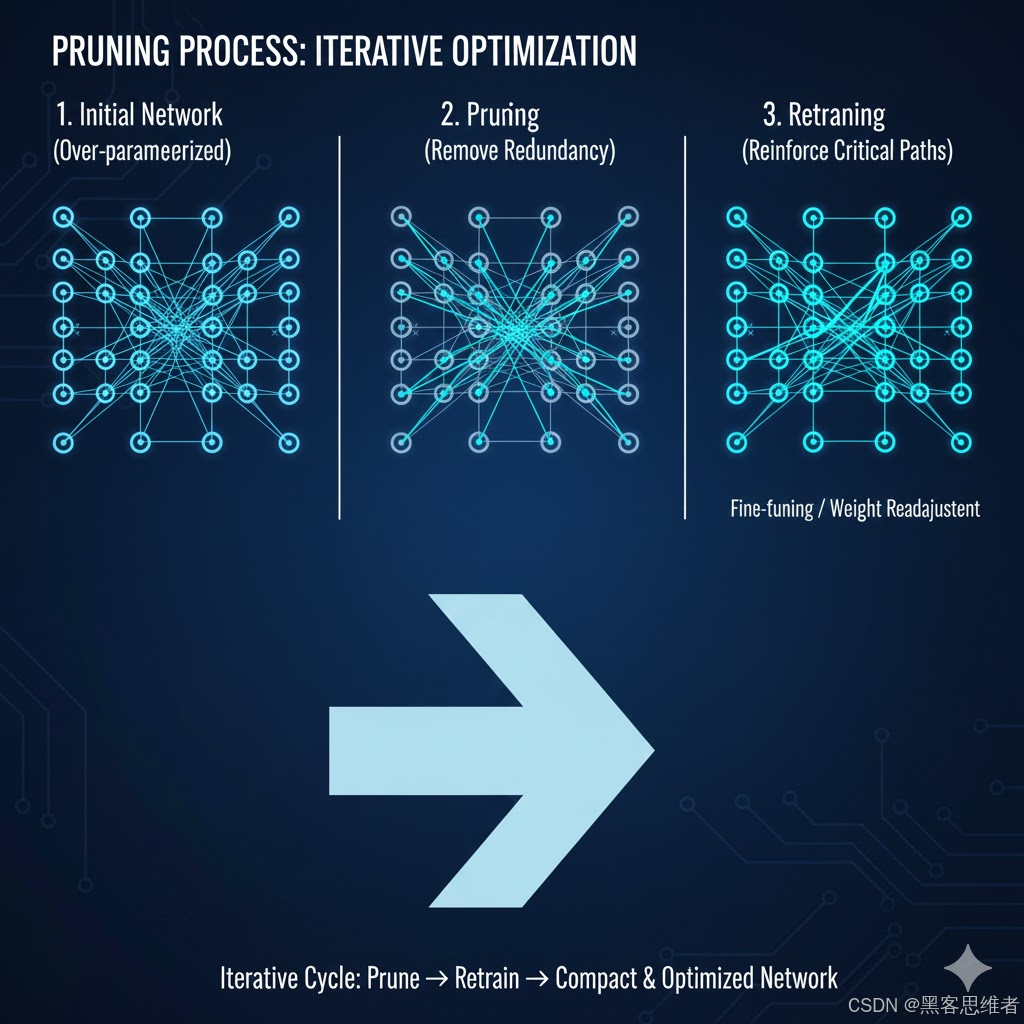

剪枝并非简单地删除,而是"删除-再训练"的迭代过程。

- 删除(Prune): 移除冗余连接,使网络变得稀疏。

- 修复(Retrain): 在剩余的"关键路径"上进行微调(Fine-tuning)。

由于被移除的参数对模型的贡献本就极小,微调过程能迅速让剩下的少数关键参数重新调整并吸收 被移除参数所携带的"知识"。这使得网络以更少的参数,实现与原网络相当的特征映射能力。这就像把一个庞大的团队裁员后,剩下的核心成员分担了原有的所有任务,最终团队的效率反而更高。

3. 性能提升的直接来源:从稀疏到紧凑

剪枝带来的性能优势,并非仅仅源于参数量的减少,更重要的是它在计算和硬件层面的优化。

3.1 减少计算量(FLOPs)

参数量(Parameters)和浮点运算次数(FLOPs)是衡量模型复杂度的两个重要指标。

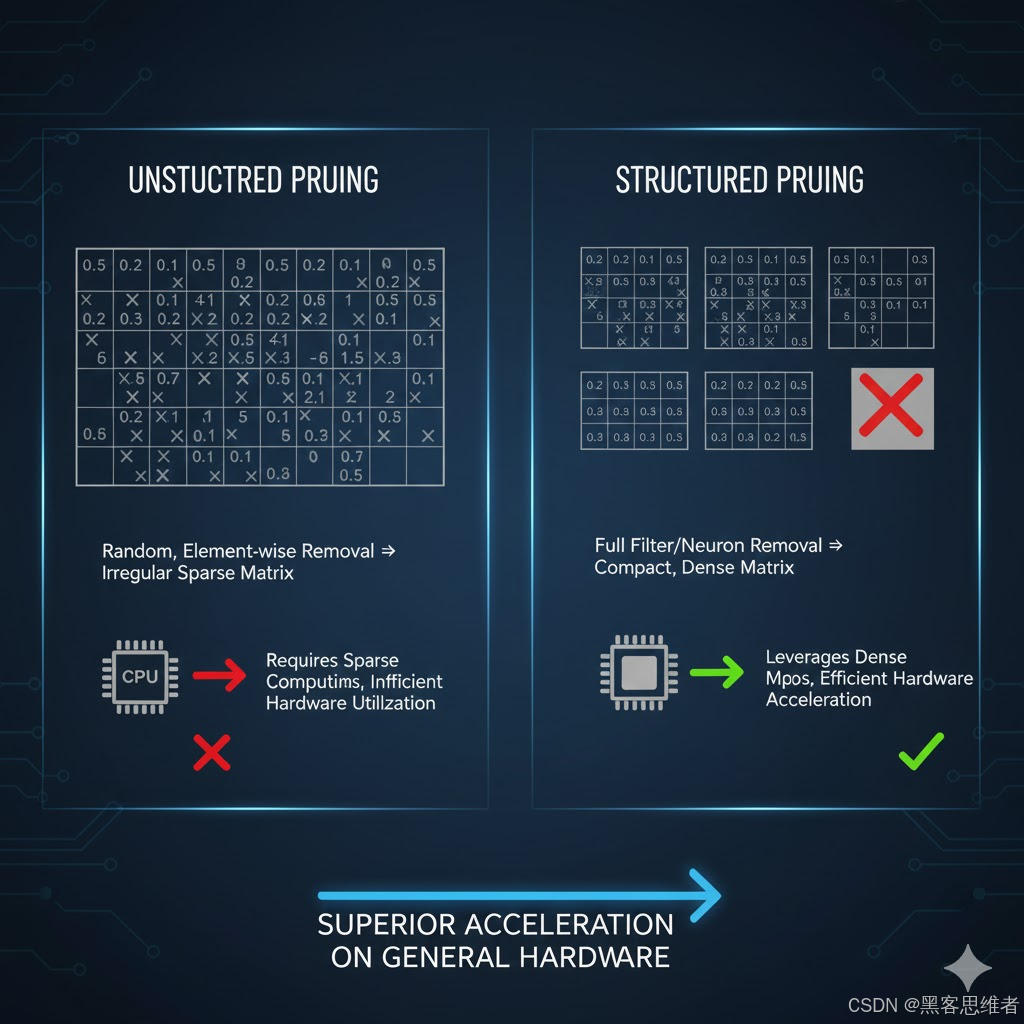

- 非结构化剪枝(Unstructured Pruning): 移除的是任意位置的单个权重。虽然减少了参数量,但由于剩下的连接是稀疏且不规则的,需要专用的**稀疏矩阵库(Sparse Matrix Library)**和硬件才能实现真正的 FLOPs 减少和加速。否则,内存访问不连续性反而会降低效率。

- 结构化剪枝(Structured Pruning): 移除的是整个神经元、整个卷积核(Filter)、甚至整个层。

- 原理: 这种方式使得剩余的矩阵运算保持稠密性(Dense),可以直接使用现有的高性能通用矩阵乘法库(如 cuBLAS, MKL)。

- 优势: 直接减少了输入和输出的维度,从而乘法次数(FLOPs)被直接削减,实现了真正的推理速度提升。

3.2 内存与硬件加速的配合

对于边缘计算设备(如手机 SoC、FPGA):

- 内存带宽瓶颈缓解: 剪枝直接减少了模型大小,降低了模型在内存中的存储和传输开销。在推理过程中,从内存读取参数的时间(Memory Bandwidth Bottleneck)往往比实际计算时间更长。模型变小,这一瓶颈得到缓解。

- 硬件兼容性: 结构化剪枝保证了裁剪后的模型结构是规则的,可以更好地映射到 ASIC 或 FPGA 等定制硬件的计算单元上,进一步发挥硬件并行计算的优势,实现比非结构化剪枝更高的加速比。

4. 总结与展望

模型剪枝之所以能在几乎不损失性能的情况下压缩模型,其底层逻辑建立在深度神经网络固有的过参数化冗余之上。

剪枝通过敏感度分析精准定位这些"沉默的多数"并将其移除,同时利用微调强化关键知识路径 。特别地,结构化剪枝将稀疏性转化为规则的紧凑结构,实现了 FLOPs 的硬性减少和硬件加速的完美配合。

随着未来对模型效率要求的不断提高,剪枝技术将与量化(Quantization)、知识蒸馏(Knowledge Distillation)等技术融合发展,成为工业界部署高效率、低功耗 AI 模型的必备工具。