《博主简介》

小伙伴们好,我是阿旭。

专注于计算机视觉领域,包括目标检测、图像分类、图像分割和目标跟踪等项目开发,提供模型对比实验、答疑辅导等。

《------往期经典推荐------》

二、机器学习实战专栏【链接】 ,已更新31期,欢迎关注,持续更新中~~

三、深度学习【Pytorch】专栏【链接】

四、【Stable Diffusion绘画系列】专栏【链接】

五、YOLOv8改进专栏【链接】,持续更新中~~

六、YOLO性能对比专栏【链接】,持续更新中~

《------正文------》

目录

LAMP剪枝(Layer-Adaptive Magnitude-based Pruning)是一种基于权重幅度的全局剪枝方法,其核心思想是通过最小化模型输出失真来自动确定每层的最优稀疏度。

一、基本思想:从层间稀疏度选择到全局剪枝

传统幅度剪枝(MP)通常依赖预设的层间稀疏度(如均匀剪枝或启发式规则),而LAMP通过一种归一化的权重重要性评分,将层间MP扩展为全局剪枝。其评分公式为:

score(u; W) = (W[u])² / ∑_{v≥u} (W[v])²其中:

-

W[u]是权重张量中第 u个连接(按幅度升序排列);

-

分母是当前层中所有不小于 W[u]的权重的平方和。

该评分本质是权重平方的归一化值,反映当前连接在"未剪枝权重"中的相对重要性。

二、设计动机:最小化输出失真

LAMP的灵感来源于对MP的理论重构:

- 层间MP等价于Frobenius失真最小化 :

对单层而言,MP实际是优化问题

的解,其中 M是剪枝掩码。该问题可视为输出 ℓ2失真(对最坏情况输入)的松弛形式。 - 扩展至模型级失真 :

LAMP进一步考虑剪枝对整个模型输出的失真影响,通过贪心策略逐步移除对模型输出失真最小的连接。

三、算法流程

- 计算LAMP评分:对每层权重按幅度排序,计算每个连接的LAMP评分。

- 全局剪枝:根据LAMP评分对所有连接进行全局排序,移除评分最低的连接直至满足目标稀疏度。

- 自动分层效果:由于评分依赖层内权重的分布,LAMP会自动为不同层分配不同的稀疏度。例如,权重分布较平坦的层会更稀疏,而关键层(如首尾层)则保留更多连接。

四、关键特性

-

无超参数:无需手动调整层间稀疏度或正则化强度。

-

结构自适应 :

自动保留首尾层更多连接(与启发式规则一致);

在极端稀疏下,倾向于使每层剩余连接数均匀(见图5下层),可能提升表达能力。

-

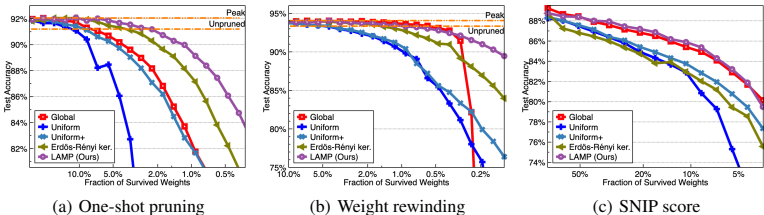

兼容性强:适用于一次性剪枝、迭代剪枝、权重回退(rewinding)等场景。

五、实验验证

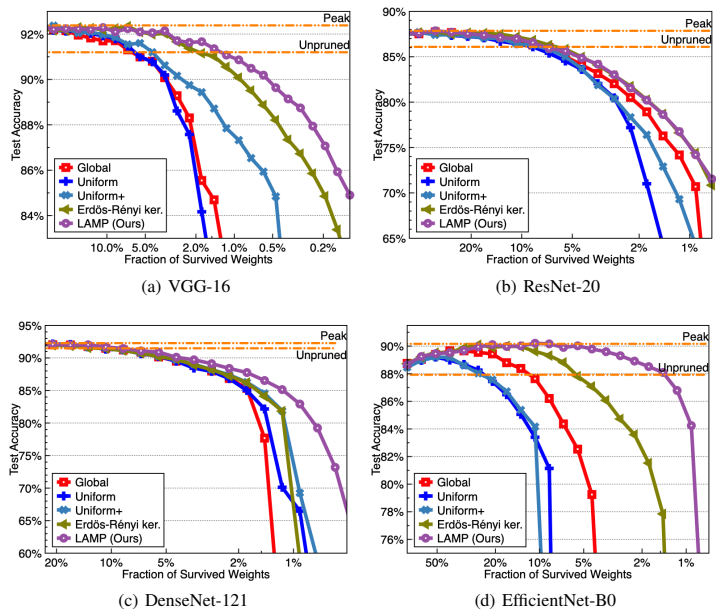

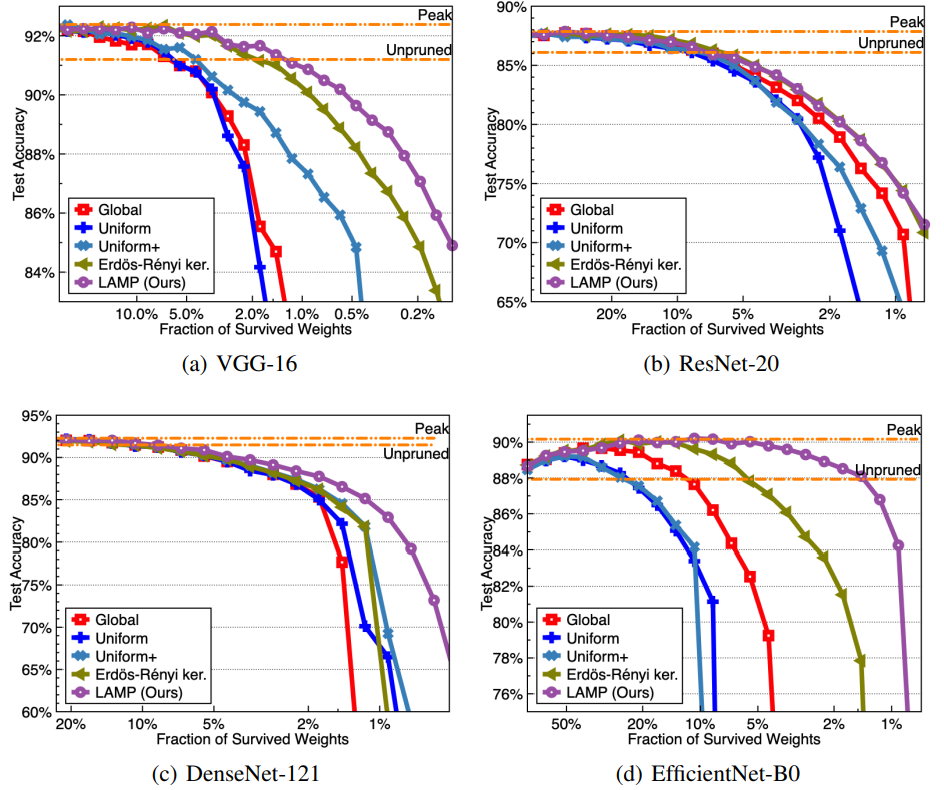

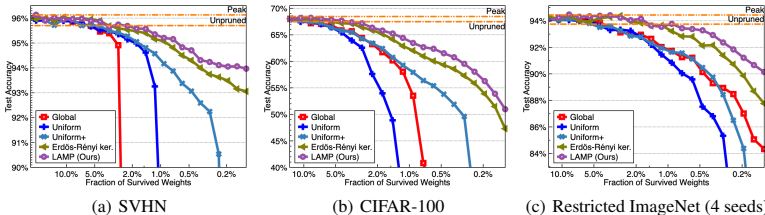

在多个模型(VGG-16、ResNet、DenseNet等)和数据集(CIFAR-10/100、ImageNet)上的实验表明:

- LAMP在相同稀疏度下准确率更高,尤其在高效网络(如EfficientNet-B0)中优势显著;

- 其分层稀疏度模式与强化学习搜索方法(如AMC)结果相似,但计算成本更低。

总结

LAMP通过将幅度剪枝与模型级失真最小化结合,提供了一种理论驱动、无需调参、自动分层的全局剪枝方案,成为幅度剪枝中"即插即用"的层间稀疏度选择工具。

好了,这篇文章就介绍到这里,喜欢的小伙伴感谢给点个赞和关注,更多精彩内容持续更新~~

关于本篇文章大家有任何建议或意见,欢迎在评论区留言交流!