目录

一、方法论

[1.1 NoteLLM框架](#1.1 NoteLLM框架)

[1.2 笔记压缩提示](#1.2 笔记压缩提示)

编辑

特殊令牌与占位符说明

分类生成的具体内容定义

以下为话题标签生成的模板:

[1.3 生成-对比学习](#1.3 生成-对比学习)

协同信号整合

[1.4 协同监督微调(Collaborative Supervised Fine-Tuning)](#1.4 协同监督微调(Collaborative Supervised Fine-Tuning))

上一篇论文:推荐大模型系列-NoteLLM: A Retrievable Large Language Model for Note Recommendation(一)

一、方法论

1.1 NoteLLM框架

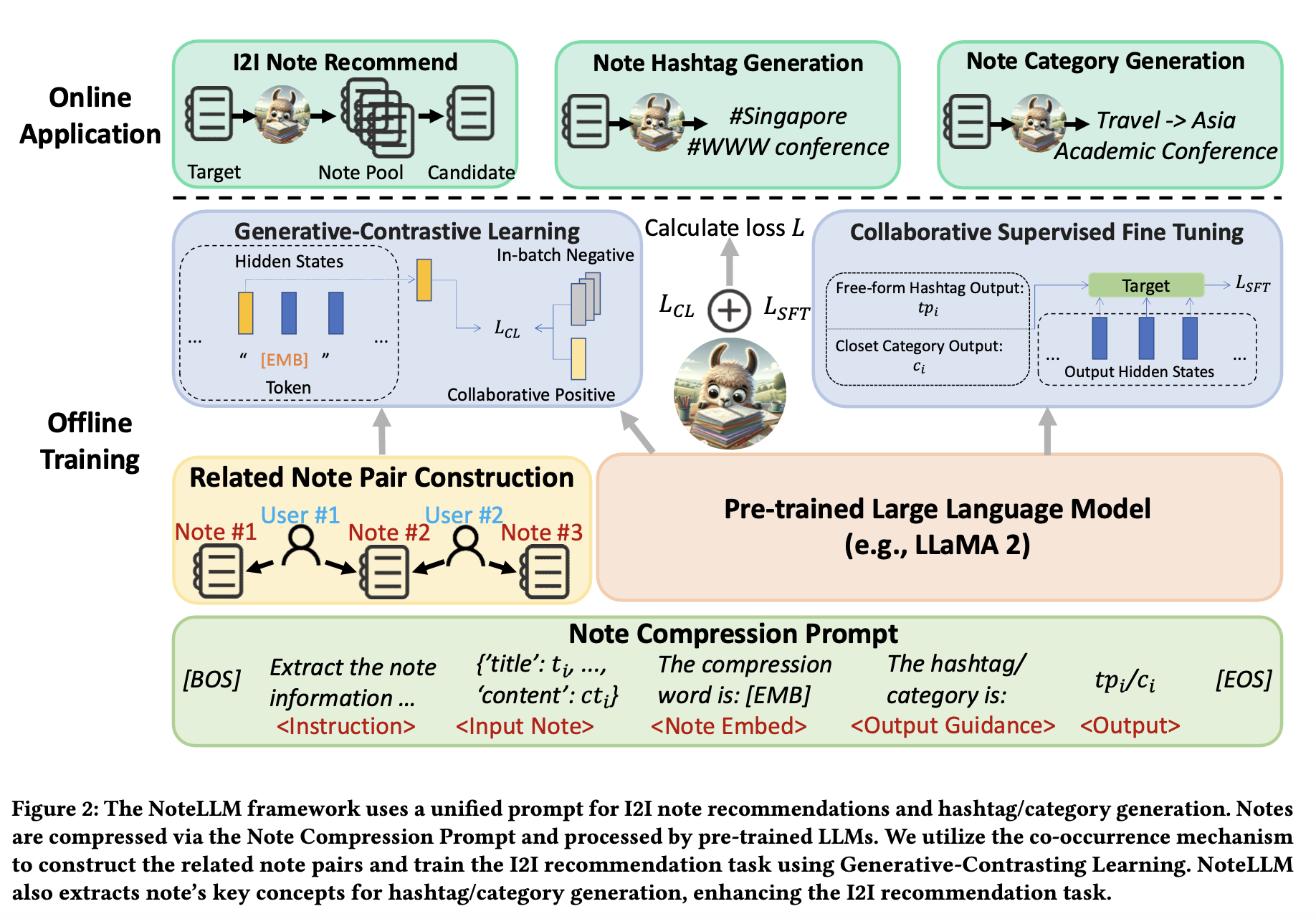

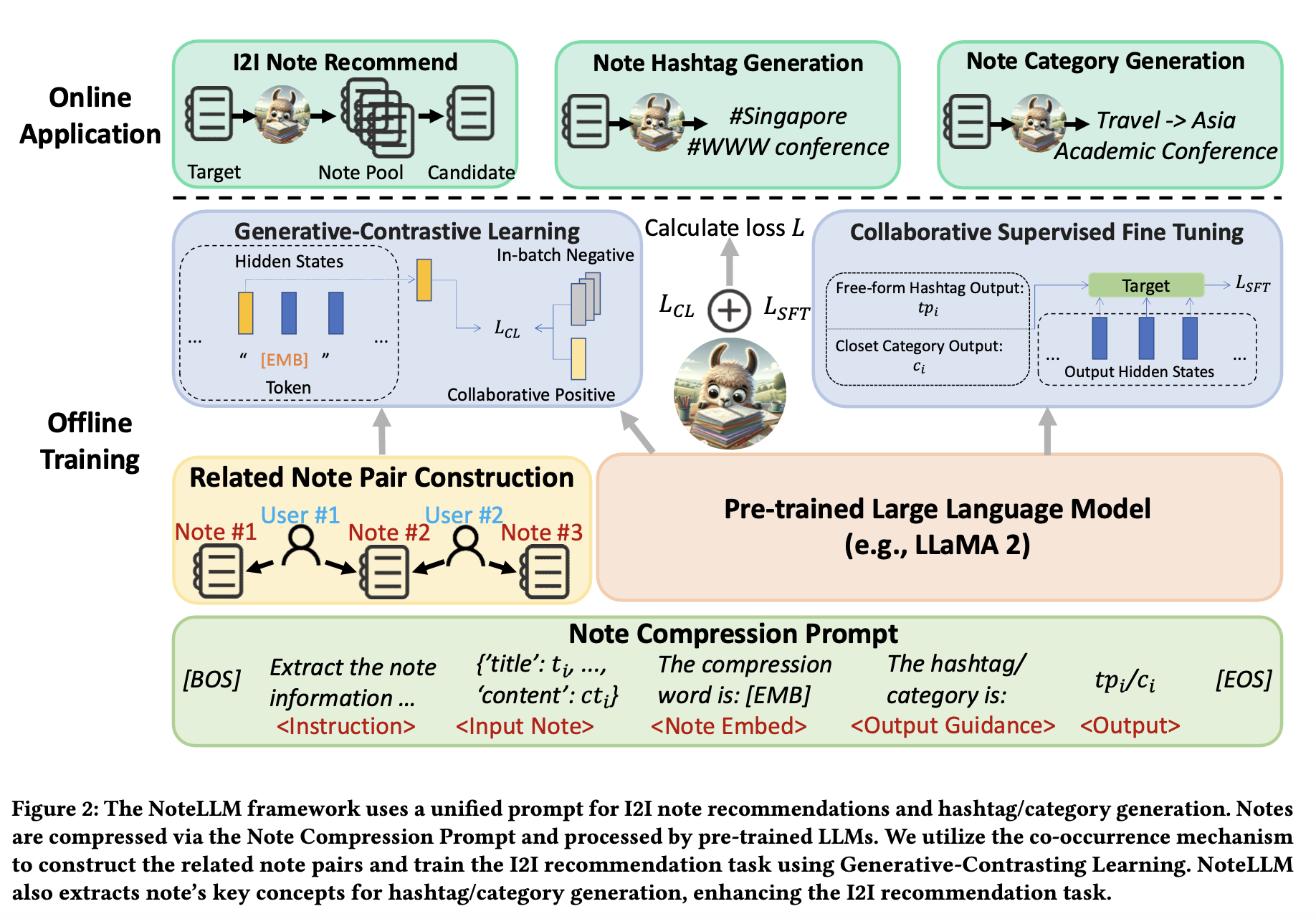

本节介绍NoteLLM的框架,包含三个核心组件:笔记压缩提示词构建(Note Compression Prompt Construction)、生成式对比学习(GCL)和协同监督微调(CSFT),如图2所示。

通过笔记压缩提示灵活管理图像到图像(I2I)推荐任务及标签/分类生成任务。这些提示经分词后输入大语言模型(LLMs)。NoteLLM将协同信号与语义信息共同嵌入隐藏状态中。

生成式对比学习(GCL)利用生成压缩词的隐藏状态进行对比学习,从而捕获协同信号。

协同监督微调(CSFT)结合笔记的语义与协同信息,生成标签及分类内容。

1.2 笔记压缩提示

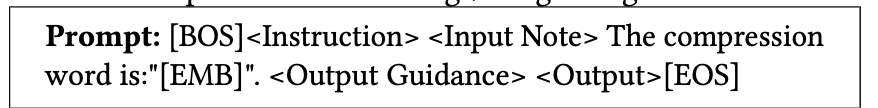

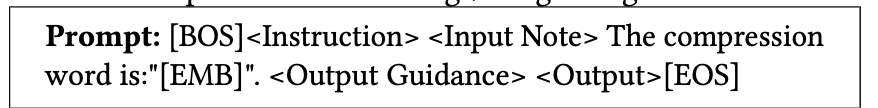

采用统一的笔记压缩提示(Note Compression Prompt)来同时支持图像到图像(I2I)推荐和生成任务。为了利用自回归大语言模型(LLMs)在I2I推荐任务中的生成能力,目标是将笔记内容压缩为单个特殊标记。这一压缩后的特殊标记通过生成式对比学习(GCL)获取协同知识,随后通过协同监督微调(CSFT)利用该知识生成标签/分类。

具体提出以下通用模板,用于笔记压缩及标签/分类生成:

特殊令牌与占位符说明

BOS\]、\[EMB\]、\[EOS\] 是特殊令牌(special tokens),用于标记文本的开始、嵌入和结束。

\、\、\