多相机拼接:OpenCV+Halcon实战代码!

- 🎯多相机拼接:消除重叠区域的6个核心方法,附OpenCV+Halcon实战代码!

-

- [🎯 一、先搞懂:为什么重叠区域会出现"拼接瑕疵"?](#🎯 一、先搞懂:为什么重叠区域会出现“拼接瑕疵”?)

- 🎯二、6个核心方法:消除重叠区域,从易到难按需选

-

- [1. 方法1:参数归一化(基础操作,先解决"色差")](#1. 方法1:参数归一化(基础操作,先解决“色差”))

- [2. 方法2:特征点匹配+单应性变换(解决"空间错位")](#2. 方法2:特征点匹配+单应性变换(解决“空间错位”))

- [3. 方法3:线性融合(简单融合,快速消缝)](#3. 方法3:线性融合(简单融合,快速消缝))

- [4. 方法4:多分辨率融合(拉普拉斯金字塔,高级消缝)](#4. 方法4:多分辨率融合(拉普拉斯金字塔,高级消缝))

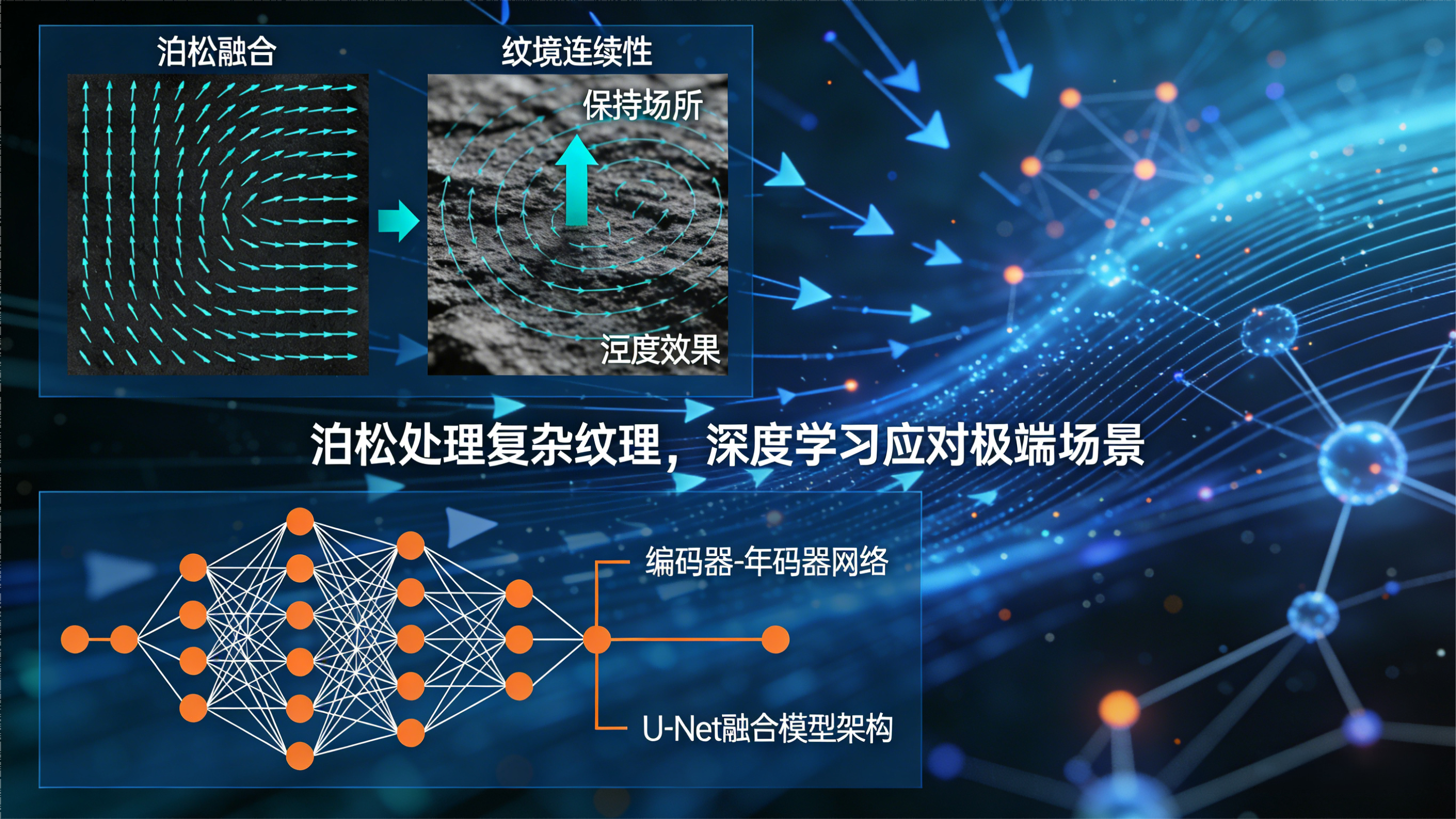

- [5. 方法5:泊松融合(保留纹理,适配复杂场景)](#5. 方法5:泊松融合(保留纹理,适配复杂场景))

- [6. 方法6:深度学习融合(应对极端场景)](#6. 方法6:深度学习融合(应对极端场景))

- 🎯三、实战代码:OpenCV+Halcon实现重叠区域消除(特征点匹配+线性融合)

-

- [1. OpenCV实现(特征点匹配+线性融合)](#1. OpenCV实现(特征点匹配+线性融合))

- [2. Halcon实现(特征点匹配+线性融合)](#2. Halcon实现(特征点匹配+线性融合))

- 代码关键说明

- 🎯四、工业落地:3个关键技巧,让拼接更稳定

-

- [1. 硬件校准优先,减少算法压力](#1. 硬件校准优先,减少算法压力)

- [2. 选择合适的重叠区域比例](#2. 选择合适的重叠区域比例)

- [3. 实时性与精度的平衡](#3. 实时性与精度的平衡)

- 🎯五、避坑指南:2个常见误区

- 🎯六、总结:多相机拼接消除重叠区域的"核心逻辑"

🎯多相机拼接:消除重叠区域的6个核心方法,附OpenCV+Halcon实战代码!

做工业视觉检测的都遇到过这个问题:多相机拼接大视野时,重叠区域总会出现"重影、色差、拼接缝明显"的情况,明明硬件同步做好了,结果拼接后的图像还是没法用------要么边缘错位,要么同一物体在重叠区出现双影,直接影响缺陷检测的精度。

其实,多相机拼接的核心难点不是"拼在一起",而是"让重叠区域无缝融合"。重叠区域本是为了保证拼接的精准性而设计的,只要用对方法,就能从"视觉瑕疵"变成"拼接精准的保障"。

今天就拆解消除多相机拼接重叠区域的6个核心方法,还附上OpenCV和Halcon的实战代码,帮你快速实现"无缝拼接",适配工业大尺寸零件检测、全景视觉等场景~

🎯 一、先搞懂:为什么重叠区域会出现"拼接瑕疵"?

多相机拼接的重叠区域(一般占单相机视野的10%-20%),出现重影、色差、拼接缝的根本原因就3个:

-

相机参数不一致:不同相机的曝光、增益、白平衡参数有差异,导致重叠区域同一位置的亮度、颜色不一样;

-

空间校准不精准:多相机的坐标系统未完全统一,重叠区域的像素点对应物理位置有偏差,出现"重影";

-

融合算法选择不当:直接拼接而不做融合处理,两个相机的图像在重叠区有明显的"边界线"。

简单说:重叠区域的问题,本质是"硬件校准"和"算法融合"的双重问题,只靠其中一项,根本没法做到无缝拼接。

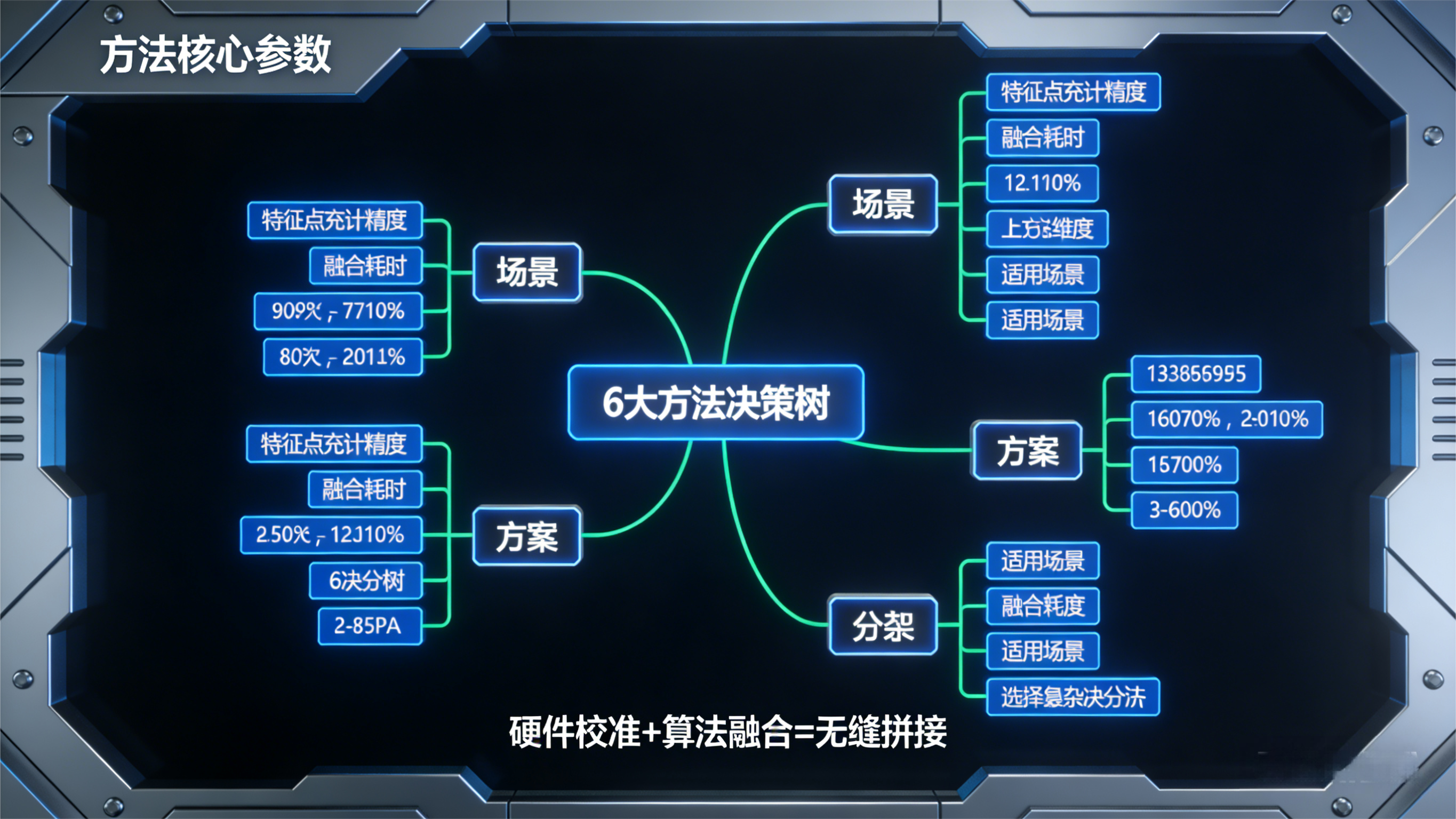

🎯二、6个核心方法:消除重叠区域,从易到难按需选

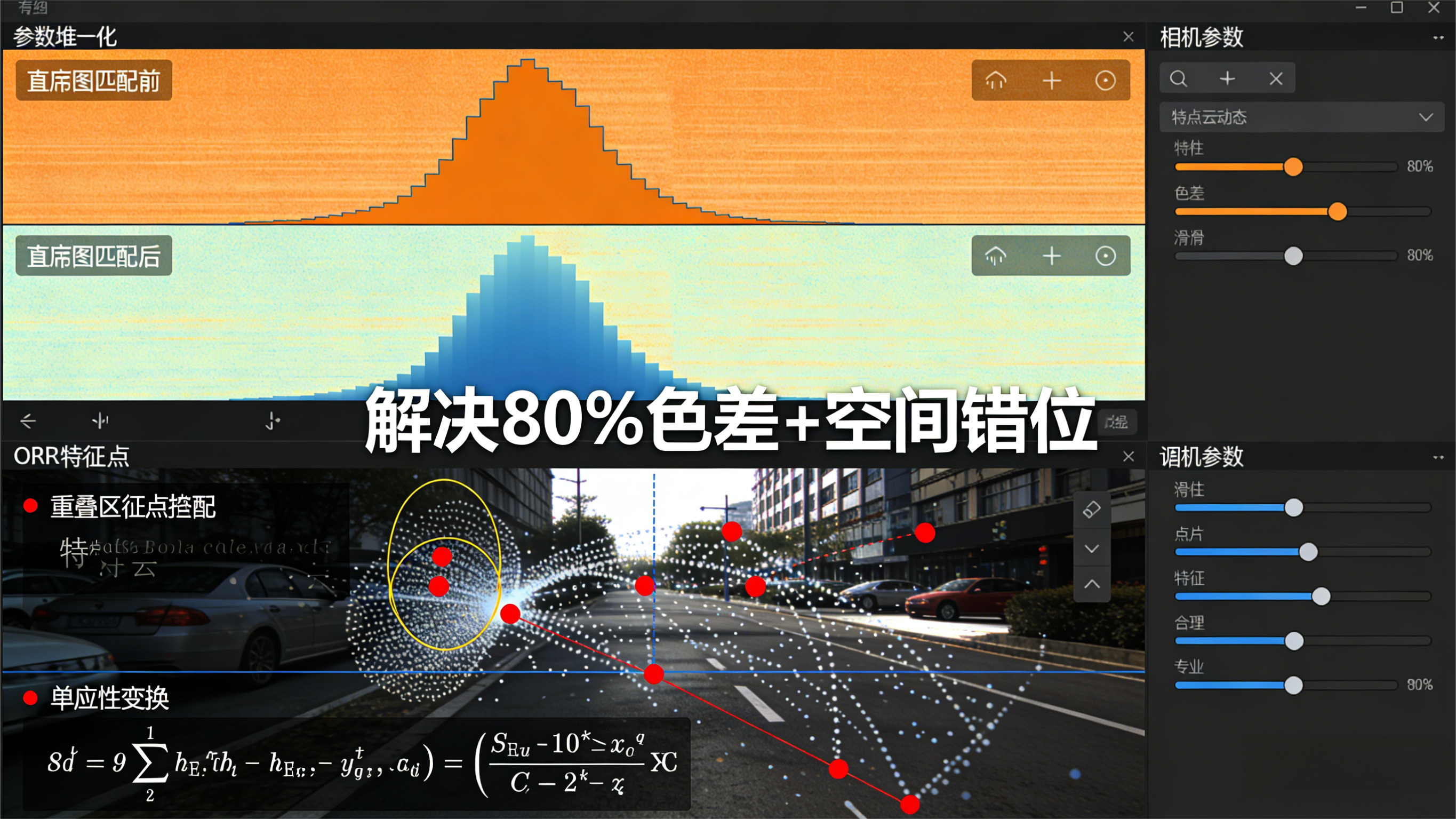

1. 方法1:参数归一化(基础操作,先解决"色差")

-

核心逻辑:统一所有相机的硬件参数,让重叠区域的亮度、对比度、白平衡保持一致,从源头减少色差;

-

具体操作:

-

硬件层面:将所有相机的曝光时间、增益、白平衡设为相同值(如曝光10ms,增益1.0);

-

软件层面:通过直方图匹配,将副相机的图像灰度分布匹配到主相机,消除亮度差异;

-

-

适用场景:相机型号相同、光照环境稳定的场景(如光伏板检测);

-

优势:简单易操作,无需复杂算法,能解决80%的色差问题。

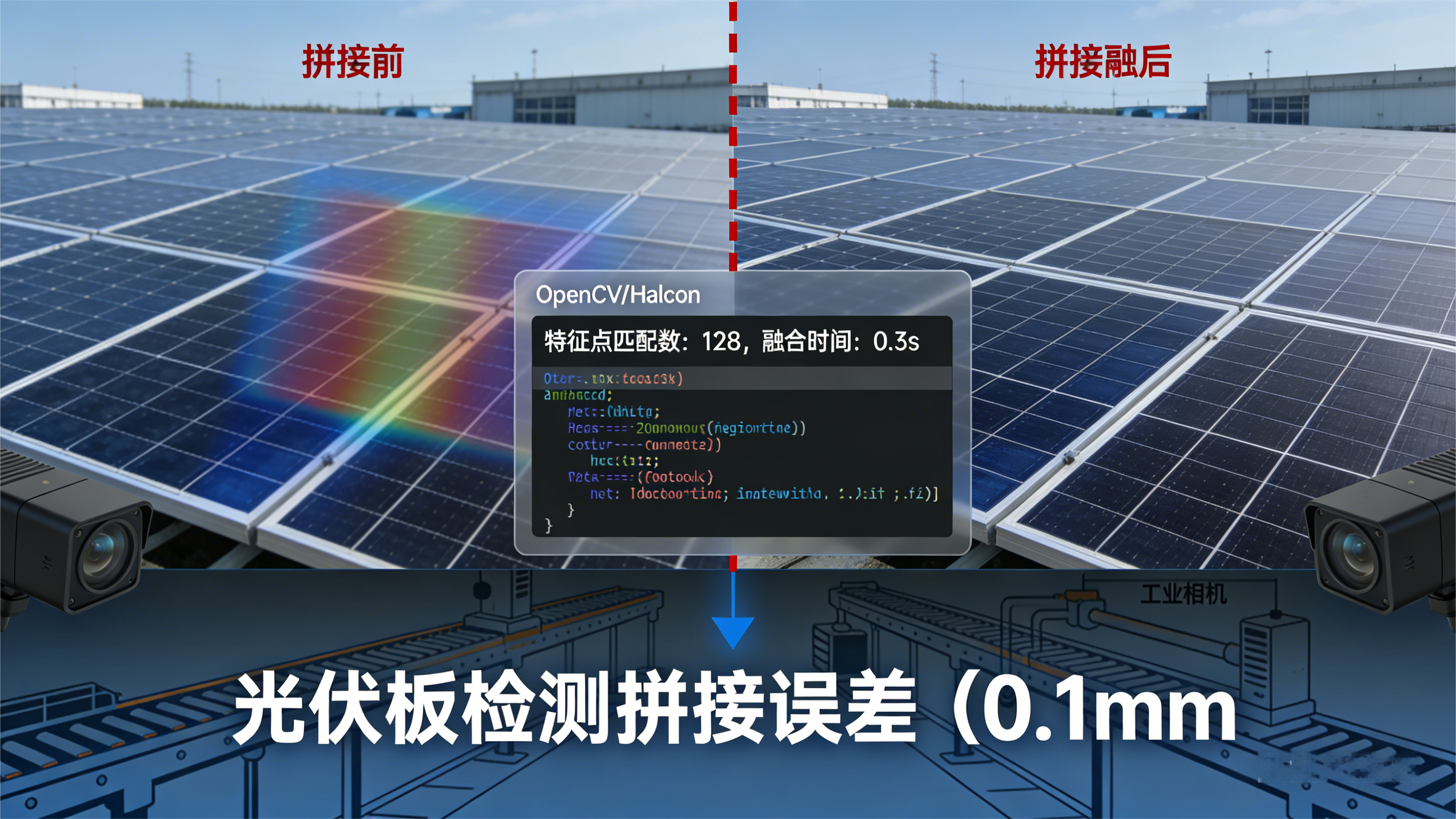

2. 方法2:特征点匹配+单应性变换(解决"空间错位")

-

核心逻辑:在重叠区域提取特征点(如SIFT、ORB特征),通过单应性变换(Homography)将副相机图像映射到主相机的坐标系统,让重叠区域的像素精准对齐;

-

关键价值:修正相机安装的微小偏移(如角度倾斜、位置偏差),从空间上消除重影;

-

适用场景:相机有轻微安装偏差的场景(如汽车车架检测的多相机布局);

-

注意:特征点提取需保证重叠区域有明显的特征(如零件的轮廓、标记点),无特征的纯色区域效果差。

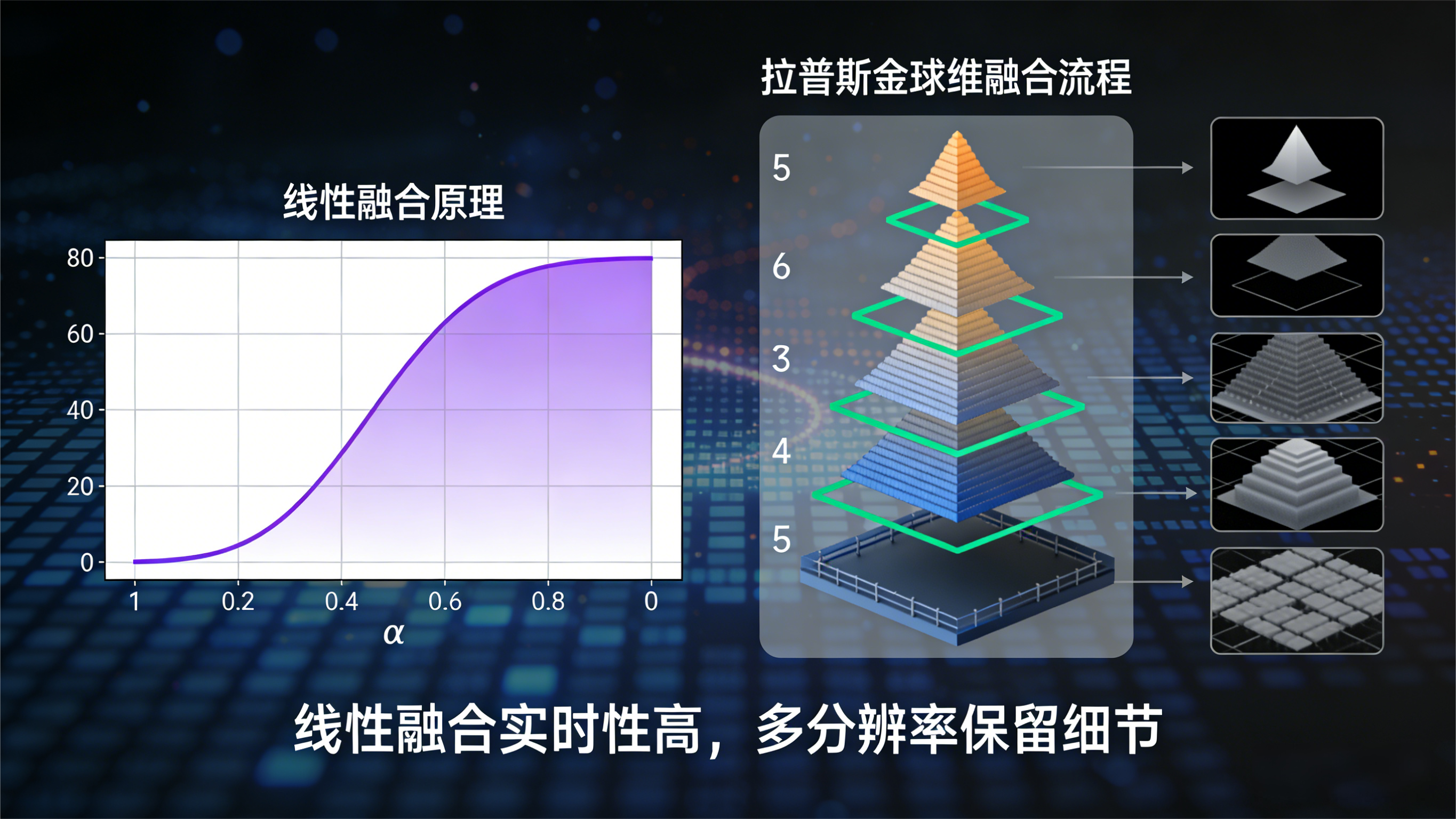

3. 方法3:线性融合(简单融合,快速消缝)

-

核心逻辑:对重叠区域的像素进行加权平均,靠近主相机的像素权重高,靠近副相机的像素权重低,平滑过渡重叠区域;

-

公式 : I ( x , y ) = α ⋅ I 1 ( x , y ) + ( 1 − α ) ⋅ I 2 ( x , y ) I(x,y) = \alpha \cdot I_1(x,y) + (1-\alpha) \cdot I_2(x,y) I(x,y)=α⋅I1(x,y)+(1−α)⋅I2(x,y) ( α \alpha α 从1线性递减到0);

-

适用场景:重叠区域较小(10%以内)、已经精准对齐的图像拼接;

-

优势:计算量小,实时性强(单帧处理<5ms),适合高速产线。

4. 方法4:多分辨率融合(拉普拉斯金字塔,高级消缝)

-

核心逻辑:将两张图像分解为不同分辨率的金字塔图层,在每层图层的重叠区域做融合,最后重构图像;

-

优势:融合后的图像过渡更自然,不会出现线性融合的"模糊感",能保留图像细节;

-

适用场景 :对图像细节要求高的场景(如半导体晶圆检测、精密零件拼接)。

5. 方法5:泊松融合(保留纹理,适配复杂场景)

-

核心逻辑:基于图像的梯度信息,将副相机图像的纹理无缝融合到主相机图像中,保证重叠区域的纹理连续性;

-

关键价值:即使重叠区域有复杂的纹理(如零件的花纹、划痕),也能自然融合,不会出现拼接缝;

-

适用场景:复杂纹理的零件拼接(如木纹板材检测、皮革缺陷检测)。

6. 方法6:深度学习融合(应对极端场景)

-

核心逻辑:用预训练的深度学习模型(如U-Net、GAN)直接学习重叠区域的融合规则,自动输出无缝拼接的图像;

-

优势:能处理传统算法难以应对的场景(如光照剧烈变化、相机型号不同);

-

落地注意:需要大量标注的拼接样本,适合高要求、大批量的工业场景(如新能源电池模组检测)。

🎯三、实战代码:OpenCV+Halcon实现重叠区域消除(特征点匹配+线性融合)

1. OpenCV实现(特征点匹配+线性融合)

python

import cv2

import numpy as np

def stitch_images_opencv(img1, img2):

"""

多相机图像拼接:特征点匹配对齐+线性融合消除重叠区域

:param img1: 主相机图像(灰度图)

:param img2: 副相机图像(灰度图)

:return: 拼接后的图像

"""

# 1. 提取ORB特征点

orb = cv2.ORB_create(nfeatures=2000)

kp1, des1 = orb.detectAndCompute(img1, None)

kp2, des2 = orb.detectAndCompute(img2, None)

# 2. 特征点匹配(暴力匹配)

bf = cv2.BFMatcher(cv2.NORM_HAMMING, crossCheck=True)

matches = bf.match(des1, des2)

matches = sorted(matches, key=lambda x: x.distance)[:100] # 筛选优质匹配点

# 3. 单应性变换(Homography)

pts1 = np.float32([kp1[m.queryIdx].pt for m in matches]).reshape(-1, 1, 2)

pts2 = np.float32([kp2[m.trainIdx].pt for m in matches]).reshape(-1, 1, 2)

H, mask = cv2.findHomography(pts2, pts1, cv2.RANSAC, 5.0)

# 4. 映射副相机图像到主相机坐标

h1, w1 = img1.shape

h2, w2 = img2.shape

img2_warp = cv2.warpPerspective(img2, H, (w1 + w2, h1))

# 5. 线性融合重叠区域

# 确定重叠区域的列范围

overlap_left = max(0, w1 - w2)

overlap_right = w1

alpha = np.linspace(1, 0, overlap_right - overlap_left) # 权重从1到0线性递减

for col in range(overlap_left, overlap_right):

img2_warp[:, col] = alpha[col - overlap_left] * img1[:, col] + (1 - alpha[col - overlap_left]) * img2_warp[:, col]

# 6. 拼接主相机图像

img2_warp[:h1, :w1] = img1

# 裁剪无效区域

img_stitch = cv2.cvtColor(img2_warp, cv2.COLOR_GRAY2BGR)

gray = cv2.cvtColor(img_stitch, cv2.COLOR_BGR2GRAY)

_, thresh = cv2.threshold(gray, 1, 255, cv2.THRESH_BINARY)

contours, _ = cv2.findContours(thresh, cv2.RETR_EXTERNAL, cv2.CHAIN_APPROX_SIMPLE)

x, y, w, h = cv2.boundingRect(contours[0])

img_stitch = img_stitch[y:y+h, x:x+w]

return img_stitch

# 测试代码

if __name__ == "__main__":

# 读取两张重叠的图像(主相机+副相机)

img1 = cv2.imread("camera1.jpg", 0)

img2 = cv2.imread("camera2.jpg", 0)

# 拼接图像

img_stitch = stitch_images_opencv(img1, img2)

# 保存并显示结果

cv2.imwrite("stitch_result.jpg", img_stitch)

cv2.imshow("Stitch Result", img_stitch)

cv2.waitKey(0)

cv2.destroyAllWindows()2. Halcon实现(特征点匹配+线性融合)

csharp

* 多相机图像拼接:特征点匹配对齐+线性融合消除重叠区域

dev_close_window()

dev_open_window(0, 0, 640, 480, 'black', WindowHandle)

* 1. 读取图像

read_image(Img1, 'camera1.jpg')

read_image(Img2, 'camera2.jpg')

get_image_size(Img1, Width1, Height1)

get_image_size(Img2, Width2, Height2)

* 2. 提取SIFT特征点

gen_empty_obj(Keypoints1)

gen_empty_obj(Keypoints2)

find_sift_points(Img1, Keypoints1, 'octaves', 3, 'contrast_threshold', 0.04, 'edge_threshold', 10)

find_sift_points(Img2, Keypoints2, 'octaves', 3, 'contrast_threshold', 0.04, 'edge_threshold', 10)

* 计算特征描述子

compute_sift_descriptors(Img1, Keypoints1, Descriptors1, 'normalization', 'l2')

compute_sift_descriptors(Img2, Keypoints2, Descriptors2, 'normalization', 'l2')

* 3. 特征点匹配

match_descriptors(Descriptors1, Descriptors2, MatchingPairs, 'nn', 0.7, 'row_dist', 5)

* 筛选匹配点对

select_matching_points(Keypoints1, Keypoints2, MatchingPairs, Points1, Points2)

* 单应性变换

homography_to_3d(Points1, Points2, HomMat2D, 'ransac', 1.0, 0.99, 1000)

* 4. 映射副相机图像

affine_trans_image(Img2, Img2Warp, HomMat2D, 'constant', 'false')

get_image_size(Img2Warp, WidthWarp, HeightWarp)

* 5. 创建拼接画布

gen_image_const(Canvas, 'byte', Width1 + Width2, max(Height1, HeightWarp))

paint_image(Img1, Canvas, Canvas, 0, 0, 'constant')

* 6. 线性融合重叠区域

overlap_left = max(0, Width1 - Width2)

overlap_right = Width1

alpha_step = 1.0 / (overlap_right - overlap_left)

alpha = 1.0

for Col := overlap_left to overlap_right - 1 by 1

* 读取主相机和映射后副相机的像素值

get_grayval(Img1, 0, Col, Gray1)

get_grayval(Img2Warp, 0, Col, Gray2)

* 加权融合

GrayFuse = alpha * Gray1 + (1 - alpha) * Gray2

* 写入画布

set_grayval(Canvas, 0, Col, GrayFuse)

alpha = alpha - alpha_step

endfor

* 7. 绘制映射后的副相机图像

paint_image(Img2Warp, Canvas, Canvas, 0, 0, 'constant')

* 8. 显示结果

dev_display(Canvas)代码关键说明

-

OpenCV版:用ORB特征点实现快速匹配,适合实时性要求高的场景,线性融合保证重叠区域平滑过渡;

-

Halcon版:用SIFT特征点提升匹配精度,更适配工业高精度拼接场景,代码更贴近工业视觉的实际应用。

🎯四、工业落地:3个关键技巧,让拼接更稳定

1. 硬件校准优先,减少算法压力

-

用标准标定板对多相机进行手眼标定,提前修正相机的内参(如畸变)和外参(如位置偏差);

-

安装相机时用精密支架,减少振动导致的位置偏移,避免频繁重新匹配特征点。

2. 选择合适的重叠区域比例

- 工业场景推荐重叠区域占单相机视野的15%-20%:比例太小,特征点不足,匹配精度低;比例太大,融合计算量增加,实时性下降。

3. 实时性与精度的平衡

-

高速产线(如>1m/s):用ORB特征+线性融合,保证单帧处理<10ms;

-

高精度检测(如半导体晶圆):用SIFT特征+拉普拉斯金字塔融合,牺牲一点速度换精度。

🎯五、避坑指南:2个常见误区

-

误区1:"只靠算法就能解决所有重叠问题"------如果相机参数差异大、安装偏差严重,再优秀的算法也难救,硬件校准才是基础;

-

误区2:"重叠区域越小越好"------过小的重叠区域会导致特征点不足,匹配失败,反而出现拼接错位。

🎯六、总结:多相机拼接消除重叠区域的"核心逻辑"

重叠区域不是"麻烦",而是"拼接精准的关键"。解决重叠问题的核心是:先通过硬件校准和参数归一化,让重叠区域"对齐且无色差",再通过融合算法让过渡"自然无缝"。

6种方法从易到难,按需选择即可:基础场景用参数归一化+线性融合,高精度场景用特征点匹配+拉普拉斯金字塔融合,极端场景再考虑深度学习。