从传统后端到AI智能驱动:Java + AI 生态深度实战技术总结

- [1 引言](#1 引言)

- [2 构建企业级 RAG 知识库的核心工程化实践](#2 构建企业级 RAG 知识库的核心工程化实践)

-

- [2.1 存储与解析](#2.1 存储与解析)

- [2.2 语义分块策略](#2.2 语义分块策略)

- [3 从 passive RAG 到 active AI Agent](#3 从 passive RAG 到 active AI Agent)

-

- [3.1 Java 21 虚拟线程](#3.1 Java 21 虚拟线程)

- [3.2 ReAct 范式](#3.2 ReAct 范式)

- [3.3 踩坑与修复:复读机](#3.3 踩坑与修复:复读机)

- [4 AI 辅助编程重塑开发工作流](#4 AI 辅助编程重塑开发工作流)

-

- [4.1 Cursor](#4.1 Cursor)

- [4.2 复杂的MCP流](#4.2 复杂的MCP流)

- [4.3 范式转移](#4.3 范式转移)

- [5 不忘初心,砥砺前行](#5 不忘初心,砥砺前行)

1 引言

站在 2025 年的岁末回望,这一年无疑是大模型(LLM)从"技术狂欢"走向"落地实战"的关键一年。

作为一名深耕 Java 领域的开发者,我深刻感受到了技术范式的转变:AI 不再只是一个简单的 API 调用,而是正在深刻重构我们的业务逻辑、架构设计乃至编程思维。

这一年,我入选了 CSDN Top 300 博客之星,这不仅是对我过去一年坚持原创的认可,更是对我专注"Java + AI"探索方向的肯定。

我先后完成了《Java 手搓 RAGFlow》、《Java 手搓 OpenManus》以及《AI 应用探索》等多个深度系列,累计输出 30 余篇高质量技术干货。本文将对我全年的技术实践进行一次深度的系统总结。

2 构建企业级 RAG 知识库的核心工程化实践

在我的《Java 手搓 RAGFlow》系列中,我用了 12 篇长文系统地拆解了检索增强生成(RAG)的每一个工程细节。

系列文章地址:Java手搓RAGFlow

我始终坚持一个观点:RAG 的核心痛点不在于模型本身,而在于极致的工程化数据处理(Data Ingestion)。

2.1 存储与解析

在实践中,我选择了 MinIO 作为对象存储中心,并结合 MD5 校验 实现了文件秒传与去重,极大地节省了带宽与存储空间。

针对多样化的文档格式(PDF、Word、Excel等),我集成 Apache Tika 实现了流式解析,确保即便是在处理几百兆的大文件时,系统内存占用依然保持在极低水位,从根源上规避了 OOM 风险。

java

// 使用 Tika 包装流,实现边读边解析,避免大文件撑爆内存

try (InputStream stream = minioClient.getObject(args)) {

AutoDetectParser parser = new AutoDetectParser();

// 使用自定义的 ContentHandler 动态捕捉文本块

BodyContentHandler handler = new BodyContentHandler(-1);

Metadata metadata = new Metadata();

parser.parse(stream, handler, metadata, new ParseContext());

String fullText = handler.toString();

// ... 后续进入分块流程

}踩坑点: 早期没做 MD5 校验,导致用户重复上传同一份文档,向量数据库里全是冗余数据。后来加入了 MinIO + Redis MD5 判重,实现了秒传和去重。

2.2 语义分块策略

简单的字符数切分会切断"由于...所以..."的逻辑。

在系列文章中,我重点探讨了语义分块策略:利用 HanLP 对长难句进行智能切词,并结合"父子文档"策略:

- 子切片(512 tokens): 负责高精度向量检索。

- 父上下文(1MB): 负责给 LLM 提供完整的逻辑背景。

这种"小块检索,大块喂给 LLM"的策略,直接解决了 AI 说话"断章取义"的问题。

- Kafka架构引入

这是我今年技术实践中最重要的闭环。

在最初的版本中,文件从上传到向量化的链路是同步的,这导致用户在上传大文件时必须面临漫长的 HTTP 等待,且任何一个环节(如 API 调用超时)都会导致整条链路崩溃。

为了解决这一稳定性痛点,我引入了 Kafka 分布式消息队列:

- 解耦与削峰: 用户上传文件后,系统立即返回成功响应,同时向 Kafka 投递一个 FileProcessingTask。

- 容错与重试: 通过配置 Kafka 的手动确认机制与死信队列,确保了即便在向量化 API 波动的情况下,任务也能自动重试,不会丢失任何一份宝贵的知识。

我通过 Kafka 将任务解耦,定义了核心任务 DTO:

java

public record FileProcessingTask(

String fileMd5,

String userId,

boolean isPublic,

ProcessingStage stage // 标记当前是解析中、分块中还是向量化中

)通过这一阶段的实践,我深刻体会到:优秀的 AI 应用,绝非简单的 Prompt 堆砌,而是对底层数据库、消息队列、存储系统等传统后端技术栈的极致整合。

3 从 passive RAG 到 active AI Agent

如果说 RAG 是给模型装上了"外接大脑",那么 Agent(智能体)则是让模型拥有了"手脚"。

系列文章地址:Java 手搓 OpenManus

在《Java 手搓 OpenManus》系列中,我的核心目标是:抛弃 Python 依赖,构建一个纯 Java 生态的高性能通用智能体。

3.1 Java 21 虚拟线程

Agent 的运行逻辑涉及大量的 IO 等待(LLM 生成、浏览器渲染、API 调用)。Python 版本依赖 async/await 协程,而在 Java 实现中,我果断选择了 JDK 21 的虚拟线。

java

// 虚拟线程执行器:让每一个 Agent 任务拥有自己的"轻量级线程"

try (var executor = Executors.newVirtualThreadPerTaskExecutor()) {

while (currentStep < maxSteps && state != AgentState.FINISHED) {

// join() 挂起虚拟线程,释放物理线程,实现高吞吐非阻塞 IO

String stepResult = step().join();

results.add(stepResult);

}

}虚拟线程让我能用最直观的 while 同步代码逻辑,写出并发性能媲美协程的 Agent。在压力测试中,单机同时运行 30,000 个 并发任务,响应时间依然保持在 1.7 秒 以内。

3.2 ReAct 范式

我将智能体的逻辑拆解为标准的 ReAct 架构。通过 LangChain4j 封装 LLM 服务,实现了复杂的 Function Calling 适配。

- Think: LLM 分析当前记忆,决定是输出文字还是调用工具(如 browser_use)。

- Act: 集成 Playwright,让 Agent 能够像真人一样访问网页、点击元素、提取内容。

- Observe: 将工具返回的结果(如"页面标题:Example Domain")重新喂回给 LLM。

3.3 踩坑与修复:复读机

在实战中我遇到了最头疼的问题:Agent 陷入死循环。 LLM 有时会反复执行同一个搜索动作,消耗大量 Token 却拿不到结果。

我的解决方案:

在 ToolCallAgent 中,我加入了一套任务完成检测与重复调用拦截机制。

java

// 核心逻辑:检测最近 3 次调用是否完全一致

if (detectRepeatedToolCalls(currentToolCalls)) {

log.warn("检测到重复工具调用,强制终止并提取现有答案");

this.state = AgentState.FINISHED; // 及时止损,强制状态机流转

}通过这套机制,Agent 的任务成功率从最初的 60% 提升到了 90% 以上,能够稳健地完成"访问百度搜索 Java 虚拟线程并总结前三个标题"这种多步骤复杂任务。

4 AI 辅助编程重塑开发工作流

如果说手搓 RAG 和 Agent 是在"造核弹",那么日常使用 Cursor 和 MCP 协议就是在"开歼击机"。

这一年,我最真实的体感是:代码不再是写出来的,而是"盘"出来的。

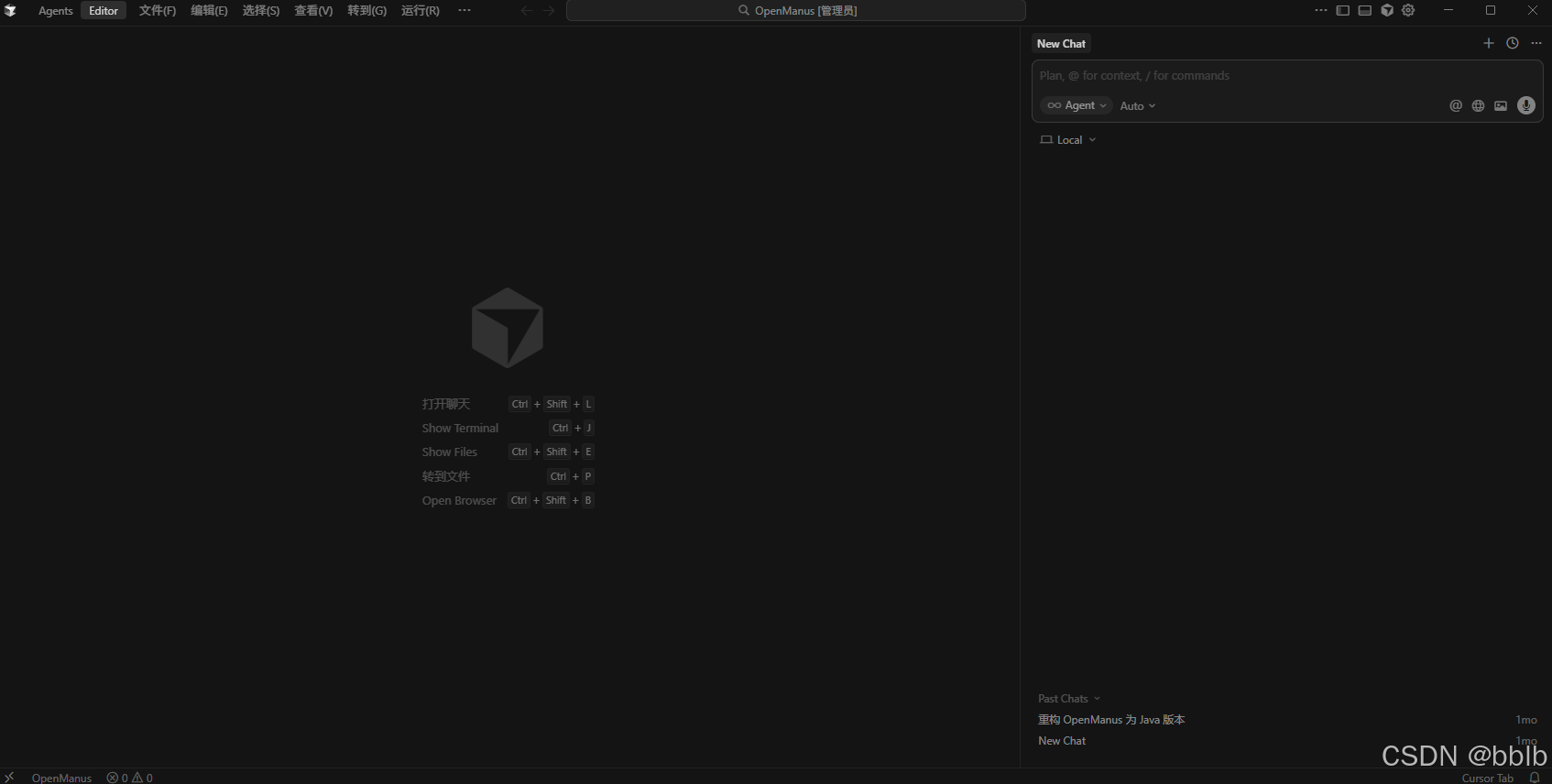

4.1 Cursor

现在日常开发已经离不开Cursor了,他使我的效率提升了很多

我深入实战了 Cursor 的三种核心模式,并总结出一套高效协作流:

- Agent 模式: 在开发"神笔马良"文生图安卓 APP 时,我直接通过自然语言描述需求。Cursor 不仅生成了代码,还自动执行了组件安装和 Gradle 配置。我只需要关注核心逻辑的"Accept"或"Save",开发效率提升了 10 倍以上。

- Plan 模式: 在重构复杂的 ToolCallAgent 逻辑时,我更倾向于使用 Plan 模式。它会先给出修改计划,让我一步步确认。这种"先思考、再动刀"的过程,极大减少了 AI 产生幻觉导致的代码污染。

- @Codebase 上下文感知: 这是最让我惊喜的功能。通过 @Codebase,AI 能够秒级理解我整个项目的包结构和依赖关系,再也不会出现"找不到类"或"引用错误"这种低级 Bug。

4.2 复杂的MCP流

在《AI 应用探索》专栏中,我重点研究了 MCP(Model Context Protocol)。它彻底解决了 AI 模型与外部工具(数据库、本地文件、搜索 API)之间的"孤岛问题"。

我开发了一个基于 高德地图 MCP Server 的助手。只需在配置文件中加入几行 JSON,Cursor 就能直接调用地图 API 帮我查询西北大学周边的交通状况。这种"即插即用"的扩展能力,让我意识到:未来的编程将不再是编写逻辑,而是组装工具。

4.3 范式转移

这一年的编程经历,让我完成了一次职场角色的跃迁。以前我是一个深陷 CRUD 的"搬砖工",现在我更像是一个架构监工。

- Prompt 即需求: 我开始花更多时间编写《Chrome 插件需求文档》或《架构设计说明》,而不是去纠结一个循环怎么写。

- 专注架构与安全: 当 AI 包揽了 80% 的代码编写后,我可以腾出精力去思考系统的扩展性、并发安全(如虚拟线程的调度)以及业务的闭环。

5 不忘初心,砥砺前行

2025 年的创作历程,是我技术视野不断拓宽的过程。从最初的 RAG 流程跑通,到后来能够手搓复杂的 Agent 框架,再到整合 MCP 等前沿协议,每一次总结都是一次认知的重塑。

入选 CSDN Top 300 是一个里程碑,但技术探索永无止境。在即将到来的 2026 年,我将继续深耕 "Java + AI 智能体集群" 领域,致力于将更多复杂的 AI 论文转化为可运行的 Java 代码。

技术的魅力在于分享,而分享的价值在于回响。

未来,愿与诸位开发者共同见证 Java 生态在 AI 时代的第二次春天!