-

系统要求检查

检查系统版本

lsb_release -a

检查GPU(如果有)

nvidia-smi

或

lspci | grep -i nvidia

-

安装依赖

更新系统

sudo apt update && sudo apt upgrade -y

安装基本工具

sudo apt install -y python3-pip python3-venv git wget curl

安装CUDA工具(如使用NVIDIA GPU)

CUDA 12.1示例,根据实际情况选择版本

wget https://developer.download.nvidia.com/compute/cuda/repos/ubuntu2204/x86_64/cuda-keyring_1.1-1_all.deb

sudo dpkg -i cuda-keyring_1.1-1_all.deb

sudo apt update

sudo apt install -y cuda-toolkit-12-1 -

创建Python虚拟环境

创建目录

mkdir -p ~/deepseek && cd ~/deepseek

创建虚拟环境

python3 -m venv venv

source venv/bin/activate -

安装PyTorch

根据CUDA版本选择合适的PyTorch

CUDA

pip install torch torchvision torchaudio

或CPU版本

pip install torch torchvision torchaudio

-

安装模型运行环境

安装Transformers和相关库

pip install transformers accelerate bitsandbytes

pip install sentencepiece protobuf对于GGUF量化格式

pip install llama-cpp-python

或

pip install ctransformers[cuda] # 如使用GPU

-

下载DeepSeek 32B量化模型

安装Ollama

curl -fsSL https://ollama.com/install.sh | sh

下载DeepSeek 32B量化版

ollama pull deepseek-r1:32b

或指定量化版本

ollama pull deepseek-r1:32b-q4_K_M

由于在线安装资源太慢这里选择下载好后直接上传解压

官网地址:Download Ollama on Linux

GitHub手动安装文档地址:ollama/docs/linux.md at main .ollama/ollama .GitHub

安装包下载地址:https://ollama.com/download/ollama-linux-amd64.tgz

上传后解压:

sudo tar -C /usr -xzf ollama-linux-amd64.tgz设置权限:

sudo chmod +x /usr/bin/ollama创建系统用户:为Ollama服务创建一个专用的、无登录权限的系统用户,这有助于提高安全性

sudo useradd -r -s /bin/false -m -d /usr/share/ollama ollama创建服务文件:创建一个systemd服务配置文件。使用文本编辑器创建并编辑文件:

sudo vim /etc/systemd/system/ollama.service将以下配置内容粘贴到文件中。这个配置设置了服务的基本信息、启动方式以及运行用户

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/usr/bin/ollama serve

User=ollama

Group=ollama

Restart=always

RestartSec=3

# 如需允许局域网内其他机器访问,取消下面一行的注释

# Environment="OLLAMA_HOST=0.0.0.0"

# 明确指定模型存储目录,防止权限问题

Environment="HOME=/usr/share/ollama"

[Install]

WantedBy=multi-user.target设置目录权限:确保Ollama用户对其工作目录有读写权限

sudo chown -R ollama:ollama /usr/share/ollama启用并启动服务:

sudo systemctl daemon-reload

sudo systemctl enable ollama

sudo systemctl start ollama检查服务状态:使用以下命令查看Ollama服务是否正常运行。

sudo systemctl status ollama下载DeepSeek 32B量化版

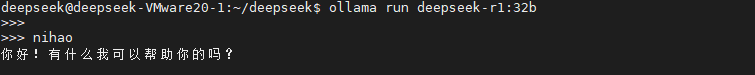

ollama pull deepseek-r1:32b使用Ollama运行:

ollama run deepseek-r1:32b