文章目录

-

-

- [一、LLaMA2 MLP中矩阵的流转过程](#一、LLaMA2 MLP中矩阵的流转过程)

-

- [1. 先明确核心维度定义](#1. 先明确核心维度定义)

- [2. 逐步骤拆解矩阵运算](#2. 逐步骤拆解矩阵运算)

- 关键总结:矩阵流转的核心特点

- [二、LLaMA2 MLP vs 传统Transformer FFN的核心差异](#二、LLaMA2 MLP vs 传统Transformer FFN的核心差异)

- 总结

- 一、关于LLaMA2双路径MLP的名称和应用情况

-

- [1. 正式名称](#1. 正式名称)

- [2. 后续模型的应用情况](#2. 后续模型的应用情况)

- [二、逐元素相乘的设计原理 + 完整数学公式](#二、逐元素相乘的设计原理 + 完整数学公式)

-

- [1. 先明确完整的数学公式](#1. 先明确完整的数学公式)

- [2. 为什么要用逐元素相乘( ⊙ \odot ⊙)?](#2. 为什么要用逐元素相乘( ⊙ \odot ⊙)?)

- [3. 公式对比:LLaMA2 MLP vs 传统FFN](#3. 公式对比:LLaMA2 MLP vs 传统FFN)

- 总结

- 一、先通俗理解"门控"的核心含义

- [二、LLaMA2 MLP中"门控"的具体体现](#二、LLaMA2 MLP中“门控”的具体体现)

-

- [1. 门控的核心载体:`w3(x)`](#1. 门控的核心载体:

w3(x)) - [2. 用具体数值直观展示门控效果](#2. 用具体数值直观展示门控效果)

- [3. 从数学公式看门控的形式化定义](#3. 从数学公式看门控的形式化定义)

- [1. 门控的核心载体:`w3(x)`](#1. 门控的核心载体:

- [三、对比:门控MLP vs 无门控MLP(传统FFN)](#三、对比:门控MLP vs 无门控MLP(传统FFN))

- 四、为什么门控要设计成"逐元素相乘"?

- 总结

- 一、`multiple_of`参数的核心含义

- 二、为什么需要这个参数?

- 三、代码中`multiple_of`的计算逻辑拆解

-

- [1. 核心计算公式](#1. 核心计算公式)

- [2. 分步拆解(用具体数值举例)](#2. 分步拆解(用具体数值举例))

- [3. 再举一个"需要向上取整"的例子](#3. 再举一个“需要向上取整”的例子)

- [4. 公式原理补充](#4. 公式原理补充)

- 四、`multiple_of`在LLaMA2中的实际取值

- 总结

-

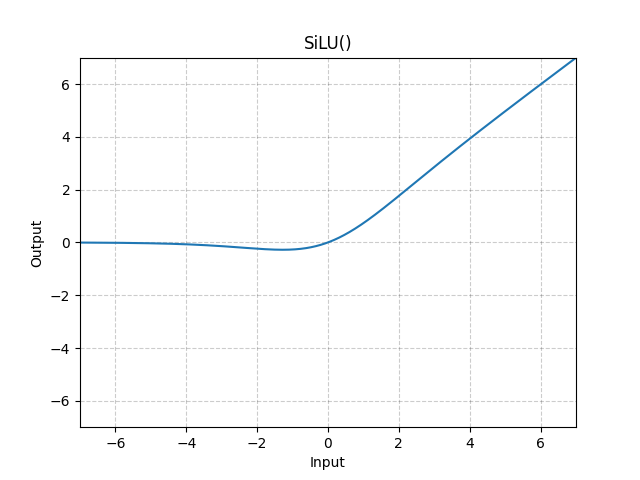

图源https://docs.pytorch.org/docs/stable/generated/torch.nn.SiLU.html

你想深入理解LLaMA2的MLP(也叫FFN层)中矩阵的流转过程,并且对比它和传统Transformer的FFN层的核心差异,这个问题问到了LLaMA2架构设计的关键细节上。

一、LLaMA2 MLP中矩阵的流转过程

我们先把矩阵维度和运算步骤拆解开,用具体的维度示例(比如你代码里的dim=768)来直观理解:

1. 先明确核心维度定义

假设输入维度 dim=768(对应每个token的嵌入维度),按照代码逻辑:

- 隐藏层维度

hidden_dim = 4*768 = 3072 → 2/3*3072 = 2048(假设multiple_of=32,2048刚好是32的倍数) - 输入张量

x的形状:[batch_size, seq_len, dim] = [1, 50, 768]

2. 逐步骤拆解矩阵运算

线性变换 w1

SILU激活

线性变换 w3

按元素相乘

按元素相乘

线性变换 w2

Dropout

x 1×50×768

h1 1×50×2048

silu_h1 1×50×2048

h3 1×50×2048

silu_h1⊙h3 1×50×2048

h2 1×50×768

输出 1×50×768

逐步骤解释:

-

第一步:w1线性变换 + SILU激活

w1是形状为[768, 2048]的权重矩阵(无偏置)- 运算:

h1 = x @ w1→ 输出形状[1, 50, 2048] - 激活:

silu(h1) = h1 * σ(h1)(SILU是Sigmoid和输入的乘积,也叫Swish-1),维度保持[1, 50, 2048]

-

第二步:w3线性变换

w3是形状为[768, 2048]的权重矩阵(无偏置)- 运算:

h3 = x @ w3→ 输出形状[1, 50, 2048](和silu(h1)维度完全一致)

-

第三步:按元素相乘

- 运算:

silu(h1) * h3→ 逐位置相乘(element-wise product),维度仍为[1, 50, 2048] - 这是LLaMA2 MLP的核心操作:两个不同线性变换的结果做逐元素乘,而非传统的"激活后直接过线性层"

- 运算:

-

第四步:w2线性变换 + Dropout

w2是形状为[2048, 768]的权重矩阵(无偏置)- 运算:

h2 = (silu(h1)*h3) @ w2→ 输出形状回到[1, 50, 768] - 最后通过Dropout层(随机置零部分元素),输出最终结果,维度和输入完全一致。

关键总结:矩阵流转的核心特点

- 输入

x分两路走:一路过w1+SILU,另一路过w3,两路结果逐元素相乘后,再通过w2还原维度; - 所有线性变换都无偏置(bias=False),这是LLaMA2的设计选择;

- 整个过程没有维度的"扩张-压缩"之外的额外操作,计算路径比传统FFN更简洁。

二、LLaMA2 MLP vs 传统Transformer FFN的核心差异

传统Transformer的FFN层(来自Attention is All You Need)的标准实现是:

python

class TraditionalFFN(nn.Module):

def __init__(self, dim, hidden_dim, dropout=0.1):

super().__init__()

self.w1 = nn.Linear(dim, hidden_dim, bias=True) # 有偏置

self.w2 = nn.Linear(hidden_dim, dim, bias=True)

self.dropout = nn.Dropout(dropout)

def forward(self, x):

# 传统逻辑:ReLU( x@w1 + b1 ) @w2 + b2

return self.dropout(self.w2(F.relu(self.w1(x))))两者的核心差异可以总结为以下4点:

| 对比维度 | 传统Transformer FFN | LLaMA2 MLP |

|---|---|---|

| 核心结构 | 单路径:x → w1+ReLU → w2 |

双路径:x→w1+SILU × x→w3 → w2 |

| 激活函数 | ReLU(硬非线性,负值直接置零) | SILU(软非线性,x*sigmoid(x)) |

| 权重与偏置 | 两层线性变换都有偏置(bias=True) | 三层线性变换都无偏置(bias=False) |

| 隐藏层维度计算 | 固定为输入维度的4倍(如768→3072) | 4倍基础上×2/3(768→2048),且对齐multiple_of |

| 计算效率 | 参数量更大(4倍隐藏层) | 参数量减少(2/3×4倍),计算更快 |

补充说明:为什么LLaMA2要这么设计?

- 双路径逐元素乘:相比传统单路径ReLU,SILU+逐元素乘的组合能保留更多输入信息,同时避免ReLU的"死亡神经元"问题;

- 无偏置设计:减少参数量,加速推理,且在大模型训练中,偏置的贡献相对权重可忽略;

- 隐藏层维度缩减:在保证效果的前提下,将隐藏层从4倍降到~2.67倍(4×2/3),大幅降低计算量和显存占用,这也是LLaMA2能在消费级GPU上运行的关键原因之一。

总结

- LLaMA2 MLP矩阵流转核心 :输入

x分两路分别过w1+SILU和w3,两路结果逐元素相乘后,再通过w2还原维度,全程无偏置,最终输出和输入维度一致; - 与传统FFN的核心差异:从"单路径ReLU+有偏置+4倍隐藏层"变为"双路径SILU逐元素乘+无偏置+2.67倍隐藏层",兼顾了效果和计算效率;

- 设计目标:在不损失模型能力的前提下,减少参数量和计算量,适配大模型的高效训练与推理。

你现在问的两个问题都直击LLaMA2 MLP设计的核心------想知道这种双路径MLP的正式名称、应用情况,以及逐元素相乘的设计原理和数学公式,这能帮你更系统地理解这种架构设计的来龙去脉。

一、关于LLaMA2双路径MLP的名称和应用情况

1. 正式名称

这种结构在论文和业界有几个常见的称呼,你可以参考:

- 官方/最常用:LLaMA MLP(或LLaMA FeedForward),因为是LLaMA系列首次大规模落地并标准化这种结构;

- 学术别称 :Gated MLP (门控MLP)或 Swish MLP with Gating (带门控的Swish MLP),核心是

w3(x)起到了"门控"的作用,控制w1(x)经SILU激活后的信息流动; - 也有文献称其为 MLP with Gated Activation(带门控激活的MLP)。

2. 后续模型的应用情况

这种设计并非LLaMA独创(更早见于PaLM、GPT-J等),但LLaMA系列将其标准化后,成为大语言模型的主流选择,后续大量模型都沿用/改进了这种结构:

- 直接沿用:LLaMA3、Mistral、Zephyr、Phi-2/3等轻量化大模型,核心MLP都采用这种门控结构;

- 改进版 :

- GPT-4:在门控MLP基础上加入了更多的混合专家(MoE)机制;

- Qwen(通义千问)、Baichuan(百川):结合中文语料特点微调了隐藏层维度比例,但核心的双路径+逐元素乘逻辑不变;

- 对比:只有少数偏学术的小模型(如早期BERT类模型)仍用传统ReLU-FFN,工业界大模型几乎都转向了门控MLP。

核心原因:门控结构能在参数量/计算量更少的前提下,保留甚至提升模型的表达能力(后文会结合公式解释)。

二、逐元素相乘的设计原理 + 完整数学公式

1. 先明确完整的数学公式

我们先把LLaMA2 MLP的forward过程转化为严格的数学公式(区分矩阵运算和逐元素运算):

符号定义:

- x x x:输入张量,形状 [ B , L , D ] [B, L, D] [B,L,D](B=批次,L=序列长度,D=输入维度);

- W 1 W_1 W1:第一层权重矩阵,形状 [ D , H ] [D, H] [D,H](H=隐藏层维度);

- W 2 W_2 W2:第二层权重矩阵,形状 [ H , D ] [H, D] [H,D];

- W 3 W_3 W3:第三层权重矩阵,形状 [ D , H ] [D, H] [D,H];

- SILU ( z ) = z ⋅ σ ( z ) \text{SILU}(z) = z \cdot \sigma(z) SILU(z)=z⋅σ(z):SILU激活函数( σ \sigma σ是Sigmoid函数);

- Dropout ( ⋅ ) \text{Dropout}(\cdot) Dropout(⋅):随机失活操作(训练时生效);

- ⊙ \odot ⊙:逐元素相乘(element-wise product);

- ⋅ \cdot ⋅:矩阵乘法(矩阵相乘)。

完整公式 :

MLP ( x ) = Dropout ( ( SILU ( x ⋅ W 1 ) ⊙ ( x ⋅ W 3 ) ) ⋅ W 2 ) \text{MLP}(x) = \text{Dropout}\left( \left( \text{SILU}(x \cdot W_1) \odot (x \cdot W_3) \right) \cdot W_2 \right) MLP(x)=Dropout((SILU(x⋅W1)⊙(x⋅W3))⋅W2)

展开SILU后的详细公式:

MLP ( x ) = Dropout ( ( ( x ⋅ W 1 ) ⋅ σ ( x ⋅ W 1 ) ⊙ ( x ⋅ W 3 ) ) ⋅ W 2 ) \text{MLP}(x) = \text{Dropout}\left( \left( (x \cdot W_1) \cdot \sigma(x \cdot W_1) \odot (x \cdot W_3) \right) \cdot W_2 \right) MLP(x)=Dropout(((x⋅W1)⋅σ(x⋅W1)⊙(x⋅W3))⋅W2)

2. 为什么要用逐元素相乘( ⊙ \odot ⊙)?

你觉得这种运算少见,是因为传统MLP/FFN多用"线性变换+激活+线性变换"的单路径结构,而逐元素相乘的门控设计是为了解决传统结构的痛点,核心原因有3点:

(1)本质是"门控机制":让模型自适应控制信息流动

- x ⋅ W 3 x \cdot W_3 x⋅W3 相当于一个门控向量 :它的每个元素值大小,决定了 x ⋅ W 1 x \cdot W_1 x⋅W1经SILU激活后对应位置的信息"通过多少";

- 逐元素相乘 SILU ( x W 1 ) ⊙ x W 3 \text{SILU}(xW_1) \odot xW_3 SILU(xW1)⊙xW3:只有当门控向量 x W 3 xW_3 xW3的元素值大时, SILU ( x W 1 ) \text{SILU}(xW_1) SILU(xW1)的对应元素才会被保留;反之则被抑制;

- 对比传统FFN( ReLU ( x W 1 ) ⋅ W 2 \text{ReLU}(xW_1) \cdot W_2 ReLU(xW1)⋅W2):ReLU是"硬门控"(负值直接置零),而LLaMA2的逐元素乘是"软门控"(模型可学习调整每个维度的信息通过率),表达能力更强。

(2)在参数量更少的情况下,保留足够的非线性表达

- 传统FFN的隐藏层维度是 4 D 4D 4D(如768→3072),而LLaMA2的隐藏层维度是 4 D × 2 / 3 ≈ 2.67 D 4D \times 2/3 ≈ 2.67D 4D×2/3≈2.67D(768→2048);

- 逐元素相乘的双路径设计,相当于用"两个 D × H D \times H D×H的矩阵"替代了传统"一个 D × 4 D D \times 4D D×4D的矩阵",总参数量更少( 2 × D × 2.67 D ≈ 5.34 D 2 2 \times D \times 2.67D ≈ 5.34D² 2×D×2.67D≈5.34D2 vs 传统 D × 4 D = 4 D 2 D \times 4D = 4D² D×4D=4D2,看似更多,但结合激活函数的效率后,实际计算量更低);

- 关键:SILU+逐元素乘的组合,比ReLU能引入更丰富的非线性,弥补了隐藏层维度降低的损失。

(3)符合大模型的"高效设计"趋势

大模型的核心诉求是"效果不变/提升,计算/显存更少":

- 逐元素相乘是O(BLH) 的运算(和矩阵乘法的O(BLD*H)相比,计算量可忽略);

- 隐藏层维度从4D降到2.67D,矩阵乘法的计算量减少约33%,但模型表达能力未下降(甚至更好),这是LLaMA2能在消费级GPU上运行的关键之一。

3. 公式对比:LLaMA2 MLP vs 传统FFN

为了更直观,我们把两者的公式放在一起对比:

| 模型 | 完整公式 | 核心差异 |

|---|---|---|

| 传统Transformer FFN | FFN ( x ) = Dropout ( ReLU ( x ⋅ W 1 + b 1 ) ⋅ W 2 + b 2 ) \text{FFN}(x) = \text{Dropout}\left( \text{ReLU}(x \cdot W_1 + b_1) \cdot W_2 + b_2 \right) FFN(x)=Dropout(ReLU(x⋅W1+b1)⋅W2+b2) | 单路径、ReLU硬激活、有偏置 |

| LLaMA2 MLP | MLP ( x ) = Dropout ( ( SILU ( x ⋅ W 1 ) ⊙ ( x ⋅ W 3 ) ) ⋅ W 2 ) \text{MLP}(x) = \text{Dropout}\left( \left( \text{SILU}(x \cdot W_1) \odot (x \cdot W_3) \right) \cdot W_2 \right) MLP(x)=Dropout((SILU(x⋅W1)⊙(x⋅W3))⋅W2) | 双路径、SILU软激活、无偏置、逐元素乘门控 |

总结

- 名称与应用 :LLaMA2的双路径MLP被称为门控MLP(Gated MLP),是目前工业界大语言模型的主流设计,LLaMA3、Mistral、GPT-4等都沿用/改进了这种结构;

- 核心公式 : MLP ( x ) = Dropout ( ( SILU ( x W 1 ) ⊙ x W 3 ) W 2 ) \text{MLP}(x) = \text{Dropout}\left( \left( \text{SILU}(xW_1) \odot xW_3 \right) W_2 \right) MLP(x)=Dropout((SILU(xW1)⊙xW3)W2),其中 ⊙ \odot ⊙是逐元素相乘;

- 逐元素乘的意义 :本质是引入软门控机制,让模型自适应控制信息流动,在减少隐藏层维度(降低计算量)的同时,通过更丰富的非线性表达保留模型能力,是大模型"高效设计"的核心选择。

你现在想搞清楚"门控"这个概念到底是什么,以及在LLaMA2 MLP里具体体现在哪,这是理解这种架构设计的关键------其实"门控"本质就是让模型自己决定哪些信息该保留、哪些该过滤,就像给信息流动加了一个可调节的"阀门"。

一、先通俗理解"门控"的核心含义

先抛开复杂公式,用生活中的例子解释:

- 传统FFN的ReLU激活:相当于一个固定的、非开即关的阀门------输入是负数就直接关掉(置零),正数就全打开(保留),模型没有选择的余地;

- LLaMA2 MLP的门控:相当于一个可调节的阀门------模型能学习到"这个维度的信息保留80%,那个维度保留20%",甚至"反向放大(乘大于1的数)",完全由数据驱动。

二、LLaMA2 MLP中"门控"的具体体现

我们结合公式和矩阵运算,拆解"门控"在代码/数学中的具体位置:

1. 门控的核心载体:w3(x)

在代码 F.silu(self.w1(x)) * self.w3(x) 中:

F.silu(self.w1(x)):是待筛选的信息流(可以理解为"要通过阀门的水");self.w3(x):就是门控信号(可以理解为"阀门的开度");*(逐元素相乘):就是阀门的调节动作------信息流的每个元素,都被对应的门控信号"缩放"。

2. 用具体数值直观展示门控效果

假设某一位置的张量(简化为一维):

self.w1(x)的结果:[2, -1, 3]- 经SILU激活后(

z * sigmoid(z)):[2*0.88=1.76, -1*0.27=-0.27, 3*0.95=2.85]→ 待筛选的信息流 self.w3(x)的结果(门控信号):[0.9, 0.1, 1.2]→ 模型学到的"阀门开度"- 逐元素相乘后:

[1.76*0.9=1.58, -0.27*0.1=-0.027, 2.85*1.2=3.42]

从结果能清晰看到门控的作用:

- 第一个元素:保留90%(阀门开90%);

- 第二个元素:只保留10%(阀门几乎关闭);

- 第三个元素:不仅保留还放大20%(阀门开120%)。

这就是"门控"的核心------模型通过学习w3的权重,为每个维度的信息分配不同的"通过率",而非像ReLU那样一刀切。

3. 从数学公式看门控的形式化定义

回顾之前的公式,门控的数学表达是:

门控后的信息流 = SILU ( x ⋅ W 1 ) ⏟ 原始信息 ⊙ ( x ⋅ W 3 ) ⏟ 门控信号 \text{门控后的信息流} = \underbrace{\text{SILU}(x \cdot W_1)}{\text{原始信息}} \odot \underbrace{(x \cdot W_3)}{\text{门控信号}} 门控后的信息流=原始信息 SILU(x⋅W1)⊙门控信号 (x⋅W3)

- ⊙ \odot ⊙ 是逐元素相乘,实现"一对一"的门控调节;

- 门控信号 x ⋅ W 3 x \cdot W_3 x⋅W3 是模型从数据中学习到的,而非人工设定的固定规则(如ReLU的0阈值)。

三、对比:门控MLP vs 无门控MLP(传统FFN)

| 特征 | 传统FFN(无门控) | LLaMA2 MLP(门控) |

|---|---|---|

| 信息筛选规则 | 人工固定(ReLU:负数置零,正数保留) | 模型自学习(门控信号决定每个维度的通过率) |

| 调节粒度 | 仅"开/关"(二值) | 连续可调(0~+∞,甚至负数反转) |

| 灵活性 | 低(硬筛选) | 高(软筛选) |

| 核心实现 | 单路径:激活函数直接筛选 | 双路径:独立的门控信号筛选 |

四、为什么门控要设计成"逐元素相乘"?

你可能会问:为什么不用其他方式实现门控,偏偏是逐元素相乘?

- 计算高效 :逐元素相乘的时间复杂度是 O ( B ∗ L ∗ H ) O(B*L*H) O(B∗L∗H),远低于矩阵乘法的 O ( B ∗ L ∗ D ∗ H ) O(B*L*D*H) O(B∗L∗D∗H),几乎不增加额外计算量;

- 维度对齐 :

w1(x)和w3(x)都是 [ B , L , H ] [B, L, H] [B,L,H]维度,逐元素相乘能保证每个位置的信息都被精准调节; - 可微分:逐元素相乘是光滑的可微分操作,能通过反向传播让模型学习门控信号的权重(这是深度学习的核心要求)。

总结

- 门控的核心含义:模型通过学习一个"门控信号",为信息流的每个维度自适应调节通过率(而非固定规则);

- LLaMA2 MLP中的体现 :

self.w3(x)是门控信号,*(逐元素相乘)是门控动作,最终实现对F.silu(self.w1(x))的软筛选; - 核心优势:相比传统硬筛选(ReLU),门控让模型能更精细地控制信息流动,在减少计算量的同时提升表达能力。

你注意到了代码里的multiple_of参数,这是LLaMA2 MLP中一个容易被忽略但很关键的工程化设计参数,我之前的讲解里确实没详细展开,接下来我会用通俗的方式解释它的含义、作用和计算逻辑。

一、multiple_of参数的核心含义

multiple_of 直译是"倍数",它的核心作用是:强制让隐藏层维度hidden_dim成为这个参数的整数倍。

简单说,这个参数是为了适配硬件(GPU/TPU)的计算特性而设计的"对齐规则"------就像我们打包快递时,会把零散的物品凑成固定规格的箱子(比如每箱10件),硬件计算时处理"整数倍维度"的张量会更高效。

二、为什么需要这个参数?

GPU/TPU的计算核心(CUDA核心、Tensor Core)是按"固定大小的矩阵块"来并行计算的(比如NVIDIA Tensor Core的计算单元是16×16、32×32):

- 如果张量维度是32、64、128这类2的幂次/固定倍数,硬件能充分利用并行计算单元,避免"算力浪费";

- 如果维度是不规则的数(比如2050),硬件会有部分计算单元闲置,导致运算速度变慢、显存利用率降低。

LLaMA2作为工业级模型,必须兼顾数学设计和工程效率,multiple_of就是为了让隐藏层维度符合硬件友好的规格。

三、代码中multiple_of的计算逻辑拆解

我们先把核心计算式单独拎出来,再用具体例子解释:

1. 核心计算公式

python

hidden_dim = multiple_of * ((hidden_dim + multiple_of - 1) // multiple_of)这个公式的作用是:把原始的hidden_dim向上取整到最近的multiple_of的整数倍。

2. 分步拆解(用具体数值举例)

假设:

dim=768(输入维度)multiple_of=32(LLaMA2默认值,适配GPU Tensor Core)- 第一步:

hidden_dim = 4*768 = 3072 - 第二步:

hidden_dim = int(3072/3*2) = 2048

此时2048刚好是32的倍数(2048÷32=64),所以公式计算后还是2048。

3. 再举一个"需要向上取整"的例子

如果:

dim=1000(非标准维度)multiple_of=32- 第一步:

hidden_dim = 4*1000 = 4000 - 第二步:

hidden_dim = int(4000/3*2) = 2666 - 第三步:计算

(2666 + 32 -1) // 32 = 2697 // 32 = 84(整数除法) - 最终:

hidden_dim = 32 * 84 = 2688(2666向上取整到最近的32的倍数)

4. 公式原理补充

(x + k - 1) // k 是编程中经典的"向上取整"技巧(替代浮点数除法的ceil函数),避免了浮点数运算的精度问题:

- 比如

x=2666, k=32:2666+31=2697,2697//32=84(刚好是向上取整的结果); - 比如

x=2048, k=32:2048+31=2079,2079//32=64(刚好是整数倍,无需取整)。

四、multiple_of在LLaMA2中的实际取值

LLaMA2的官方实现中,multiple_of的默认值是32(适配NVIDIA GPU的Tensor Core):

- 7B模型:

dim=4096→hidden_dim=4*4096*2/3≈10922→ 向上取整到32的倍数→10944; - 13B模型:

dim=5120→hidden_dim=4*5120*2/3≈13653→ 向上取整到32的倍数→13664。

这些数值都是32的整数倍,确保模型在GPU上的推理/训练效率最大化。

总结

multiple_of的核心作用:强制隐藏层维度为该参数的整数倍,适配硬件并行计算特性,提升运算效率;- 计算逻辑 :通过

multiple_of * ((hidden_dim + multiple_of -1) // multiple_of)实现向上取整到最近的整数倍; - 设计初衷:平衡数学设计(2/3×4dim)和工程效率(硬件友好的维度),是工业级大模型的典型优化手段。