引言

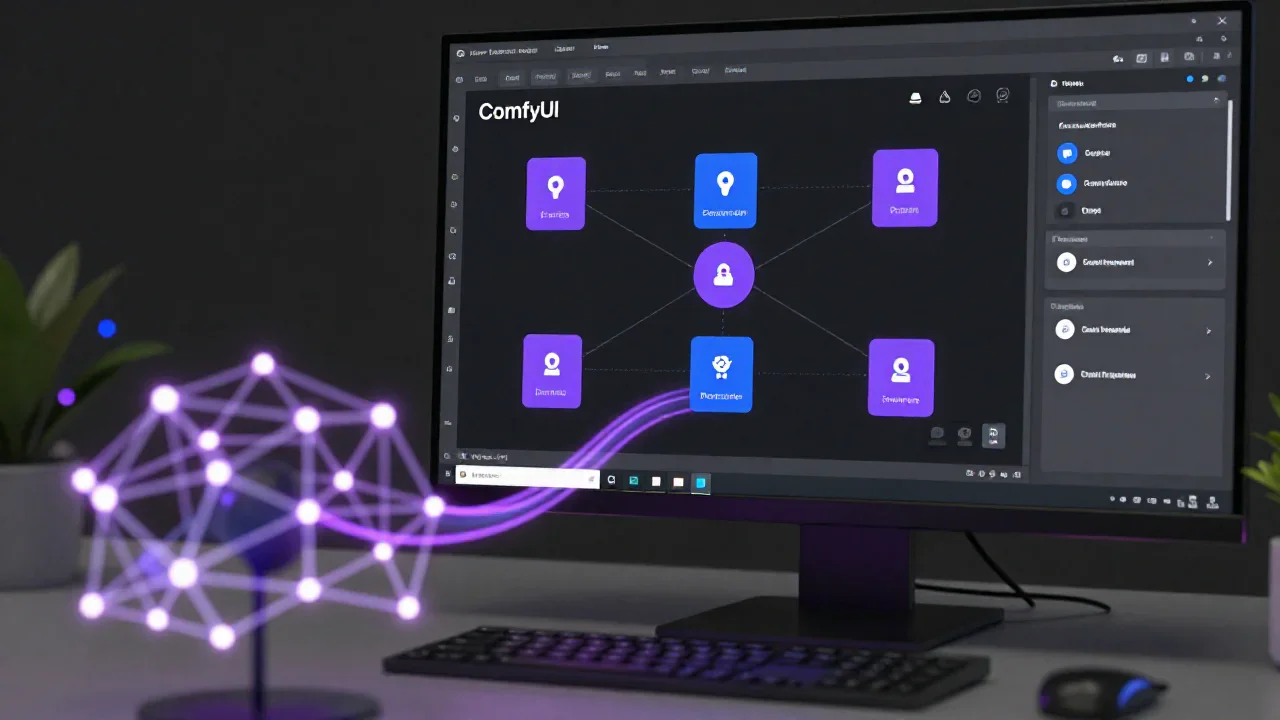

LTX-2代表了开源AI视频生成领域的重大突破。由Lightricks开发,这个190亿参数的扩散变换器模型能够在单次运行中生成同步的视频和音频,创造出以前只有专有系统才能实现的连贯多媒体体验。凭借原生ComfyUI集成和NVIDIA优化的检查点,LTX-2将专业级视频生成带到了消费级硬件上。

本综合指南将带你完成在ComfyUI中配置LTX-2的全过程,从初始安装到高级工作流优化。无论你是AI视频生成的新手还是经验丰富的ComfyUI用户,你都将学会如何充分发挥LTX-2的潜力,创作令人惊叹的同步音视频内容。

你将学到:

- 安装ComfyUI和LTX-2自定义节点

- 下载和组织所需模型

- 配置文生视频和图生视频工作流

- 使用NVFP4/FP8量化优化性能

- 解决常见问题

什么是LTX-2?

LTX-2是一个基于扩散变换器(DiT)架构构建的开源音视频基础模型。与传统的生成静音视频的视频生成模型不同,LTX-2同时生成动作、对话、音效和音乐,确保视觉和音频元素之间的完美同步。

核心特性

同步音视频生成: LTX-2的独特架构同时生成两种模态,无需单独的音频合成和同步步骤。

多种模型变体: 根据你的硬件和质量要求选择合适的检查点:

| 模型 | 描述 | 使用场景 |

|---|---|---|

| ltx-2-19b-dev | 完整模型,bf16格式 | 训练和微调 |

| ltx-2-19b-dev-fp8 | FP8量化 | 平衡质量和速度 |

| ltx-2-19b-dev-fp4 | NVFP4量化 | 3倍速度,减少60% VRAM |

| ltx-2-19b-distilled | 8步蒸馏版本 | 快速生成,CFG=1 |

| ltx-2-19b-distilled-lora-384 | LoRA版本 | 微调和定制 |

高级控制选项: 除了基本的文生视频,LTX-2还支持:

- 带首帧条件的图生视频

- 基于深度的结构引导

- 姿态驱动的角色动画

- Canny边缘控制实现精确运动

放大功能: 专用的放大器模型提升输出质量:

- 空间放大器(2倍分辨率)

- 时间放大器(2倍帧率)

技术规格

- 架构: 扩散变换器(DiT)

- 参数量: 190亿

- 许可证: ltx-2-community-license-agreement(开源)

- 文本编码器: Gemma 3 12B IT(量化为Q4_0)

- 输出: 同步视频和音频

需要考虑的限制

虽然LTX-2功能强大,但需要注意以下约束:

- 无法提供事实信息(这是生成模型,不是知识库)

- 可能放大训练数据中存在的社会偏见

- 提示词遵循度有所不同;复杂场景可能无法完美匹配描述

- 可能生成不当内容;生产环境需使用内容过滤

- 生成无语音内容时音频质量会下降

系统要求

LTX-2对资源要求较高。在继续之前,请确保你的系统满足这些规格。

最低硬件要求

GPU: NVIDIA GPU,32GB显存

- RTX 4090(24GB)可通过优化运行

- 推荐RTX 6000 Ada(48GB)用于完整工作流

内存: 最低32GB系统内存

- 推荐64GB用于复杂工作流

存储: 100GB+可用磁盘空间

- 模型: ~50GB

- 缓存和临时文件: ~30GB

- 输出工作空间: ~20GB

操作系统:

- Windows 10/11(64位)

- Linux(Ubuntu 20.04+或同等版本)

- macOS(有限支持,仅CPU)

软件前置条件

Python: 3.12或更高版本

- LTX-2需要现代Python特性

- 推荐使用虚拟环境

CUDA: 12.7或更高版本

- GPU加速所需

- 从NVIDIA网站下载

PyTorch: 2.7或兼容版本

- 将随ComfyUI依赖项一起安装

Git: 用于克隆仓库

- Windows: Git for Windows

- Linux/Mac: 预装或通过包管理器安装

最佳性能推荐配置

为获得最佳体验,特别是实时工作流:

- GPU: NVIDIA RTX 4090或A6000

- 内存: 64GB DDR4/DDR5

- 存储: NVMe SSD,200GB+可用空间

- CPU: 现代多核处理器(8核以上)

步骤1: 安装ComfyUI

ComfyUI为运行LTX-2提供基于节点的界面。如果你已经安装了ComfyUI,请跳到步骤2。

方法A: 全新安装(推荐新手)

Windows安装:

- 克隆ComfyUI仓库:

`git clone https://github.com/comfyanonymous/ComfyUI.git cd ComfyUI `- 创建Python虚拟环境:

`python -m venv venv venv\Scripts\activate `- 安装依赖项:

`pip install -r requirements.txt `- 安装支持CUDA的PyTorch:

`pip install torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu121 `- 启动ComfyUI:

`python main.py `Linux安装:

- 克隆并导航:

`git clone https://github.com/comfyanonymous/ComfyUI.git cd ComfyUI `- 创建虚拟环境:

`python3 -m venv venv source venv/bin/activate `- 安装依赖项:

`pip install -r requirements.txt pip install torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu121 `- 启动ComfyUI:

`python main.py `方法B: 更新现有安装

如果你已经有ComfyUI,更新到最新的nightly版本以获得LTX-2兼容性:

`cd ComfyUI git pull origin master pip install -r requirements.txt --upgrade `验证安装

- 打开网页浏览器并访问 http://localhost:8188

- 你应该看到带有默认工作流的ComfyUI界面

- 如果页面成功加载,ComfyUI就准备好了

故障排除: 如果ComfyUI无法启动:

- 检查Python版本: python --version(应为3.12+)

- 验证CUDA安装: nvidia-smi

- 检查端口可用性: 尝试 python main.py --port 8189

步骤2: 安装LTX-2自定义节点

LTX-2需要自定义节点才能与ComfyUI集成。最简单的安装方法是使用ComfyUI Manager。

方法A: 通过ComfyUI Manager安装(推荐)

- 打开ComfyUI Manager: - 启动ComfyUI(python main.py) 按Ctrl+M(Windows/Linux)或Cmd+M(Mac) Manager窗口将出现

- 搜索LTXVideo: - 点击"Install Custom Nodes" 在搜索框中输入"LTXVideo" 找到Lightricks的"ComfyUI-LTXVideo"

- 安装节点: - 点击"Install"按钮 等待安装完成(可能需要2-5分钟) 完成后会看到成功消息

- 重启ComfyUI: - 关闭ComfyUI终端/窗口 使用python main.py重启 LTXVideo节点将出现在节点菜单中

方法B: 手动安装

如果ComfyUI Manager不可用:

- 导航到自定义节点目录:

`cd ComfyUI/custom_nodes `- 克隆LTXVideo仓库:

`git clone https://github.com/Lightricks/ComfyUI-LTXVideo.git cd ComfyUI-LTXVideo `- 安装依赖项:

`pip install -r requirements.txt `- 返回ComfyUI根目录并重启:

`cd ../.. python main.py `验证节点安装

重启ComfyUI后:

- 在工作流画布中右键点击

- 导航到"Add Node" → "LTXVideo"

- 你应该看到如下节点: - LTXVConditioning LTX LTXV Add Guide LTXVLoader 以及其他

如果看到这些节点,安装就成功了!

低显存配置

如果你的显存少于32GB,使用低显存加载器节点:

- 定位低显存节点: 查找来自low_vram_loaders.py的节点

- 使用显存预留启动:

`python main.py --reserve-vram 5 `将5替换为要为其他进程预留的显存GB数。

步骤3: 下载所需模型

LTX-2需要几个模型文件。首次使用时,ComfyUI会尝试自动下载,但手动下载可确保你获得正确的版本。

模型存储位置

ComfyUI在特定目录中组织模型:

`ComfyUI/ ├── models/ │ ├── checkpoints/ # 主要LTX-2模型 │ ├── text_encoders/ # Gemma 3 12B编码器 │ │ └── gemma-3-12b-it-qat-q4_0-unquantized/ │ ├── latent_upscale_models/ # 放大器模型 │ └── loras/ # LoRA控制模型(可选) `需要下载的核心模型

1. 主检查点(选择一个):

对于大多数用户,从FP8量化模型开始以获得平衡性能:

- ltx-2-19b-dev-fp8(推荐) 下载: Hugging Face 大小: ~19GB 放置在: ComfyUI/models/checkpoints/

替代选项:

- ltx-2-19b-distilled: 更快,8步生成

- ltx-2-19b-dev-fp4: 最低显存使用(仅NVIDIA GPU)

2. 文本编码器(必需):

- Gemma 3 12B IT(Q4_0量化) 下载: Hugging Face 大小: ~7GB 放置在: ComfyUI/models/text_encoders/gemma-3-12b-it-qat-q4_0-unquantized/

3. 放大器模型(可选但推荐):

- 空间放大器(2倍) 下载: ltx-2-spatial-upscaler-x2-1.0 放置在: ComfyUI/models/latent_upscale_models/

- 时间放大器(2倍) 下载: ltx-2-temporal-upscaler-x2-1.0 放置在: ComfyUI/models/latent_upscale_models/

下载说明

使用Git LFS(推荐用于大文件):

`# 如果尚未安装Git LFS,先安装 git lfs install # 克隆模型仓库 cd ComfyUI/models/checkpoints git clone https://huggingface.co/Lightricks/LTX-2 `使用Hugging Face Hub:

`pip install huggingface-hub # 下载特定模型 huggingface-cli download Lightricks/LTX-2 ltx-2-19b-dev-fp8 --local-dir ComfyUI/models/checkpoints/ `手动下载:

- 访问Hugging Face LTX-2页面

- 导航到"Files and versions"

- 下载所需文件

- 放置在相应目录中

验证模型安装

下载后,验证你的目录结构:

`ComfyUI/models/checkpoints/ltx-2-19b-dev-fp8/ ComfyUI/models/text_encoders/gemma-3-12b-it-qat-q4_0-unquantized/ ComfyUI/models/latent_upscale_models/ltx-2-spatial-upscaler-x2-1.0/ `重要: 模型文件必须匹配预期的命名约定。如果ComfyUI找不到模型,请检查:

- 文件名完全匹配(区分大小写)

- 文件在正确的目录中

- 下载期间没有创建额外的子目录

步骤4: 加载示例工作流

LTX-2包含六个预配置的工作流,展示不同的生成模式。这些工作流是开始创作内容的最快方式。

访问模板库

方法A: 通过ComfyUI界面:

- 打开ComfyUI 访问 http://localhost:8188

- 访问模板: - 点击顶部菜单中的"Load"按钮 导航到"Template Library" → "Video" 查找LTX-2工作流

方法B: 从GitHub下载:

`cd ComfyUI mkdir -p workflows/ltx2 cd workflows/ltx2 # 下载示例工作流 wget https://raw.githubusercontent.com/Comfy-Org/workflow_templates/main/video_ltx2_t2v.json wget https://raw.githubusercontent.com/Comfy-Org/workflow_templates/main/video_ltx2_i2v.json `可用工作流

1. 文生视频(完整模型)

- 文件: video_ltx2_t2v.json

- 用途: 从文本提示词生成高质量视频

- 步数: 50(可调整)

- 最适合: 最终生产输出

2. 文生视频(蒸馏版)

- 文件: video_ltx2_t2v_distilled.json

- 用途: 快速预览生成

- 步数: 8(固定)

- 最适合: 快速迭代和测试

3. 图生视频(完整模型)

- 文件: video_ltx2_i2v.json

- 用途: 使用首帧条件为静态图像添加动画

- 输入: 单张图像+文本提示词

- 最适合: 角色动画、产品演示

4. 图生视频(蒸馏版)

- 文件: video_ltx2_i2v_distilled.json

- 用途: 快速图像动画测试

- 步数: 8

- 最适合: 预览动画概念

5. 视频增强器

- 文件: video_ltx2_v2v_detailer.json

- 用途: 为现有视频添加额外细节

- 输入: 视频文件+增强提示词

- 最适合: 放大和精修

6. IC-LoRA多重控制

- 文件: video_ltx2_iclora_multicontrol.json

- 用途: 使用多种引导类型进行高级控制

- 控制: 深度、姿态、Canny边缘

- 最适合: 精确运动控制

加载工作流

- 下载或定位工作流JSON文件

- 在ComfyUI中,点击"Load" → "Load Workflow"

- 选择JSON文件

- 等待节点填充画布

- 检查所有节点是否已连接(无红色错误指示器)

如果看到缺少节点错误:

- 确保已安装LTXVideo自定义节点

- 重启ComfyUI

- 检查模型是否在正确的目录中

步骤5: 配置你的第一次生成

让我们使用文生视频工作流创建你的第一个视频。本节将详细介绍每个参数并解释如何获得最佳结果。

理解T2V工作流结构

文生视频工作流由五个主要组件组成:

- 文本编码: 将提示词转换为嵌入向量

- 条件设置: 将文本与帧率和其他参数绑定

- 采样: 生成潜在视频表示

- 解码: 将潜在表示转换为可查看的视频

- 音视频混合: 组合同步的音频和视频

配置提示词

LTX-2的提示词工程:

LTX-2对描述性、场景聚焦的提示词响应最好。遵循以下指南:

良好的提示词结构:

`[主体] [动作] [场景] [氛围/风格] [镜头运动] [音频描述] `示例提示词:

简单场景:

`一只金毛寻回犬小狗在阳光明媚的花园里玩耍,兴奋地摇着尾巴。 轻柔的环境音,鸟儿鸣叫和树叶沙沙作响。缓慢的镜头平移。 `复杂场景:

`一位穿着粉色制服的1950年代餐厅女服务员在柜台为顾客端咖啡。 复古美学,温暖的灯光。镜头从左向右推移。 背景喧闹声、餐具碰撞声和欢快的爵士乐。 `提示词技巧:

- 明确音频描述: 当你描述期望的声音时,LTX-2会生成更好的结果

- 包含镜头运动: "静态镜头"、"缓慢变焦"、"从左向右平移"

- 描述光照: "黄金时刻"、"霓虹灯"、"柔和的工作室照明"

- 指定风格: "电影感"、"纪录片"、"复古胶片"

关键参数详解

1. 帧率(fps):

- 24 fps: 电影感,电影标准

- 30 fps: 流畅运动,适合一般内容

- 60 fps: 非常流畅,最适合动作场景

- 注意: 更高的fps需要更多显存和处理时间

2. 分辨率:

- 必须能被32整除

- 常见选项: - 512x512: 快速测试 768x512: 宽屏预览 1024x576: 高清质量 1280x720: 全高清(需要48GB+显存)

3. 帧数:

- 必须能被(8 + 1) = 9整除

- 示例: 9、18、27、36、45帧

- 更长的视频需要指数级增加的显存

4. 采样步数:

- 完整模型: 30-50步(更高=更好质量)

- 蒸馏模型: 8步(固定)

- 更多步数=更长生成时间

5. CFG比例(无分类器引导):

- 范围: 1.0 - 15.0

- 1.0-3.0: 宽松解释,创意性强

- 5.0-7.0: 平衡(推荐)

- 10.0+: 严格遵循,可能降低质量

分步生成流程

- 加载T2V工作流(如步骤4所述)

- 定位CLIP文本编码节点: - 这是你输入提示词的地方 输入或粘贴你的描述性文本

- 配置LTXVConditioning节点: - 设置帧率(默认: 24) 调整CFG比例(从7.0开始)

- 在采样器节点中设置分辨率: - 宽度: 768 高度: 512 帧数: 27(24fps时约1秒)

- 选择检查点: - 在模型加载器节点中 选择ltx-2-19b-dev-fp8以获得平衡性能

- 排队生成: - 点击右上角的"Queue Prompt" 观察进度条 生成时间: 2-10分钟,取决于硬件

- 预览结果: - 视频出现在输出节点中 右键点击保存或播放

音频同步设置

LTX-2自动生成同步音频。要控制音频特性:

在提示词中指定:

- 声音类型: "对话"、"音乐"、"环境音"

- 音频氛围: "欢快"、"忧郁"、"充满活力"

- 音量平衡: "安静的背景音乐"、"突出的对话"

注意: 当生成具有清晰声源(对话、音乐)的内容时,音频质量最佳。静音或仅环境音的场景可能音频保真度较低。

高级功能

一旦你熟悉了基本的文生视频生成,就可以探索这些高级功能来精确控制输出。

控制到视频:深度、姿态和Canny

LTX-2支持三种结构引导类型,用于精确的运动控制:

1. 基于深度的控制

使用深度图引导空间结构和镜头运动:

- 工作流: 加载 video_ltx2_depth_control.json

- 预处理器: "Image to Depth Map (Lotus)"

- 用途: - 保持一致的3D结构 控制镜头透视变化 建筑漫游

设置:

- 加载参考图像

- 应用Lotus深度预处理器

- 将深度图连接到LTX LTXV Add Guide节点

- 设置引导强度(0.5-1.0)

2. 姿态驱动动画

使用姿态估计控制角色运动:

- 工作流: 加载 video_ltx2_pose_control.json

- 预处理器: DWPreprocessor(DWPose)

- 用途: - 角色动画 舞蹈序列 动作编排

设置:

- 输入参考视频或图像序列

- 使用DWPreprocessor提取姿态

- 可选: 加载姿态控制LoRA以增强准确性

- 连接到引导节点

3. Canny边缘控制

使用边缘检测进行结构引导:

- 工作流: 加载 video_ltx2_canny_control.json

- 预处理器: Canny边缘检测器

- 用途: - 保留物体边界 建筑细节 线稿动画

设置:

- 对参考应用Canny边缘检测

- 调整阈值(低: 100,高: 200)

- 将边缘连接到引导节点

- 与文本提示词强度平衡

空间和时间放大

使用专用放大器模型增强生成的视频:

空间放大器(2倍分辨率):

- 在初始生成后添加放大器节点

- 加载模型: ltx-2-spatial-upscaler-x2-1.0

- 连接潜在输出到放大器输入

- 结果: 768x512 → 1536x1024

优势:

- 更清晰的细节

- 更好的纹理质量

- 最少的伪影

时间放大器(2倍帧率):

- 添加时间放大器节点

- 加载模型: ltx-2-temporal-upscaler-x2-1.0

- 连接视频输出

- 结果: 24fps → 48fps

优势:

- 更流畅的运动

- 减少抖动

- 更好的慢动作能力

组合使用: 链接空间和时间放大器以获得最大质量:

- 输入: 768x512 @ 24fps

- 空间放大后: 1536x1024 @ 24fps

- 时间放大后: 1536x1024 @ 48fps

注意: 放大会显著增加显存使用和处理时间。

LoRA训练和应用

为特定风格或主题微调LTX-2:

训练自己的LoRA:

- 准备数据集: 10-50个目标风格的视频片段

- 使用LTX-2 Trainer: 遵循官方训练指南

- 训练时间: 在现代GPU上1-2小时

- 输出: LoRA权重文件

在ComfyUI中应用LoRA:

- 放置LoRA在ComfyUI/models/loras/

- 添加LoRA加载器节点到工作流

- 设置强度: 0.5-1.0(更高=更强效果)

- 连接到模型输入

IC-LoRA(图像条件LoRA):

使用参考图像的特殊LoRA类型:

- 加载video_ltx2_iclora_multicontrol.json

- 提供参考图像

- 与其他控制(深度、姿态、canny)结合

- 实现一致的角色外观

性能优化

通过这些优化技术最大化生成速度和质量。

NVFP4/FP8量化

NVIDIA优化的检查点提供显著的性能改进:

FP8量化(推荐):

- 模型: ltx-2-19b-dev-fp8

- 显存节省: 相比bf16约30%

- 速度: 约2倍快

- 质量: 最小降级

NVFP4量化(最大速度):

- 模型: ltx-2-19b-dev-fp4

- 显存节省: 相比bf16 60%

- 速度: 3倍快

- 质量: 轻微质量降低

- 要求: NVIDIA RTX 40系列或更新

选择正确的量化:

- 32GB+显存: 使用FP8获得最佳平衡

- 24GB显存: 使用NVFP4以确保可行性

- 48GB+显存: 考虑bf16以获得最大质量

多GPU配置

在多个GPU之间分配工作负载:

序列并行:

- 编辑ComfyUI启动脚本:

`python main.py --multi-gpu --gpu-ids 0,1 `- 在工作流中配置:

- 添加"Multi-GPU Sampler"节点

- 指定GPU分配

- 平衡显存使用

优势:

- 2个GPU: 约1.7倍速度提升

- 4个GPU: 约3倍速度提升

- 支持更高分辨率

内存管理技术

分块解码: 在视频解码期间减少显存使用:

- 添加"Tiled VAE Decode"节点

- 设置块大小: 512x512

- 重叠: 64像素

- 更慢但使用50%更少的显存

模型卸载: 对于显存有限的系统:

`python main.py --lowvram `在不使用时将模型卸载到内存。

批处理: 高效生成多个视频:

- 排队多个提示词

- ComfyUI按顺序处理

- 模型在生成之间保持加载

- 比单独运行更快

工作流优化技巧

- 使用蒸馏模型进行迭代: - 使用8步蒸馏模型测试提示词 切换到完整模型进行最终输出 节省80%的迭代时间

- 缓存文本编码: - 重用编码的提示词 添加"Save Text Encoding"节点 为变体加载缓存的编码

- 渐进式分辨率: - 从512x512开始测试 放大到目标分辨率 比直接高分辨率生成更快

故障排除

在ComfyUI中使用LTX-2时的常见问题及其解决方案。

显存不足错误

症状: 生成期间出现"CUDA out of memory"错误

解决方案:

- 降低分辨率: 尝试512x512或768x512

- 减少帧数: 使用18或27帧而不是36+

- 使用NVFP4模型: 需要60%更少的显存

- 启用低显存模式:

`python main.py --lowvram --reserve-vram 4 `- 使用分块解码: 添加Tiled VAE Decode节点

- 关闭其他应用程序: 释放GPU内存

模型下载失败

症状: "Model not found"或下载超时错误

解决方案:

- 手动下载: 使用Git LFS或Hugging Face CLI

- 检查网络连接: 大文件需要稳定连接

- 验证文件路径: 确保模型在正确的目录中

- 检查磁盘空间: 需要100GB+可用空间

- 使用镜像站点: 尝试替代下载源

缺少节点错误

症状: 红色节点或"Node not found"消息

解决方案:

- 重新安装自定义节点:

`cd ComfyUI/custom_nodes/ComfyUI-LTXVideo git pull pip install -r requirements.txt --upgrade `- 重启ComfyUI: 关闭并重新启动

- 检查Python版本: 必须是3.12+

- 验证依赖项: 运行pip list检查安装

音视频同步问题

症状: 音频与视频时间不匹配或缺失

解决方案:

- 检查提示词: 在提示词中明确描述音频

- 验证混合节点: 确保"Video Combine"节点已连接

- 帧率一致性: 使用标准帧率(24、30、60 fps)

- 重新生成: 音频生成可能不一致;再试一次

- 使用完整模型: 蒸馏模型可能音频质量较低

生成速度慢

症状: 短片段生成需要10分钟以上

解决方案:

- 使用蒸馏模型: 8步生成快5-6倍

- 启用NVFP4: 在兼容GPU上提升3倍速度

- 降低分辨率: 更低分辨率=更快生成

- 检查GPU利用率: 使用nvidia-smi验证GPU处于活动状态

- 更新驱动程序: 确保安装了最新的NVIDIA驱动程序

输出质量差

症状: 模糊、伪影或结果不一致

解决方案:

- 增加采样步数: 完整模型尝试40-50步

- 调整CFG比例: 测试5.0-9.0范围

- 改进提示词: 更具体和描述性

- 使用更高分辨率: 最低768x512以获得质量

- 尝试不同检查点: FP8 vs NVFP4 vs 蒸馏版

- 添加放大器: 使用空间放大器获得更清晰的输出

结论

LTX-2将专业级同步音视频生成带到了ComfyUI,使消费级硬件上的高级AI视频创作成为可能。通过遵循本指南,你已经学会了如何:

- 安装和配置ComfyUI与LTX-2自定义节点

- 下载和组织所需模型

- 创建你的第一个文生视频和图生视频

- 应用深度、姿态和canny引导等高级控制

- 使用量化和多GPU设置优化性能

- 解决常见问题

关键要点

从简单开始: 从蒸馏模型和低分辨率开始快速学习工作流。熟悉后,再转向完整模型以获得生产质量的输出。

实验提示词: 当你详细描述视觉和音频元素时,LTX-2的音视频同步效果最佳。花时间精心制作描述性提示词。

针对硬件优化: 根据显存可用性选择合适的检查点(FP8、NVFP4或蒸馏版)。如果需要,不要犹豫使用低显存模式。

利用高级功能: 一旦掌握了基本生成,探索控制到视频工作流以实现精确的运动控制,以及放大器以增强质量。

学习资源

官方文档:

- LTX-2 GitHub仓库

- ComfyUI-LTXVideo文档

- LTX-2提示词指南

社区资源:

- ComfyUI Discord - 从社区获得帮助

- LTX平台Discord - Lightricks官方支持

- ComfyUI工作流仓库 - 示例工作流

在线演示:

- LTX Studio文生视频 - 在线试用LTX-2

- LTX Studio图生视频 - 测试I2V生成

下一步是什么?

现在你已经配置好了LTX-2,考虑以下后续步骤:

- 创建作品集: 生成多样化的视频以了解LTX-2的能力

- 训练自定义LoRA: 为你的特定风格或主题进行微调

- 探索控制方法: 掌握深度、姿态和canny引导

- 加入社区: 分享你的作品并向他人学习

- 保持更新: LTX-2正在积极开发中;关注新功能

AI视频生成的未来就在这里,有了ComfyUI中的LTX-2,你拥有了创作令人惊叹的同步音视频内容的工具。祝你生成愉快!

Link

- Z-Image: Free AI Image Generator

- Z-Image-Turbo: Free AI Image Generator

- Free Sora Watermark Remover

- Zimage.run Google Site