标题:《HY-World 1.5: A Systematic Framework for Interactive World Modeling with Real-Time Latency and Geometric Consistency》

项目:https://3d.hunyuan.tencent.com/sceneTo3D

来源:腾讯

文章目录

- 摘要

- 一、前言

- 二、数据

-

- [1. 数据管理](#1. 数据管理)

- [2. 数据过滤与增强](#2. 数据过滤与增强)

- 3.元数据标注

- 三、模型预训练:自回归生成模型

-

- [3.1 双向扩散模型](#3.1 双向扩散模型)

- 2.块(Chunk-wise)自回归的生成

- 四、模型中间训练:控制与记忆整合

- [五、模型后训练 I:高效强化学习](#五、模型后训练 I:高效强化学习)

-

- 1.世界模型的强化学习挑战

- [2.WorldCompass 框架的设计](#2.WorldCompass 框架的设计)

- [六、模型后训练 II:上下文强制蒸馏](#六、模型后训练 II:上下文强制蒸馏)

- [七、模型推理:Play with the World](#七、模型推理:Play with the World)

- 八、模型评估

摘要

混元世界1.0能够生成沉浸式可探索的3D世界,但其依赖冗长的离线生成过程且缺乏实时交互功能。HY-World 1.5通过WorldPlay这一流式视频扩散模型弥合了这一差距,该模型实现了具有长期几何一致性、实时交互的世界建模,解决了当前方法在速度与内存之间的权衡问题。模型基于四大核心设计:

- 1)采用双动作表征实现对用户键盘和鼠标输入的稳健动作控制;

- 2)通过重构上下文记忆动态重建历史帧上下文,并运用时间重构技术保持几何关键的远古帧可访问性,有效缓解记忆衰减问题;

- 3)设计WorldCompass------一种新型强化学习(RL)后训练框架,直接提升长视距自回归视频模型的动作跟随能力和视觉质量;

- 4)提出上下文强制技术,专为记忆感知模型设计的新型蒸馏方法。通过在教师模型与学生模型间保持上下文记忆一致性,既保留了学生模型利用远距离信息的能力,又实现了实时生成速度并防止误差漂移。

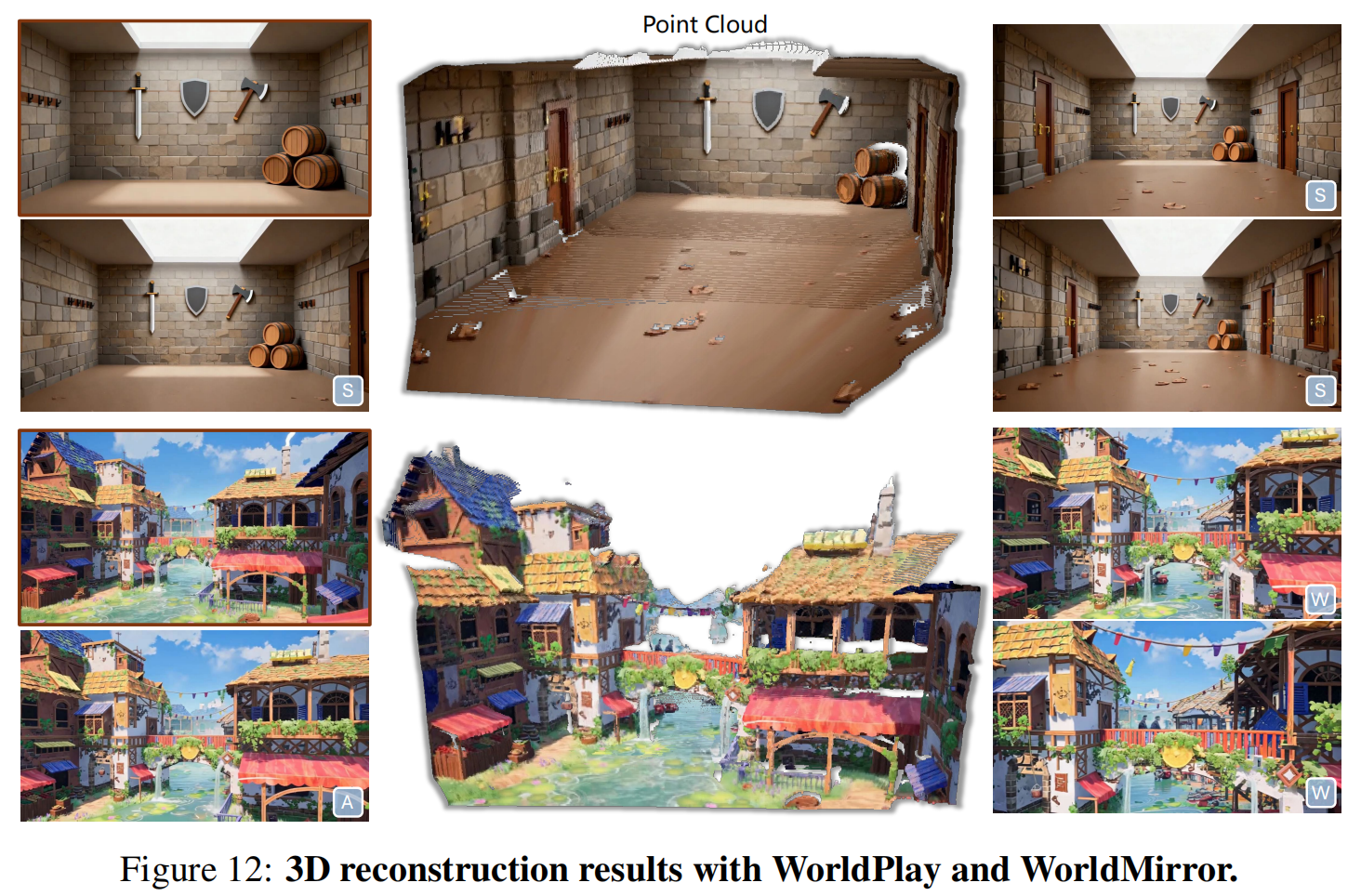

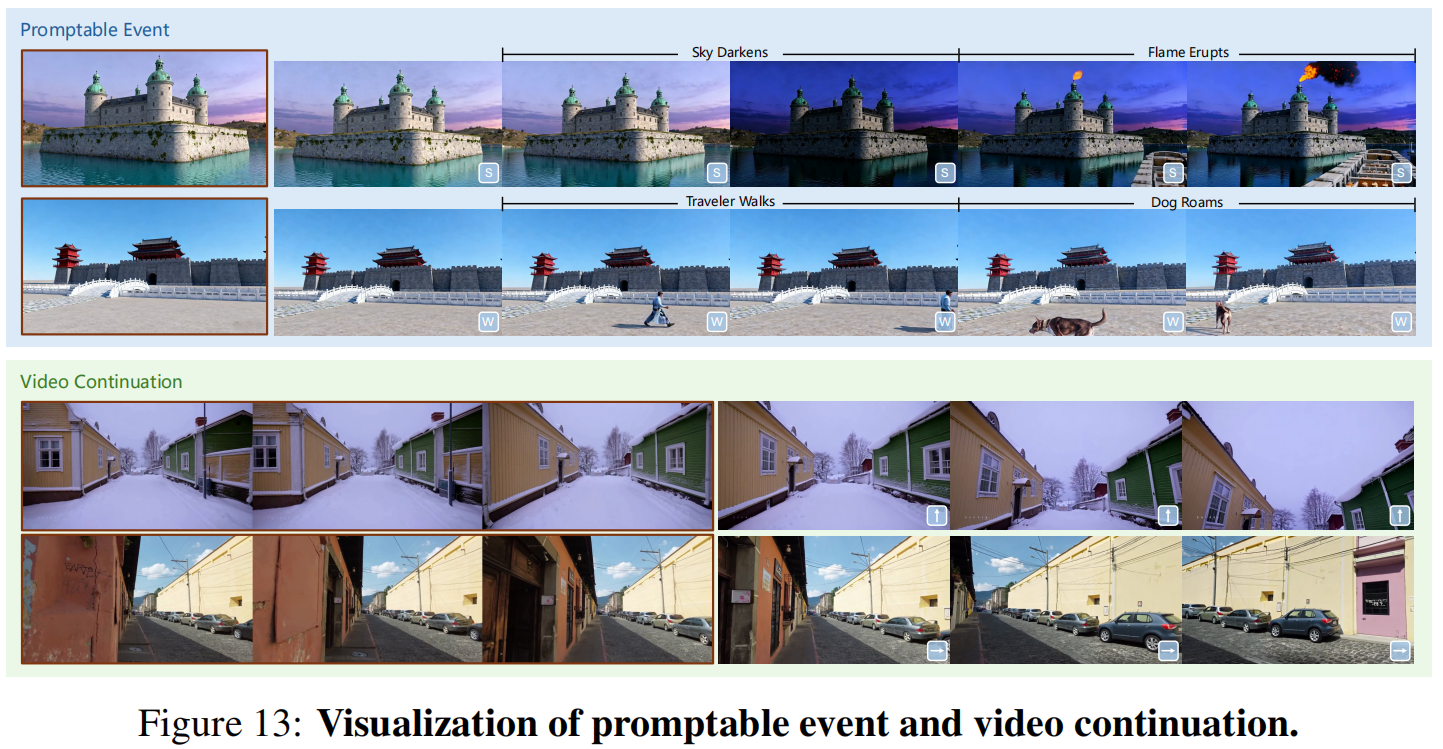

HY-World 1.5能以24帧/秒的速率生成具有卓越一致性的长视距流式视频 ,其表现优于现有技术,在多种场景中展现出强大的泛化能力,无论是在现实世界还是风格化环境中,都能支持第一人称和第三人称视角 ,从而实现三维重建、提示式事件及无限世界扩展等多样化应用。

一、前言

二、数据

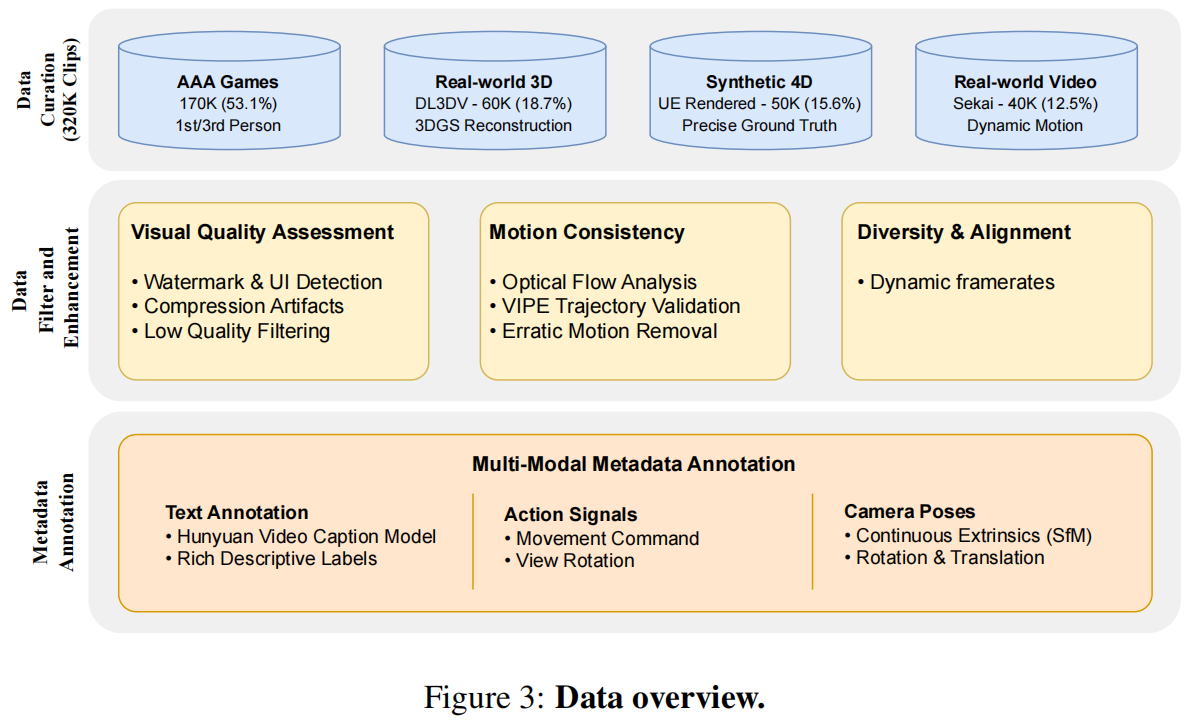

HY-World 1.5 基于一个包含32万段经过人工标注的视频片段的全面训练数据集,该数据集在数据多样性、质量及标注准确性方面均经过考量。图3展示了数据整体架构。

1. 数据管理

我们的训练数据集采用战略性分类设计, 包含四大不同类别,每个类别既聚焦交互式世界建模的不同维度,又为训练语料库的整体多样性和全面性作出贡献。

其中占比最大的17万段视频片段(53.125%)来自AAA级游戏,涵盖第一人称视角和第三人称视角的多角度录制。这些视频片段生动呈现了复杂智能体行为、物理模拟效果以及多样化环境交互的丰富互动场景。

真实世界三维数据集包含60,000个片段(占比18.75%),源自DL3DV数据集[16],具有逼真的外观和精确的场景结构。具体的,首先对每个原始视频进行3DGS重建;随后设计摄像机轨迹以模拟交互式导航模式,确保全面覆盖不同运动和旋转角度,这对开发稳健的动作控制至关重要。

合成数据集包含5万段视频片段(占比15.625%),均采用虚幻引擎(Unreal Engine)渲染。这些数据不仅实现了物体间的动态交互与可控光照效果,更显著提升了数据集的多样性。此外,其提供的精准标注数据(groundtruth)在现实场景中往往难以获取,对动作模式学习具有重要价值。

最后一类数据源自Sekai数据集[15],包含4万段视频片段(占比12.5%),聚焦于具有动态运动与交互的自然实景视频。我们采用严格的筛选标准,确保视频具备高质量视觉效果、稳定的摄像机运动以及有意义的交互元素。这些片段为真实环境中发生的自然运动模式和物体行为提供了关键先验信息,使模型在真实场景中的表现更具可信度。

2. 数据过滤与增强

原始数据需经过精密的多阶段数据过滤流程,以确保视觉质量与运动一致性。首先采用自动化视觉质量评估系统,运用视频美学评分、水印与用户界面检测、压缩伪影检测等工具,对未达最低质量标准的视频片段进行过滤。

运动一致性分析是确保数据集呈现物理真实运动行为的关键环节,这对开发稳定的交互响应至关重要。具体而言,我们首先通过光流技术分析运动强度,过滤掉存在严重摄像机抖动的视频片段。接着对每个视频片段的摄像机运动轨迹进行平滑度和合理性验证,剔除可能影响训练效果的突兀或不合理运动。

我们进一步提升了训练数据集的内容质量与多样性,通过动态帧率技术增强内容多样性,确保涵盖不同播放速度、摄像机运动方式及帧率配置的多样化场景。

3.元数据标注

采用HunyuanVideo 1.5[25]的字幕模型为每个视频片段生成结构化文本注释 。连续摄像机位姿通过 VIPE [ 7--Vipe: Video pose engine for 3d geometric perception ]估算或直接从虚幻引擎及3D渲染管线中提取 。随后根据这些摄像机轨迹推导离散动作信号,将动作分类为运动指令和视角旋转。对于AAA级游戏的录制内容,离散动作信号直接记录。

三、模型预训练:自回归生成模型

3.1 双向扩散模型

双向视频扩散模型[25,26]通过在海量网络数据集上训练,已具备感知、建模和操控现实世界 的能力,从而生成逼真视频。其采用三维变分自编码器(VAE)[11],将视频压缩至紧凑的潜在空间。随后,扩散Transformer(DiT)[21]被用于潜在空间的生成建模 。每个DiT模块包含三维自注意力机制、条件输入的交叉注意力[26](或双向注意力[25])以及前馈网络。这些模型 N θ N_θ Nθ 由 θ θ θ 参数化的模型,采用流匹配目标[17]进行训练,其公式表述为:

其中 z 0 z_0 z0表示由三维 VAE 编码的视频潜在变量, z 1 ∼ N ( 0 , I ) z_1∼N(0,I) z1∼N(0,I)表示高斯噪声, z k z_k zk表示扩散时间步 k k k时的含噪潜在变量, v k v_k vk为目标速度。

2.块(Chunk-wise)自回归的生成

双向视频扩散模型属于非因果架构 ("causal"框架下,模型是单向的,预测时只能从过去的信息向未来生成数据,Non-Causal框架可以增强模型的理解能力,但它在生成长时间序列时会面临一定的限制) ,这限制了其无限长交互生成的能力。但WorldPlay的目标是构建一个具有长期几何一致性(具体表现为 N θ ( x t ∣ O t − 1 , A t − 1 , a t , c ) ) N_θ(x_t|O_{t−1},A_{t−1},a_t,c)) Nθ(xt∣Ot−1,At−1,at,c)) 的实时交互世界模型 ,能够根据历史观测数据 O t − 1 = O_{t−1}= Ot−1={ x t − 1 , . . . , x 0 x_{t−1},...,x_0 xt−1,...,x0}、动作序列 A t − 1 = A_{t−1}= At−1={ a t − 1 , . . . , a 0 a_{t−1},...,a_0 at−1,...,a0}以及当前动作 a t a_t at,生成下一个片段 x t x_t xt(每个chunk有16帧) 。 c c c是描述世界的文本提示或图像。为简化符号表示,后续章节将省略A、a、c的标注。

为了实现实时交互式长时程生成,我们将双向视频模型转换为分块自回归生成模型 。 将视频序列分为4个latents 块,对应16帧。受Diffusion Forcing[2]的启发,训练过程中,为每个块添加不同噪声等级 ,并修改双向自注意力以阻断因果注意力。训练损失与等式1类似。这种训练好的自回归模型建立了交互式世界建模所需的基础能力,为后续的动作和记忆整合提供基础。

四、模型中间训练:控制与记忆整合

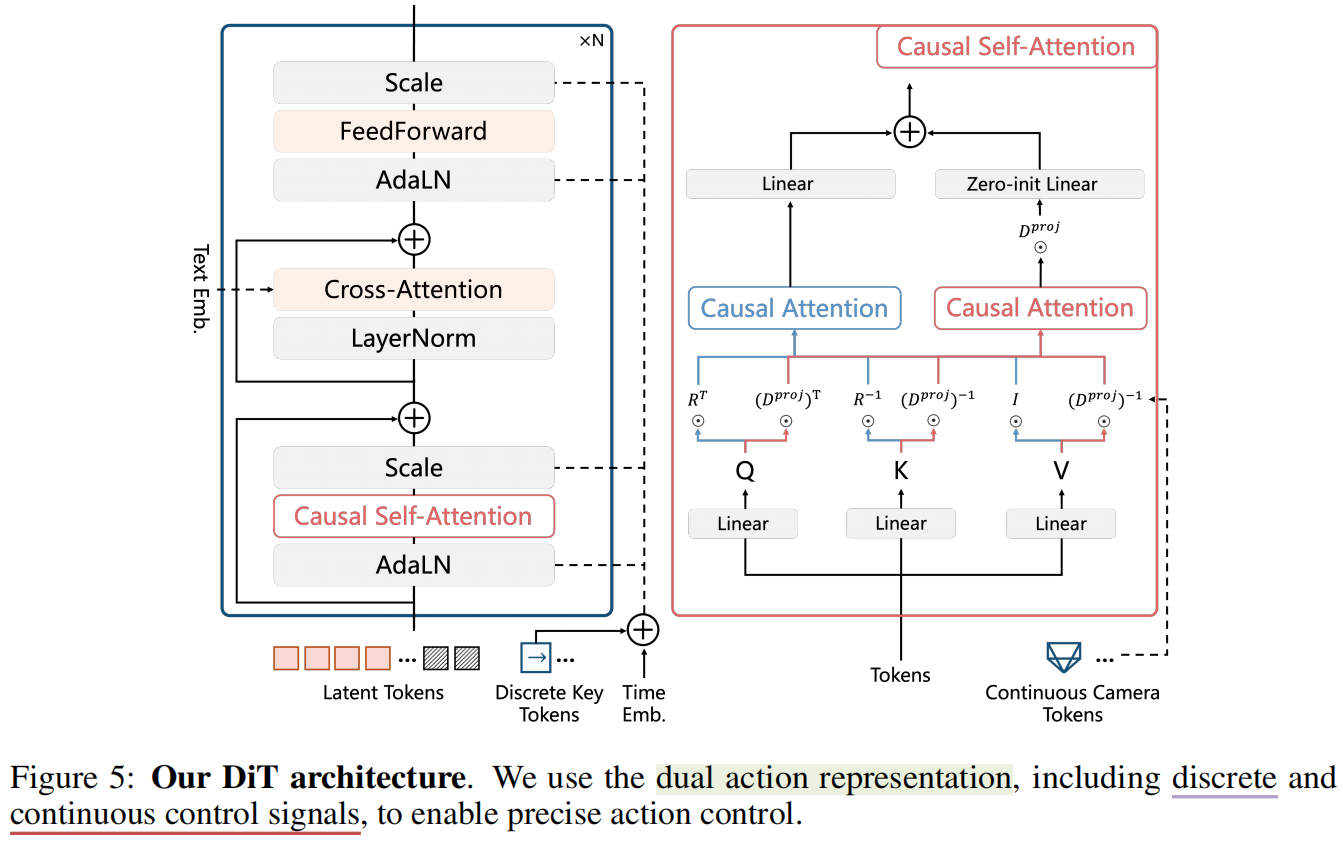

该中间训练阶段将 动作控制 与 记忆机制 整合至自回归生成模型中,以实现精确的动作控制和长期几何一致性。我们首先引入用于动作控制的双动作表征 ,随后采用重构的上下文记忆机制,该机制在重新访问先前已观察区域时能保持一致性。

1.双重动作表示

- 1.仅使用离散动作信号[4,29,6,32]能够帮助学习在不同尺度场景(如极大和极小场景)中物理上合理的运动,却难以提供精确的先前位置信息,用于空间记忆检索

- 2.连续的相机姿态(旋转和平移矩阵)能提供准确的空间位置信息,从而促进精确控制和记忆检索。但仅使用相机姿态进行训练时,由于训练数据的尺度差异,会面临训练稳定性挑战。

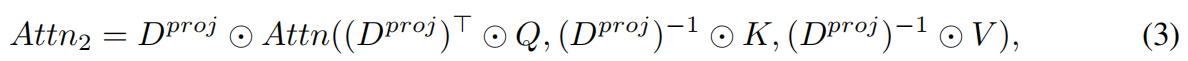

如图5,我们 引入了一种双动作表征方法,融合了离散与连续控制信号的优势 :对于离散动作(键盘和鼠标输入),采用零初始化 MLP 来投影动作嵌入 ,并将其整合到时间步嵌入中,用于调节DiT模块。对于连续的相机姿态,采用投影位置编码(PRoPE)[13]将相机位姿注入自注意力 。 原始自注意力计算公式如下:

R R R表示视频潜像的三维旋转位置编码(RoPE)[23],⊙表示矩阵-向量乘积[13]。为编码摄像机间的截锥体关系,采用额外的注意力:

D p r o j D^{proj} Dproj由相机的内参和外参共同生成(文献 [13:Cameras as relative positional encoding] )。每个自注意力模块的输出通过 零初始化层(权重为0,开始时几乎不起作用),整合为 A t t n 1 + Attn_1+ Attn1+zero_init ( A t t n 2 ) (Attn_2) (Attn2)。这种双重动作表征机制,既能实现跨尺度的鲁棒控制,又可为记忆检索提供精准的空间定位。

2.上下文记忆表示

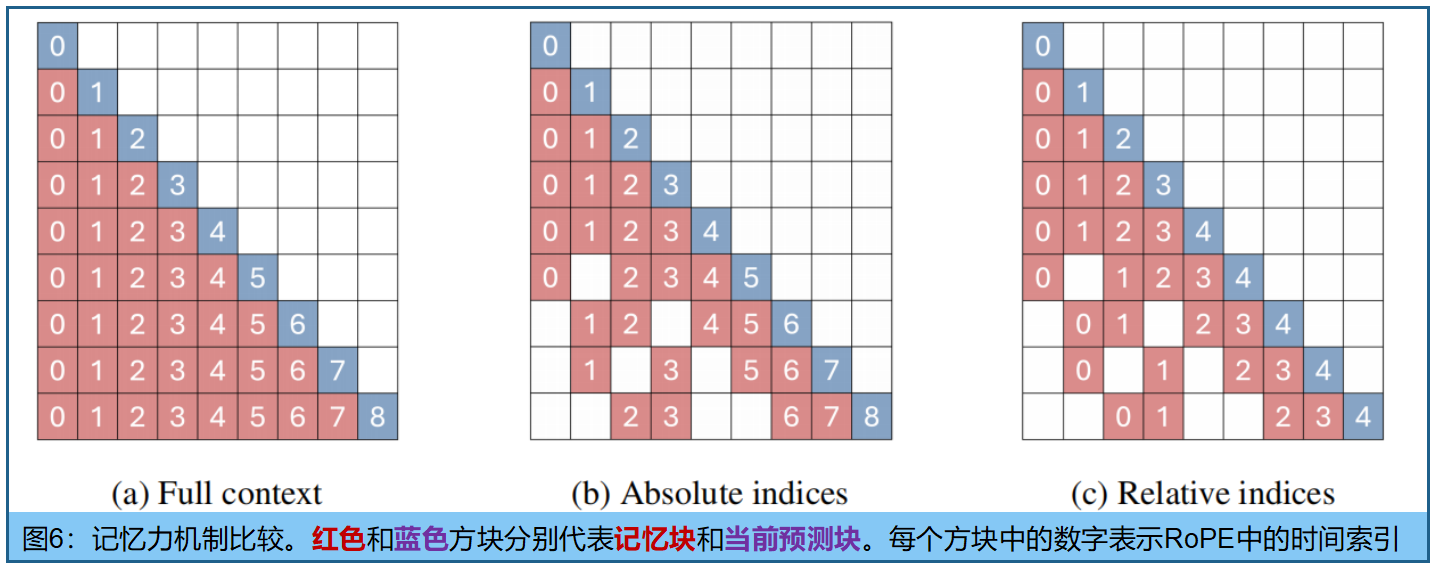

要保持长期几何一致性 ,需要调用历史片段,确保在重新访问先前位置时内容保持不变 。然而,若简单地将所有历史片段都作为上下文使用(图6a),对于长序列而言计算成本过高且冗余。为此, 对于每个新片段 x t x_t xt ,由历史片段 O t − 1 O_{t−1} Ot−1重建记忆上下文 C t C_t Ct 。本方法通过结合短期时间线索与远程空间参考实现双重优化:

- 1)时间记忆( C t T C_t^T CtT )包含最近 L L L个片段 { x t − L , . . . , x t − 1 x_{t−L},...,x_{t−1} xt−L,...,xt−1},确保短期运动平滑性;

- 2)空间记忆( C t S C_t^S CtS )从非相邻历史帧中采样,防止长序列中 的几何漂移,其中 C t S ⊆ O t − 1 − C t T C_t^S ⊆ O_{t−1} − C_t^T CtS⊆Ot−1−CtT。这种采样过程由几何相关性评分引导,该评分同时考虑 FOV 重叠度与摄像机距离。

标准RoPE位置编码模型(图6b)中,当前数据块与历史记忆之间的距离会随时间无限扩大 。这种不断增长的相对距离最终可能超出RoPE模型的训练插值范围,导致外延的伪影[23]。更严重的是,随着对这些远古空间记忆的感知距离增加,它们对当前预测结果的影响会逐渐减弱。为解决这一问题, 我们提出时间重构技术(图6c),摒弃绝对时间索引,动态为所有上下文帧重新分配位置编码 ,确保其与当前预测数据块保持固定且较小的相对距离,而不论实际时间间隔大小,实质上"拉近"了重要历史帧的时间距离。

五、模型后训练 I:高效强化学习

1.世界模型的强化学习挑战

经过预训练和中期训练后,世界模型已具备生成对应基础探索动作的视觉序列能力。然而,这些初始训练阶段,高度依赖原始视觉数据的像素级监督,这种监督方式仅能隐式教会模型遵循输入动作并探索环境,常导致长时程交互准确率陷入性能瓶颈,且视觉伪影持续存在,尤其在复杂组合动作条件下更为明显。强化学习(RL)为显式强化模型处理此类复杂场景的能力提供了可行路径。

然而,将强化学习(RL)应用于世界建模具有独特挑战性,这源于其固有的长时域、自回归和交互特性。具体而言,长时域要求给轨迹生成带来了显著的计算成本。此外,如何开发合适的奖励函数以及选择有效的强化学习算法来提升动作跟随精度和世界模型的视觉保真度,仍是当前研究中尚未充分探索的领域。

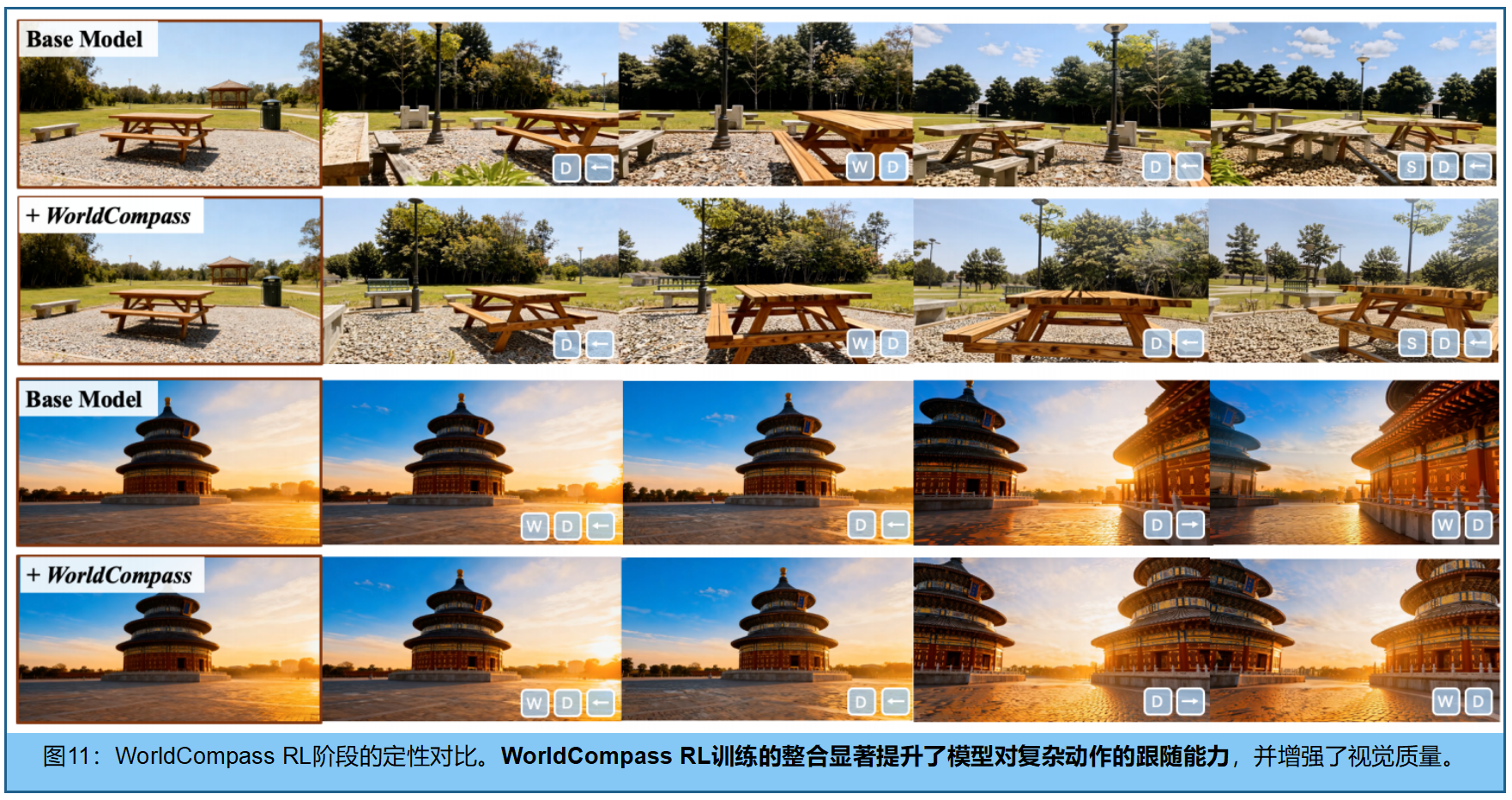

2.WorldCompass 框架的设计

我们推出了WorldCompass[27]------一个专为交互式视频世界模型训练后阶段设计的新型强化学习框架,能有效引导模型探索路径。通过直接利用交互信号进行模型教学,我们在不同训练时长、多样化输入提示及复杂组合动作场景中,均实现了能力的显著提升。具体而言,我们 对强化学习(RL)流程的每个阶段进行了重新设计,将其建立在世界模型的交互式、长时域生成范式基础上:

- 1.首先,为自回归视频生成引入了Clip-Level Rollout 策略 , 传统的逐帧展开(Frame-Level Rollout)会加剧曝光偏差,因为每一步的误差都会被立刻用于下一步的预测。Clip-Level Rollout 将生成过程划分为一个个连续的 "片段",通过引入"缓冲"和"批量校正"来应对这个问题,显著提升了Rollout 效率和奖励信号的粒度,通过迫使模型依赖自身不完美的预测,有效缓解了暴露偏差问题。

- 2.其次,我们设计了与世界建模主要特征相匹配的互补奖励函数------具体包括动作跟随分数和生成内容的视觉质量分数,这种多维度反馈机制能有效抑制奖励黑客攻击这一常见故障模式。

- 3.第三,采用先进的强化学习算法DiffusionNFT[35],结合多种效率优化策略,有效引导自回归视频生成模型向预期行为方向发展。

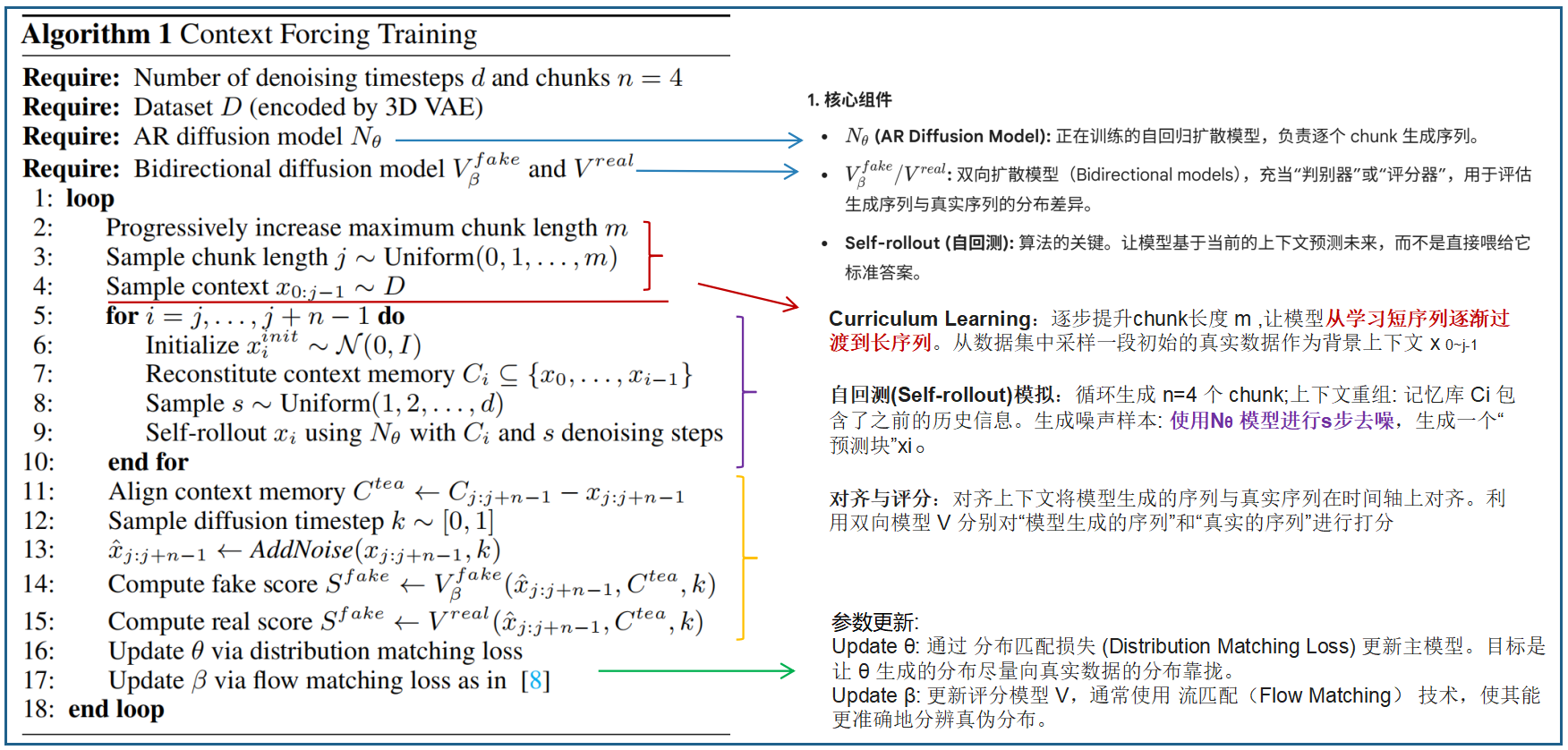

六、模型后训练 II:上下文强制蒸馏

本训练后阶段引入了上下文强制(context forcing)技术,这是一种蒸馏方法,可在保留前序阶段开发的记忆能力的同时实现实时性能。该方法解决了双向教师模型与自回归学生模型之间的分布不匹配问题,该问题曾阻碍记忆感知生成系统中有效的蒸馏过程。

1.分布匹配挑战

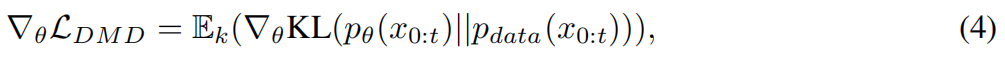

自回归世界模型在生成长视频时存在误差累积问题,且去噪过程较慢。近期研究[8,30,18,3]通过将双向扩散模型,精简为多步自回归学生模型来解决这些问题 。这些技术通过分布匹配损失[31],强制学生模型的分布 p θ ( x 0 : t ) p_θ(x_{0:t}) pθ(x0:t)与教师模型的分布对齐:

其中梯度可近似为由扩散模型导出的分数差。

然而,这些标准的蒸馏方法在处理记忆感知模型时会遇到问题,这源于教师模型与学生模型在上下文分布上的差异 。 双向教师模型能够获取完整的上下文信息(包括过去和未来的帧),而自回归学生模型由于因果生成的要求,只能访问过去上下文。这种不匹配对记忆感知模型尤为棘手,因为学生模型依赖复杂的记忆机制。即便教师模型被增强记忆功能,其双向特性仍与学生模型的因果自回归过程存在本质差异。这意味着若没有精心设计的记忆上下文来弥合这一差距,记忆上下文的差异将导致条件分布 p ( x ∣ C ) p(x|C) p(x∣C)出现偏差,进而导致分布匹配失败。

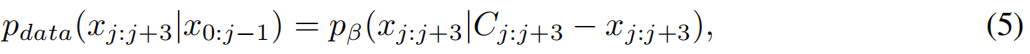

2.上下文强制

上下文强制方法如图7所示的,可缓解蒸馏过程中教师模型与学生模型之间的记忆上下文错位问题。针对学生模型,我们根据记忆上下文 p θ ( x j : j + 3 ∣ x 0 : j − 1 ) = ∏ i = j j + 3 p θ ( x i ∣ C i ) p_θ(x_{j:j+3}|x_{0:j−1})=\prod^{j+3}{i=j} p_θ(x_i|C_i) pθ(xj:j+3∣x0:j−1)=∏i=jj+3pθ(xi∣Ci)来 self-rollout 4个块。self-rollout在此可理解为因果推理。**为构建教师模型 V β V_β Vβ ,我们在标准双向扩散模型中引入记忆机制,并通过屏蔽学生记忆上下文中的 x j : j + 3 x{j:j+3} xj:j+3来构建其上下文**:

其中 C j : j + 3 C_{j:j+3} Cj:j+3表示与学生的 self-rollout x j : j + 3 x_{j:j+3} xj:j+3对应的全部上下文记忆块。通过将记忆上下文与学生模型对齐,我们强制教师模型所表示的分布尽可能接近学生模型,从而实现更有效的分布匹配。借助上下文强制机制,我们通过四步去噪步骤在实时生成中保持长期一致性,并有效抑制误差累积。该上下文强制方法消除了在将双向教师模型蒸馏为具有不同上下文信息访问模式的自回归学生模型时通常出现的分布不匹配问题。

七、模型推理:Play with the World

1.加速与工程优化

虽然我们的蒸馏机制大幅减少了高质量生成所需的去噪步骤,但要实现实时流式交互仍需额外优化。

DiT与 VAE 的混合并行方法。为充分利用现代多GPU架构,我们在8个GPU上同时实现了DiT主干网络和 VAE 解码器的序列并行计算。与传统并行方法(通过复制整个模型或在时间维度上调整序列并行)不同,我们的方法创新性地结合了序列并行与注意力并行,将每个数据chunk的token分配到不同设备上。这种设计确保了生成每个数据块的计算任务均衡分布,显著缩短了单个数据块的推理时间,同时保持了生成质量。

流式部署与渐进式解码技术 。为缩短首帧加载时间并实现无缝交互,我们采用基于 NVIDIA Triton推理框架的流式部署架构 。不同于传统等待完整数据块生成解码的方案,我们创新性地采用渐进式多阶段 VAE 解码策略,通过分批处理实现帧的即时传输。当生成DiT模型的潜在表征后,系统会逐步解码帧并立即传输至客户端,让用户在后续帧处理期间即可观看生成内容。这种流式处理流程通过异步处理与帧缓冲技术,将帧生成与传输解耦,确保即使在计算负载波动时仍能保持流畅的低延迟交互体验。

量化技术与高效注意力机制 。为在保持生成质量的同时进一步加速推理,我们采用了一套完整的量化策略组合。具体而言,我们通过混合精度运算,采用Sage注意力机制 [34]优化注意力计算,对模型权重和激活值进行浮点量化以降低内存带宽需求 ,并对计算密集型线性层实施矩阵乘法量化。此外,我们为注意力模块采用KVcache机制,以消除自回归生成过程中的冗余计算。这些技术共同在保持视觉保真度的同时,有效降低了内存占用和计算成本,实验结果已验证该方案的可行性

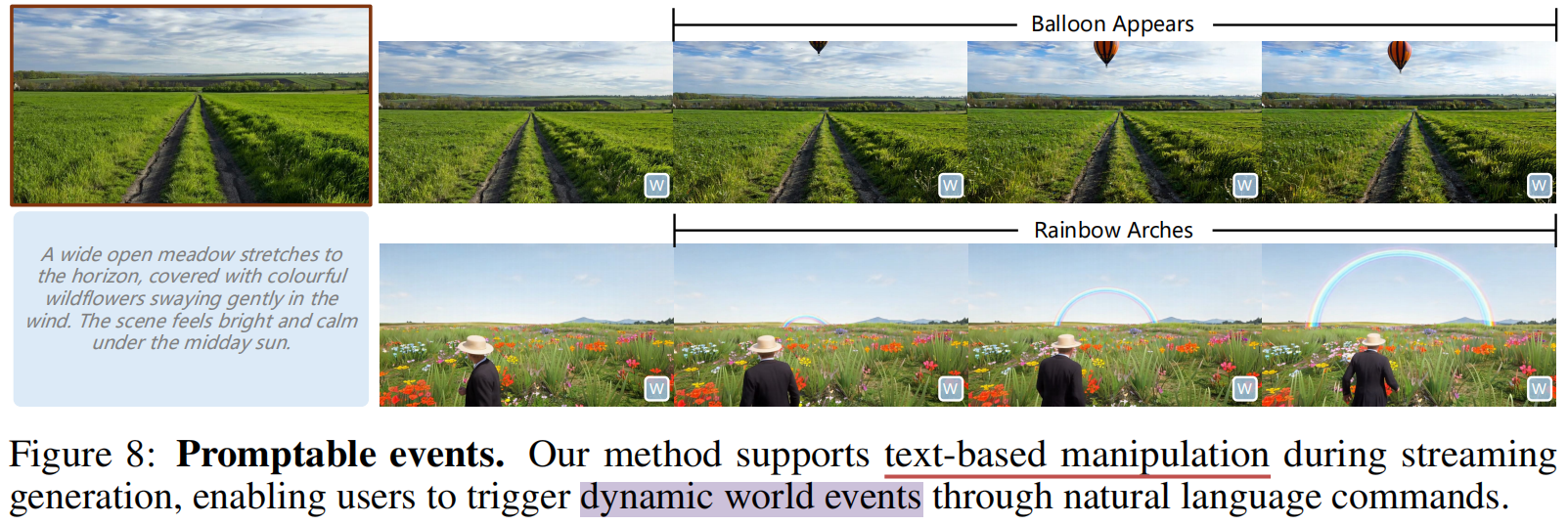

2.超越动作控制:基于文本的事件触发

HY-World 1.5不仅支持导航与探索功能,更具备动态文本事件生成能力,让用户在流式生成过程中实时操控虚拟世界。WorldPlay支持复杂的文本交互功能,可触发动态世界事件并实时修改生成流。这些可触发事件涵盖多种模拟场景:包括物体增减、环境变化(如天气、光照)、动态效果(如爆炸)以及角色行为(如NPC动作)。

如图8和图1(e)所示,用户可在生成过程中输入自然语言提示,从而动态调整叙事与视觉内容。该功能支持交互式叙事、虚拟环境操控及动态内容创作,使用户能通过自然语言界面探索并修改虚拟世界。

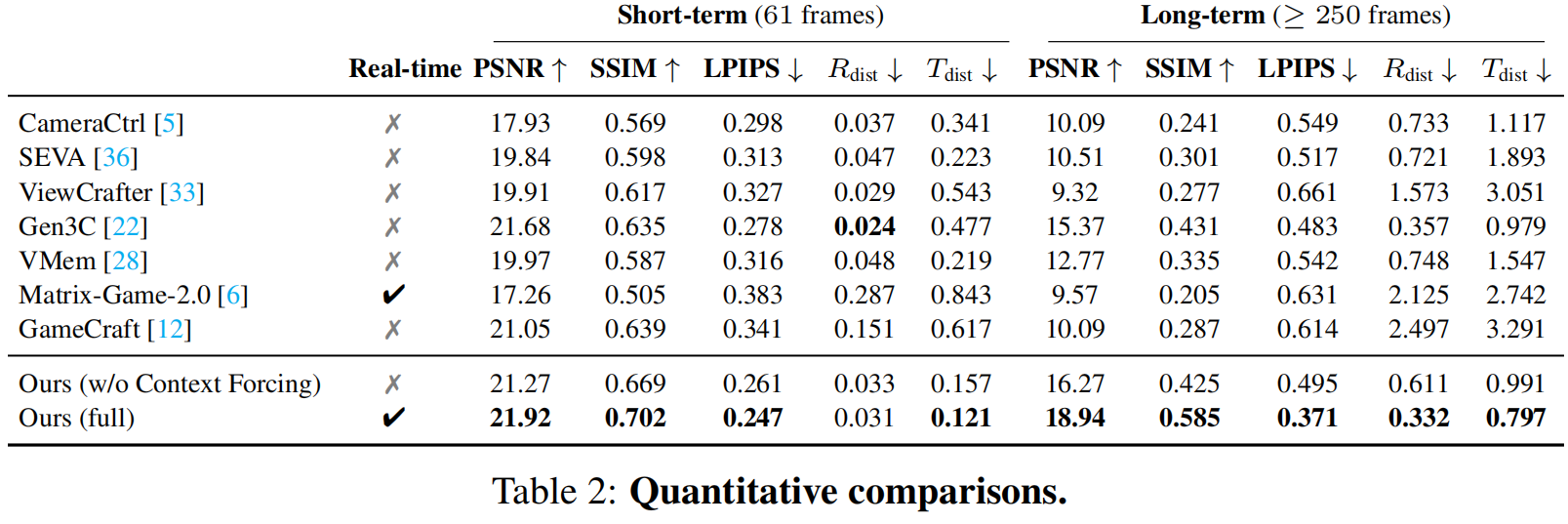

八、模型评估

估采用来自真实世界 视频、游戏录制 及AI生成图像的600个多样化测试案例,同时评估短期生成质量与长期几何一致性。

在短期评估中 ,以测试视频轨迹作为输入位姿,通过 LPIPS 、 PSNR 、 SSIM 等指标对比生成帧与真实值的视觉质量,同时采用Rdist和Tdist评估相机位姿精度。为确保长期一致性,我们设计了循环轨迹:模型沿路径生成帧后返回原路,通过对比返回路径帧与初始路径帧来强制重访。该方法直接测量了重访位置时的几何一致性,这对交互体验至关重要。

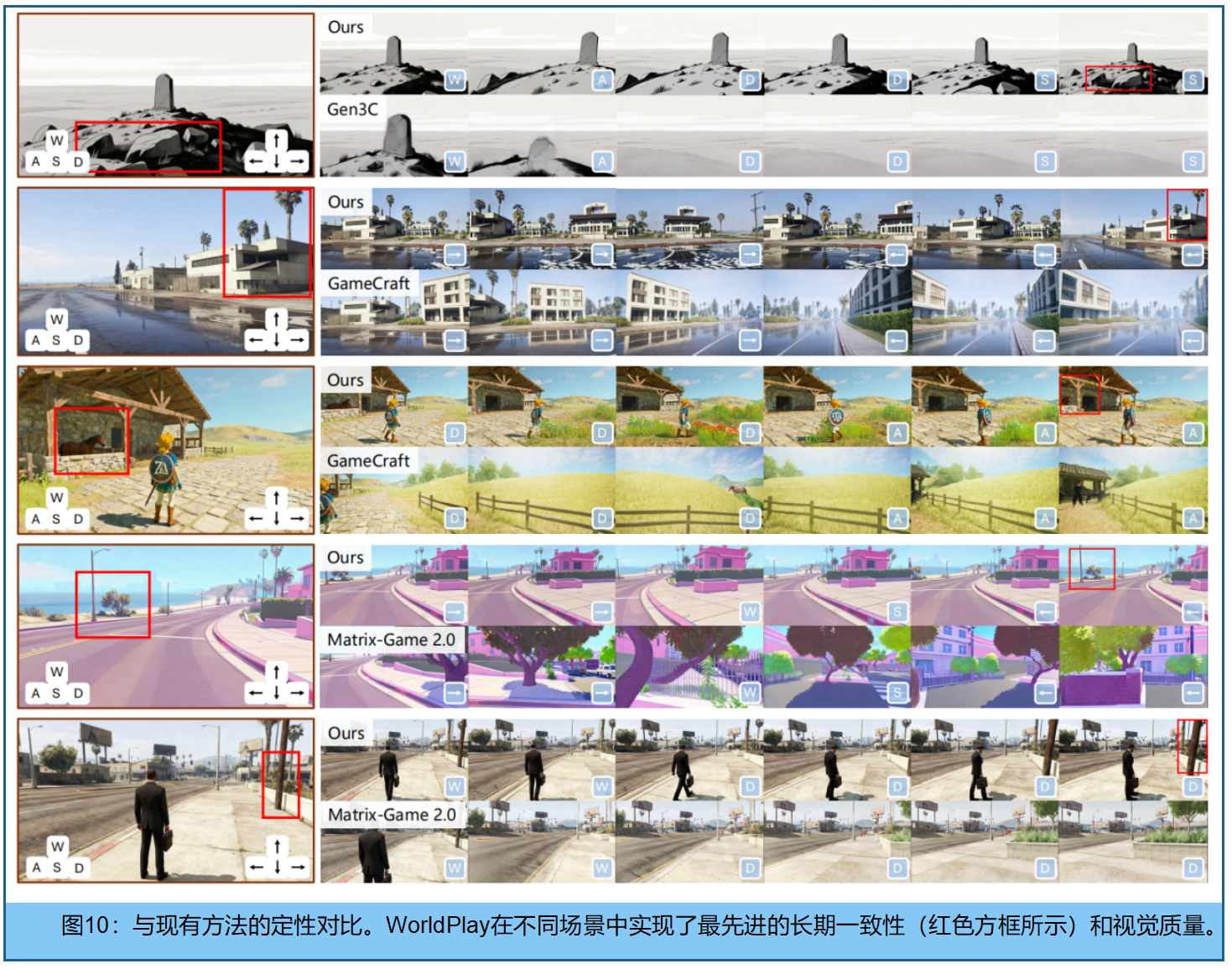

我们与两个基准组进行对比:

- (1)无记忆机制的动作控制扩散模型:CameraCtrl[5]、 SEVA [36]、ViewCrafter[33]、Matrix-Game2.0[6]、GameCraft[12];

- (2)带记忆机制的模型:Gen3C[22]、VMem[14]

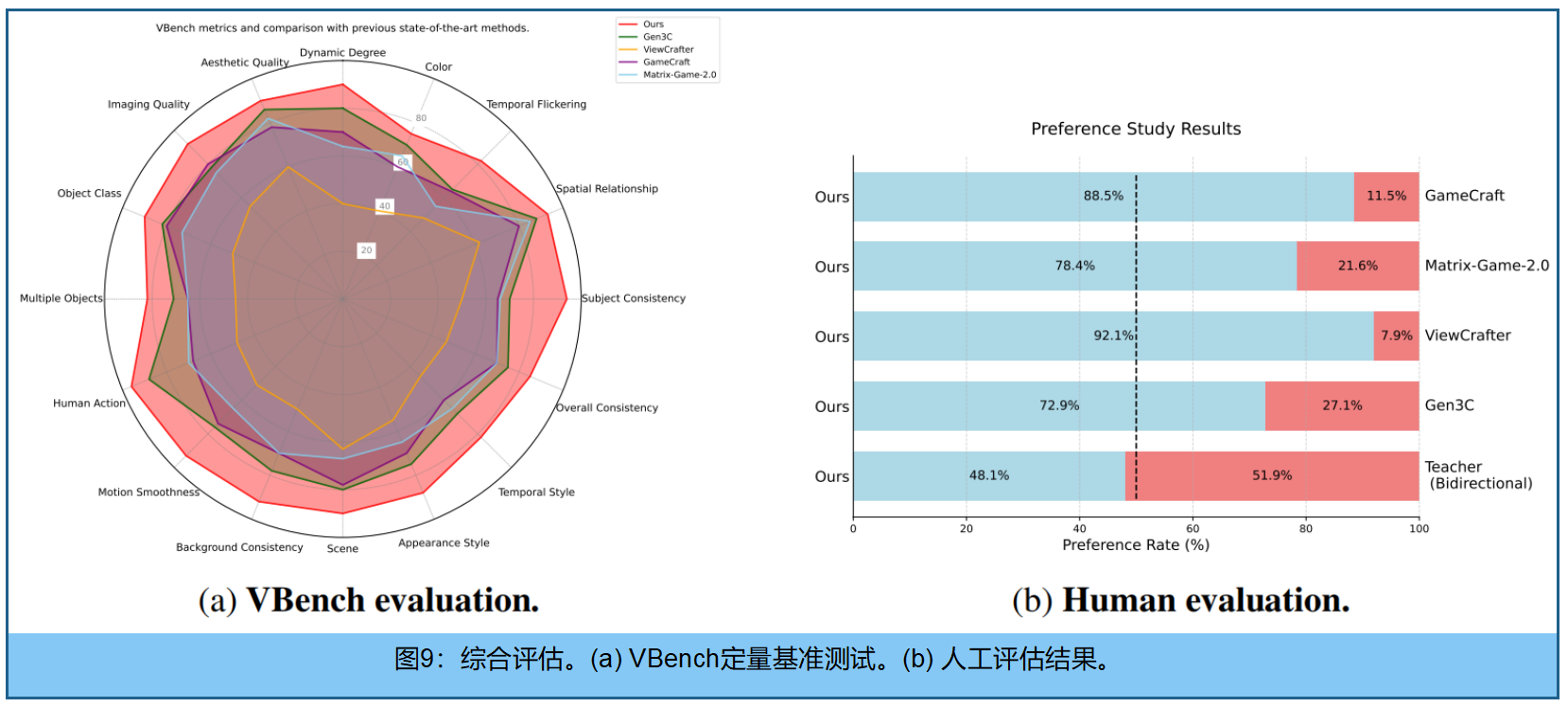

定量性能分析。表2显示WorldPlay在短期生成质量和长期几何一致性方面均表现出色。在短期模式下,我们的方法在保持视觉保真度的同时,控制精度也具有竞争力。然而在长期场景中,由于误差累积导致控制精度较基线方法显著下降,两者差距逐渐扩大。WorldPlay始终保持优异的稳定性,而其他方法则出现明显性能退化。图9a进一步展示了VBench测试结果,图9b则呈现了人工评估数据。

三维场景重建的应用:

动态事件操控 vs 视频连续播放的应用:

#pic_center =80%x80%

d \sqrt{d} d 1 8 \frac {1}{8} 81 x ˉ \bar{x} xˉ D ^ \hat{D} D^ I ~ \tilde{I} I~ ϵ \epsilon ϵ

ϕ \phi ϕ ∏ \prod ∏ a b c \sqrt{abc} abc ∑ a b c \sum{abc} ∑abc

/ $$ E \mathcal{E} E