这是一个展示 AI 技术演进层级的重要问题。

简单来说:深度学习 (DL) 是"技术底座",大语言模型 (LLM) 是基于这个底座造出来的"超级工程"。

-

关系:包含关系。AI > 机器学习 > 深度学习 > 大语言模型。

-

比喻:

-

深度学习是**"内燃机技术"**(一种核心动力原理)。

-

LLM 是**"波音 747"**(使用内燃机技术制造的、极其复杂且巨大的特定载具)。

-

以下是详细维度的解析:

1. 原理上如何理解:通用 vs. 专用

-

深度学习 (Deep Learning, DL):

-

原理 :它是一套方法论。核心是利用多层神经网络(DNN, CNN, RNN 等)来模拟人脑学习。它不限制处理什么数据,可以是图片、声音、股市数据,也可以是文本。

-

关键点:它强调"深"(层数多),通过反向传播算法更新参数。

-

-

大语言模型 (LLM):

-

原理 :它是深度学习在文本领域 的巅峰应用。它特指基于 Transformer 架构、参数量巨大(数十亿到万亿级)、使用海量文本训练的模型。

-

关键点:它基于"自回归"原理(预测下一个字),通过海量参数产生了"涌现"能力(原本没教它的逻辑推理能力突然出现了)。

-

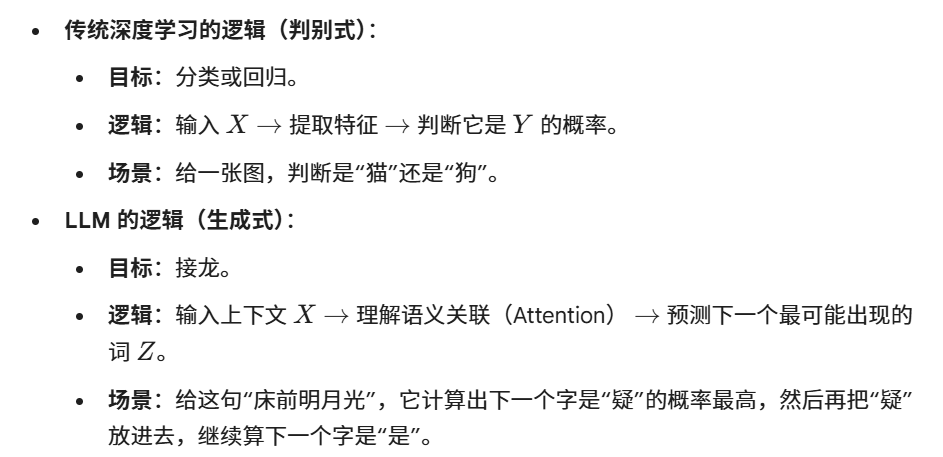

2. 逻辑上如何理解:识别 vs. 生成

3. 举例数值计算说明

让我们看看它们在计算输出时的核心区别。

4. 有什么意义?

-

从"专用"到"通用":

-

以前的深度学习模型,下围棋的只会下围棋(AlphaGo),识图的只会识图。

-

LLM 证明了,只要模型够大、书读得够多,一个模型可以同时通过律师考试、写代码、写诗、做翻译。这是 AI 迈向 AGI(通用人工智能)的关键一步。

-

-

人机交互的革命:

-

深度学习时代,人适应机器(即使是 Siri,你也得用特定的命令词)。

-

LLM 时代,机器适应人(你可以用自然语言命令它做任何事)。

-

5. 作用是什么?

在现代 AI 应用开发流程中,它们的位置发生了变化。

传统开发模式 (深度学习时代)

你需要自己从头造轮子。

-

数据:收集几万张图。

-

DL 算法:选择 ResNet 或 VGG 网络结构。

-

训练:用 GPU 跑几天,得到一个模型。

-

作用 :DL 是你手中的工具,你用来从头训练一个模型。

大模型开发模式 (LLM 时代)

你站在巨人的肩膀上。

-

基座模型:直接下载开源的 LLM(如 Llama, DeepSeek)或调用 API(GPT-4)。这些是已经用数万张 GPU 训练好的"半成品"。

-

微调/提示词工程:

-

你不需要从头训练 DL 网络。

-

你只需要写 Prompt(提示词)或者用少量数据微调(SFT)。

-

-

作用 :LLM 是你的"基础设施" 。DL 技术隐藏在底层框架(如 PyTorch)中,你更多是在应用 LLM 的能力,而不是设计 DL 网络结构。

总结: 如果把 AI 开发比作盖房子:

-

深度学习 是钢筋混凝土技术。

-

LLM 是一栋已经盖好的摩天大楼。

-

现在你不需要自己去浇筑混凝土(设计层数、激活函数),你只需要入住这栋大楼,搞搞装修(微调)就可以使用了。