模型架构:GCN-TCN-Transformer 回归模型

-

GCN 模块:深度空间特征提取与交互

该模型首先引入图卷积网络(GCN),将输入特征之间的潜在关系建模为图结构,利用邻接矩阵定义特征节点的连接强度。通过多层图卷积操作,每个特征节点动态聚合其邻居节点的信息,生成富含局部上下文的高维嵌入表示。这一过程使模型能够捕捉特征间深层的、非线性的空间依赖模式,超越传统方法对特征独立处理的局限,显著提升对复杂结构数据的表征能力。

-

TCN 模块:高效局部时序建模与特征演化捕捉

经 GCN 提取的空间特征沿时间维度形成序列,并输入至时序卷积网络(TCN)模块。TCN 采用因果卷积与膨胀卷积(Dilated Convolutions)相结合的设计,在保持时序因果性的前提下,高效捕捉时间序列中的局部依赖与短期动态模式。其并行计算架构使训练速度优于循环神经网络(RNN),同时通过堆叠膨胀卷积层逐步扩大感受野,以较少参数覆盖较长时间区间,有效缓解梯度消失问题,强化对近期演变规律的建模能力。

-

Transformer 模块:全局长程时序依赖融合

为进一步捕捉时间序列中的长距离依赖,TCN 输出被送入 Transformer 编码器。借助其核心的自注意力(Self-Attention)机制,模型能够在每个时间步同时评估并整合全序列所有位置的信息,从而识别跨远距离的时序关联与全局模式。该模块弥补了 TCN 在超长序列上感受野有限的不足,实现从局部到全局的多尺度时间特征融合。最终,GCN、TCN 与 Transformer 三者协同,形成"空间 -- 局部时间 -- 全局时间" 三重维度的高效建模体系。

系统功能流程

- 数据处理与加载

支持常见表格数据格式(CSV / Excel),具备灵活的数据接口;

内置数据标准化与归一化模块,确保输入尺度一致,提升训练稳定性;

支持时序-图结构数据的构建与批加载,适配模型输入需求。

- 模型训练与对比

完成 GCN-TCN-Transformer 混合模型的端到端训练;

可选择与基线模型(如纯 TCN、LSTM、GRU 等)进行性能对比;

提供训练过程监控与检查点保存,便于调优与回溯。

- 性能评估与可视化

指标输出:回归任务核心评价指标,包括 MAE(平均绝对误差)、MSE(均方误差)、RMSE(均方根误差)与 R² 分数;

结果对比:生成训练集与测试集性能对比表格,直观反映模型泛化能力;

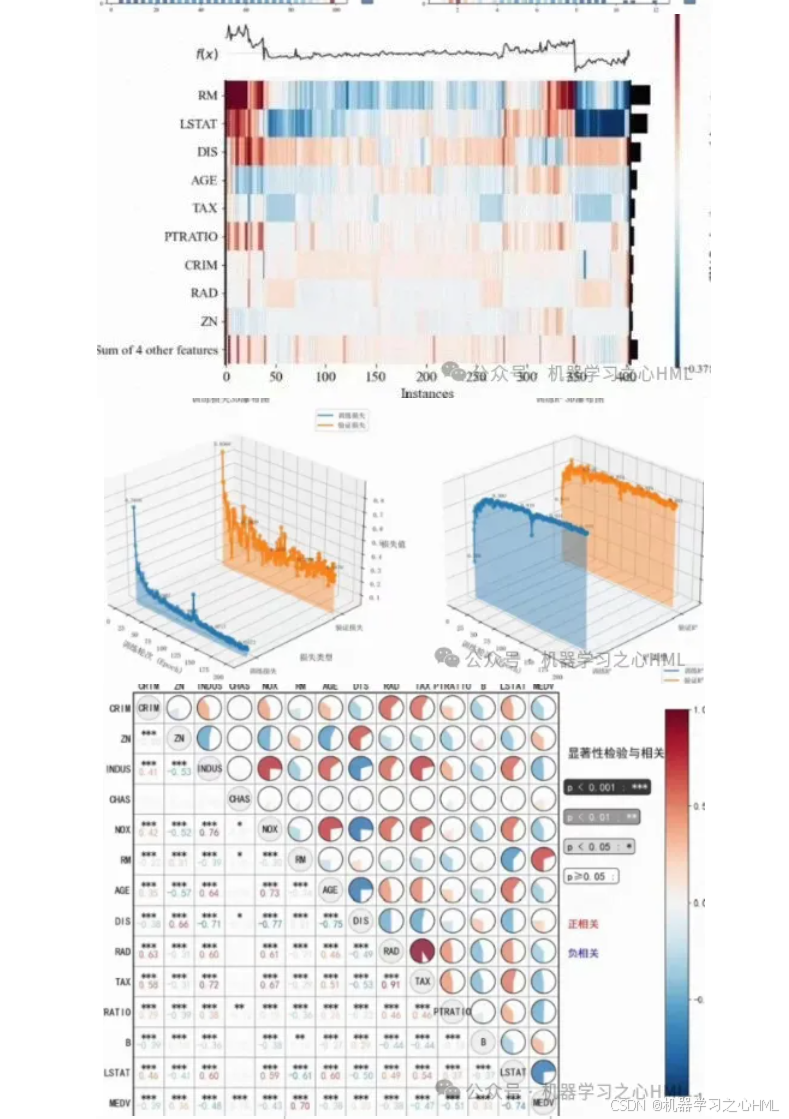

可视化分析:

训练损失与验证损失曲线对比图,追踪模型收敛过程;

预测值与真实值散点图(配合理想拟合线),评估预测一致性及系统偏差。

- SHAP 可解释性分析

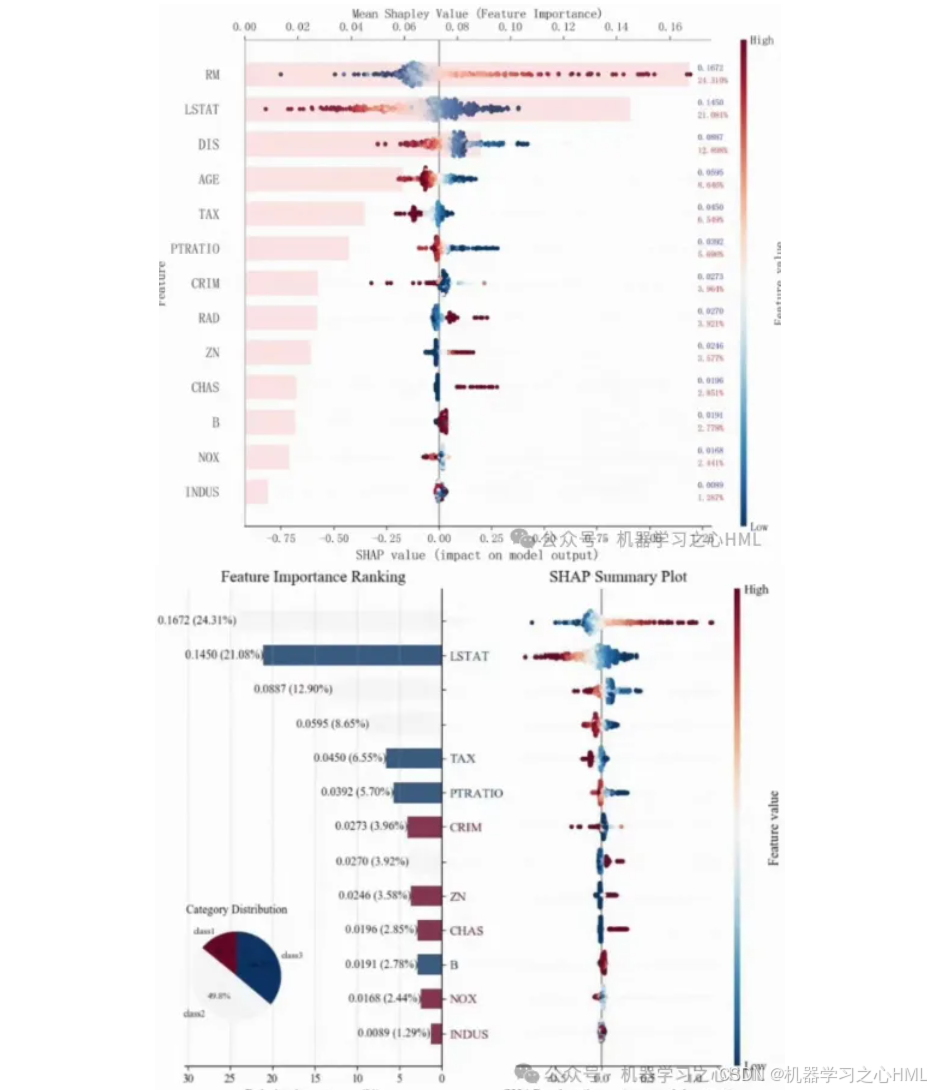

全局解释:

特征重要性条形图:基于 SHAP 值量化各特征对预测结果的平均影响幅度与方向(正/负贡献);

SHAP 蜂巢图(Beeswarm Plot):展示特征取值与 SHAP 值之间的分布关系,揭示特征-目标之间可能存在的非线性关联与边际效应变化。

局部解释:

支持对任意单一样本的预测结果进行归因分析,通过力导向图或条形图展示各特征对该特定预测的贡献度,提升模型决策透明度。

方案优势

建模全面:融合空间图结构、局部时序与全局时序依赖,适用于具有复杂时空关联的回归任务;

解释性强:借助 SHAP 提供全局与局部双重解释,增强模型可信度与调试依据;

端到端实现:覆盖从数据预处理、模型训练、评估到解释分析的全流程,提供完整可复现的预测分析解决方案。