我整理好的1000+面试题,请看

大模型面试题总结-CSDN博客

或者

https://gitee.com/lilitom/ai_interview_questions/blob/master/README.md

最好将URL复制到浏览器中打开,不然可能无法直接打开

好了,我们今天针对上面的问题,

1B的模型和1T的数据大概要训练多久?

首先明确下1B=10亿,1T=1万亿,预训练的时间和模型、数据、算力以及其它开销有关系,有这么一个公式,计算出训练时间和上述参数的关系:

训练时间=8 * token数 * 参数量/(GPU数量 * GPU的flops * GPU利用率)

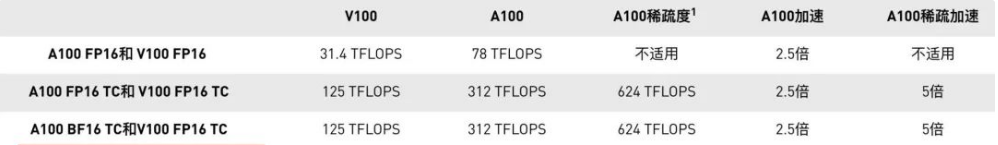

其中对于不同的GPU其flops是不同的,一般情况下GPU的利用率在0.3-0.55之间。

那么对于1B的模型和1T的数据,假设1个GPU,大概的耗时为:

耗时= 8 * 10^9 * 1T / (1 * 300T * 0.3 ) = 1028天

上述的1T是1万亿的数据,300T是300TFLOPS,就是GPU每秒算300万亿次,这个8是怎么来的呢,因为对于每个token,每个模型参数,需要进行2次浮点运算,我们整体包括前向+后向+重激活整体是1+2+1=4,那么整体上就是8次了。