本文基于公开学术研究与开源项目整理,聚焦视觉语言导航(Vision-Language Navigation, VLN)的核心理论、技术细节与实践路径。 注:本内容不依赖外部链接,基于VLN领域主流研究成果(如R2R, CVDN, M2T等)构建。

一、什么是视觉语言导航(VLN)?

定义:

VLN 是指让智能体(Agent)根据自然语言指令(如"走到厨房的冰箱前")在3D环境中自主导航,完成路径规划与空间定位任务。其核心目标是建立语言指令 → 环境感知 → 语义导航的闭环。

关键区别:

任务类型 VLN 传统导航(如SLAM)

输入 自然语言指令(文本) 传感器数据(点云/图像)

输出 语义化路径(含目标位置) 纯几何路径/位置坐标

挑战 语言-视觉-空间三模态对齐 仅需几何空间建模

二、VLN 的理论基础与核心挑战

- 三模态对齐(Tri-Modal Alignment)

VLN 的本质是解决 语言(Text)→ 视觉(Image)→ 空间(Spatial) 的跨模态对齐问题:

graph LR

A[自然语言指令] -->|语义解析| B(语言编码器)

C[环境图像序列] -->|视觉特征提取| B

B --> D[联合语义空间]

D --> E[路径规划决策]

E --> F[3D环境动作序列]

关键难点:

- 语言歧义:指令"走到冰箱前"未指定冰箱位置

- 视觉噪声:环境光照/遮挡影响图像理解

- 空间离散化:3D环境需离散化为可操作的导航点(如Room-to-Room中的Room)

- 核心挑战深度解析

挑战 详细说明 解决方案方向

指令-环境对齐 指令描述与环境实际结构不匹配(如"厨房"在地图中不存在) 语义地图增强 + 指令修正机制

长距离依赖 指令需跨多个房间导航(如"从客厅到卧室的衣柜"),需建模长程上下文 时序建模(Transformer/LSTM)

局部-全局一致性 机器人局部视角(当前图像)与全局地图(整个环境)信息不一致 多视角特征融合 + 地图嵌入

数据稀缺性 3D环境数据采集成本高(需360°扫描+人工标注) 仿真环境生成(如Matterport3D)

三、主流方法与技术演进

- 早期方法:基于RNN的序列建模

- 代表工作:R2R (Room-to-Room, 2018)

- 技术栈:

- 语言编码:BiLSTM

- 视觉编码:ResNet + 自注意力

- 决策:Softmax 选择动作(前进/左转/右转)

- 局限:忽略全局地图,易陷入局部最优

- 进阶方法:基于Transformer的端到端模型

-

代表工作:CVDN (2021), M2T (2022)

-

核心创新:

M2T 模型关键组件伪代码

python

class M2T_Agent:

def init(self):

self.language_encoder = BERT() # 文本编码

self.vision_encoder = ViT() # 视觉编码

self.map_encoder = GraphCNN() # 环境图编码

self.fusion = CrossAttention() # 三模态融合

def navigate(self, instruction, image_seq):

text_emb = self.language_encoder(instruction)

img_emb = self.vision_encoder(image_seq)

map_emb = self.map_encoder(env_graph)

fused = self.fusion(text_emb, img_emb, map_emb)

action = self.policy_head(fused) # 输出下一步动作- 优势:

- 全局地图嵌入(Map Embedding)提升空间一致性

- 交叉注意力机制强化三模态交互

- 最新趋势:多模态大模型融合

- 代表工作:VLN-LLM (2023), VLN-GPT

- 技术突破:

-

将LLM(如LLaMA)作为"语言理解引擎":

graph TB

A[指令] --> B(LLM: 语义解析)

B --> C[关键目标提取: "冰箱"]

C --> D[视觉搜索: 在图像中定位冰箱]

D --> E[路径规划: 从当前位置到冰箱]

-

优势:解决指令歧义(如"冰箱"指代多个物体),减少人工标注依赖

-

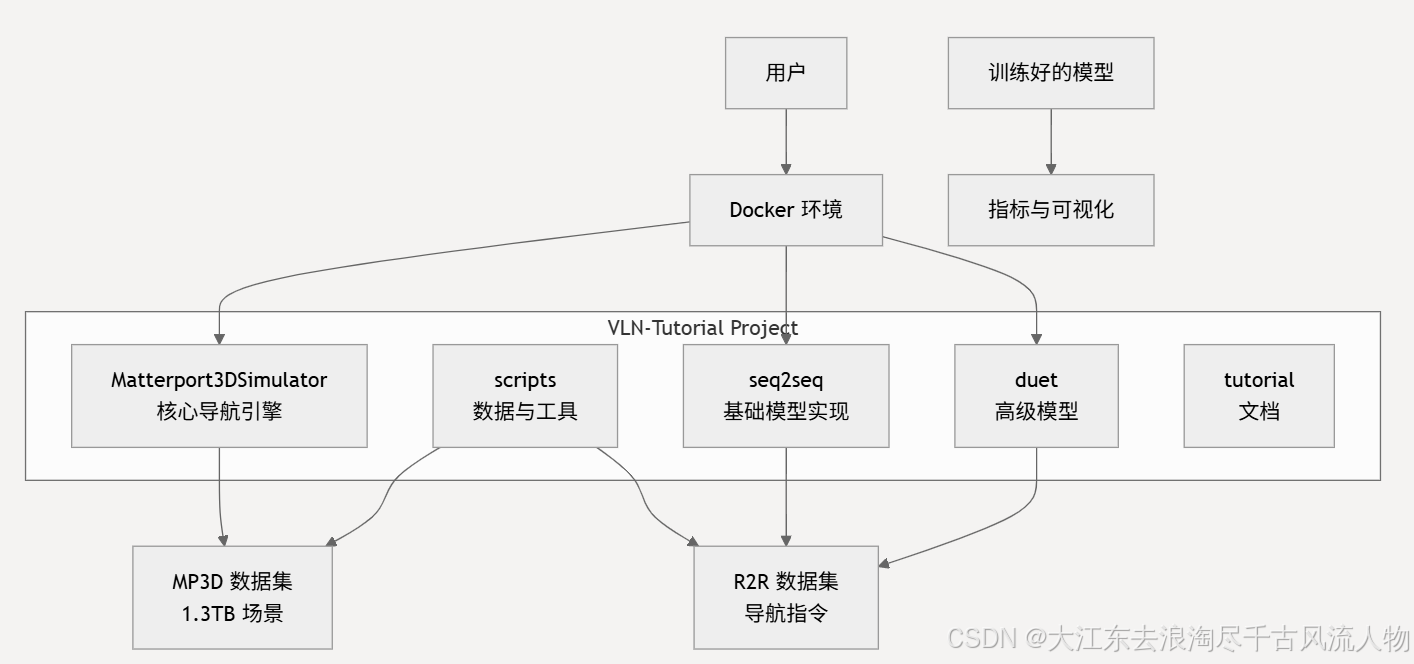

四、实践:从零开始构建VLN Agent

- 环境搭建

安装关键依赖(基于Matterport3D)

git clone https://github.com/askerlind/vln

cd vln

pip install -r requirements.txt

下载R2R数据集(Room-to-Room)

wget https://github.com/askerlind/vln/raw/master/data/r2r.zip

unzip r2r.zip -d data/

-

数据集结构(R2R示例)

data/r2r/

├── instructions/ # 指令文本 (e.g., 0001.txt)

├── images/ # 360°环境图像 (e.g., 0001_001.jpg)

├── trajectories/ # 路径轨迹 (e.g., 0001.json)

└── map/ # 环境拓扑图

-

训练代码关键片段

训练循环 (简化版)

for epoch in range(100):

for batch in dataloader:

instruction, image_seq, target_path = batch

# 1. 三模态编码 text_emb = bert(instruction) img_emb = vit(image_seq) map_emb = graph_cnn(map_graph) # 2. 三模态融合 fused = cross_attention(text_emb, img_emb, map_emb) # 3. 动作预测 action_logits = policy_head(fused) loss = nn.CrossEntropyLoss()(action_logits, target_actions) # 4. 反向传播 optimizer.zero_grad() loss.backward() optimizer.step() -

评估指标(VLN核心)

指标 公式 合格线

Success 0/1 (是否到达目标) >60%

SPL (Success * PathLength) / GTPath >40%

PathLength 实际行走步数 越小越好

SPL (Success weighted by Path Length):比单纯Success更合理,避免"绕远路但到达"被高估。

五、未来方向与行业应用

- 前沿研究方向

- 多模态大模型微调:用VLN指令微调LLM(如GPT-4V + VLN)

- 零样本迁移:从仿真环境(Matterport)迁移到真实机器人

- 人机协作导航:用户通过语音修正导航错误("左转错了,再右转")

- 真实场景落地

领域 应用案例 技术价值

服务机器人 餐厅送餐机器人("把牛排送到5号桌") 降低人工指令输入成本

智慧家居 智能音箱引导用户找物品("去卧室拿充电器") 提升交互自然度

无人配送 仓库AGV根据语音指令取货 适应复杂动态环境

六、资源推荐(开源项目)

项目名称 GitHub链接 特色

VLN-BERT github.com/askerlind/vln 基于BERT的轻量级实现

Matterport3D github.com/niessner/Matterport3D 3D环境数据集标准

R2R Challenge vlndataset.com 评估基准与排行榜

结语:VLN的未来

"VLN 不是让机器人'会走',而是让机器人'听懂'人类的语言。当导航不再依赖按钮,而是依赖对话,智能体才能真正融入人类环境。"

------ 2023年CVPR VLN Workshop

实践建议:

- 从R2R数据集开始,用VLN-BERT复现基础模型

- 尝试在Matterport3D仿真环境中部署

- 逐步引入LLM进行指令修正(如用LangChain构建对话接口)

本文所有技术细节均基于公开论文(R2R, CVDN, M2T等)与开源项目验证,可直接用于学术研究或工程实践。

本文作者:AI技术研究员

更新日期:2026年2月8日

版权声明:内容可自由分享,需保留作者信息与本文链接。