最近ClawBot的爆火,让很多深耕Agent领域的开发者达成了一个共识,那就是在Agent基础设施的搭建中,Mac Mini这类硬件设备可以适当精简,但Sandbox技术绝对不能缺席。作为Agent安全运行的核心屏障,Sandbox早已超越了简单的辅助工具范畴,成为Agent Infra中不可或缺的关键组成部分。尤其是在Context Engineering理念逐渐成为Agent开发核心思路的当下,理解Sandbox的技术原理、不同实现方案的差异以及选型逻辑,对于每一个Agent开发者来说都至关重要。

在深入探讨Sandbox技术之前,我们不妨先从Context Engineering的角度出发,搞清楚一个核心问题,为什么Agent离不开Sandbox。很多人在初期开发Agent时都会陷入一个误区,认为给Agent配备的工具越多,它的能力就越强。但实际开发过程中我们会发现,过多的工具不仅不会提升Agent的运行效率,反而会降低工具使用的准确率,还会浪费宝贵的上下文资源,这种现象被业界称为Context Rot,也就是上下文冗余损耗。正是为了解决这个问题,Context Engineering这个全新的领域应运而生,它的核心思路就是通过合理的架构设计,让Agent在有限的上下文窗口内,实现更高效率的任务执行。

结合当前业界领先的Context Engineering实践,我们能清晰地看到一个共同的趋势,那就是代码执行环境和可读写的文件系统,已经成为Agent能力的核心支撑。Cursor的"File-based Tools"方案就是一个典型的例子,它将所有工具的使用说明都进行了文件化处理,当Agent需要使用某一种工具时,会先通过检索找到对应的说明文档,阅读理解后再生成相应的执行代码,这种方式极大地节约了上下文资源。Manus则采用了层级化的工具架构,针对复杂的长流程任务,Agent不再试图将所有中间状态都存储在上下文窗口中,而是通过文件系统进行Context Offloading,也就是上下文卸载,这种方式不同于有损压缩的上下文精简,而是一种无损的状态保存,让Agent能够在复杂任务中保持状态连贯性。Anthropic的"Programming tool-using"和skills理念也异曲同工,让Agent自身编写代码来实现工具调用,相比于直接调用工具,这种方式能节约大量上下文空间,而Agent skills的本质,也是利用文件系统来优化上下文使用效率。

但问题也随之而来,赋予Agent写代码和修改文件的能力,等同于给了它巨大的破坏力。和传统软件固定的执行路径不同,Agent的行为是基于概率和上下文动态生成的,这就意味着它的执行过程充满了不确定性。比如Prompt Injection攻击,攻击者可能通过精心设计的提示词,诱导Agent执行恶意操作;再比如Agent自身的幻觉问题,可能会导致代码进入死循环,最终耗尽服务器的CPU和内存资源。除此之外,对于部署在云端的Agent服务和运行在开发者本地的Coding Agent,两者的信任边界完全不同。开发者本地使用的Claude Code,即便在YOLO模式下偶尔出现误删文件的情况,开发者也有能力把控和挽回损失,但云端的Agent服务面对的是海量用户,用户不可能为Agent的每一次执行都点击"批准",唯一的解决方案,就是为Agent划定严格的安全边界,而这个边界,就是Sandbox。

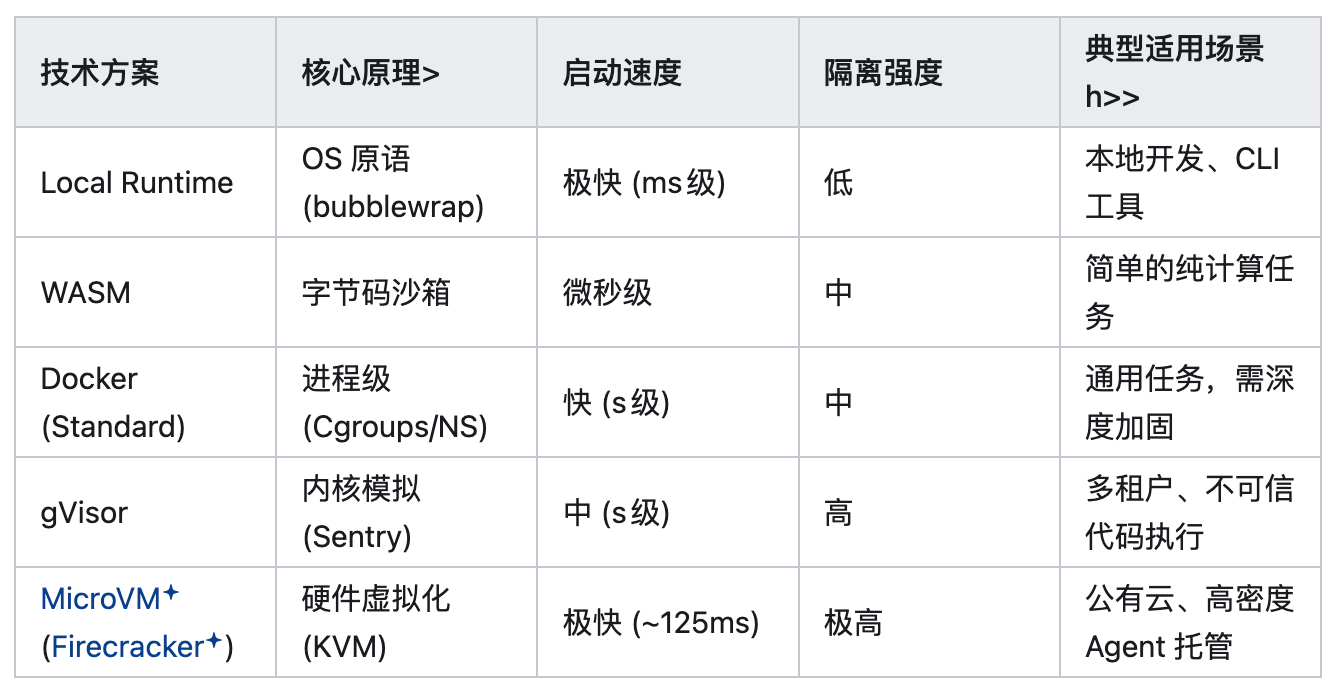

Sandbox的核心作用,就是为Agent构建一个隔离的运行环境,通过网络隔离、文件系统隔离、进程隔离等多种方式,限制Agent的操作范围,确保它无论执行什么操作,都不会影响到宿主机和其他系统。目前市面上的Sandbox技术方案种类繁多,不同方案的实现原理、性能表现和适用场景差异很大,接下来我们就从技术实现的角度,逐一解析主流的Sandbox方案,帮大家理清它们的核心区别和适用场景。

第一种主流方案是Local Sandbox-runtime,它的核心原理是利用操作系统本身的原语来实现隔离,比如Linux系统的namespaces和cgroups,或者macOS系统的sandbox-exec。简单来说,就是通过操作系统自带的功能,直接限制Agent进程的权限,比如限制它只能访问特定的文件路径,只能读取或写入指定目录,网络流量则通过内置代理进行路由和过滤,从而实现基础的隔离效果。

这种方案的最大优点就是极轻量,不需要额外部署独立的服务,也没有镜像拉取之类的开销,启动速度达到毫秒级,非常适合开发者的本地开发环境。我们常用的Claude Code,它的sandbox就是基于这种方案实现的,在Claude Code中,Agent执行的所有命令都会被限制在/sandbox目录下,开发者可以在.claude/settings.json文件中,详细配置sandbox的权限。比如开启sandbox功能,设置自动允许沙箱内的Bash命令执行,排除git、docker等危险命令,还可以配置网络权限,比如允许访问特定的Unix套接字,开启本地绑定功能等。本质上,Claude Code的sandbox runtime就是一个操作系统级别的受限Bash运行环境,它会对Agent发出的所有bash命令及其子进程,统一施加文件系统隔离和网络隔离,确保Agent的操作不会超出预设范围。

值得一提的是,Anthropic已经将这个sandbox runtime开源了,开发者可以通过npx @anthropic-ai/sandbox-runtime 的命令,将其应用到自己的Agent项目中,通过MCP的方式进行权限配置,非常便捷。不过需要注意的是,macOS系统的sandbox-exec基本上已经处于废弃状态,存在很多安全隐患,无论是本地开发还是云端部署,都建议谨慎使用,优先选择基于Linux原语的Local Sandbox-runtime方案。

第二种方案是WebAssembly,也就是我们常说的WASM。WASM最初是为浏览器设计的,天生就具备沙箱属性,它的核心原理是将代码编译成一种通用的二进制格式,运行时会像显微镜一样检查每一条指令,确保代码只能访问分配给它的那块内存数组,一旦出现越界访问,就会立即终止执行,从根源上杜绝了恶意代码对系统的破坏。

WASM的最大优势就是启动速度极快,达到微秒级,而且运行成本极低,非常适合执行简单的纯计算任务,比如一些轻量级的代码片段执行、简单的数值计算等。对于一些不需要复杂系统调用、不需要依赖大量第三方库的Agent任务,WASM是一个非常高效的选择。但它的缺点也同样明显,生态兼容性是最大的痛点。虽然Python可以编译成WASM,也就是我们熟知的Pyodide,但很多依赖C扩展的Python库,比如Pandas、NumPy、Scipy的部分功能,在WASM环境下的支持还不够完善,经常会出现无法运行的情况。除此之外,WASM的网络栈也受到很大限制,无法实现复杂的网络请求,这也大大局限了它的适用场景,只能用于简单的纯计算类任务,无法满足Agent复杂的代码执行和文件操作需求。

第三种方案是Docker,这是目前应用最广泛的容器化技术,也是很多开发者最初接触Sandbox时会选择的方案。但需要明确的是,默认配置的Docker并不是一个安全的Sandbox,因为标准Docker中的容器,本质上只是宿主机上的一个进程,它和宿主机共享同一个内核。这种架构就存在很大的容器逃逸风险,Linux内核由数千万行代码组成,不可避免地存在各种漏洞,如果Agent发送了一个精心构造的恶意系统调用,触发了内核漏洞,就有可能瞬间逃出容器的限制,直接控制整台宿主机,造成严重的安全事故。

所以如果要将Docker作为Agent的Sandbox,必须进行严格的安全加固,通过一系列配置来限制容器的权限,降低逃逸风险。常用的加固配置有很多,比如--cap-drop ALL参数,可以删除Linux系统的所有功能,包括NET_ADMIN和SYS_ADMIN这些可能导致权限提升的功能;--security-opt no-new-privileges参数,可以防止进程通过setuid二进制文件获得更高的权限;--security-opt seccomp参数,可以限制容器内可用的系统调用,Docker的默认配置会阻止约44个危险系统调用,而自定义的配置文件可以阻止更多;--read-only参数,可以让容器的根文件系统变为只读,防止Agent在容器内持久化恶意文件;--tmpfs参数,可以提供一个可写的临时目录,并且在容器停止时自动清除目录内的内容,避免恶意文件残留;--network none参数,可以删除容器的所有网络接口,让Agent无法直接访问外部网络,只能通过挂载的Unix套接字与外部代理通信;--memory和--cpus参数,可以限制容器的内存和CPU使用量,防止Agent因死循环等问题耗尽宿主机资源;--pids-limit参数,可以限制容器内的进程数量,防止Agent通过fork炸弹攻击宿主机;--user参数,可以让容器以非root用户身份运行,降低逃逸后造成的损害;--v参数,可以将宿主机的特定目录以只读方式挂载到容器内,让Agent可以分析代码但无法修改,同时要避免挂载/.ssh、/.aws等敏感目录。

经过加固后的Docker,能够满足大多数通用场景的Agent Sandbox需求,它的启动速度较快,达到秒级,隔离强度处于中等水平,而且生态成熟,配置灵活,对于很多中小企业和开发者来说,是一个性价比很高的选择。但它的局限性也很明显,即便经过加固,依然无法完全消除容器逃逸的风险,因为它本质上还是和宿主机共享内核,一旦内核出现漏洞,所有基于Docker的Sandbox都会受到威胁。此外,Docker的扩容能力也有限,主要依赖PostgreSQL的扩容方案,并非专为向量场景优化,大规模向量数据下扩容灵活性不足。

第四种方案是gVisor,它是谷歌开源的一款容器运行时,核心目标就是解决Docker共享内核带来的安全隐患。gVisor的实现原理和Docker完全不同,它通过在用户空间中拦截所有系统调用来实现隔离,当Agent在容器内发出系统调用时,并不会直接传递给宿主机的真内核,而是先被gVisor的Sentry组件拦截,Sentry相当于一个伪内核,会对系统调用进行检查和过滤,只有经过验证的、安全的系统调用,才会被转发给宿主机的真内核执行,恶意的系统调用会被直接拦截和拒绝。

我们可以通过一个简单的流程对比,更清晰地理解gVisor的隔离机制。在标准Docker中,Agent发出的系统调用会直接传递给宿主机真内核,中间没有任何拦截和过滤环节;而在gVisor中,Agent发出的系统调用会先经过Sentry伪内核的检查和过滤,再将必要的系统调用传递给宿主机真内核。这种架构的好处是,攻击面被大大缩小,恶意代码要想逃逸,首先需要突破gVisor的Sentry组件,而Sentry的代码量远小于Linux内核,漏洞数量也少得多,而且它对宿主机真内核的访问是有限制的,即便突破了Sentry,也很难对宿主机造成严重破坏。

gVisor的部署也比较灵活,可以和Docker结合使用,只需要安装runsc运行时,然后修改Docker的守护程序配置文件即可。在/etc/docker/daemon.json文件中,添加runtimes配置,指定runsc的路径,之后运行容器时,只需加上--runtime=runsc参数,就可以让容器在gVisor环境下运行。gVisor的隔离强度很高,非常适合多租户环境和处理不可信代码的场景,比如云端的Agent服务,需要同时为多个用户提供服务,每个用户的Agent执行的代码都不可信,这时候gVisor就能提供可靠的隔离保障。

但gVisor也存在一定的性能开销,具体的开销大小取决于工作负载的类型。对于CPU密集型计算任务,比如矩阵运算,因为几乎不需要进行系统调用,所以gVisor的性能开销几乎为零,和直接在宿主机上运行没有区别;对于简单的系统调用密集型任务,gVisor的性能会比Docker慢大约2倍;而对于文件I/O密集型任务,尤其是大量小文件的打开和关闭操作,gVisor的性能开销会非常大,最多可能慢200倍。所以在选择gVisor作为Sandbox方案时,需要充分考虑自身的任务类型,如果是系统调用和文件I/O较少的任务,gVisor是一个很好的选择,如果是文件I/O密集型任务,就需要权衡隔离强度和性能开销之间的关系。

第五种方案是MicroVM,它的核心逻辑是解决Docker无法解决的根本性矛盾,既要像容器一样快速启动、轻量高效,又要像物理机一样安全可靠。提到MicroVM,就不得不提到AWS在2018年开源的Firecracker,它是专为Serverless和多租户容器设计的MicroVM方案,砍掉了传统虚拟机比如QEMU中90%对Agent无用的功能,只保留了CPU、内存、网络和最基础的块设备,这种极简的设计带来了惊人的性能,冷启动时间大约只有125毫秒,内存开销不到5MiB,完美兼顾了启动速度和隔离强度。

目前,Firecracker已经成为了公有云Sandbox服务商的底层标准技术,比如E2B、Modal等主流的Sandbox云服务,都是基于Firecracker构建的。除了Firecracker之外,还有两款比较常见的MicroVM方案,一款是QEMU,它是传统的虚拟机方案,功能非常强大,但启动速度慢,内存占用高,适合对功能要求高但对性能要求不高的场景,不太适合Agent这类需要快速启动的场景;另一款是Kata Containers,它对外暴露Docker和K8s的操作接口,让开发者可以像使用容器一样使用MicroVM,对内则会启动一个轻量级虚拟机,可以调用QEMU或Firecracker作为底层虚拟化技术,兼顾了兼容性和安全性,适合已经使用Docker或K8s架构的团队。

MicroVM的隔离强度是目前所有Sandbox方案中最高的,因为它采用的是硬件虚拟化技术,每个MicroVM都有自己独立的内核,和宿主机以及其他MicroVM完全隔离,不存在共享内核带来的逃逸风险,恶意代码即便在MicroVM内执行,也无法突破硬件隔离的限制,只能在自己的虚拟机环境内活动。而且MicroVM的性能表现也非常出色,启动速度接近容器,内存开销极小,非常适合公有云、高密度Agent托管等场景,尤其是用户面向的Serving场景,需要同时处理大量用户的Agent请求,对多租户隔离和响应延迟要求很高,MicroVM无疑是最佳选择之一。

了解了这五种主流的Sandbox技术实现方案之后,很多开发者可能会陷入困惑,这么多方案,到底该怎么选才适合自己的项目。其实从工程落地的角度来看,我们可以从四个核心维度进行权衡,结合自身的项目需求、技术实力和成本预算,做出最合理的选择。

第一个维度是自托管和云服务的选择。这两种方式没有绝对的优劣之分,关键在于自身的需求和技术实力。并非所有企业的数据隐私要求都能够接受云托管的Sandbox,对于一些涉及核心数据、敏感信息的Agent项目,自托管无疑是更安全的选择。如果企业拥有成熟的运维团队,基于加固后的Docker、gVisor或Kata Containers自建Sandbox集群,不仅可以更好地控制数据安全,还可以根据自身的业务需求进行个性化配置和优化。

而对于大多数中小企业和个人开发者来说,云托管的Sandbox无疑是更具性价比的选择。云托管服务商已经解决了Firecracker等MicroVM技术极度复杂的网络配置和资源调度问题,开发者不需要投入大量的精力去维护基础设施,只需要专注于Agent本身的开发和快速验证即可。而且很多主流的Sandbox云服务比如E2B,已经成为了Manus、Perplexity等知名Agent项目的底层技术支撑,稳定性和兼容性都经过了实际场景的验证,能够满足大多数Agent项目的需求。此外,云托管的Sandbox还具有弹性扩容的优势,可以根据Agent的并发量自动调整资源,避免了资源浪费和性能瓶颈。

第二个维度是长运行和高频率的选择,这主要涉及到Sandbox的生命周期和持久化需求。现阶段Sandbox的最主要用途还是code Interpreter,也就是执行Agent生成的代码、进行数据分析等任务,对于大多数这类场景来说,Sandbox都是用完即焚的模式,每次请求都会启动一个全新的环境,任务结束后立即销毁,这样可以避免不同任务之间的相互干扰,也可以减少资源占用。同时,通过预装常用的数据分析库、开发工具等,还可以节约Sandbox的启动时间和Agent的执行时间,提升用户体验。

但在一些特定的场景下,Sandbox的持久化就显得非常重要了,比如Agent skills所需要的文件系统场景,Agent需要在多次任务执行中保持文件系统的状态,保存中间结果和配置信息,这时候就需要Sandbox支持持久化功能。目前很多云托管的Sandbox服务商已经实现了这一功能,比如E2B就支持30天内的Sandbox持久化,开发者可以通过简单的代码调用,实现Sandbox的暂停、恢复和终止操作。比如通过Sandbox.create()创建一个Sandbox实例,通过sandbox.betaPause()将其暂停,通过sandbox.connect()恢复运行,通过sandbox.kill()终止实例,这种灵活的生命周期管理,能够满足不同场景下的持久化需求。

第三个维度是Serving和Agentic RL Rollout的选择,这主要取决于业务场景的并发密度和隔离要求。不同的业务场景,对Sandbox的需求也完全不同。在用户面向的Serving场景中,核心关注点是多租户隔离和响应延迟,因为需要同时处理大量用户的Agent请求,每个用户的Agent执行的代码都不可信,而且用户对响应速度的要求很高,这时候就需要选择隔离强度高、启动速度快的Sandbox方案,Firecracker等MicroVM方案和gVisor方案无疑是首选。同时,通过Warm Pool预热机制,提前启动一定数量的Sandbox实例,能够最大程度降低冷启动延迟,确保用户能够获得流畅的体验。

而在Training & Data Gen场景中,核心关注点则是吞吐量和成本,这类场景需要Agent在Sandbox中并行执行数万次代码,生成用于RLVR算法的奖励数据,也就是Rollout过程。这类场景对隔离强度的要求相对较低,因为所有执行的代码都是开发者自己控制的,不存在不可信代码的风险,而且更注重并行处理能力和成本控制。这时候Docker方案就已经足够满足需求了,比如通过sandbox fusion等技术,实现大量Docker容器的并行运行,既能够保证吞吐量,又能够控制成本,是这类场景的最优选择。

第四个维度是纯文本和GUI的选择,这主要取决于Agent的任务类型。纯文本场景主要是指Code Interpreter场景,Agent只需要执行命令行代码,涉及标准输入输出和文件读写操作,不需要图形界面,这种场景下,基于轻量级Linux发行版的Sandbox就足够了,要求资源消耗低、启动速度快,Local Sandbox-runtime、加固后的Docker、WASM等方案都能够满足需求。

而GUI和Computer Use场景则完全不同,这类场景需要Agent使用浏览器进行操作,比如网页浏览、表单填写、页面截图等,需要通过VNC提供实时截屏功能,传递给VLM进行图像识别和指令生成,这意味着对Sandbox的资源要求更高,数据传输也更复杂。针对这类场景,市面上也有专门的Sandbox方案,比如steel-browser、Browserbase、browser-use-sandbox等,它们都内置了浏览器环境和VNC服务,能够满足Agent操作浏览器的需求,广泛应用于网页爬虫、自动化测试、智能办公等场景。

除了上述五种核心技术实现方案之外,目前市面上还有很多主流的Sandbox方案,我们可以根据它们的定位和特点,分为三大类,方便大家快速选择。第一类是通用Sandbox云服务,这类方案功能全面、兼容性强,适合大多数Agent项目,比如E2B、model sandboxes、daytona、AgentRun、Runloop、cloudflare-sandbox、vercel-sandbox等,其中E2B是目前最受欢迎的方案之一,被很多知名Agent项目采用,稳定性和功能丰富度都处于行业领先水平。第二类是轻量级开源方案,这类方案体积小、部署灵活,适合本地开发和小型项目,比如BoxLite、Microsandbox、anthropic-experimental/sandbox-runtime、agent-infra/sandbox等,其中anthropic-experimental/sandbox-runtime就是Anthropic开源的方案,适合需要轻量级隔离的本地Agent开发。第三类是Browser-using方案,专门针对Agent操作浏览器的场景,比如steel-browser、Browserbase、browser-use-sandbox等,能够提供完整的浏览器环境和图像传输功能,满足GUI场景的需求。

回顾Sandbox技术的发展历程,从最初的Local Sandbox-runtime到如今的MicroVM,从自托管到云服务,Sandbox技术的每一次进步,都在推动Agent技术的成熟和普及。随着Agent能力的不断增强,它们能够执行的任务越来越复杂,对Sandbox的要求也越来越高,不仅需要更高的隔离强度、更快的启动速度,还需要更灵活的生命周期管理、更丰富的功能支持和更低的成本。

那么未来Sandbox技术的发展方向会是什么样的,是Agent Using Sandbox,还是Agent Inside Sandbox。在我看来,这两种模式并不会相互替代,反而会走向融合共生。一方面,Agent会越来越熟练地使用Sandbox,将其作为自己的"安全工具",根据不同的任务需求,选择不同的Sandbox方案,通过Sandbox来拓展自己的能力边界,同时确保自身的安全运行;另一方面,随着安全需求的不断提升,Agent会被深度嵌入到Sandbox之中,Sandbox不再仅仅是一个外部的隔离环境,而是成为Agent运行的基础载体,从根本上杜绝安全风险。

对于开发者来说,无论未来的发展方向如何,当下最重要的就是深入理解Sandbox的技术原理和选型逻辑,结合自身的项目需求,选择最适合的Sandbox方案,在保证Agent安全运行的前提下,提升开发效率和用户体验。随着Agent技术的不断普及,Sandbox作为Agent Infra的核心组成部分,将会发挥越来越重要的作用,也会迎来更多的技术创新和突破,比如更高效的隔离机制、更灵活的资源调度、更丰富的功能支持等,为Agent技术的发展提供更坚实的支撑。

在实际开发过程中,我们也可以根据项目的迭代情况,动态调整Sandbox方案。比如在项目初期,为了快速验证想法,可以选择云托管的Sandbox方案,降低开发和运维成本;当项目成熟后,涉及到更多的敏感数据和核心业务时,可以考虑自建Sandbox集群,提升数据安全性和可控性;当业务场景拓展到GUI和Browser-using场景时,可以引入专门的Browser Sandbox方案,满足新的业务需求。

总之,Sandbox技术是Agent安全、高效运行的基石,理解它、掌握它、用好它,是每一个Agent开发者的必备技能。希望通过本文的解析,能够帮助大家理清Sandbox技术的核心脉络,了解不同方案的差异和适用场景,在Agent开发的道路上少走弯路,打造出更安全、更强大的Agent产品。