大侠幸会,在下全网同名[算法金] 0 基础转 AI 上岸,多个算法赛 Top [日更万日,让更多人享受智能乐趣]

1. 引言

数据分析中聚类算法的作用

在数据分析中,聚类算法用于发现数据集中的固有分组,通过将相似对象聚集在一起来揭示数据的结构和模式。这种方法常用于市场细分、社交网络分析、组织复杂数据集等领域。

选择K-Means聚类算法的动机

K-Means 是一种广泛使用的聚类算法,主要因其简单、高效,适用于大规模数据处理。它通过优化簇内距离来形成相对均匀的簇,适合于许多实际应用中的基本聚类需求。

K-Means聚类算法的简述

K-Means 是一个无监督学习算法,它的目标是将 n 个观测值划分到 k 个簇中,使得每个观测值属于离它最近的簇中心(质心),从而使簇内的方差最小。

2. K-Means聚类算法概述

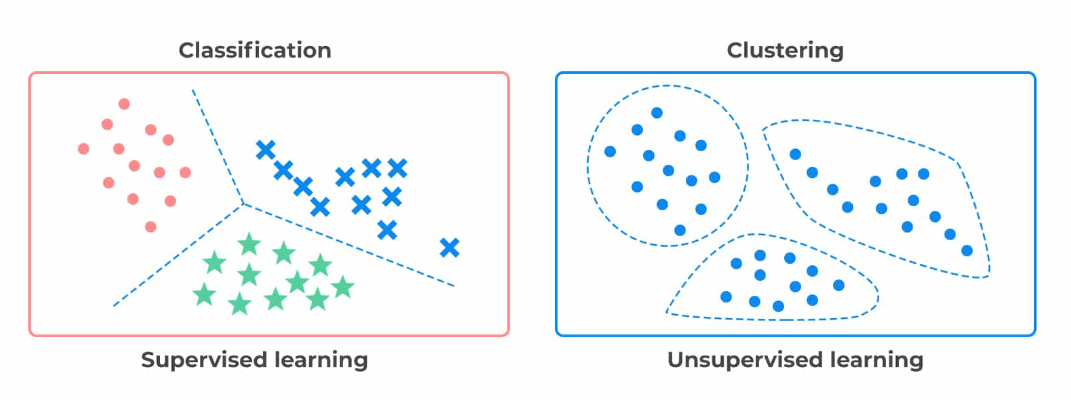

2.1 监督学习与无监督学习的对比

监督学习需要预先标记的输出结果来训练模型,常用于分类和回归任务。无监督学习不依赖于标注输出,而是通过分析数据的内在结构和关系来学习数据的分布或模式,聚类是无监督学习中的典型例子。

2.2 K-Means算法简介

K-Means算法通过迭代过程选择簇中心和划分簇来优化簇内距离,直到达到最优或满足停止条件。该算法只需要指定簇的数量 k,并对初始簇中心的选择敏感。

2.3 K-Means的应用实例

K-Means广泛应用于客户细分、图像分割、文档聚类等多个领域,通过识别相似特征的聚集,帮助企业或研究者洞察数据特征和群体行为。

3. K-Means算法的工作原理

3.1 簇与质心的定义

在 K-Means 算法中,"簇"是数据点的集合,这些数据点彼此之间比与其他簇的数据点更相似。"质心"是簇内所有点的平均位置,代表了簇的中心。

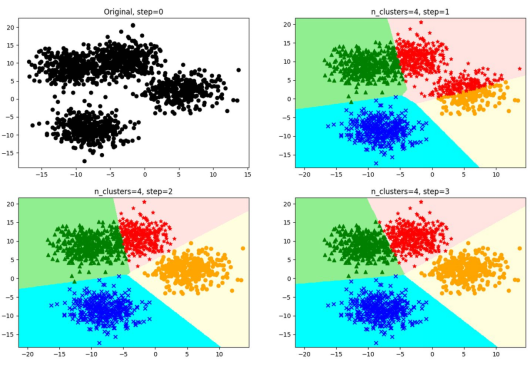

3.2 算法步骤详解

K-Means算法的基本步骤包括随机初始化质心,计算每个数据点到每个质心的距离,根据最近质心重新分配数据点到簇,重新计算簇的质心,重复这一过程直到质心不再变化或达到预定的迭代次数。

3.3 初始质心选择的重要性及其影响

初始质心的选择可能会极大影响算法的收敛速度和最终聚类的质量。不恰当的初始质心可能导致簇结果不稳定或收敛到局部最优。

4. K-Means算法的数学基础

4.1 簇内误差平方和的计算及其评估作用

簇内误差平方和(SSE)是衡量聚类效果的一个重要指标,计算方法是将簇内每个点到其质心的距离平方求和。优化目标是最小化 SSE,从而提高簇的紧密性。

4.2 不同距离度量方法的比较

K-Means常用欧氏距离作为距离度量,但在不同的应用场景中,可以考虑曼哈顿距离、余弦相似度等其他度量方法,以更好地适应数据特性。

5. K-Means算法的实现

5.1 使用Python及scikit-learn实现K-Means

Python 的 scikit-learn 库提供了 K-Means 算法的高效实现。以下是使用 scikit-learn 实现 K-Means 的基本代码示例:

from sklearn.cluster import KMeans

import numpy as np

# 生成模拟数据

X = np.random.rand(100, 2)

# 初始化 KMeans

kmeans = KMeans(n_clusters=3)

# 拟合模型

kmeans.fit(X)

# 获取簇标签

labels = kmeans.labels_5.2 算法的初始化策略

scikit-learn 中的 K-Means 实现支持多种初始化策略,如随机初始化和 K-Means++ 初始化,后者可以优化初始质心的选择,提高算法的稳定性和效率。

5.3 迭代过程与收敛条件

K-Means 算法的迭代继续进行,直到质心的更新非常小(在设定的阈值之下)或达到预设的迭代次数。这确保了算法能够在合理的时间内收敛到一个稳定的簇划分。

6. 模型评估与选择K值

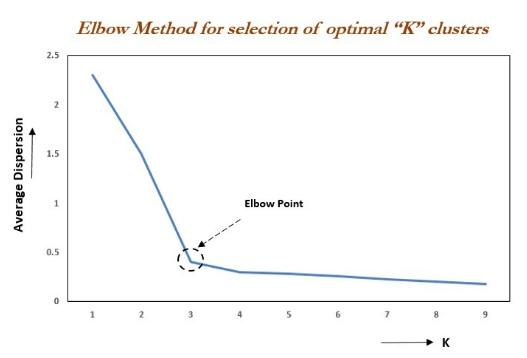

6.1 手肘法的原理与应用

手肘法是一种用来选择 K 值的技术,它通过绘制不同 K 值的 SSE 曲线,寻找曲线的"手肘"点,即 SSE 下降速度显著变缓的点,通常认为这一点是最佳的簇数量。

6.2 轮廓系数的计算与意义

轮廓系数衡量了簇内的紧密性和簇间的分离度,值范围从 -1 到 1。较高的轮廓系数表明簇内部的点相互更接近,而与其他簇的点较远离,反映了聚类的效果较好。

6.3 确定K值的其他方法

除手肘法和轮廓系数外,还可以通过交叉验证、信息准则如 AIC 或 BIC 以及实际应用需求来确定最佳的 K 值。

7. K-Means算法的优缺点

7.1 算法的优势分析

K-Means 算法简单、易于实现,计算效率高,尤其适用于处理大规模数据集。这使得它成为实际应用中最常用的聚类算法之一。

7.2 算法的局限性讨论及问题解决方案

K-Means的主要局限性包括对初始质心选择敏感、对噪声和异常值较为敏感、只能处理球形簇等。针对这些问题,可以采取诸如数据预处理、使用 K-Means++ 初始化等策略来改善算法性能。

8. K-Means算法的变体与改进

8.1 K-Means++算法介绍

K-Means++ 是对传统 K-Means 算法的一项重要改进,通过一种特定的概率方法来选择初始质心,可以显著提高聚类的质量和算法的收敛速度。

8.2 针对不同数据集的优化策略及案例分析

为了应对不同类型的数据集和特定的应用场景,K-Means 算法被适当修改和优化。例如,使用加权距离度量在处理非均匀特征的数据集时,或者调整算法参数以适应高维数据。

9. K-Means在文本聚类中的应用

9.1 文本数据的预处理与向量化

文本聚类前的预处理包括清洗文本、分词、去除停用词等步骤。向量化通常通过 TF-IDF 方法实现,它帮助转换文本数据为算法可处理的数值型特征。

9.2 K-Means与TF-IDF的结合应用

结合 K-Means 算法和 TF-IDF 向量化的方法在文本聚类中广泛应用,有效地将相关文档聚集在一起,便于后续的文本分析和信息检索。

9.3 文本聚类的实际案例分析

案例分析可以展示 K-Means 算法在文本聚类中的应用效果,如新闻文章分类、社交媒体帖子分析等,展示如何从大量文本中提取有用信息。

[ 抱个拳,总个结 ]

K-Means 是一种强大而灵活的聚类工具,尽管它有一些局限性,但正确使用时,它能有效地组织大规模数据集,揭示隐藏的模式和群体结构,是数据分析不可或缺的工具。