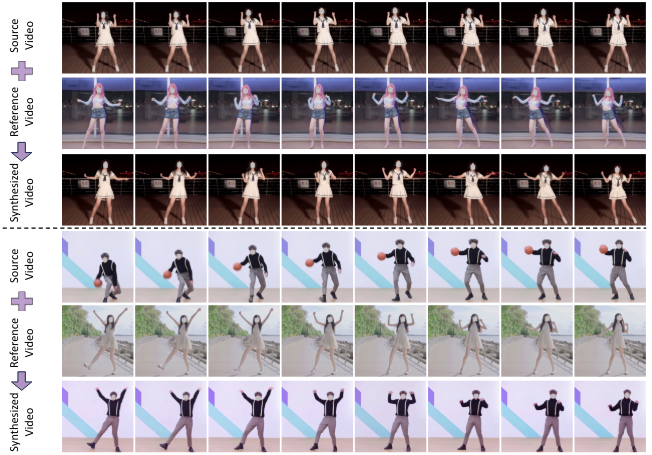

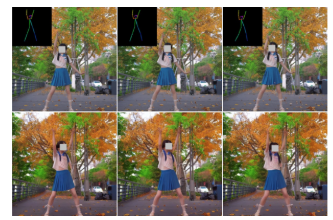

图1. MotionEditor:一种基于扩散的视频编辑方法,旨在将参考视频的运动转移到源视频中。

摘要

现有的基于扩散的视频编辑模型在随时间编辑源视频的属性方面取得了显著进展,但在修改运动信息的同时保持原始主角的外观和背景方面存在困难。为了解决这个问题,我们提出了MotionEditor,这是一种用于视频运动编辑的扩散模型。MotionEditor将一种新颖的内容感知运动适配器集成到ControlNet中,以捕捉时间上的运动对应关系。虽然ControlNet能够基于骨架姿势直接生成,但在修改源运动时,由于噪声(源)和条件(参考)之间的矛盾信号,它会遇到挑战。我们的适配器通过涉及源内容来补充ControlNet,无缝转移适配的控制信号。此外,我们构建了一个双分支架构(一个重建分支和一个编辑分支),并采用高保真度的注意力注入机制促进分支间的交互。这种机制使得编辑分支能够以解耦的方式从重建分支查询关键和值,从而使编辑分支保留原始背景和主角外观。我们还提出了一种骨架对齐算法,以解决姿势大小和位置的差异。实验表明,MotionEditor在定性和定量上都具有有希望的运动编辑能力。

引言

扩散模型在图像生成方面取得了显著成功,这激发了视频编辑领域的大量研究。尽管取得了重大进展,但现有的视频编辑扩散模型主要关注纹理编辑,例如主角属性的操纵、背景编辑和风格编辑。与图像相比,运动信息是最独特和最显著的特征,但大多被忽视。这引出了一个问题:我们能否根据参考视频操纵视频的运动?在本文中,我们尝试探索一种新颖、更高级且更具挑战性的视频编辑场景------运动编辑。给定一个参考视频和提示,我们的目标是改变源视频中主角的运动以匹配参考视频,同时保留原始外观。

在文献中,研究人员已经探索了人体运动转移和姿势引导的视频生成。前者侧重于基于参考骨架的静态图像动画,而后者尝试生成与姿势对齐的视频,而不保留期望的外观。运动编辑的不同之处在于,它直接修改视频中的运动,同时保留其他视频信息,如动态的逐帧背景和相机运动。

视觉编辑的最新进展主要通过使用扩散模型实现。例如,ControlNet使得基于姿势的直接可控生成成为可能。然而,当尝试根据另一个姿势编辑运动时,它们会遭受严重的伪影。我们假设原因是控制信号仅从参考姿势中派生,无法适当适应源内容,从而导致矛盾。一些方法还缺乏保留主角和背景外观以及时间一致性的能力。

在本文中,我们重新思考了ControlNet的基本有效性。我们认为,在生成编辑任务的控制信号时,涉及源潜在内容是至关重要的。借助源内容,条件指导可以精确感知整个上下文和结构,并调整其分布以防止不希望的扭曲。

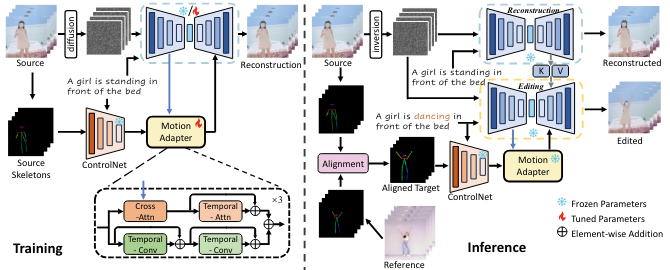

为此,我们提出了MotionEditor,如图2所示,以在使用扩散模型探索视频运动编辑方面迈出一步。MotionEditor需要在源视频上进行一次学习以保留原始纹理特征。然后,我们引入了一个附加到ControlNet的内容感知运动适配器,以增强控制能力和时间建模。适配器由内容感知块和时间块组成。特别是,内容感知块执行交叉注意力以融合源帧特征,这显著提高了运动控制的质量。

在推理时,设计了一个骨架对齐算法来解决源骨架和参考骨架之间的大小和位置差异。我们进一步提出了基于双分支架构(重建和编辑分支)的注意力注入机制,以保留主角和背景的原始外观。以前的注意力融合策略直接将注意力图或键注入编辑分支。直接注入可能会导致编辑前景和背景之间的混淆。在某些情况下,它会给编辑分支带来噪声,从而导致重叠和阴影闪烁的现象。为了避免这种情况,我们提出使用分割掩码解耦前景和背景中的键/值。因此,编辑分支能够从源中捕获背景细节和主角的几何结构。总之,我们的贡献如下:(1)我们探索了通常被以前的视频编辑工作忽视的视频扩散模型用于运动编辑。(2)我们提出了一种新颖的内容感知运动适配器,使得ControlNet能够进行一致和精确的运动编辑。(3)我们提出了一种高保真度的注意力注入机制,该机制在推理期间保持活跃,无需训练即可保留源背景信息和主角的几何结构。(4)我们在野外视频上进行了实验,结果表明我们的方法与最先进的方法相比具有优越性。

相关工作

扩散模型用于图像编辑 图像生成随着扩散模型的出现而显著提高,超越了之前的GAN模型在质量和编辑能力方面。在[29]的开创性工作基础上,研究人员在这一方向上取得了进展。Meng等人提出了SDEdit,这是第一个通过反转和还原实现图像编辑的方法。这使得与之前的基于GAN的方法相比,编辑控制更加精确。Prompt-to-Prompt[9]和Plug-and-Play[37]引入了生成更连贯混合图像的技术,解决了不一致的噪声问题。同时,UniTune[38]和Imagic[15]专注于扩散模型的个性化微调。简而言之,这些方法使得编辑更接近原始图像。

为了生成多样化的内容,研究人员提出了几种可控的扩散模型[6, 13, 24, 30, 31, 42]。Zhang等人引入了ControlNet,它使得Stable Diffusion[29]能够接受多种可控条件进行文本到图像的合成。Cao等人提出了MasaCtrl,它将现有的自注意力转换为互自注意力,以实现非刚性图像合成。总的来说,这些方法通过处理不一致的噪声、微调策略和基于反转的编辑,推进了基于扩散的图像编辑。然而,仍然存在一个开放的挑战,即在保持完美保真度和一致性的同时,实现精确的语义编辑。

扩散模型用于视频编辑和生成

视频编辑很复杂,需要在编辑中保持时间一致性。大多数方法使用现有的文本到图像扩散模型,并添加了一个额外的时间建模模块。Tune-a-Video[41]和Text2Video-Zero[16]将2D扩散模型扩展到3D模型。FateZero[27]和Vid2Vid-zero[40]使用互注意力来确保几何和颜色信息的一致性。另一方面,Text2LIVE[1]和StableVideo[4]通过利用分层神经图谱[14]来分解视频语义。然而,这些模型仅限于低级属性编辑,无法编辑复杂的运动信息等。

最近,基于姿势的视频生成变得流行。Follow-Your-Pose[19]通过在文本到图像扩散模型上实现适配器提取粗略的时序运动信息。ControlVideo[44]通过将ControlNet扩展到视频中引入了全帧交叉注意力。然而,这些方法侧重于视频生成而不是运动编辑,这可能导致主角和背景的扭曲。与这些模型不同,我们的MotionEditor旨在在保留原始视频外观的同时进行运动编辑。

人体运动转移 这项任务旨在将视频中的运动转移到目标图像上,使得目标可以被动画化。之前的GAN方法[18, 33, 34]已经解决了这项任务,但在复杂运动和背景方面存在困难。LWG[18]使用3D姿势投影进行运动转移,但无法很好地建模内部运动。FOMM[33]通过边界关键点近似运动转移。MRAA[34]利用区域特征捕捉部分运动,但在复杂场景上的性能有限。为了解决这些限制,我们提出了MotionEditor,用于在复杂运动和背景上的高质量运动编辑。与以往的工作不同,它利用了能够为复杂运动和背景生成一致细节的扩散模型。

基础知识

扩散模型[11, 23, 35]最近展示了使用迭代去噪操作合成高质量和多样化内容的有希望的结果。它们由一个前向扩散过程和一个反向去噪过程组成。

在前向过程中,配备了预定义的噪声计划αt的模型在时间步长t对源样本x0添加随机噪声,以获得一个带噪声的样本xt:

q(x1:T) = q(x0) ∏t=1T q(xt|xt−1),

q(xt|xt−1) = N(xt; √αtxt−1,(1 − αt)I).(1)

原始输入x0在T个前向步骤后被反转成高斯噪声xT ∼ N(0, 1)。反向过程尝试通过去除噪声来预测一个更干净的样本xt−1。该过程描述如下:

pθ(xt−1|xt) = N(xt−1; µθ(xt, t), σ2t I),(2)

其中µθ(xt, t)和σ2t表示当前时间步的样本的均值和方差。只有均值与时间步和噪声相关,而方差是恒定的。去噪网络εθ(xt, t)旨在通过训练简化均方误差来预测噪声ε:

Lsimple = Ex0,ε,t(∥ε − εθ(xt, t)∥2).(3)

一旦模型训练完成,我们将xT ∼ N(0, 1)输入到扩散模型中,并迭代执行DDIM采样,以预测从上一个时间步的噪声样本xt中更干净的xt−1。该过程如下所示:

xt−1 = √αt−1 xt − √1 − αtεθ(xt, t) √αt + √1 − αt−1εθ(xt, t).(4)

人们还可以将文本提示p注入到预测模型εθ(xt, t, p)中作为条件,其中扩散模型可以执行T2I合成。最近的工作[29]引入了一个编码器E将图像x压缩到潜在空间z = E(x),以及一个解码器D将潜在嵌入转换回像素空间。通过这种方式,扩散过程在潜在空间中执行。

方法

图2. MotionEditor的架构概述。在训练过程中,只有运动适配器和U-Net中的时间注意力是可训练的。在推理过程中,我们首先通过调整大小和平移来对齐源视频和参考视频的骨架。然后,我们构建了一个双分支框架:一个用于重建,另一个用于编辑。运动适配器通过利用源潜在信息增强了ControlNet的运动指导。我们还将重建分支中的键/值注入到编辑分支中,以保留源视频的外观。

4.1. 架构概述

如图2所示,MotionEditor基于常用的T2I扩散模型(即LDM [29])和ControlNet [42]。我们首先将LDM中的U-Net的空间变换器膨胀成一个3D变换器,通过添加一个时间自注意力层。我们还提出了ConsistentSparse注意力,如第4.3节所述,以替换空间自注意力。为了实现精确的运动操作和时间一致性,我们设计了一个内容感知运动适配器,操作来自U-Net的特征和来自ControlNet的条件姿势信息。遵循[41],我们执行一次性训练来计算时间注意力模块和运动适配器的权重,以重建输入源视频。

在推理过程中,给定一个参考目标视频Xrf,MotionEditor旨在将Xrf的运动转移到源视频中,同时保留源视频的外观信息。为此,我们首先开发了一个骨架对齐算法,通过考虑位置和大小来缩小源骨架Ssr和参考骨架Srf之间的差距,并产生一个精细的目标骨架S¯tg。然后,我们使用DDIM反演[35]对视频的像素值进行操作,产生一个潜在的噪声,作为采样的起点。更重要的是,我们引入了一个高保真度的注意力注入模块,探索了一个精心设计的双分支网络。一个专门用于重建,另一个专注于编辑。更具体地说,编辑分支接受来自精细目标骨架的特征作为输入,将参考视频的运动信息转移到源视频中。同时,重建分支中编码的关键外观信息进一步注入到编辑分支中,以便保留外观和背景。下面,我们将详细介绍所提出的组件。

4.2. 内容感知运动适配器

我们的目标是在姿势信号的指导下操纵视频中的身体运动。虽然ControlNet [42]能够基于条件直接进行可控生成,但它在修改源视频的运动时存在困难。ControlNet注入的运动信号可能会与源视频的运动发生冲突,从而导致明显的鬼影和模糊效果,甚至失去控制能力。此外,该模型源自图像,缺乏生成时间一致内容的能力。因此,我们提出了一个时间内容感知运动适配器,增强了运动指导并促进了时间一致性,如图2所示。

我们的运动适配器接受ControlNet输出的特征作为输入,这些特征已被观察到在空间控制方面取得了有希望的结果。我们没有在ControlNet中插入时间层,以防止影响其固有的建模能力。适配器由两个并行路径组成,对应于不同的感知粒度。一个是全局建模路径,包括一个内容感知的交叉注意力块和一个时间注意力块。另一个是局部建模路径,它使用两个时间卷积块来捕捉局部运动特征。具体来说,我们的交叉注意力涉及来自U-Net的潜在特征来建模姿势特征,其中查询来自姿势特征mi,而键/值来自U-Net产生的相应帧潜在特征zi:

Q = WQc mi, K = WKc zi, V = WVc zi, (5)

其中WQc、WKc和WVc是投影矩阵。我们的交叉注意力使运动适配器能够专注于视频潜在空间中相关的运动线索,这显著增强了控制能力。通过在它们之间建立桥梁,模型可以无缝地操纵源视频的运动,而不会产生矛盾。

图3. 推理过程中高保真度注意力注入的示意图。我们利用源前景掩码来指导Consistent-Sparse Attention中键/值的解耦。

4.3. 高保真度注意力注入

尽管我们的运动适配器能够准确捕捉身体姿态,但它可能会不希望地改变主角和背景的外观。因此,我们提出了从重建分支到编辑分支的高保真度注意力注入,这保留了合成视频中主体和背景的细节。虽然之前的注意力融合范例[2, 27, 40]使用了注意力图或键/值进行编辑,但由于上下文混淆,它们在模糊区域(即运动区域)遭受了严重的质量退化。为了解决这个问题,我们通过语义掩码将键和值分解为前景和背景。通过将重建分支中的分离键和值注入到编辑分支中,我们可以减少阻碍编辑的混淆。流程如图3所示。

在介绍注入之前,我们首先介绍模型中注意力块的细节。U-Net中的每个注意力块包括我们设计的Consistent-Sparse Attention(CS注意力)、交叉注意力和时间注意力。Consistent-Sparse Attention作为一种稀疏的因果注意力,替代了原始U-Net中的空间注意力。它的目标是在增加的计算开销很小的情况下执行时空建模。具体来说,以重建分支为例,CS注意力中的查询来自当前帧zri,而键/值来自前一帧和当前帧zri−1, zri。这种设计可以提高帧的一致性:

Qr = WQzri, Kr = WK[zri−1, zri], Vr = WV[zri−1, zri],(6)

其中[·]表示拼接。WQ、WK和WV是投影矩阵。值得注意的是,我们没有使用[41]中的稀疏注意力,其中键/值来自第一帧和前一帧z0, zi−1。我们发现它可能会过分地使合成运动偏向第一帧,导致闪烁。

我们现在介绍从重建分支到编辑分支的键和值的注入,操作在Consistent-Sparse Attention(CS注意力)和时间注意力上。注入仅在U-Net的解码器中活跃。对于CS注意力,我们利用一个源前景掩码M(从现成的分割模型获得)来分离前景和背景信息。给定重建分支中的键Kr和值Vr,我们将它们分离为前景(Krfg和Vrfg)和背景(Krbg和Vrbg),

Krfg = Kr ⊙ M, Vrfg = Vr ⊙ M,

Krbg = Kr ⊙ (1 − M), Vrbg = Vr ⊙ (1 − M).(7)

这种解耦操作在背景和前景之间引入了明确的区别。它鼓励模型更多地关注个体外观而不是混合两者,确保主体和背景的高保真度。值得注意的是,简单地用上述键/值替换编辑分支中的键/值会导致大量的突然运动变化,因为模型显著受到源运动的影响。相反,我们将它们结合起来以精确地保持目标运动。因此,在编辑分支中,CS注意力的键和值通过注入的键Kinj和值Vinj更新:

Ke = WK[zei−1, zei] = [WKzei−1,WKzei] := [Kepre, Kecu],

Ve = WV[zei−1, zei] = [WVzei−1,WVzei] := [Vepre, Vecu],

Kinj = [Krfg, Krbg, Kecu],

Vinj = [Vrfg,Vrbg,Vecu], (8)

其中zei, zei−1表示编辑分支中的当前帧和前一帧。Ke, Ve是编辑分支中CS注意力的原始键和值。Kecu, Vecu是从当前帧来的键和值。

在时间注意力中的注入比在CS注意力中简单得多,因为它已经执行了关于空间区域的局部操作。我们直接将重建分支中的Kr, Vr注入到编辑分支中。

4.4. 骨骼信号对齐

给定源视频和参考视频,由于不同大小和协调位置,源和目标主角之间总是存在差距。这种差异可能会影响编辑的性能。因此,我们提出了一个对齐算法来解决这个问题。

我们的算法包含两个步骤,即缩放操作和平移操作。具体来说,给定源视频Xsr和参考视频Xrf,我们首先使用现成的模型提取源骨架Ssr和前景掩码Msr,以及参考骨架Srf及其掩码Mrf。然后,我们对掩码执行边缘检测,以获得前景的矩形轮廓。基于两个矩形轮廓的面积,我们将Srf缩放到与源视频相同的大小。关于前景位置,我们计算每个掩码中前景像素的平均坐标,这表示主角的中心。通过计算两个中心之间的差异,我们得到一个仿射矩阵用于平移操作,该矩阵进一步应用于缩放后的参考骨架。最后,生成目标骨架S¯tg。对齐的详细信息在附录中描述。

图4. 展示了我们的MotionEditor运动编辑结果。更多示例可在附录中找到。

实验

5.1. 实现细节

我们提出的MotionEditor基于潜在扩散模型[29](Stable Diffusion)。我们在YouTube视频和TaichiHD[33]数据集的视频上评估我们的模型,其中每个视频至少包含70帧。帧的分辨率统一为512×512。我们对运动适配器进行了一次性学习,共300步,学习率恒定为3×10−5。在推理过程中,我们使用DDIM反演[35]和无文本优化[21]以及无分类器指导[10]。由于使用了DDIM反演和无文本优化,MotionEditor需要10分钟在单个NVIDIA A100 GPU上对每个视频进行运动编辑。

5.2. 运动编辑结果

我们广泛验证了我们提出的MotionEditor在运动编辑方面的优越性。这里,我们在图4中展示了一些案例,其余案例在附录中。我们可以看到,MotionEditor可以在保持原始主角外观和背景信息的同时,完成广泛的运动编辑。

5.3. 与最新方法的比较

竞争对手。我们将我们的MotionEditor与最近的方法进行比较,以验证我们模型的优越性。竞争对手如下:(1) 基于GAN的人体运动转移模型,包括LWG[18],它解构了姿势和形状,以及MRAA[34],它学习语义对象部分。(2) Tune-A-Video[41],它以一次性学习的方式膨胀Stable Diffusion。(3) Follow-Your-Pose[19],它提出了一个空间姿势适配器用于姿势引导的视频生成。(4) ControlVideo[44],它设计了完全的跨帧注意力,试图将视频帧缝合成一个大图像。(5) MasaCtrl[2],它进行掩码引导的互自注意力融合,其中掩码来自文本交叉注意力。(6) FateZero[27],它设计了反演注意力融合以保留源结构。值得注意的是,Tune-A-Video和MasaCtrl配备了条件T2I模型(即ControlNet)用于可控视频编辑。我们还将FateZero与ControlNet结合,以实现姿势引导编辑。更多关于实现的细节在附录中描述。

定性结果。我们在图5中进行了我们MotionEditor与几个竞争对手的定性比较。LWG[18]和MRAA[34]的结果在附录中提供。通过分析结果,我们有以下观察:(1) Tune-A-Video[41]、ControlVideo[44]、MasaCtrl[2]和FateZero[27]在一定程度上展示了编辑运动的能力。然而,它们编辑的视频表现出相当程度的鬼影,表现为主角头部和腿部的重叠帧。(2) Follow-Your-Pose[19]未能进行运动编辑并保留源外观。结果中也存在鬼影效应。合理的解释是它在处理反向噪声和输入参考姿势之间的运动冲突时有困难。(3) Tune-A-Video[41]和ControlVideo[44]都有剧烈的外观变化,例如发型、衣服的质地和背景。由于单一分支架构的限制,当引入额外的姿势条件时,它们无法与原始视频特征互动。这导致随着去噪步骤的增加,源外观逐渐丧失。(4) MasaCtrl[2]生成了过多的模糊噪声。可能的原因是交叉注意力图生成的掩码不可靠且随时间不一致,因此将模糊噪声引入结果中。(5) FateZero[27]的编辑结果显示出主角腿部的重叠帧。这表明FateZero中的注意力融合策略可能不适合运动编辑。(6) 最后,我们的MotionEditor可以有效地进行运动编辑,同时保留原始背景和外观,与以往的方法相比,突显了其巨大潜力。

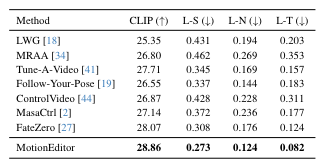

定量结果。据我们所知,目前还没有广泛认可的指标来评估视频编辑的性能。在本文中,我们通过几个感知度量[43]和对编辑视频的用户研究,对以往的方法进行了定量比较。详细的度量如下:(1) CLIP分数[28]:目标文本忠实度。(2) LPIPS:学习的感知图像块相似度(LPIPS)[43],在编辑帧和源帧之间。(3) LPIPS-N:编辑相邻帧之间的LPIPS。(4) LPIPS-T:我们将一个长视频分为两个片段。第一个片段用于源视频,第二个片段用于参考视频。我们计算编辑视频与第二个片段之间的LPIPS。结果如表1所示。我们观察到MotionEditor在很大程度上超过了竞争对手。

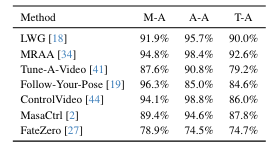

我们还进行了一项用户研究,以评估我们的方法与竞争对手之间的主观偏好。对于每个案例,参与者首先被呈现源视频和目标视频,以及提示。然后,我们以随机顺序展示两个运动编辑视频;一个是我们的方法生成的,另一个来自竞争对手。参与者被要求回答以下问题:"哪一个与参考有更好的运动对齐","哪一个与源有更好的外观对齐",以及"哪一个与提示有更好的内容对齐。"案例总数为20,参与者主要是大学生。表2中的结果表明,我们的方法在主观评估方面远远领先于其他方法。

图5. 我们的MotionEditor与其他最新视频编辑模型的定性比较。源提示:"一个穿着黑色裙子的女孩在跳舞。"目标提示:"一个穿着黑色裙子的女孩在练习太极。"我们的方法展示了精确的运动编辑和外观保持。

表1. 在20个户外案例上的定量比较。L-S、L-N和L-T分别代表LPIPS-S、LPIPS-N和LPIPS-T。

表2. 在与每种方法比较时,MotionEditor的用户偏好比例。数值越高表示用户更倾向于我们的MotionEditor。M-A、A-A和T-A分别代表运动对齐、外观对齐和文本对齐。

5.4. 消融研究

为了验证MotionEditor核心组件的重要性,我们进行了一项消融研究。结果如图6所示。值得注意的是,在©中,我们用之前的稀疏注意力[41]替换了我们提出的CS注意力。结果在©行表明,稀疏注意力试图使帧与第一帧对齐,导致运动不可靠。在(d)和(e)行中,两者都未能完成运动编辑和背景保留。这表明,没有额外的内容感知建模,原始的ControlNet对运动的约束较弱。它还迫使模型保留背景信息。在(f)行中,没有高保真度注意力注入的模型失去了原始背景细节,如女孩身后的路标消失了。这验证了我们提出的机制可以促进模型保留源背景。在(g)行中,没有骨架对齐的模型由于对齐不当而出现外观变化。骨架的不对齐可能会将意外的噪声引入内容潜在空间,从而破坏源数据分布。上述消融结果表明,我们的核心组件确实有助于MotionEditor的运动编辑能力。

图6. MotionEditor核心组件的消融研究。图中的行分别是:(a)源视频,(b)参考视频,©无CS注意力,(d)无运动适配器中的交叉注意力,(e)无运动适配器,(f)无高保真度注意力注入,(g)无骨架对齐,以及(h)MotionEditor。源提示:"一个女孩在跳舞。"目标提示:"一个女孩在练习太极。"

6. 结论

在本文中,我们提出了MotionEditor来解决视频运动编辑的挑战,这与之前的视频属性编辑相比,被认为是高级视频编辑。为了增强运动的可控性,我们设计了一个内容感知运动适配器,以与源内容建立关系,实现无缝的运动编辑以及时间建模。我们进一步提出了高保真度注意力注入,以保留背景和主角的源外观。为了解决骨架信号对齐问题,我们提出了一种简单而有效的骨架对齐方法,以规范化目标骨架。总之,MotionEditor探索了很少研究的视频运动编辑任务,鼓励在这一具有挑战性的场景中进行更多的未来研究。

附录

A. 骨骼信号对齐

我们骨骼信号对齐的详细信息在对齐1中描述。其中(xs, ys), hs, ws指的是源主角边界框的左上角坐标、高度和宽度。而(xr, yr), hr, wr指的是参考帧中的对应值,即参考主角边界框的左上角坐标、高度和宽度。w∗r表示源主角的调整后宽度。Rectangle Boundary(·)表示cv2.boundingRect(·)。

B. 任务比较

我们提出了MotionEditor来解决一个更高层次且更具挑战性的视频编辑任务------视频运动编辑。给定源视频、目标提示和参考视频,我们的模型可以直接根据参考视频和目标描述编辑源视频的运动,同时保留源视频的外观信息。比较详情如表3所示。

表3. 在姿态引导图像生成、人体运动转移、姿态引导视频生成、视频属性编辑和视频运动编辑之间的任务比较。

图7. 我们的MotionEditor的失败案例。

C. 实验细节

由于现有方法并非为运动编辑设计,我们对其模型进行了若干修改。对于姿态引导的视频生成模型,我们将DDIM反演的源视频潜在特征输入到Follow-Your-Pose [19]和ControlVideo [44]中,这使得它们能够执行可控的视频编辑。对于视频属性编辑模型,Tune-A-Video [41]、MasaCtrl [2]和FateZero [27]配备了ControlNet [42],这使得它们能够接受额外的可控信号输入。在人体运动转移模型方面,我们仅将每个视频的第一帧输入到LWG [18]和MRAA [34]中,以遵循它们的原始流程。其余设置与我们提出的MotionEditor相同。我们展示了以4倍采样率对32帧视频进行运动编辑的结果,以获得更好的视觉效果。

D. 关于视频运动编辑和人体运动转移的讨论

视频运动编辑需要直接在时间维度上对视频进行运动转移,这考虑了逐帧的动态背景信息和相机运动。相比之下,人体运动转移的流程[18, 34]仅要求单一图像,忽略了额外的动态信息。我们在具有动态背景信息和相机运动的案例上进行了两次比较实验。结果分别显示在图13和图14中。我们可以看到,我们的MotionEditor可以在保持额外动态信息的同时,以更高的质量执行运动编辑。人体运动转移模型的结果仅限于给定的单一图像,因此导致静态的背景信息和相机运动。此外,它们通常受限于背景干净的图像。当背景复杂且场景复杂时,它们的模型能力有限。

人体运动转移方法(例如,LWG [18]和MRAA [34])也对初始源姿势敏感。它们要求简单的初始源姿势,例如一个人直立站立。我们进行了一项实验,选择具有不同和复杂姿势的帧作为运动转移的初始图像。结果如图15所示。请注意,只展示了每次转移的第一帧。这表明人体运动转移模型无法直接处理不同的和复杂的初始姿势,而我们的MotionEditor在视频运动编辑方面显示出其优越性。

E. 额外结果

图8和9展示了MotionEditor的额外视频运动编辑结果。图10显示了完整的比较结果。图11和12提供了额外的比较结果和消融研究结果。

F. 限制和未来工作

图7展示了我们的MotionEditor的一个失败案例。女孩的手与周围的背景混淆。可能的原因是前景潜在特征与背景潜在特征混淆,从而在去噪过程中引入了额外的偏差到U-Net的自注意力中。可能的解决方案是在去噪过程之前明确地将前景和背景分离,并对它们进行相应的编辑操作。此外,可以设计一个可学习的专用混合适配器,用于自然地将前景与背景混合。这部分留作未来的工作。